Die Absicherung sensibler und unersetzlicher Daten stellt heute einen zentralen Bestandteil jeder Datenstrategie dar. Insbesondere bei wertvollen Inhalten wie persönlichen Fotos, kreativen Projekten oder geschäftskritischen Dateien reicht die lokale Speicherung häufig nicht aus. Offsite-Backups bieten hier eine ideale Lösung, um Daten lokal unabhängig und ausfallsicher zu speichern. Ein modernes, flexibles und kosteneffizientes Backup-System lässt sich mit Linux, WireGuard und rsync aufbauen, das netzwerkbasiert über verschiedene Standorte hinweg arbeitet und so einen umfassenden Schutz gewährleistet. Viele Anwender verfügen heute über ungenutzte Hardware wie Einplatinencomputer oder alte Notebooks – ob Orange Pi, LattePanda oder Raspberry Pi.

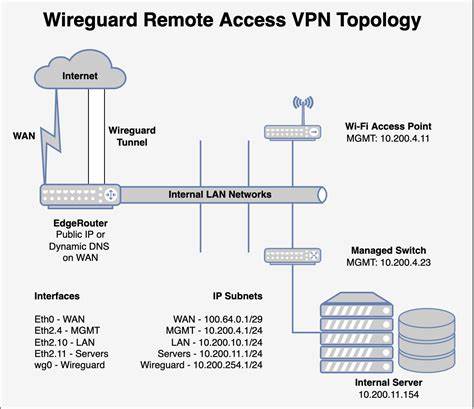

Diese Geräte können mit wenig Stromverbrauch rund um die Uhr im Einsatz sein und als dezentrale Backup-Endpunkte fungieren. Mit einer passenden 1-Terabyte-SSD ausgestattet, bieten sie ausreichend Speicherkapazität für diverse Backup-Daten und sorgen durch ihre Vernetzung via WireGuard für sicheren Datenverkehr. Im Zentrum eines solchen Systems steht die Netzwerkverbindung. WireGuard hat sich als modernes, schlankes VPN-Protokoll etabliert, das mit hoher Geschwindigkeit und einfacher Konfiguration punktet. Im Gegensatz zu komplexeren Lösungen ist WireGuard leichtgewichtig und bietet durch moderne Kryptografie eine sichere Basis für die Kommunikation zwischen Backup-Endpunkten und dem zentralen Server zuhause.

Die Verwendung eines privaten Netzwerks beispielsweise im Adressbereich 10.13.69.0/24 ermöglicht es, alle Backup-Geräte eindeutig und sicher anzusprechen. Der Server fungiert hierbei als Dreh- und Angelpunkt für die Backups.

Die Backup-Endpunkte, also die dezentral verteilten Einplatinencomputer, verbinden sich mithilfe der VPN-Konfiguration an das zentrale Netzwerk an. Indem jede Komponente eine feste IP-Adresse innerhalb des VPN bekommt, bleibt die Verwaltung übersichtlich und lässt eine gezielte Ansprache der Geräte zu. Die Kommunikation beschränkt sich bewusst nur auf das Backup-Netzwerk, um keine unnötigen Daten über den zentralen Server zu tunneln. Das erhöht die Performance und reduziert mögliche Angriffsflächen. Ein weiterer wichtiger Faktor ist die Stabilität der Verbindungen.

So sorgen Optionen wie PersistentKeepalive dafür, dass Backup-Endpunkte regelmäßig Kontakt zum Server halten. Dies ist besonders wichtig, wenn die Endpunkte an wechselnden oder durch NAT-Router geschützten Standorten betrieben werden. Ohne diese Einstellung wäre es häufig nicht möglich, die Geräte aus der Ferne zu erreichen, was in einem Offsite-Backup-Szenario zu erheblichen Problemen führen kann. Die Konfigurationsdateien für WireGuard lassen sich automatisiert generieren, beispielsweise durch Docker-Images, die sowohl Server als auch Client-Configs auf einfache Weise bereitstellen. Dabei sollte man darauf achten, unnötige DNS-Server-Einstellungen in den Client-Konfigurationen zu entfernen, da diese für ein reines Backup-VPN nicht benötigt werden.

Ebenso empfiehlt es sich, die Hosts-Dateien auf den beteiligten Rechnern anzupassen, sodass die Backup-Endpunkte unter einfachen Namen erreichbar sind, was die Handhabung deutlich erleichtert. Bei Heimnetzwerken mit dynamischer IP-Adresse ist eine zusätzliche Vorsichtsmaßnahme ratsam: Ein dynamischer DNS-Dienst oder die Nutzung einer eigenen Domain mit sich automatisch aktualisierendem DNS-Eintrag garantieren den dauerhaften Zugriff auf den zentralen Server trotz wechselnder öffentlicher IP-Adressen. Zudem ist es essentiell, im Router entsprechende Portweiterleitungen und Firewall-Regeln zu konfigurieren, damit die Backup-Endpunkte den Server problemlos erreichen können. Nach dem Einrichten des sicheren Netzwerkkanals folgt die eigentliche Datensicherung. Rsync ist ein bewährtes Werkzeug, das durch seine einfache Bedienung und effiziente Übertragung überzeugt.

Mit der richtigen Kombination von Parametern werden die Daten beim Transfer komprimiert (über die -z Option), sämtliche Dateiattribute erhalten (-aAX) und Zielverzeichnisse exakt synchronisiert, indem veraltete Dateien auf dem Ziel mit --delete entfernt werden. RSYNC funktioniert zuverlässig über SSH, was daher zusammen mit WireGuard für eine doppelte Sicherheitsschicht sorgt. Die Backup-Speicher werden idealerweise im Linux-eigenen fstab mit der nofail-Option eingebunden, sodass das System auch nach einem Ausfall oder Auswerfen der Festplatte problemlos hochfahren kann. Dadurch ist der Zugriff auf die Backup-Endpunkte jederzeit gewährleistet, auch wenn Hardwaredefekte vorliegen. Alternativ können die Laufwerke vom Backup-Skript vor und nach der Sicherung manuell ein- und ausgehängt werden, was mehr Kontrolle bietet und mögliche Fehler minimiert.

Die Wahl des Dateisystems spielt eine wichtige Rolle für den Langzeitschutz der Daten. Btrfs erweist sich als besonders geeignet, weil es snapshots bezogen auf das Dateisystem gestattet. Mit btrbk lassen sich automatisierte Snapshot-Strategien realisieren, die vergangenen Datenzustände konservieren. Bei versehentlicher Löschung von Dateien können so frühere Versionen unkompliziert wiederhergestellt werden. Eine Aufbewahrungsdauer von etwa 30 Tagen ist ein sehr guter Kompromiss zwischen Speicherverbrauch und Datensicherheit.

Wer kein btrfs verwenden möchte, findet mit Tools wie Restic eine aktuelle und moderne Alternative. Restic verschlüsselt die Daten, ermöglicht Backups über SSH und unterstützt komfortable Snapshot- und Retentions-Policies. Hier gilt es allerdings, das Passwort und die Schlüsselmaterialien sicher zu verwahren, sonst kann der Zugriff auf die Sicherungen schnell verloren gehen. Für die einfache Verwaltung großer Backup-Flotten bieten sich Automatisierungstools wie Ansible an. Damit lassen sich Betriebssystem-Installation, Paketupdates, Einrichtung der Netzwerkverbindungen und Start von Backup-Prozessen zentral steuern.

So sinkt der zeitliche Aufwand für Wartung und Fehlerbehebung erheblich. Selbst komplexe Aufgaben können in playbooks beschrieben und mit wenigen Befehlen auf alle Endpunkte angewendet werden. Die regelmäßige Aktualisierung der Systeme ist ein bedeutender Faktor für die Stabilität und Sicherheit. Automatische Upgrades und Neustarts können bequem nachts oder in Zeitfenstern geringer Nutzung eingeplant werden. Größere Versionssprünge des Betriebssystems sollten hingegen mit Vorsicht angegangen und gut getestet werden, um Ausfälle im Offsite-Backup-Netzwerk zu vermeiden.

Ein Monitoring der Backup-Endpunkte erhöht die Transparenz und ermöglicht frühzeitiges Eingreifen bei Problemen. Prometheus zusammen mit node-exporter bietet eine einfache Lösung, um Statusinformationen wie Verfügbarkeit der Geräte, Festplattenauslastung oder Temperatur zu überwachen. Ergänzt durch automatisierte Benachrichtigungen lassen sich Ausfälle schnell erkennen und beheben. Wie bei vielen selbstgebauten Systemen sind auch bei einem Linux-basierten Offsite-Backup-Netzwerk kleinere Herausforderungen und Gehversuche keine Seltenheit. Hardwareprobleme wie Überhitzung bei kleinen Einplatinencomputern lassen sich durch eigenhändige Kühlung, etwa einfache Lüfter oder Kühlkörper, wirkungsvoll lösen.

Spezielle Eigenheiten, etwa fehlende Echtzeituhr bei manchem Gerät, erfordern manchmal angepasste Scripte, die das Systemverhalten intelligent steuern. Bei Problemen mit dem Stromnetz oder der Hardware können Ausfälle mit den Monitoring-Tools schnell sichtbar werden. Das ermöglicht zügige Reaktion und minimalisiert den Datenverlust. Auch ein versehentlicher Fehler bei der automatischen Konfiguration lässt sich durch manuelle Eingriffe oder Rückspielung von Snapshots korrigieren. Insgesamt bietet ein selbst aufgebautes Netzwerk von Offsite-Backups eine kostengünstige und flexible Lösung, die selbst mit moderner kommerzieller Backup-Software konkurrieren kann.

Die Kombination von offenen Linux-Systemen, dem schlanken VPN WireGuard und dem bewährten Dateisynchronisationstool rsync schafft eine robuste Basis, die sich individuellen Bedürfnissen anpasst. Mit einem durchdachten Setup, regelmäßiger Wartung und einem guten Monitoring ist so ein solides Sicherheitsnetz für wertvolle Daten gewährleistet – unabhängig von Cloud-Anbietern oder proprietären Lösungen. Wer den Schritt wagt, profitiert von der völligen Kontrolle über seine Daten, der Sicherheit einer eigenen Infrastruktur und der Freude an einem spannenden technisch anspruchsvollen Projekt, das langfristig vor Datenverlust schützt. Für ambitionierte Nutzer, die sich nicht scheuen, in die Tiefe der Systemadministration einzutauchen, ist dies eine besonders lohnende Herausforderung, die ideale Voraussetzungen für eine moderne Datenstrategie schafft.