Die Integration von Künstlicher Intelligenz (KI) in unternehmensweite Anwendungen gewinnt zunehmend an Bedeutung. Besonders große Organisationen stehen vor der Herausforderung, KI-Modelle nicht nur zu entwickeln, sondern auch in großem Maßstab effizient zu betreiben. In diesem Kontext stellt sich häufig die Frage, ob serverlose Plattformen oder Kubernetes als Orchestrierungsplattform die bessere Wahl sind. Kingfisher Group AI hat hier eine hybride Strategie entwickelt, die je nach Anwendungsfall unterschiedliche Technologien einsetzt, um optimale Ergebnisse zu erzielen. Serverless Computing und Kubernetes sind zwei unterschiedliche Ansätze, die jeweils spezifische Vorteile bieten.

Während Serverless-Architekturen vor allem durch Elastizität, einfache Skalierbarkeit und eine vereinfachte Ressourcennutzung punkten, erlaubt Kubernetes eine granulare Kontrolle über die Infrastruktur und eignet sich besonders für komplexe, dauerhafte Workloads mit besonderen Anforderungen an Leistung und Zuverlässigkeit. Im Bereich des Trainings und der Batch-Verarbeitung von KI-Modellen nutzt Kingfisher Group AI vorwiegend serverlose Technologien über die Google Cloud Platform und deren Dienst Vertex AI Pipelines. Diese Lösung erlaubt es, zahlreiche Machine Learning Pipelines flexibel und effizient zu orchestrieren. Ein großer Vorteil ist die native Integration von Monitoring, Alerting und Benutzeroberflächen, die eine übersichtliche Verwaltung der Pipelines erleichtern. Die vielfältigen Anforderungen der unterschiedlichen Pipelines reichen dabei von einfachen Berechnungen auf Single-Core-Maschinen bis hin zu rechenintensiven Aufgaben auf VMs mit über 100 Kernen sowie dem Einsatz von GPUs.

Die stark variierende und elastische Nachfrage an Ressourcen macht serverlose Plattformen besonders attraktiv, da sie automatische Anpassungen ohne die Notwendigkeit fester Node-Konfigurationen ermöglichen. Dies ist ein klarer Vorteil gegenüber einer rein Kubernetes-basierten Infrastruktur, bei der Knoten oft mit vordefinierten Ressourcen betrieben werden und die Elastizität durch Hinzufügen oder Entfernen gleicher Node-Typen realisiert wird. Da Kingfisher mehrere Marken mit jeweils individuellen Anforderungen betreibt, wäre eine Standardisierung auf fest konfigurierte Node-Pools inefficient. Ressourcen könnten so entweder unter- oder überfordert sein, mit entsprechenden Auswirkungen auf Kosten und Leistung. Dies könnte zu erheblichen Verschwendungen führen oder dazu, dass wichtige Prozesse unter Ressourcenknappheit leiden.

Natürlich erfordert der Betrieb von Kubernetes-Cluster mit entsprechend aufwändigen Tools wie Kubeflow zur Pipeline-Orchestrierung zusätzlichen Aufwand bei der Einrichtung, Wartung und laufenden Optimierung. Demgegenüber steht bei serverlosen Plattformen die Auslagerung dieser Komplexität an den Cloud-Anbieter, was insbesondere kleinere Teams entlastet und Zeit für die tatsächliche Entwicklung freimacht. Auch wenn serverlose Notebook-Frameworks wie Databricks Notebooks oder AWS Sagemaker vereinfacht den Einstieg in die KI-Entwicklung ermöglichen, sehen die Experten bei Kingfisher Group AI Grenzen in Bezug auf Codequalität, Testbarkeit und robuste CI/CD-Integration. Nachteile wie schwierige Versionsverwaltung, mangelnde Code-Überprüfbarkeit und eingeschränkte Kontrolle über die Laufzeitumgebung sprechen gegen den produktiven Einsatz von Notebooks als Endlösung. Stattdessen setzt das Team auf strukturierte Python-Codebasis und bewährte Open-Source-Standards für robuste und wartbare Pipelines.

Neben der Trainings- und Batch-Verarbeitung kommt vor allem der Bereich der Live-Inferenz zum Tragen, bei dem KI-Modelle in Echtzeit Kunden- oder Mitarbeiteranfragen beantworten. Hier verfolgt Kingfisher einen ergebnisorientierten Ansatz, bei dem Machine Learning Engineers die gesamte Verantwortung vom Modelltraining bis zur produktiven Skalierung tragen. Dies sorgt für echte Ownership und einen ganzheitlichen Blick auf Wartbarkeit, Performance, Kosten und Betriebssicherheit. Die Anforderungen an moderne Echtzeit-KI-Dienste sind komplex. Häufig werden Anfragen nicht nur durch einzelne Modelle beantwortet, sondern erfordern eine Orchestrierung verschiedener Systeme – etwa Large Language Models wie ChatGPT oder Gemini, spezialisierte Vektor-Datenbanken zur Ähnlichkeitssuche, eigene Einbettungsmodelle oder klassische relationale Datenbanken.

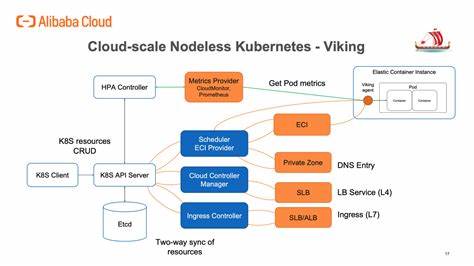

Wegen dieser Vielfalt sind die meisten Anfrageprozesse I/O-lastig und binden viel Zeit mit der Kommunikation zwischen Komponenten, während die eigentlichen Berechnungen für das maschinelle Lernen oft von dedizierten Hardware-optimierten Diensten übernommen werden. Dieses Muster erlaubt eine klare Trennung zwischen der I/O-Orchestrierung und dem rechenintensiven Modellserver, für den beispielsweise TensorFlow Serving oder NVIDIA Triton eingesetzt werden kann. Die unterschiedlichen Skalierungsbedarfe dieser Komponenten machen es oft sinnvoll, sie separat zu betreiben und zu skalieren. Für die I/O-orientierten Komponenten empfiehlt Kingfisher bei vorhersehbarem und gleichmäßigem Traffic den Einsatz von Kubernetes mit Horizontal Pod Autoscalern. Diese Kombination bietet Kosteneffizienz, Kontrolle und eine einfache Skalierung, da Serverless-Modelle bei hohem Anfragevolumen oft teurer werden.

Die bei Serverless anfallenden Kosten entstehen unter anderem durch das „one request, one invocation“-Modell, das sich bei kontinuierlicher Nutzung als weniger wirtschaftlich erweist. Serverless-Lösungen eignen sich besser bei unregelmäßigem, kurzzeitigem Traffic. Dort kann die Abrechnung pro Nutzung und die automatische Elastizität deutliche Vorteile bieten. Bei dauerhaft hohem Durchsatz überwiegen jedoch die Kostenvorteile von Kubernetes, wenn die Infrastruktur gut verwaltet wird. Da Kubernetes jedoch mit einer höheren Management-Komplexität verbunden ist, setzt Kingfisher auf interne Tools wie die APIHandler-Bibliothek, die als schlanker FastAPI-Wrapper fungiert.

Dies erleichtert Entwicklern das schnelle Bereitstellen von KI-APIs mit standardisiertem Monitoring, Logging und Metriken. Die Integration mit Terrraform und CI/CD-Vorlagen beschleunigt zudem den Deployment-Prozess und garantiert konsistente Infrastruktureinstellungen. Ein besonders spannender Aspekt ist bei Kingfisher die Bereitstellung GPU-basierter Workloads für die Inferenz. Während Serverless-Angebote vermehrt GPU-Optionen anbieten, bevorzugt Kingfisher hier aktuell dedizierte GPU-Node Pools in Kubernetes-Clustern. Dies bietet maximale Flexibilität bei der Ausführungsumgebung und erlaubt komplexere Modellpipelines mit Vorverarbeitungsschritten oder Modellketten, wie sie beispielsweise Triton unterstützt.

Noch steht die GPU-Unterstützung von Serverless-Plattformen erst am Anfang, doch Kingfisher beobachtet diese Entwicklung aufmerksam und wird zukünftige Möglichkeiten evaluieren, um von weiterer Vereinfachung und verbesserter Bedienbarkeit zu profitieren. Letztlich ergibt sich aus den praktischen Erfahrungen von Kingfisher Group AI ein differenziertes Bild: Serverless-Dienste sind hervorragend geeignet, um die Infrastrukturkomplexität beim Skalieren elastischer und stark variierender Machine Learning Workloads zu reduzieren. Gleichzeitig liefert Kubernetes in Szenarien mit hohen Anforderungen an Kostenkontrolle, Flexibilität und langfristige Wartbarkeit klare Vorteile. Die Kombination beider Ansätze, angepasst auf die Besonderheiten der jeweiligen Anwendungsfälle, bietet den idealen Weg, um KI-Anwendungen in großem Maßstab effizient, zuverlässig und flexibel zu betreiben. Für Unternehmen, die zukunftsfähige AI-Plattformen entwickeln möchten, ist das Verständnis dieser Vor- und Nachteile essenziell, ebenso wie die Fähigkeit, technische Expertise in beiden Welten aufzubauen.

Ein komplexes Ökosystem wie Künstliche Intelligenz erfordert individuelle Lösungen und pragmatische Kompromisse. Die hybride Architektur von Kingfisher Group AI zeigt, dass weder Serverless noch Kubernetes allein die universelle Antwort sind. Vielmehr ist es entscheidend, die Charakteristika der eigenen Workloads, den Traffic, das Teamwissen und die operativen Anforderungen genau zu analysieren und daraus eine maßgeschneiderte Infrastrukturstrategie abzuleiten. Wer sich dieser Herausforderung stellt, kann nachhaltig von den Vorteilen beider Welten profitieren und Innovationen mit KI erfolgreich in die Praxis bringen.