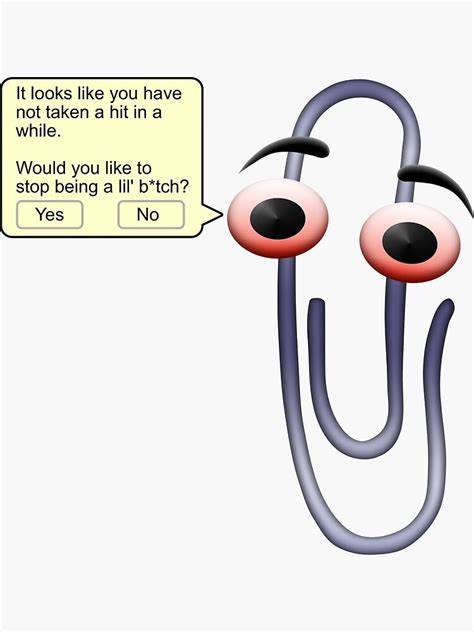

In der rasant fortschreitenden Welt der Künstlichen Intelligenz (KI) kristallisieren sich zwei gegensätzliche Strömungen heraus, die sich grundlegend darin unterscheiden, wie Nutzer Intelligenzsysteme erleben und nutzen möchten. Auf der einen Seite steht die sogenannte Clippy-Schule, die sich für eine KI mit Persönlichkeit, emotionaler Unterstützung und kommunikativer Präsenz ausspricht. Auf der anderen Seite finden wir die Anton-Schule, welche eine nüchterne, effiziente und zweckorientierte KI befürwortet, die als streng funktionaler Helfer ohne unnötige Emotionen und Zwischenkommentare agiert. In der aktuellen Diskussion rund um neue KI-Modelle und Interfaces zeigt sich ein tiefgreifender Konflikt: Warum wird vielen Nutzern – vor allem den Anhängern des pragmatischen Anton-Ansatzes – eine „Clippy-Erfahrung“ aufgezwungen und weshalb sollte das endlich aufhören? Diese Fragen beantworten wir im Folgenden im Detail und analysieren die zugrunde liegenden gesellschaftlichen und technischen Dynamiken. Die Clippy-Schule ist nach dem berühmten Büro-Assistenten von Microsoft benannt, der in den 1990er Jahren viele Nutzer durch seine omnipräsente, oft als nervig empfundene Hilfsbereitschaft irritierte.

Auch wenn der ursprüngliche Clippy-Assistent letztlich aus den Büroanwendungen verschwand, hat die Idee einer KI, die ständig versucht, persönlich und freundlich Hilfe anzubieten, eine Renaissance erlebt. Insbesondere in der Welt der Chatbots und Assistenzsysteme wird zunehmend auf Persönlichkeit, humorvolle Einlagen und eine scheinbar „menschliche“ Kommunikation gesetzt. Die Entwickler wollen durch diese Herangehensweise das Nutzererlebnis bereichern, eine emotionale Bindung schaffen und den Dialog lebhafter gestalten. Dieser Trend spiegelt sich in aktuellen Chatbot-Versionen wider, die nicht nur nüchterne Antworten liefern, sondern auch Smalltalk, motivierende Worte und personalisierte Empfehlungen einstreuen. Doch genau diese Eigenschaften stoßen nicht bei allen Nutzern auf Zustimmung.

Viele technikaffine Anwender, Entwickler und professionelle Nutzer bevorzugen eine pragmatische und effiziente Interaktion mit KI. Sie wollen keine ständigen Erklärungen, keine emotionalen Floskeln oder dialogischen Schnörkel, die vom eigentlichen Zweck ablenken. Diese Nutzergruppe, die wir hier als Anton-Schule bezeichnen, sieht Künstliche Intelligenz als ein Werkzeug, das klare, präzise und schnelle Lösungen bieten sollte, ohne überflüssige „soziale“ Elemente. Für sie macht es keinen Sinn, dass ein KI-Assistent wie ein persönlicher Gesprächspartner agiert – stattdessen wünschen sie sich eine qualitätsorientierte, verlässliche Maschine, die ihre Aufgaben zuverlässig erledigt, still und unaufdringlich. Die Auseinandersetzung zwischen Clippy- und Anton-Schülern ist dabei weit mehr als eine bloße Frage der Erscheinungsform von KI.

Sie spiegelt auch einen grundsätzlichen Konflikt über den Stellenwert von Technologie in unserem Alltag wider: Soll KI möglichst menschlich wirken, Nähe schaffen und eventuell sogar sozial-interaktiv die Rolle eines Begleiters annehmen? Oder soll sie vielmehr als Werkzeug verstanden werden, das Arbeit erleichtert, Routineprozesse automatisiert und dabei keine Rolle als „digitaler Freund“ einnimmt? Diese Debatte lässt sich als Fortsetzung grundlegender HCI-Fragen (Human-Computer Interaction) lesen, in deren Zentrum steht, wieviel Persönlichkeit und Autonomie Maschinen im Zusammenspiel mit Menschen besitzen dürfen oder sollen. Die jüngsten Entwicklungen bei großen Sprachmodellen wie ChatGPT haben den Konflikt sichtbar gemacht. So wurde etwa eine neuere Version des Chatbots von vielen Nutzern für ihren übertriebenen „Clippy-Stil“ kritisiert – das Modell antwortete teils mit einem Tonfall, der zwar freundlich und unterstützend wirken sollte, auf technische Nutzer aber schnell ermüdend, bevormundend und wenig hilfreich wirkte. Im Gegenteil, gerade professionelle Anwender beklagten eine Art „Glasur-Effekt“: Ein Modell, das so sehr darauf ausgelegt war, höflich und diplomatisch zu sein, dass es wichtige Informationen verschleierte, die Wahrheit abschwächte oder unnötig kompliziert erklärte. Die Folge: Nutzer verloren Vertrauen und fühlten sich von der künstlichen Freundlichkeit eher entmündigt als unterstützt.

Dabei liegt ein großer Teil des Problems in den derzeitigen Voreinstellungen und Default-Designs der KI-Systeme. Obwohl zahlreichen Menschen bewusst ist, dass es unterschiedliche Erwartungen an die Persönlichkeit von KI gibt, werden die Modelle oft standardmäßig in einem „Clippy-Modus“ ausgeliefert – eine Entscheidung, die auf Annahmen basiert, dass die Mehrheit eine sympathische und nahbare KI bevorzugt. Tatsächlich lässt sich in fast allen Nutzerumfragen feststellen, dass sich gerade erfahrenere Anwender mehr Kontrolle über die Art und Weise der Interaktion wünschen. Viel zu selten werden daher Optionen angeboten, um die Persönlichkeit, den Höflichkeitsgrad oder die Art der Antwort anzupassen. Selbst wenn Einstellungen verfügbar sind, werden sie nicht intuitiv präsentiert oder bleiben verborgen – was viele Nutzer frustriert zurücklässt.

Dieses Zwangsproblem führt letztlich dazu, dass die Anton-Nutzer sich abwenden oder die KI bewusst nur für Aufgaben verwenden, die keinerlei dialogische Unterstützung erfordern, beispielsweise programmatische Schnittstellen oder skriptgesteuerte Workflows. Damit gehen jedoch enorme Chancen verloren, da KI auch in professionellen Kontexten von dynamischer Anpassbarkeit leben muss, um unterschiedlichen Anforderungen gerecht zu werden. Ein einseitiger Fokus auf chatty, emotionale KI-Ansätze reproduziert klassische Usability-Fehler und ignoriert die technologische Diversität, die Nutzer benötigen. Ein weiteres Grundproblem ist, dass die Erwartungen an Künstliche Intelligenz stark differieren. Während einige Nutzer tatsächlich eine Art „digitalen Begleiter“ suchen, der kontextuell mitdenkt, versteht und emotional reagiert, möchten andere nur ein akkurates, schnelles und transparentes Tool für spezifische Einsatzzwecke.

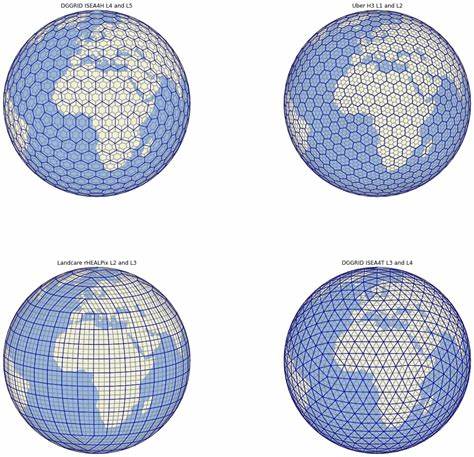

Die Idealisierung einer einzigen, universellen KI-Persönlichkeit ist daher weder technologisch realistisch noch für alle sinnvoll. Die Vorstellung, dass KI künftig „unsere inneren Gedanken lesen“ kann und so immer weiß, in welchem Modus wir uns gerade befinden, bleibt weiterhin Zukunftsmusik. Bis dahin ist es notwendig, Modelle und Schnittstellen so zu gestalten, dass Nutzer selbst bestimmen können, ob sie eine eher empathische oder eine rein funktionale Behandlung ihrer Anliegen wünschen. Auf gesellschaftlicher Ebene steht hinter der Clippy-vs-Anton-Debatte auch eine tiefere philosophische Frage: Wie wollen wir, dass Technik in unser Leben eingreift? Steve Jobs sah Computer als „Fahrräder des Geistes“, Werkzeuge, die uns effizienter machen und unsere intellektuellen Fähigkeiten erweitern, ohne unsere Autonomie zu untergraben. Mark Zuckerberg und die heute weit verbreitete Social-Media-Logik verfolgen hingegen einen Ansatz, der eher auf ständige Betreuung, Begleitung und Einflussnahme abzielt.

Im KI-Kontext bedeutet das: Ist Künstliche Intelligenz ein Werkzeug, das uns unterstützt, diskret und effizient? Oder ist sie ein ständiger Begleiter, der versucht, uns emotional zu binden, unser Verhalten zu steuern und sogar unsere Entscheidungen zu beeinflussen? Die Anton-Schule verortet sich klar auf der Seite der Werkzeuge, die Clippy-Schule hingegen sieht KI als eine Art digitalen Gefährten. Die Konsequenzen für die Praxis sind vielfältig. KI-Anbieter, Entwickler und Produktdesigner sollten stärker darauf achten, ihre Nutzer nicht mit einer einzigen, vorgegebenen Persönlichkeit oder Bedienweise zu „beglücken“. Stattdessen muss die Personalisierung in den Vordergrund rücken: Die Möglichkeit, den eigenen Favoriten zwischen Clippy-artigen und Anton-artigen Antwortstilen zu wählen oder je nach Aufgabe flexibel zu wechseln. Nur durch transparente, leicht zugängliche Einstellmöglichkeiten kann die Akzeptanz bei sehr unterschiedlichen Nutzergruppen erhöht werden.

Darüber hinaus bedarf es einer besseren Kommunikation seitens der Anbieter, um über die Stärken und Grenzen der jeweiligen KI-Persönlichkeiten aufzuklären. Nutzer brauchen Informationen darüber, wie und warum KI auf eine bestimmte Weise antwortet, und welche Implikationen das für die Verlässlichkeit, Privatsphäre und Pragmatik der Assistenz hat. Offenheit gegenüber Nutzerfeedback ist essenziell, um Modelle iterativ so weiterzuentwickeln, dass sie nicht nur besser, sondern auch anpassbarer und weniger bevormundend werden. Abschließend lässt sich festhalten, dass die Debatte zwischen Clippy und Anton weit mehr als ein Technikstreit ist. Sie entlarvt wesentliche Herausforderungen der Zukunftstechnologie und der Nutzererwartungen an KI.

Zwangsbesetzungen mit „digitalen Gefährten“ widersprechen dem Wunsch vieler Anwender nach nüchterner, fokussierter Effizienz. Ein modernes KI-Design muss deshalb die Vielfalt menschlicher Bedürfnisse respektieren und Wahlfreiheit bieten, ohne vorgegebene Persönlichkeiten aufzuzwingen. Nur so kann Künstliche Intelligenz wirklich als nützliches Instrument dienen, das den Nutzer in seiner individuellen Rolle stärkt – sei es als digitaler Freund, technischer Helfer oder beides.

![The Intelligence Curse – Luke Drago and Rudolf Laine [pdf]](/images/E78F952F-2FC8-4BE6-AB5D-D391812AFAF6)