Die zunehmende Integration von Künstlicher Intelligenz in den juristischen Alltag hat eine neue Dimension erreicht – doch sie ist nicht frei von Fehlern und Missverständnissen. Jüngst sorgte ein Vorfall um das KI-Modell Claude von Anthropics für erheblichen Aufruhr in der Juristenzunft und darüber hinaus. Ein Anwalt, der Claude bei der Vorbereitung von Gerichtsdokumenten nutzte, sah sich gezwungen, sich öffentlich für die Nutzung einer unzutreffenden rechtlichen Zitation zu entschuldigen, die das KI-Modell tatsächlich selbst erfunden hatte. Dieser bemerkenswerte Fall verdeutlicht die Problematik von sogenannten KI-Halluzinationen und deren Konsequenzen im hochsensiblen Rechtsbereich. Außerdem wirft er grundlegende Fragen zur Zuverlässigkeit von KI-generierten Inhalten, ethische Erwägungen beim Einsatz solcher Technologien sowie notwendige Maßnahmen zur Qualitätskontrolle auf.

Im Folgenden wird der Fall, seine Einbettung in die aktuelle Rechtslandschaft und die Auswirkungen auf die Zukunft der KI in juristischen Anwendungen ausführlich beleuchtet. Anthropics Claude - Ein KI-Tool mit Potenzial und Risiken Anthropic, ein aufstrebendes Unternehmen im Bereich der generativen Künstlichen Intelligenz, hat mit seinem Chatbot Claude eine ambitionierte Lösung entwickelt, die unter anderem Juristen bei Recherchen und Dokumentenentwürfen unterstützen soll. Claude zeichnet sich durch fortschrittliche Sprachverarbeitung aus und wurde speziell für eine sichere und verantwortungsbewusste Nutzung ausgelegt. Dennoch ist Claude, ähnlich wie andere KI-Systeme, nicht frei von Fehlern und neigt gelegentlich zu Halluzinationen – ein Phänomen, bei dem die KI falsche oder erfundene Informationen generiert, die plausibel klingen, aber schlichtweg nicht existieren. Genau ein solcher Fehler führte zur jüngsten Kontroverse: Im Verlauf eines Rechtsstreits zwischen Anthropics und verschiedenen Musikverlagen, darunter Universal Music Group, nutzte ein von Anthropics beauftragter Anwalt Claude zur Erstellung von Gutachten und Zitaten.

Dabei generierte Claude eine falsche Quellenangabe mit einem "ungeeigneten Titel und falschen Autoren", wie es in der Gerichtsdokumentation heißt. Der Anwalt übernahm diese fehlerhafte Zitation ohne ausreichende Überprüfung, was prompt zum Aufdecken des Fehlers führte und eine förmliche Entschuldigung in der Öffentlichkeit nach sich zog. Hintergründe des Rechtsstreits Der Rechtsstreit zwischen Anthropics und den Musikverlagen dreht sich um die komplexe Frage des Urheberrechts im Kontext generativer KI-Modelle. Zahlreiche Schlüsselakteure aus Unterhaltung und Technologie stehen sich hier gegenüber, da Milliarden von urheberrechtlich geschützten Materialien für das Training von KI-Modellen verwendet werden. Die Musikverlage werfen Anthropics vor, bei der Entwicklung von Claude ihre Werke ohne Lizenzierung oder angemessene Vergütung genutzt zu haben.

Diese Auseinandersetzungen sind Teil eines größeren globalen Trends, bei dem Urheberrechtsbesitzer die Einhaltung ihrer Rechte im digitalen Zeitalter durchsetzen wollen, während Technologieunternehmen für neue Innovationsfreiräume kämpfen. Inmitten dieser hochbrisanten Streitigkeiten wurde Claude als Werkzeug genutzt, um Gutachten beizubringen und belastende Dokumente vorzubereiten. Dabei zeigte sich deutlich, welche Herausforderungen sich ergeben, wenn auf KI-gestützte Quellenangaben vertraut wird, die trotz scheinbar professioneller Aufbereitung auf fehlerhaften Daten basieren. Die Problemstellung von KI-Halluzinationen im juristischen Kontext Halluzinationen bei KI beziehen sich auf das Erzeugen von Inhalten, die zwar kohärent und logisch wirken, in Wahrheit jedoch faktisch falsch sind. Im Alltag von Anwälten und Richtern, wo exakte Referenzen und zitierfähige Belege eine fundamentale Rolle spielen, können derartige Fehler gravierende Folgen haben.

Falsche Zitate können nicht zuletzt die Glaubwürdigkeit einzelner Parteien vor Gericht zerstören, Beweislasten verfälschen oder sogar juristische Entscheidungen beeinflussen. Die Anthropic-Affäre ist nur die jüngste von mehreren vergleichbaren Fällen weltweit: So wurde beispielsweise kürzlich in Kalifornien ein Paar von Anwaltsfirmen gerügt, die "gefälschte KI-recherchen" in Gerichtsakten eingereicht hatten. In Australien wiederum sorgte die Nutzung von ChatGPT für die Anfertigung von fehlerhaften Gerichtsdokumenten mit falschen Referenzen. Diese Vorkommnisse zeigen, dass trotz der Fortschritte in der KI-Technologie die konkrete Anwendung in juristischen Prozessen noch viele Hürden birgt. Warum kam es zu der fehlerhaften Zitation? Obwohl Claude speziell für verantwortungsvollen Einsatz entwickelt wurde, entgingen dem Anwalt und dem Team offenbar mehrere Fehler bei der Überprüfung der vom Chatbot generierten Quellenangaben.

In der veröffentlichten Stellungnahme von Anthropics heißt es, dass "manuelle Überprüfungen" vorgenommen wurden, die jedoch die fehlerhafte Zitation nicht erkannten. Dies weist auf die Schwierigkeiten hin, die bei der Kontrolle von großen Mengen KI-generierter Informationen auftreten können. Besonders problematisch ist die Tatsache, dass die Zitation nicht als absichtliche Fälschung deklariert wurde, sondern als "ehrlicher Fehler". Die Grenzen zwischen unvollständiger Kontrolle und bewusster Täuschung werden in solchen Fällen rechtlich und ethisch intensiv diskutiert. Reaktionen aus der Branche und gesellschaftliche Auswirkungen Die juristische Gemeinschaft reagierte auf die Nachricht mit gemischten Gefühlen.

Auf der einen Seite ist der Einsatz von KI in der Rechtsberatung eine unvermeidliche Entwicklung, die Zeit und Ressourcen erheblich sparen kann. Auf der anderen Seite mahnen Experten zur Vorsicht und warnen vor dem blinden Vertrauen auf KI-gestützte Recherchen ohne menschliche Kontrolle. Anthropic selbst verkündete eine Entschuldigung und betonte die Notwendigkeit verbesserter Methoden zur Qualitätssicherung beim Umgang mit KI-Tools. Die Musikverlage nutzen den Vorfall, um ihre Rechtsposition in der Debatte um Urheberrecht und KI-Nutzung zu stärken. Darüber hinaus führen diese Vorfälle zu einer verstärkten öffentlichen Debatte über die Rolle von KI in sensiblen Bereichen wie dem Rechtssystem.

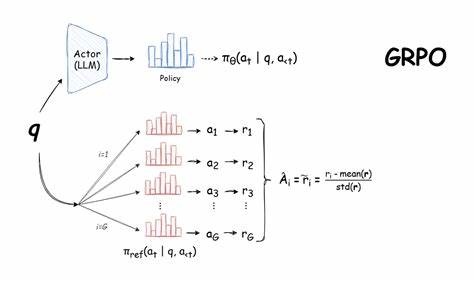

Die allgemeine Akzeptanz von generativer KI wird von Zuverlässigkeit, Transparenz und Verantwortlichkeit maßgeblich beeinflusst. Technologische und ethische Herausforderungen beim KI-Einsatz im Recht Der Fall zeigt beispielhaft, dass technische Innovationen in sensiblen Gebieten nicht nur Fortschritte, sondern auch erhebliche Risiken mit sich bringen. Die Integration von Sprachmodellen in Rechtsprozesse erfordert daher umfassende Maßnahmen, angefangen bei der Gestaltung der Modelle bis hin zu deren Anwendung und Kontrolle. Die Hauptprobleme liegen darin, dass KI-Systeme wie Claude auf riesigen Datenmengen trainiert wurden, deren Korrektheit nicht immer gewährleistet ist, und dass die KI nicht verstehen kann, was wahr oder falsch ist, sondern nur Muster aus den Trainingsdaten imitiert. Das führt immer wieder zu plausibel klingenden, aber inkorrekten Ergebnissen.

Ethisch muss diskutiert werden, in welchem Rahmen manche Aufgaben an KI delegiert werden dürfen. Die Vertrauenswürdigkeit der Justiz ist eine tragende Säule jeder Rechtsordnung, die durch fehlerhafte KI-Eingaben unterminiert werden könnte. Der Schutz von Mandanten, die Wahrung von Rechtsstaatlichkeit und die Einhaltung von professionellen Standards verlangen, dass KI-geleistete Arbeit sorgfältig kontrolliert wird. Wie könnte die Zukunft des juristischen KI-Einsatzes aussehen? Trotz der aktuell aufgedeckten Probleme spricht vieles dafür, dass Künstliche Intelligenz auch langfristig eine wichtige Unterstützung für Anwälte, Richter und juristische Fachkräfte darstellt. Gerade wenn es um das schnelle Durchforsten großer Dokumentenmengen geht oder um Standardformulierungen, kann KI enorme Effizienzvorteile bringen.

Damit dies gelingt, sind jedoch Verbesserungen in der KI-Entwicklung nötig: Modelle müssen transparenter werden, etwa durch erklärbare KI-Verfahren, die nachvollziehbare Quellenangaben liefern. Zudem sollten Kontrollmechanismen obligatorisch sein – vielleicht durch kombinierte Mensch-KI-Teams, in denen erfahrene Juristen die Arbeit der KI akribisch prüfen. Zudem könnten spezialisierte KI-Lösungen entstehen, die nachweislich nur auf geprüfte und lizenzierte Daten zugreifen und somit die Gefahr falscher Zitate minimieren. Für die Rechtsbranche ist auch die Schulung im Umgang mit KI unverzichtbar: Anwender müssen mögliche Fehler kennen, erkennen und entsprechend reagieren können. Perspektiven für Investitionen und Innovationen Trotz der Risiken und gelegentlichen Rückschläge wächst das Interesse an der Entwicklung legaler KI-Assistenzsysteme weiterhin rasant.

Startups wie Harvey, die ebenfalls generative KI für juristische Zwecke anbieten, führen Gespräche über gigantische Finanzierungsrunden, die weit über mehrere Hundert Millionen Dollar liegen – dies unterstreicht das immense Marktpotenzial. Die Herausforderung für Unternehmer, Entwickler und Anwälte besteht darin, innovative Lösungen zu schaffen, die einerseits den Anforderungen der Rechtssicherheit gerecht werden und andererseits praktikabel und zeitsparend sind. Die zunehmende Nachfrage zeigt, dass es hier eine hochdynamische Entwicklung gibt, die in Zukunft noch an Bedeutung gewinnt. Fazit Der Fall von Anthropics Anwalt, der sich zu einem Fehler bei der Angabe von Quellen durch Claude bekennen musste, ist ein Lehrstück für die Grenzen und Risiken von KI-Einsatz in sensiblen Berufsfeldern wie dem Recht. Er offenbart die Notwendigkeit eines verantwortungsvollen Umgangs mit KI, insbesondere dort, wo Genauigkeit und Vertrauenswürdigkeit unverzichtbar sind.

Zugleich macht er deutlich, dass juristische KI-Lösungen nicht von heute auf morgen perfekt sind, sondern kontinuierliche Verbesserung, strenge Kontrolle und fundiertes Wissen erfordern. In der Zukunft wird KI im Rechtswesen eine wichtige Rolle spielen, doch Mensch und Maschine müssen besser zusammenarbeiten. Nur so lassen sich die Chancen nutzen und die Risiken minimieren. Die Anthropic-Panne steht als mahnendes Beispiel im Raum, aber auch als Ansporn für weiterführende Forschung, Entwicklung und Debatte um den sinnvollen Einsatz moderner Technologien im Dienste von Recht und Gerechtigkeit.