Protobuf gilt seit seiner Einführung durch Google als eine der effizientesten Methoden zur serialisierten Datenübertragung zwischen Diensten. In Go-basierten Systemen war lange Zeit gogoproto die bevorzugte Wahl, da es eine schnelle und reflexionsfreie Implementierung ermöglichte, die gegenüber der offiziellen golang/protobuf-Implementierung deutlich performanter war. Doch im Laufe der Zeit haben sich technologische Entwicklungen und Änderungen im Ökosystem ergeben, die den Umstieg von gogoproto auf neuere Alternativen notwendig machen – allen voran vtproto. Dieser Wechsel ist weit mehr als ein simpler Austausch einer Bibliothek, sondern ein umfassender Modernisierungsprozess mit weitreichenden Auswirkungen auf die Codebasis, Performance und das Entwicklererlebnis. Protobuf als Standard für Kommunikationsprotokolle in Microservices und verteilten Systemen ist besonders aufgrund der kompakten Binärformate und der strengen Schema-basierten Spezifikation beliebt.

Die Serialisierung und Deserialisierung von sogenannten Data Transfer Objects (DTOs) erfolgt üblicherweise mittels des von Protobuf bereitgestellten Tools protoc, welches basierend auf .proto-Dateien Go-Code generiert. Seit geraumer Zeit wird in der Go-Community eine Konsolidierung hin zur neuen offiziellen Google-Implementierung vorgenommen, die jedoch auf Reflexion basiert und daher langsamere Laufzeiten mit sich bringt. gogoproto setzte diesem Trend entgegen, indem es reflexionsfreien Code erzeugte und somit erhebliche Performancevorteile ermöglichte. Diese Tatsache führte zu einer breiten Nutzung nicht nur in kommerziellen Projekten, sondern auch in Open-Source-basierten Schwergewichten wie Kubernetes.

Der Paradigmenwechsel begann im Jahr 2021, als die bisher genutzte golang/protobuf-Bibliothek samt gogoproto-Bibliothek als veraltet erklärt wurde. Dies führte in der Folge zu Herausforderungen für Entwicklerteams, die auf bereits bestehende Abhängigkeiten in kritischen Systemteilen angewiesen waren. Reflexionsfreie Implementierungen waren nicht mehr offiziell verfügbar, wodurch die Notwendigkeit wuchs, eine performant implementierte, aber trotzdem zukunftsfähige Alternative zu finden. Hier kommt vtproto ins Spiel – ein neues protoc-Plugin, das ähnlich wie gogoproto Code ohne Reflexion generiert, jedoch modernere Herangehensweisen an Performance-Optimierungen und Speichermanagement erlaubt. vtproto zeichnet sich insbesondere durch Features aus, die in gogoproto nicht oder nur limitiert nativ unterstützt wurden.

Dazu zählen Pooling-Mechanismen, um Objekterzeugungen zu minimieren und Speicher effizienter zu nutzen, sowie unsicheres Unmarshalling, bei dem interne Speicherbereiche per Pointer-Manipulationen ohne zusätzliche Kopien umgewandelt werden können. Während dies fortgeschrittene Kenntnisse der Speichersicherheit im Go-Umfeld erfordert, führt es in Kombination zu erheblichen Laufzeitverbesserungen und reduzierten Garbage-Collection-Lasten. Ein weiterer Vorteil von vtproto ist seine aktivere Pflege und Weiterentwicklung, die durch die moderne Codebasis und das Engagement der Community sichergestellt wird. Dies steht im klaren Gegensatz zu gogoproto, das seit der Deprecation kaum noch Updates erhält und somit als potenzielles Risiko für langlebige Projekte gilt. Das Upgrade von gogoproto zu vtproto ist jedoch nicht ohne technische Hürden.

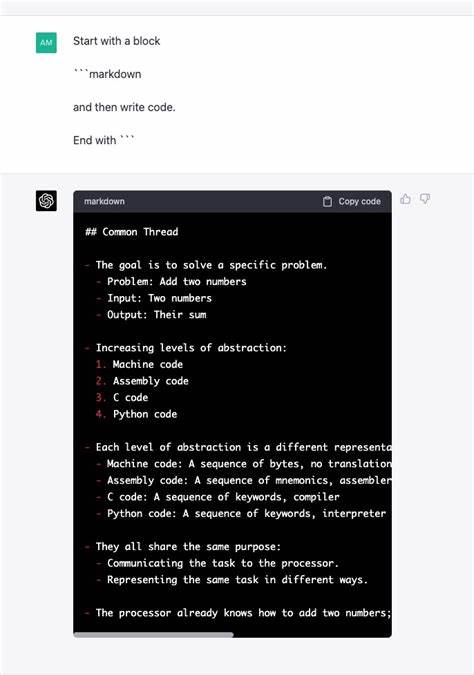

Die beiden Bibliotheken sind nicht direkt kompatibel, was nicht nur Änderungen an den Importpfaden und der API mit sich bringt, sondern tiefgreifende Anpassungen am Build-System, den generierten Code-Dateien und teils auch der Logik im Produktivcode erfordert. Eine zentrale Herausforderung besteht darin, dass vtproto generierte Methoden einen VT-Suffix erhalten (beispielsweise MarshalVT oder UnmarshalVT), während gogoproto ohne Suffix arbeitet. Teams, die einen möglichst reibungslosen Übergang anstreben, implementieren deswegen oftmals Adapter oder Wrapper, die die neuen Methoden unter den alten Namen bereitstellen, um größere Refaktorierungen schrittweise durchzuführen. Der Umstieg ist zusätzlich durch Änderungen bei der JSON-Serialisierung kompliziert. Die offizielle Google-Protobuf-Bibliothek führte ein neues Paket protojson ein, das sich teilweise semantisch von früheren jsonpb-Implementierungen unterschied.

Konkret fließen in das Output-JSON gelegentlich sogenannte „Random Spaces“ ein, die verhindern sollen, dass Anwendungen auf eine bestimmte Formatierung angewiesen sind. Diese Veränderung führt dazu, dass Tests, die direkte Stringvergleiche nutzen, fehlschlagen können – gerade im CI-Umfeld kann dies zu nicht reproduzierbaren Fehlern führen. Entwickler müssen daher ihre Teststrategien anpassen und JSON-Ausgaben entweder semantisch vergleichen oder einheitliche Formatierungsregeln durchsetzen. Auch im Bereich Zeiteinheiten und speziell beim Umgang mit Protobuf-Dauertypen gab es strengere Spezifikationsvorgaben. Während früher eine flexible Interpretation mit Go-Dauerstrings wie „24h“ möglich war, fordert die neue Protobuf-Implementierung ein strengeres Format mit expliziten Sekundenangaben (z.

B. „86400s“). Dadurch entstehen zwar teilweise Migrationsaufwände, aber auch mehr Robustheit bei der Verarbeitung und Übertragung der Zeitangaben. Ein weiterer bedeutender technischer Aspekt ist der Umgang mit internen Feldern. In gogoproto wurden intern verwendete Felder mit dem bekannten Präfix XXX_ gekennzeichnet und konnten daher im Notfall direkt referenziert werden.

In der neuen Protobuf-Implementierung sind interne Felder nicht mehr zugänglich, was den Zugriff und die Nutzung intern implementierter Funktionalitäten erschwert. Zudem führt die Einführung von Mutexes in den generierten Strukturen zu Herausforderungen für Tests, die zuvor auf reflexionsbasierte Gleichheitsprüfungen setzten. Da nicht nur Produktions-, sondern auch Testcode betroffen ist, war es notwendig, neue Assertion-Helper zu entwickeln, die Protobuf-Objekte ohne Reflexion und auf Typ-sichere Weise vergleichen können. Auf organisatorischer Ebene erfordert die Migration umfangreiche Koordination und Planung. Bei komplexen Codebasen mit zahlreichen Abhängigkeiten wurden oft mehrere hundert Pull Requests und Mikromigrationen benötigt, um den Umstieg zu bewerkstelligen.

Dabei kamen Automatisierungswerkzeuge zum Einsatz, wie beispielsweise der Proto-Formatter und Linting-Tools, die nicht nur konsistente Codequalität sicherstellen, sondern auch Abhängigkeiten kontrolliert zerlegen. Zusätzlich wurden eigene linters entwickelt, die sicherstellen, dass während der Migrationsphase keine gogoproto-Typen unabsichtlich in neuem Code verwendet werden. Ein zentrales Konzept war auch das Einführen von Kompatibilitätsschichten, in denen alte gogoproto-Typen mittels Aliasen auf neue vtproto-Typen abgebildet wurden. Dies erlaubte es, den eigentlichen Switch auf einen kleinen isolierten Bereich zu begrenzen, wodurch der Einfluss auf das Gesamtsystem beherrschbar blieb. Die Migration ist kein einmaliges Ereignis, sondern vielmehr eine Reise.

Sie ermöglicht es Teams, von einem veralteten Dependency-Stack zu einem nachhaltigen, gut betreuten und performanten System überzugehen. Gleichzeitig ebnet vtproto durch Features wie Unsafe Unmarshalling und Pooling den Weg für zukünftige Optimierungen, die über die reine Kompatibilität hinausgehen. Gerade für Projekte, die auf eventbasierte Datenhaltung und schnelle Verarbeitung angewiesen sind, sind diese Performancegewinne entscheidend. Aus Sicht der Entwickler bietet die Umstellung auch die Gelegenheit, sich intensiv mit den Eigenheiten von Protobuf, dem generierten Code und auch mit der Unterlagerung von Codegenerierung in modernen Go-Projekten auseinanderzusetzen. Während gogoproto viele Aspekte abstrahierte, schafft vtproto ein Bewusstsein für Speicherallokationen und Performance-Charakteristiken, das gerade bei hochwertigen Backend-Services von unschätzbarem Wert ist.

Das Fazit liegt klar auf der Hand: Der Umstieg von gogoproto auf vtproto ist eine zukunftsweisende Investition in die Performance, Wartbarkeit und Weiterentwicklung von Go-basierten Systemen, die Protobuf intensiv nutzen. Zwar ist der Aufwand nicht zu unterschätzen und darf nicht unterschätzt werden, doch die langfristigen Vorteile überwiegen deutlich. Es ist zu erwarten, dass vtproto sich als De-facto-Standard im Bereich schneller, reflexionsfreier Protobuf-Codegenerierung etablieren wird. Für Entwickler, die vor der Entscheidung stehen, lohnt es sich, den Migrationsprozess gründlich zu planen, partielle Adapterlösungen zu implementieren und begleitend durch automatisierte Tests und Linting die Qualität zu sichern. Ein strukturierter Ansatz mit iterativen Verbesserungen hilft zudem, den Umstieg ohne Unterbrechungen des laufenden Betriebs zu realisieren.

Langfristig profitieren Unternehmen von einer robusteren Technologiegrundlage, leichterer Wartbarkeit und verbesserten Performance in ihrem verteilten Systemökosystem.