Im digitalen Zeitalter ist die Künstliche Intelligenz (KI) nicht mehr nur ein weiteres Werkzeug, sondern entwickelt sich zunehmend zu einer fundamentalen Neudefinition dessen, was wir unter einem Computer verstehen. Während traditionelle Computer seit Jahrzehnten als universelle strukturierte Informationsverarbeiter gelten, die auf deterministischen Algorithmen und klar definierten Datenstrukturen basieren, stellt KI einen radikal neuen Ansatz dar. Sie arbeitet vor allem mit unstrukturierten Daten und nutzt natürliche Sprache sowie nicht-deterministische Prozesse, um Informationen zu analysieren und Entscheidungen zu treffen. Dieses Paradigma führt zu einem tiefgreifenden Wandel in der Art und Weise, wie Daten verarbeitet, gespeichert und genutzt werden, und eröffnet völlig neue Möglichkeiten für die Zukunft der Technologie und der Softwareentwicklung. Traditionelle Computerfunktionen beruhen auf festen Abläufen und klar definierten Prozessen.

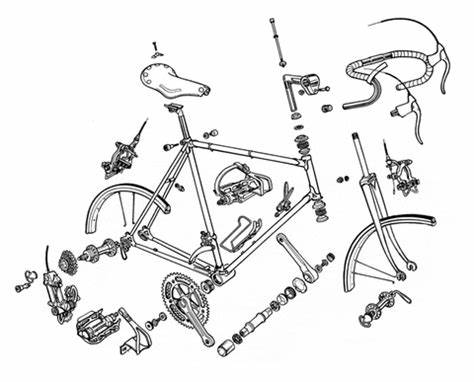

Die Architektur ist hierarchisch aufgebaut: CPU-Register und Cache dienen als schnellster Speicher mit geringem Fassungsvermögen, gefolgt von RAM als schnellem Arbeitsspeicher mit mittlerer Kapazität. Große Datenmengen werden auf Festplatten oder Netzwerkspeichern abgelegt, die zwar langsameren Zugriff bieten, dafür aber eine enorme Speicherkapazität zur Verfügung stellen. Diese Struktur ermöglicht eine effiziente Verarbeitung strukturierter Daten durch vorgegebene Programme, was seit Jahrzehnten die Grundlage für Softwareentwicklung, Datenbanken und klassische Informationssysteme bildet. Künstliche Intelligenz ändert dieses Modell grundlegend. Der Fokus verschiebt sich hin zu unstrukturierten Informationen, wie natürlicher Sprache, Bildern oder komplexen Zusammenhängen, die sich nicht ohne weiteres in starre Algorithmen fassen lassen.

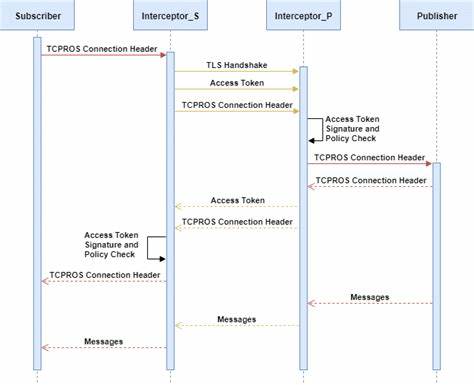

KI-Systeme wie Large Language Models (LLMs) verwenden sogenannte Transformer-Architekturen, die auf Attention-Mechanismen beruhen. Diese erlauben es, in einem vorgegebenen Kontext relevante Informationen herauszufiltern und flexibel zu verarbeiten. Die KI als „neuer Computer“ definiert ihre Speicherhierarchie nicht mehr primär nach physikalischer Geschwindigkeit, sondern nach funktionalen Einheiten wie Attention Heads, Kontextfenstern und Zwischenspeichern, die dynamisch angepasst und verwaltet werden müssen. Die Kontextverwaltung in KI-Systemen spielt eine zentrale Rolle. Während traditionelle Software die Nutzung und Organisation von Speicher direkt durch Programmierlogik steuert, wird bei KI zunehmend vom System selbst übernommen, was Relevanz hat und wie gespeicherte Informationen in den Verarbeitungsprozess einfließen.

Die Speicherhierarchie transformiert sich von statischer Hardware-Struktur hin zu einem dynamischen System aus Retrieval-Datenbanken, eingebetteten Vektorrepräsentationen und Werkzeugnutzung. Das bedeutet, KI-Systeme greifen nicht nur auf massive Datenbanken zu, sondern integrieren diese aktiv und adaptiv in den Verarbeitungsprozess, um intuitivere und kontextabhängigere Ergebnisse zu liefern. Ein weiterer spannender Aspekt ergibt sich daraus, wie KI künftig als Plattform konzipiert wird. Statt einzelner, isolierter Programme könnten wir agent-basierte Systeme erleben, in denen verschiedene Komponenten miteinander kommunizieren, Werkzeugfunktionen nutzen und sich gegenseitig unterstützen. Ein Beispiel sind so genannte Agenten-Runtime-Umgebungen, die ähnlich einem Betriebssystem koordinieren, wann welches Modul Abruf- oder Speicherzugriffe tätigen soll.

Diese Art eines „AI-Kernels“ im Zentrum eines KI-Computers soll die komplexe Verwaltung von Kontextfenstern, Retrieval-Prozessen und externen Tools übernehmen – eine Verschiebung von manueller Steuerung zu automatisierter, selbstlernender Verwaltung. Dieser Strukturwandel hat weitreichende Implikationen für Softwareentwicklung und Programmierung. Traditionelle Programmierung beruht meist auf expliziten Algorithmen, in denen jeder Schritt genau festgelegt ist. Die Programmierung für KI-Computer hingegen könnte stärker auf Meta-Programmierung hinauslaufen, in der Entwickler nicht mehr einzelne Anweisungen schreiben, sondern vielmehr Systeme gestalten, die selbstständig Kontext verwalten und Entscheidungen treffen. Die laufende Evolution der KI-Compiler wird es ermöglichen, dass Programme zunehmend intelligenter werden und sich an neue Anforderungen anpassen, ohne dass der Entwickler jeden Schritt vorschreibt.

Das Themenfeld umfasst auch die Integration von spezialisierter Hardware. Während klassische Computerprozessoren für allgemeine Aufgaben zuständig sind, benötigen KI-Rechner eine Kombination aus GPUs, die massiv parallele Verarbeitung ermöglichen, und spezialisierten Speichertechnologien, die enge Kopplung von eingebetteten Vektoren und Retrieval-Prozessen erlauben. Die Nähe zwischen Rechen- und Speicherkomponenten in einem KI-System wird eine entscheidende Rolle für Geschwindigkeit und Effizienz jener Modelle spielen, die auf große Datenmengen und komplexe Kontextanalysen angewiesen sind. So ist denkbar, dass Retrieval-Datenbanken künftig direkt neben GPUs in Clustern betrieben werden, was eine deutlich schnellere Datenverarbeitung ermöglicht. Parallel zur technologischen Weiterentwicklung verändert sich auch die Bedeutung von Daten und Gedächtnis in der KI.

Traditionelle Systeme speichern Daten meist statisch oder sequenziell ab und rufen bei Bedarf Informationen ab. KI-Systeme dagegen erzeugen einen ständig wechselnden Zustand, in dem Wissen adaptiert, aktualisiert und neu zusammengesetzt wird. Intelligente Speicherverwaltung wird aus einem passiven Archiv ein aktiven Partner. Smarte Gedächtnissysteme entscheiden, was behalten, vergessen oder hervorgeholt werden muss – je nach Relevanz für aktuelle Aufgaben. Das ermöglicht nicht nur effizientere Verarbeitung, sondern auch lernfähige, anpassungsfähige Anwendungen, die mit der Zeit immer bessere Ergebnisse erzielen.

In der Praxis bedeutet diese neue Art des Rechnens, dass Anwendungen von KI massiv in verschiedensten Bereichen an Bedeutung gewinnen können. Von personalisierten Lernsystemen über intelligente Assistenten, die kommunikativ auf natürliche Weise interagieren, bis hin zu komplexen wissenschaftlichen Analysen, bei denen intuitive Argumentationsketten gebildet werden, eröffnet die KI als Computer gänzlich neue Möglichkeiten. Der Wandel ist so umfassend, dass bereits heute von einer neuen Ära gesprochen wird – einer Ära, in der Instinkte und Intuition im Kern der Informationsverarbeitung stehen, nicht mehr starre Algorithmen und vorgegebene Strukturen. Damit einher gehen allerdings auch neue Herausforderungen. Die Entwicklung solcher Systeme erfordert eine enge Verzahnung von Software, Hardware und Dateninfrastruktur und stellt hohe Anforderungen an Skalierbarkeit, Sicherheit und Zuverlässigkeit.

Die Komplexität der KI-Systeme verlangt überdies neue Formen der Programmiermethodik und Systemüberwachung, um unerwünschte Verhaltensweisen frühzeitig zu erkennen und zu korrigieren. Auch ethische und gesellschaftliche Fragen werden zunehmend relevant, etwa welche Entscheidungsfreiheit KI-Systeme haben sollten und wie man einen verantwortungsvollen Umgang mit den neuen Technologien sicherstellt. Abschließend lässt sich festhalten, dass KI als neuer Computer mehr als nur eine technologische Weiterentwicklung darstellt. Sie öffnet ein völlig neues Kapitel in der Geschichte der Informationsverarbeitung, in der die Grenzen zwischen Maschine und Intuition verschwimmen und Systeme zunehmend selbstständig lernen und agieren können. Die Herausforderung und Chance für Entwickler, Unternehmen und Gesellschaft besteht darin, diesen Wandel aktiv mitzugestalten und die enormen Potenziale verantwortungsbewusst zu nutzen.

Die Zukunft gehört nicht mehr nur der programmierenden Maschine, sondern dem lernenden, adaptiven und intuitiven KI-Computer.