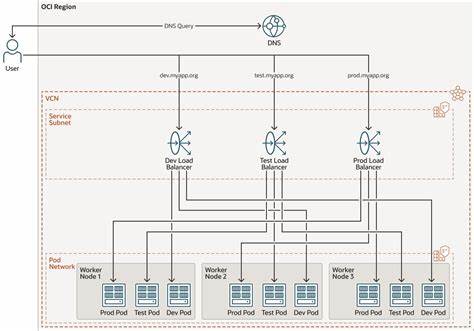

In der modernen Cloud-Welt haben Kubernetes-Plattformen zunehmend an Bedeutung gewonnen, insbesondere wenn sie als Platform-as-a-Service (PaaS) für mehrere Mandanten betrieben werden. In solchen Multi-Tenant-Umgebungen treten jedoch spezielle Herausforderungen auf, die bei der Konfiguration und Verwaltung von DNS-Diensten nicht außer Acht gelassen werden dürfen. Ein besonders relevantes Thema ist dabei das Handling von Split DNS, speziell wenn es darum geht, unterschiedliche DNS-Auflösungen je nach Tenant oder Anwendungskontext sicher und zuverlässig bereitzustellen. Kubernetes beherbergt viele Mikroservice-basierte Anwendungen, die oft auf Dienste wie Kafka zugreifen, um Nachrichten asynchron zu verarbeiten. Dabei ist die DNS-Auflösung essenziell, da Kafka-Clients Broker über deren Hostnamen erreichen, die über DNS zu IP-Adressen aufgelöst werden.

Stimmt die DNS-Konfiguration nicht exakt, können Clients entweder keine Verbindung aufbauen oder werden auf falsche Endpunkte weitergeleitet, was gravierende Auswirkungen auf die Zuverlässigkeit und Sicherheit der Anwendungen haben kann. Die Herausforderung verschärft sich in Multi-Tenant Clustern, da häufig mehrere Nutzer die gleichen Netzwerk- und DNS-Ressourcen teilen. Klassische Ansätze mit isolierten VPCs oder separaten DNS-Zonen stoßen an ihre Grenzen, wenn Ressourcen geteilt werden sollen und gleichzeitig individuelle Anforderungen eines einzelnen Tenants erfüllt werden müssen. Ein typisches Beispiel hierfür ist die Integration eines third-party Kafka-Dienstes per AWS VPC PrivateLink. Die Kunden benötigen, dass DNS-Anfragen für bestimmte Kafka-Domains auf die PrivateLink-Endpunkte zeigen, während der Zugang zu hausinternen Kafka-Systemen parallel erhalten bleibt.

Zunächst wurde versucht, Split DNS direkt auf Route53-Ebene zu realisieren. Das führte jedoch schnell an Grenzen, da Route53 Split DNS pro VPC funktioniert und nicht für Hosts innerhalb geteilten VPCs mit mehreren Mandanten geeignet ist. Daraufhin wurden Kubernetes-eigene DNS-Mechanismen geprüft, etwa die Anwendung von dnsConfig-Einstellungen oder hostAliases in Pods. Diese boten jedoch nicht die gewünschte Flexibilität, da dynamische Wildcard-Regeln nicht abgebildet werden konnten und die Handhabung auf tenantseitiger Ebene schwierig blieb. Die Entwicklung eines Kafka-Proxys erschien als technisch machbare Alternative, um DNS-Anfragen zu intercepten und gezielt weiterzuleiten.

Allerdings würde dies wieder ein neues Skalierungselement und potenzielle Single Point of Failure (SPOF) in die Architektur einführen. Auch ein eigener DNS-Resolver für Clients erschien aufwändig und wartungsintensiv, da komplexe Konfigurationen gepflegt werden müssten und damit der operative Aufwand deutlich steigen würde. Ein entscheidender Fortschritt gelang durch die Anpassung von CoreDNS-Konfigurationen auf Cluster-Ebene. Kern der Lösung war die Nutzung des template-Plugins von CoreDNS, das es erlaubt, bestimmte DNS-Anfragen dynamisch umzuschreiben und auf alternative Endpunkte weiterzuleiten. Auf diese Weise können Broker-Namen von Kafka-Clients zu den PrivateLink-Endpunkten aufgelöst werden, ohne dass feste IP-Adressen oder statische CNAME-Einträge gepflegt werden müssen.

Tenants erhalten somit die Möglichkeit, durch eine einfache Service-Konfiguration wiederkehrende Namensräume für ihre individuelle Kafka-Anbindung zu nutzen. Ein zusätzlicher Aspekt betrifft den Einsatz von node-local DNS Caches. Um DNS-Latenzen zu minimieren und Skalierbarkeit zu gewährleisten, setzen viele Kubernetes-Cluster auf eine lokale DNS-Cache-Ebene auf jedem Knoten. Diese Caches können jedoch problematisch sein, wenn unterschiedliche Pods auf dem gleichen Knoten unterschiedliche DNS-Auflösungen für die gleiche Domain erwarten. Die Lösung besteht darin, die Split-DNS-Konfiguration so zu gestalten, dass sie auch mit node-local DNS kompatibel ist.

Da node-local DNS das CoreDNS Meta-Plugin nicht unterstützt, wird fortgeschrittenes templating genutzt, das in beiden DNS-Instanzen funktioniert. Tenant-seitig ist es notwendig, die DNS-Suchoptionen in den Pod-Konfigurationen entsprechend zu setzen. Insbesondere der DNS-Parameter ndots spielt dabei eine große Rolle. Aufgrund der tief verschachtelten Domänennamen in der Kafka-DNS-Struktur (mit mehreren Punkten) müssen die Pods ndots auf einen hohen Wert, etwa sieben, setzen. Dies stellt sicher, dass die DNS-Anfragen als vollständig qualifizierte Namen interpretiert und nicht fälschlicherweise durch Suchdomänen ergänzt werden, was zu fehlerhaften Auflösungen führen könnte.

Um den Verwaltungsaufwand für Entwickler und Administratoren zu reduzieren, kann die Konfiguration der DNS-Optionen automatisiert werden. Kubernetes Webhooks und Policies, zum Beispiel über Kyverno, ermöglichen es, DNS-Einstellungen automatisch bei der Erstellung oder Aktualisierung von Deployments, StatefulSets oder DaemonSets anzupassen. Durch eine Kombination aus Annotationen und Mutating Webhooks stellen Administratoren sicher, dass Pods immer mit den richtigen DNS-Parametern ausgerollt werden, ohne manuelle Eingriffe. Die beschriebenen praktikablen Lösungen zeigen eindrucksvoll, wie komplexe Herausforderungen im Multi-Tenant Kubernetes Umfeld mit innovativen DNS-Strategien erfolgreich gemeistert werden können. Split DNS wird hier durch die Kombination von CoreDNS Template-Plugins, node-local DNS Caches und tenant-spezifischen Kubernetes Objects realisiert.

Insbesondere wird darauf geachtet, den Betriebsaufwand so gering wie möglich zu halten und gleichzeitig den Mandanten maximale Flexibilität zu bieten. Für Plattformingenieure und Administratoren bedeutet dies eine erheblich verbesserte Kontrolle bei minimaler Komplexität und höherer Stabilität. Gleichzeitig stellt das modellhafte Vorgehen eine Blaupause für weitere Integrationen von Third-Party-Diensten dar, die ähnliche Split DNS Anforderungen mitbringen. Letztlich ist das Split-DNS-Management in Multi-Tenant Kubernetes-Setups kein technisches Randproblem, sondern ein zentraler Baustein für den reibungslosen Betrieb von modernen, verteilten Anwendungen und Services. Der intelligent eingesetzte DNS-Traffic entscheidet maßgeblich über Ausfallsicherheit, Performanz und Skalierbarkeit der gesamten Plattform.

Firmen, die diesen Aspekt frühzeitig adressieren und optimieren, schaffen sich einen Wettbewerbsvorteil und verhindern Folgeprobleme bei der Servicebereitstellung. Denn nur durch ein tiefes Verständnis der DNS-Auflösungspfad-Komponenten, die richtige Auswahl von Kubernetes-eigenen Mechanismen und die adaptive Konfiguration von CoreDNS werden flexible und sichere Multi-Tenant-Cluster möglich. Die hier skizzierte Herangehensweise stellt einen wertvollen Leitfaden dar, um selbst komplexe DNS-Einstellungen in großen Kubernetes-Umgebungen strukturiert und nachhaltig zu implementieren.

![AI Scheduling for Teams [video]](/images/7D96833B-2E14-47FD-916C-89025B868A60)