Die rasante Entwicklung künstlicher Intelligenz (KI) verlangt zunehmend neue technologische Lösungen, um die stetig wachsenden Anforderungen an Rechenleistung und Energieeffizienz zu bewältigen. Klassische digitale Computer stoßen dabei oft an natürliche Grenzen, weshalb alternative Rechenparadigmen in den Fokus rücken. Thermodynamisches Rechnen, eine Methode, die auf physikalischen Prozessen der Thermodynamik basiert, stellt in diesem Kontext eine vielversprechende Chance dar, insbesondere für Anwendungen der probabilistischen KI und generativen Modelle. Thermodynamische Computersysteme zeichnen sich durch ihre Nutzung physikalischer Mechanismen aus, um Rechenoperationen durchzuführen. Die Grundlage bildet hier die thermodynamische Theorie, die stochastische Dynamiken und Fluktuationen in physikalischen Systemen beschreibt.

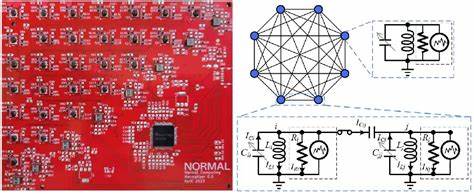

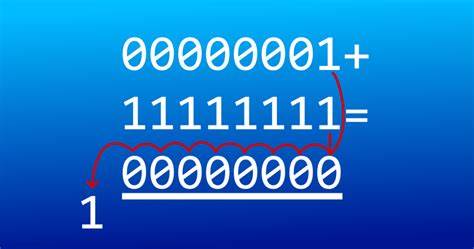

Statt deterministischer Berechnungen, wie sie im digitalen Bereich üblich sind, operieren thermodynamische Rechner mit Wahrscheinlichkeitsverteilungen und nutzen natürliche Prozesse wie das Erreichen eines thermischen Gleichgewichts zur Lösung komplexer mathematischer Probleme. Im Zentrum dieser Technologie steht der sogenannte stochastische Verarbeitungseinheit (Stochastic Processing Unit, SPU). Diese Hardware besteht aus miteinander gekoppelten RLC-Schaltkreisen – also Schwingkreisen, die aus Widerständen (R), Induktivitäten (L) und Kapazitäten (C) bestehen – und ist in der Lage, Zufallsrauschen nutzbringend in der Berechnung einzusetzen. Durch die Kopplung der Einheiten und das gezielte Einstellen von Kapazitäten kann die SPU so gesteuert werden, dass sie komplexe Wahrscheinlichkeitsverteilungen, wie etwa mehrdimensionale Gauß-Verteilungen, erzeugt und somit das Sampling für probabilistische KI-Anwendungen übernimmt. Eine der zentralen Anwendungen thermodynamischer Rechner ist die effiziente Berechnung von linearen Algebra-Operationen, wie beispielsweise die Inversion von Matrizen, die in zahlreichen Bereichen der KI unverzichtbar sind.

Herkömmliche digitale Rechenverfahren für Matrixinversionen auf GPUs oder CPUs sind oftmals energieintensiv und leiden unter Skalierungsproblemen, wenn es um sehr große Modelle geht. Die thermodynamische Variante nutzt das natürliche Verhalten physikalischer Systeme, deren stationäre Zustände direkt mit der inversen Matrix korrespondieren, was zu einer beeindruckenden Reduzierung der benötigten Rechenzeit und des Energieverbrauchs führen kann. Der Vorteil liegt dabei nicht nur in der theoretischen Skalierbarkeit: Simulationen und erste experimentelle Umsetzungen zeigen, dass der SPU ab einer bestimmten Größe reale Leistungs- und Energieeffizienzvorteile gegenüber heutigen State-of-the-Art GPUs bietet. Beispielsweise liegt die sogenannte thermodynamische Vorteilsschwelle, bei der der thermodynamische Rechner schneller arbeitet als herkömmliche Hardware, bei einer Dimension von etwa 3000, was den Einsatz im Bereich großer neuronaler Netze und komplexer probabilistischer Modelle besonders attraktiv erscheinen lässt. Neben der technologischen Leistung ist auch die Robustheit gegenüber Rauschen ein bedeutender Pluspunkt der thermodynamischen Rechner.

Während Rauschen in digitalen Systemen meist als Störgröße gilt, ist es in thermodynamischen Computern ein integraler Bestandteil des Rechenprozesses und wird gewissermaßen zur natürlichen Ressource. Diese Eigenschaft macht das System widerstandsfähiger gegen Fehler und erlaubt es, mit geringerer Präzision in den Komponenten auszukommen, was wiederum die Herstellungskosten senken kann. Trotz dieser vielversprechenden Eigenschaften bringt thermodynamisches Rechnen auch Herausforderungen mit sich. Die derzeitige Hardware basiert auf RLC-Schaltkreisen mit Induktivitäten und Transformatoren, die sich schlecht miniaturisieren lassen und bei einer IC-Implementierung große Probleme verursachen. Um diese Hindernisse zu überwinden, wurde eine alternative Architektur mit RC-Einheiten und resistiven Kopplungen entwickelt.

Diese ist besser für die Integration in Siliziumchips geeignet und bietet vergleichbare Leistungsmerkmale, wie Simulationen zeigen. Ein weiterer zentraler Punkt ist die Präzision und die Vernetzung der einzelnen Einheiten. Für anspruchsvolle Anwendungen ist die exakte Spezifikation der physikalischen Parameter entscheidend, wobei ein Kompromiss zwischen erreichbarer Genauigkeit und Skalierbarkeit besteht. Innovative Fehlerkorrektur- und Präzisionssteigerungsmethoden können hier Abhilfe schaffen, indem sie die effektive Genauigkeit des Systems trotz inhärenter physikalischer Unvollkommenheiten erhöhen. Im Bereich der KI-Anwendungen ist vor allem die probabilistische KI von Bedeutung, bei der Wahrscheinlichkeiten und Unsicherheiten eine zentrale Rolle spielen.

Thermodynamische Rechner sind besonders gut geeignet, um Aufgaben der Bayesianischen Inferenz, des Sampling von Wahrscheinlichkeitsverteilungen und der Unsicherheitsquantifizierung zu beschleunigen. Gerade für generative Modelle wie Diffusionsmodelle oder für Unsicherheitsabschätzungen in neuronalen Netzen können solche Systeme einen entscheidenden Beitrag zur Verbesserung der Leistung und Energieeffizienz leisten. Darüber hinaus eröffnen thermodynamische Rechner Potenziale jenseits von klassischem Sampling und Matrixoperationen. Studien zeigen, dass sie auch zur Lösung von Optimierungsproblemen, Berechnung von Matrixexponentialen und als Teil von zweiten Ordnung Optimierungsverfahren eingesetzt werden können. Perspektivisch bieten thermodynamische Rechner damit ein umfangreiches Portfolio an Rechenoperationen, das über den digitalen Standard hinausgeht.

Die Forschungsrichtung thermodynamisches Rechnen steckt dabei noch in ihren frühen Entwicklungsphasen. Die Parallele zur Quantencomputing-Forschung der 1990er Jahre ist evident: Kleine, proof-of-concept Hardware wurde gebaut, und es beginnt eine intensive Phase der Skalierung und Optimierung. Im Gegensatz zum Quantencomputing sind die technischen Herausforderungen überschaubarer: Es sind keine extremen Bedingungen wie Kryogenik, Isolation von Umwelteinflüssen oder exotische Materialien erforderlich. Das macht thermodynamische Computer zu einer realistischen kurzfristigen Alternative zur Leistungssteigerung von KI-Systemen. Auch wirtschaftlich gesehen ist das Potenzial erheblich.

![Modular Type Classes [pdf]](/images/7C70DA3A-1219-43A7-8A5B-F610F1DD5471)