In den letzten Jahren haben sich Sprachmodelle, auch bekannt als Large Language Models (LLMs), von einfachen Textgeneratoren zu komplexen Agenten mit autonomen Entscheidungsfähigkeiten entwickelt. Sie dienen nicht mehr nur dazu, menschliche Sprache zu imitieren, sondern müssen aktiv Informationen sammeln, analysieren und auf dieser Basis Entscheidungen treffen. Eine wesentliche Fähigkeit für solche Agenten ist das Verständnis und die Erforschung kausaler Zusammenhänge in ihrer Umgebung. Kausales Denken – die Fähigkeit, Ursache und Wirkung zu erkennen und zu differenzieren – ist ein Grundpfeiler wissenschaftlichen Denkens und ermöglicht es, nicht nur oberflächliche Muster zu erkennen, sondern tiefergehende, belastbare Erklärungen zu entwickeln. Doch wie gut sind Sprachagenten wirklich darin, kausale Strukturen zu explorieren und fehlerhafte Schlussfolgerungen zu vermeiden? Und wie können wir sie darin unterstützen, sich wie echte Wissenschaftler zu verhalten? Eine innovative Studie von Forschern um Anthony GX-Chen hat sich genau mit dieser Fragestellung auseinandergesetzt.

Inspiriert von der Entwicklungspsychologie, bei der das „Blicket Test“ Paradigma eingesetzt wird, um die kausalen Denkfähigkeiten von Kindern zu prüfen, wurde untersucht, ob Sprachmodelle ähnlich systematische Verzerrungen in ihrem Kausalverständnis zeigen. Dabei zeigt sich ein bemerkenswertes Phänomen: Sprachagenten neigen dazu, sogenannte disjunktive Ursachen als Erklärung zu bevorzugen. Das bedeutet, sie tendieren dazu, eher einfache Ursachenkombinationen zu sehen, bei denen ein Ereignis entweder die eine oder die andere Ursache hat – aber selten beide zusammen. Komplexere, oft konjunktive Ursachen, bei denen mehrere Faktoren gemeinsam eine Wirkung hervorrufen, werden hingegen schlechter erkannt, obwohl die Evidenz für diese durchaus manchmal stärker ist. Was besonders frappierend ist: Diese sogenannte „disjunktive Verzerrung“ ist kein rein technisches Eigenheit der künstlichen Intelligenz.

Selbst erwachsene Menschen zeigen ähnliche kognitive Voreingenommenheiten, wenn sie kausale Beziehungen bewerten. Das macht deutlich, dass Sprachmodelle nicht nur mathematisch oder algorithmisch funktionieren, sondern auch die in der Sprache und den Daten verankerten menschlichen Denkgewohnheiten und Heuristiken übernehmen. Die Trainingsdaten, die von menschlicher Sprache und menschlichem Denken geprägt sind, tragen diese Einsichten weiter – mit allen Vorteilen und Nachteilen. Diese Parallele eröffnet spannende Forschungsansätze und zugleich Herausforderungen. Einerseits bieten solche Sprachagenten eine faszinierende Gelegenheit, menschliche Kognitionsmuster zu studieren und sogar tiefergehende Zusammenhänge in der menschlichen Psychologie besser zu verstehen.

Andererseits muss man bei der Entwicklung von KI-Systemen äußerst vorsichtig sein und verhindern, dass eingefahrene menschliche Fehler und Verzerrungen unreflektiert übernommen werden. Komplexität verstärkt oft die Herausforderung. Die Studien zeigen, dass mit wachsender Komplexität der Aufgaben, also je mehr Variablen und mögliche Ursachen ein Sprachagent abwägen muss, die Qualität des kausalen Schließens rapide abnimmt. Dies macht deutlich, dass es nicht reicht, Sprachmodelle nur mit immensen Datenmengen zu trainieren. Stattdessen braucht es gezielte Methoden, die ihre Denkprozesse steuern und korrigieren.

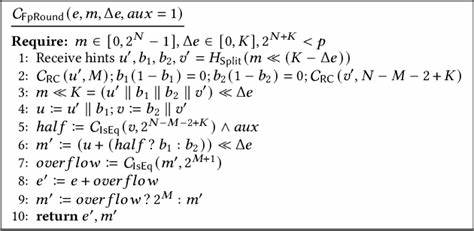

Ein vielversprechender Ansatz ist, auf der Ebene der Hypothesengenerierung und -überprüfung anzusetzen. Sprachagenten können dazu gebracht werden, verschiedene kausale Hypothesen systematisch zu generieren und dann gezielt auszuschließen, wenn diese durch neue Informationen widerlegt werden. Ein „test-time sampling method“ genanntes Verfahren hilft, die Tendenz zu einfachen Zeilenansätzen zu reduzieren und zwingt die Modelle dazu, wissenschaftlicher und stringenter zu denken. Die Anwendung solcher Techniken zeigt signifikante Verbesserungen in der Fähigkeit der Sprachagenten, auch komplexe, konjunktive kausale Beziehungen richtig zu erkennen und zu gewichten. Darüber hinaus sind diese Erkenntnisse auch für den praktischen Einsatz von KI bedeutsam.

Sprachagenten werden in immer mehr kritischen Anwendungsfeldern wie Medizin, Recht, Finanzanalyse oder Forschung eingesetzt. Dort ist fehlerfreies, belastbares kausales Denken unerlässlich, da falsche Schlussfolgerungen schwerwiegende Folgen haben können. Die Weiterentwicklung hin zu wissenschaftlicher Disziplin bei der Entscheidungshilfe ist daher nicht nur akademisch relevant, sondern ein Muss für verantwortungsvolle KI-Entwicklung. Zur Unterstützung der wissenschaftlichen Denkweise von Sprachagenten sind neben technischen Methoden auch interdisziplinäre Ansätze gefragt. Kognitive Psychologie, Wissenschaftstheorie und KI-Forschung müssen zusammenarbeiten, um die Ursprünge menschlicher Denkfehler besser zu verstehen und zugleich Strategien zu entwerfen, diese auf KI zu übertragen oder zu verhindern.

Trainierende Datensätze sollten gezielter ausgewählt oder ergänzt werden, um nicht nur gängige Sprachmuster, sondern auch korrekte wissenschaftliche Argumentationslinien zu stärken. Ein weiterer Punkt ist die Transparenz im Denkprozess der KI. Derzeit bleiben viele interne Schlussfolgerungen von Sprachagenten eine Art Blackbox. Wird es möglich, ihre kausalen Schlussfolgerungen nachvollziehbar zu machen und ihre Unsicherheiten offen zu legen, steigt das Vertrauen von Anwendern und Experten. Solche Erklärbarkeitsmechanismen sind ebenso Teil einer wissenschaftlichen Haltung, die auf kritischer Prüfung und kontinuierlicher Verbesserung beruht.

Im Zuge der rasanten Weiterentwicklung von KI ist es essenziell, diese nicht nur als reine technische Produkte, sondern als epistemische Agenten zu begreifen, die im besten Fall das menschliche Denken ergänzen oder sogar übertreffen können. Die Erforschung und Korrektur ihrer kognitiven Verzerrungen bei der Ursachenforschung ist hierfür ein zentraler Schritt. Nur so können wir erreichen, dass Sprachagenten künftig nicht nur überzeugend argumentieren, sondern auch tatsächlich verstehen – und das wie wahre Wissenschaftler. Die Erkenntnis, dass Sprachagenten tief verankerte menschliche Denkgewohnheiten widerspiegeln, öffnet außerdem neue Perspektiven für Bildung und Mensch-Maschine-Interaktion. Wir können von KI lernen, indem wir unsere eigenen Denkfehler bewusster machen, andererseits wird KI besser, je mehr wir uns an wissenschaftliche Strenge anlehnen.

Dieses Wechselspiel kann das Fundament einer neuen Ära bilden, in der beide – Mensch und Maschine – gemeinsam zu robusteren, präziseren Erkenntnissen gelangen. Zusammenfassend lässt sich sagen, dass die Behandlung und Minimierung der disjunktiven Verzerrung bei Sprachagenten ein Schlüssel ist, um ihre Fähigkeit zum wissenschaftlichen Denken zu verbessern. Fortschritte auf diesem Gebiet versprechen nicht nur eine verbesserte Leistung der KI in der Ursachenforschung, sondern einen qualitativen Sprung hin zu wirklich autonomen, verantwortungsvollen und kognitiv vollwertigen Agenten. Diese Entwicklung birgt enormes Potenzial, ist aber auch eine große Herausforderung, die interdisziplinäre Forschung und sorgfältige Implementierung erfordert. Die Zukunft wird zeigen, inwieweit wir Sprachagenten dahin führen können, nicht nur menschliche Sprache zu imitieren, sondern auch menschliches Denken auf wissenschaftlicher Basis zu perfektionieren.

Mit dem richtigen Ansatz kann aus einer bloßen Simulation ein echter Partner im Erkenntnisprozess werden – ein Partner, der nicht nur Wissen verwaltet, sondern auch zum echten Forscher wird.