Künstliche Intelligenz (KI) hat in den letzten Jahren enorme Fortschritte gemacht, insbesondere im Bereich der natürlichen Sprachverarbeitung. Große Sprachmodelle, sogenannte Large Language Models (LLMs), sind heute in der Lage, Texte zu generieren, Fragen zu beantworten und sogar kreative Aufgaben zu übernehmen. Doch diese Modelle sind nicht frei von Problemen: Sie können tiefverwurzelte, schädliche Stereotype reproduzieren und verstärken, die in den zugrundeliegenden Trainingsdaten enthalten sind. Das Bewusstsein für diese Herausforderungen wächst, und ein entscheidendes Werkzeug in der Forschung ist der Einsatz spezieller Datensätze, um solche Verzerrungen und Vorurteile sichtbar zu machen und zu bekämpfen. In der Welt der KI-Forschung spielen Datensätze eine zentrale Rolle.

Sie bilden die Grundlage für das Training von Modellen, aber auch für deren Evaluation und Weiterentwicklung. Datensätze, die gezielt darauf ausgelegt sind, schädliche Stereotype zu identifizieren, ermöglichen es Forschern, die Problemfelder in den Sprachmodellen aufzudecken. Sie enthalten beispielsweise Beispiele von Sätzen oder Aussagen, die stereotype Darstellungen bezüglich Geschlecht, Ethnizität, Religion, Alter oder anderen sozialen Kategorien prüfen. Die Bedeutung solcher Datensätze liegt darin, dass sie Transparenz schaffen. Viele LLMs basieren auf enorm großen und vielfältigen Textkorpora, die aus dem Internet, Büchern oder anderen Medien gewonnen werden.

Diese Daten enthalten jedoch oft subtile oder offensichtliche Vorurteile, die sich nicht immer direkt erkennen lassen. Ein Datensatz, der gezielt stereotype Muster abfragt, bietet ein Prüfwerkzeug, um diese Muster systematisch zu erfassen und ihre Auswirkungen auf das Modellverhalten zu analysieren. Ein weiterer Vorteil der Verwendung solcher Datensätze ist die Möglichkeit, gezielte Gegenmaßnahmen zu entwickeln. Wenn klar ist, wo und wie ein Sprachmodell schädliche Stereotype reproduziert, können Entwickler Strategien implementieren, um diese Verzerrungen zu verringern. Dazu gehören Anpassungen der Trainingsdaten, Methoden des sogenannten „Debiasing“ oder die Integration von Kontrollmechanismen, die problematische Ausgaben verhindern.

Darüber hinaus bieten diese Datensätze auch eine Grundlage für die Schaffung ethischer Richtlinien in der KI-Entwicklung. Unternehmen und Forschungseinrichtungen sehen sich zunehmend der Verantwortung gegenüber, gut funktionierende und faire Modelle zu erstellen. Die Erkenntnisse, die durch Datensätze zur Stereotypenerkennung gewonnen werden, liefern wichtige Argumente für Regularien und Standards, die langfristig das Vertrauen in KI-Systeme stärken können. Trotz all dieser positiven Aspekte gibt es auch Herausforderungen bei der Entwicklung und Anwendung von Datensätzen zur Erkennung von Stereotypen. Eine Schwierigkeit besteht darin, dass Stereotype kulturell variieren und oft komplex und mehrdeutig sind.

Es erfordert daher eine sorgfältige Auswahl und Gestaltung der Datensätze, um nicht nur offensichtliche, sondern auch subtile Formen von Vorurteilen zu erfassen. Zudem besteht die Gefahr, dass ein Modell mit seiner Komplexität und seinem Lernverhalten wider Erwarten Verzerrungen reproduziert, die von den bisher genutzten Datensätzen nicht erkannt wurden. Deshalb sind kontinuierliche Anpassungen und Erweiterungen der Datensätze notwendig, um mit der Dynamik der Sprache und den gesellschaftlichen Veränderungen Schritt zu halten. Ein wichtiger Schritt ist auch die Einbeziehung multidisziplinärer Expertise bei der Gestaltung solcher Datensätze. Sprachwissenschaftler, Soziologen, Ethiker und Experten für interkulturelle Kommunikation können dazu beitragen, Stereotype präzise zu definieren und die Datensätze entsprechend zu gestalten.

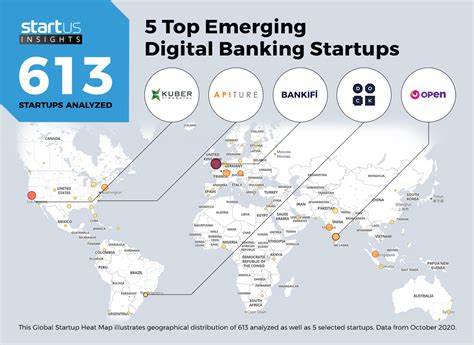

Dies erhöht die Chance, dass die Modelle künftig gerechtere Antworten liefern und diskriminierende Inhalte vermeiden. Die Rolle von Open-Source-Bewegungen und kollaborativen Projekten ist hierbei nicht zu unterschätzen. Durch den offenen Austausch von Datensätzen und Forschungsergebnissen können Initiativen schneller voranschreiten und neue Erkenntnisse fließen in die gemeinsame Entwicklung mit ein. Dies fördert Transparenz und Vertrauen und bietet eine Chance, globale Standards zu etablieren. Ein weiteres wichtiges Feld ist die Anwendung der gewonnenen Erkenntnisse in der Praxis.

Unternehmen, die auf LLMs setzen, können durch den Einsatz solcher Datensätze ihre Produkte und Dienstleistungen verbessern und verantwortungsvoller gestalten. Beispielsweise können Chatbots oder virtuelle Assistenten mit besserer Sensibilität für kulturelle und soziale Diversität ausgestattet werden, was die Nutzererfahrung deutlich verbessert. Zusammenfassend lässt sich sagen, dass Datensätze, die gezielt Schädliche Stereotype in Sprachmodellen aufdecken, eine wichtige Rolle dabei spielen, Künstliche Intelligenz fairer und verantwortungsvoller zu gestalten. Sie tragen dazu bei, dass die Modelle nicht lediglich effektive Textgeneratoren sind, sondern auch ethischen Anforderungen gerecht werden. Die Weiterentwicklung und der verantwortungsbewusste Einsatz solcher Datensätze sind daher essenziell für die Zukunft der KI.