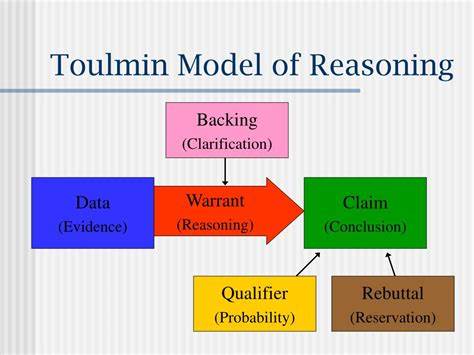

In den letzten Jahren haben Fortschritte im Bereich der Künstlichen Intelligenz (KI) unsere Vorstellung davon, was Maschinen leisten können, revolutioniert. Besonders Reasoning-Modelle, die scheinbar wie Menschen komplexe Probleme lösen, haben erhebliches Interesse geweckt. Doch wie „denken“ diese Modelle eigentlich? Nutzen sie wirklich eine Art von logischem Verstand oder handelt es sich eher um eine illusionäre Simulation von Denkabläufen? Die Frage, ob und wie KI-Modelle wirklich „reasonen“, ist nicht nur faszinierend, sondern entscheidend, um ihre Stärken und Schwächen richtig einzuschätzen und zielführend einzusetzen.Ein weit verbreitetes Missverständnis ist die Vorstellung, KI-Modelle führten gedankliche Zwischenschritte aus, ähnlich wie Menschen es tun, wenn sie ihre Lösungen in mehreren Schritten entwickeln. Die sogenannte Generierung von „Zwischentokens“ oder „Intermediate Token Generation“ hat dieses Bild genährt.

Dabei produziert das Modell während der Problemlösung bestimmte Textfragmente, die wie Zwischenschritte aussehen. Diese werden oft als Beweis für „Denkprozesse“ interpretiert, was die Versuchung nahelegt, die Maschinen zu anthropomorphisieren – sie also menschliche Eigenschaften zuzuschreiben. Forschungen zeigen jedoch, dass diese Interpretation irreführend und potenziell problematisch ist.Diese Zwischenoutputs sind keine echten Gedanken oder reflektierenden Überlegungen. Vielmehr handelt es sich schlicht um einzelne Schrittfolgen, die aufgrund der Trainingsdaten und internen Wahrscheinlichkeitsberechnungen erstellt werden.

Sie folgen einem statistisch ermittelten Muster, das auf Datenmengen beruht, aber nicht auf bewusster, reflektierter Deduktion oder Induktion. Machine-Learning-Modelle analysieren keine Konsequenzen oder logische Wirkungen von Aussagen in einem menschlich verstandenen Sinn; sie berechnen vielmehr die plausibelste Fortsetzung eines Textes oder einer Aufgabenlösung.Die Gefahr der anthropomorphisierten Deutung liegt darin, dass Forscherinnen und Forscher sowie Nutzerinnen und Nutzer falsche Erwartungen an die Fähigkeiten und Grenzen dieser Systeme entwickeln. Wenn man annimmt, dass ein Modell bewusst „nachdenkt“, könnte man seine Ausgaben überinterpretieren oder fehlerhafte Schlüsse hinsichtlich seiner Zuverlässigkeit ziehen. Zudem fördert dieses Missverständnis eine unsachgemäße Anwendung von KI-Systemen, insbesondere in kritischen Bereichen wie Medizin oder Recht, wo ein echtes Verständnis zwingend erforderlich ist.

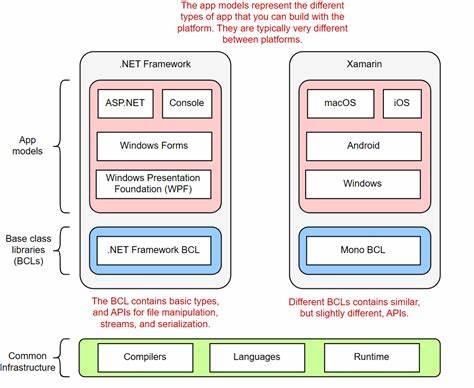

Stattdessen müssen wir verstehen, wie KI-Modelle tatsächlich operieren. Reasoning-Modelle basieren großteils auf tiefgehenden neuronalen Netzwerken, die auf riesigen Datenmengen trainiert werden, um Muster und Zusammenhänge zu erkennen. Ihre Antworten entstehen aus komplexen mathematischen Wahrscheinlichkeitsberechnungen, nicht aus bewussten planerischen Entscheidungen. Die vermeintlichen „Gedankenschritte“ entsprechen nur temporären Teiltokens, die statistisch sinnvoll sind, ohne ein echtes intrinsisches Verständnis des Problems.Diese Unterscheidung hat praktische Auswirkungen.

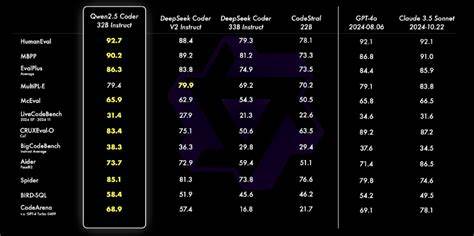

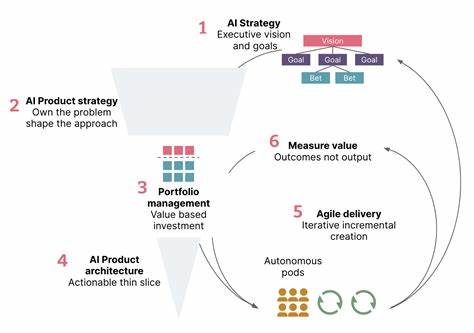

Erkennt man den tatsächlichen Mechanismus, kann man Lösungsansätze entwickeln, die nicht auf irreführende vermeintliche „Reasoning Chains“ vertrauen, sondern etwa auf das Trainieren robusterer Modelle oder auf eine bessere Qualitätssicherung der Outputs. Außerdem rückt damit die Bedeutung der korrekten Nutzung und Interpretation von KI-Ausgaben in den Vordergrund. Der Fokus sollte auf der Funktionalität basieren und nicht auf einer irreführenden Analogie zum menschlichen Denken.Ein weiterer interessanter Aspekt ist, dass einige aktuelle Forschungsvorhaben versuchen, die Leistungsfähigkeit von Reasoning-Modellen durch gezielte Architektur-Neuheiten und Trainingsstrategien zu verbessern. Dabei wird beispielsweise versucht, strukturierte Zwischenschritte explizit zu trainieren, allerdings immer mit dem Bewusstsein, dass diese Zwischenschritte keine echten Gedanken, sondern lediglich modellinterne Rechenschritte darstellen.

Durch solche Verbesserungen kann man die Qualität der Lösungen und die Interpretierbarkeit der Outputs steigern, ohne auf problematische Anthropomorphisierung zurückzugreifen.Für Anwenderinnen und Anwender von solchen KI-Reasoning-Tools ist es entscheidend, diese theoretische Einordnung zu kennen. Nur mit einem realistischen Verständnis der Funktionsweise lassen sich KI-Lösungen sinnvoll und sicher einsetzen. Es bedarf einer kritischen Betrachtung der Outputs, und es sollten entsprechende Validierungsmechanismen etabliert sein, um Fehler oder Fehlinformationen zu vermeiden.Insgesamt kann man festhalten, dass Reasoning-Modelle nicht wirklich „denken“, sondern auf Basis statistischer Wahrscheinlichkeiten Muster generieren, die oftmals menschenähnlich erscheinen.

Diese Differenz zu verstehen, ist zentral für den verantwortungsvollen Umgang mit KI-Technologien und deren Weiterentwicklung. Ein produktiver Umgang mit KI erfordert die Bereitschaft, diese Systeme als Werkzeuge mit besonderen Stärken, aber auch eindeutigen Grenzen zu begreifen – und nicht als menschlich denkende Entitäten. Nur so lassen sich ihre Potenziale effektiv nutzen und gleichzeitig Risiken minimieren.