In der Welt der Softwareentwicklung ist es entscheidend, nicht nur funktionierenden, sondern auch effizienten und gut lesbaren Code zu schreiben. Eine der besten Methoden, um diese Ziele zu erreichen, sind einfache, aber wirkungsvolle Regeln, die weit über einzelne Programmiersprachen hinaus Gültigkeit besitzen. Eine solche Faustregel lautet: „Push Ifs Up and Fors Down“ – auf Deutsch etwa „If-Bedingungen nach oben schieben und For-Schleifen nach unten ziehen“. Was genau sich dahinter verbirgt und warum dieser Ansatz vielen Entwicklern dabei hilft, saubereren, wartungsfreundlicheren und häufig deutlich performanteren Code zu schreiben, darauf soll diese ausführliche Betrachtung eingehen. Der erste Teil dieses Konzeptes, „Ifs nach oben schieben“, beschäftigt sich mit der Umstrukturierung von Kontrollflüssen in Funktionen.

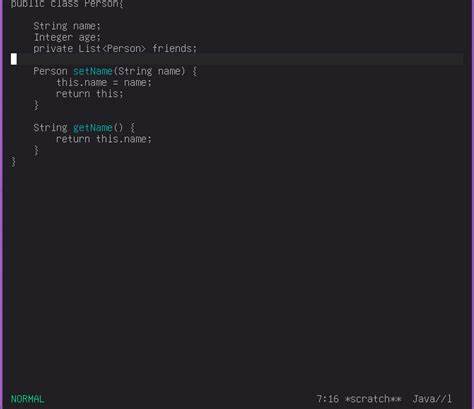

Programmierst du eine Funktion, die eine If-Bedingung enthält, lohnt es sich zu überlegen, ob diese nicht eventuell in den aufrufenden Code verlagert werden kann. Das bedeutet, anstatt innerhalb einer Funktion zu prüfen, ob eine gewisse Bedingung erfüllt ist, erledigt das die aufrufende Stelle – und die Funktion selbst erhält sauberen, „geradlinigen“ Code ohne verschachtelte Bedingungen. Die Vorteile dieser Umgestaltung sind vielschichtig. Zum einen gewinnt man Übersicht und kann komplexe Entscheidungslogiken zentral an einer einzigen Stelle platzieren. So verschwinden verstreute If-Bedingungen, die den Programmfluss unübersichtlich machen.

Zum anderen lässt sich durch diese Vereinfachung die Anfälligkeit für Fehler deutlich reduzieren, denn komplexe Kontrollstrukturen sind oft Nährboden für Bugs. Ein praktisches Beispiel verdeutlicht diesen Sachverhalt. Angenommen, eine Funktion soll eine Operation nur ausführen, wenn ein Wert tatsächlich vorhanden ist. Statt innerhalb der Funktion mit einer If-Bedingung oder einem Match-Statement zu prüfen, ob der Wert existiert, kann die Vorbedingung bereits vor dem Funktionsaufruf sichergestellt werden. Somit erfolgt der Aufruf nur noch unter der Annahme, dass der Wert gültig ist.

Das bedeutet nicht nur, dass der eigentliche Funktionscode schlanker und klarer wird, sondern auch, dass Tests und Debugging einfacher von der Hand gehen. Zudem werden unnötige Prüfungen mehrfacher Art vermieden, was vor allem in performanzkritischen Anwendungen ein großer Vorteil sein kann. Eine weitere Motivation für das Hochschieben der Ifs ist die Möglichkeit, redundante oder tote Zweige besser zu erkennen. Werden alle Verzweigungen in einer Funktion zentral zusammengefasst, fällt es leichter, Optimierungspotenzial zu entdecken – zum Beispiel Bedingungen, die sich logisch gegenseitig ausschließen oder mehrmals geprüft werden. So wird der Code nicht nur sicherer und verständlicher, sondern auch effizienter, da unnötige Checks und Ausführungen entfallen.

Ein vergleichbarer Effekt ergibt sich bei der sogenannten „dissolving enum“-Refakturierung. Hierbei wird überflüssiger Code, der dieselbe Bedingung mehrfach im System abbildet – etwa als If-Bedingung in einer Funktion, als Rückgabewert in Form eines Enums und dann nochmals als Match-Statement – zusammengeführt. Dies führt zu schlankeren und besser wartbaren Programmen. Der zweite wesentliche Teil der Regel, „For-Schleifen nach unten schieben“, knüpft an Prinzipien der datenzentrierten Programmierung an. Grundgedanke ist, dass Programme in ihrem Kern oft große Mengen von Elementen verarbeiten.

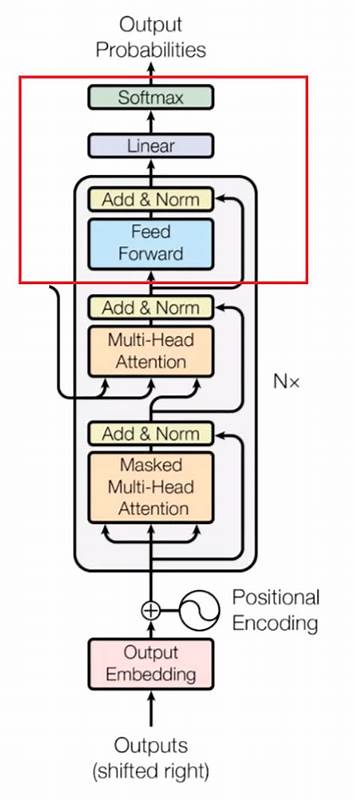

Dabei ist es effizienter, Operationen auf ganze „Batches“ von Datenobjekten anzuwenden als auf einzelne Einzelexemplare. Indem man Schleifen nach unten verschiebt und die Arbeit an mehreren Objekten gleichzeitig erledigt, lassen sich erhebliche Performancegewinne erzielen. Der Vorteil liegt vor allem in der Amortisierung von Start- und Overheadkosten sowie in der besseren Nutzung moderner Hardwarearchitekturen wie Vector Processing Units (VPUs). Wenn eine Funktion eine ganze Datenmenge als Eingabe annimmt und sie gesamtheitlich verarbeitet, können Optimierungen wie Datenparallelität, Cachecoherency oder SIMD-Instruktionen (Single Instruction, Multiple Data) genutzt werden. Das ist mit einzelnen, nacheinander ausgeführte Schleifen kaum möglich.

Ein extrem anschauliches Beispiel dafür liefert die schnelle Fourier-Transformation (FFT), die vielfach auf Basis von Batchverarbeitung arbeitet und so mathematische Operationen um ein Vielfaches beschleunigt. Neben der Performance hat das Verschieben der For-Schleifen nach unten auch eine enorme Auswirkung auf die Codequalität. Wenn alle Elemente auf einmal behandelt werden, lässt sich die Logik häufig klarer und auf höherer Abstraktionsebene ausdrücken. Dies erhöht die Lesbarkeit und erleichtert spätere Anpassungen und Erweiterungen. Anstelle vieler kleiner, verstreuter Schleifen, die immer wieder dieselbe Operation aufrufen, steht eine einzige, fokussierte Funktion, die mit einer gesamten Datenkollektion auf einmal arbeitet.

Die Schnittstelle wird dadurch konsistenter und damit wartbarer. Interessanterweise lässt sich die Regel „Push Ifs Up and Fors Down“ kombinieren, um sowohl Lesbarkeit als auch Performance zu maximieren. Wenn zum Beispiel eine If-Bedingung den gesamten Umfang einer Datenkollektion steuert, ist es effizienter, diese Bedingung außerhalb der For-Schleife zu prüfen und verschiedene Batch-Operationen zu verwenden, anstatt in jeder Iteration einer Schleife neu zu entscheiden, welcher Code ausgeführt wird. Dadurch verringert man wiederholte Abfragen und schafft Raum für weitere Optimierungen, insbesondere auf der Ebene von Hardwareressourcen und Compiler-Optimierungen. Neben technischen Vorteilen beeinflusst dieser Stil auch die Architektur moderner Systeme.

So ist es etwa bei verteilten oder hochperformanten Datenbanklösungen üblich, durch geschickte Batchverarbeitung und zentralisierte Kontrolllogik sowohl die Zahl der Operationen als auch den Aufwand zur Entscheidung über ihre Ausführung zu minimieren. Ein Beispiel ist die Architektur der Datenbank TigerBeetle, die genau diesem Prinzip folgt. Dort operiert der Datenpfad auf „Balances“ in Batches, um Einstiegskosten in die Steuerungsebene zu amortisieren, und die Steuerung selbst findet gebündelt außerhalb der heißen Schleife statt. Dieses Architekturmuster steht für eine direkte Umsetzung der Regel „Push Ifs Up and Fors Down“ im großen Maßstab. Auch aus softwareingenieurtechnischer Sicht ist es strategisch sinnvoll, wenn Kontrollstrukturen gebündelt an einer zentralen Stelle zusammenlaufen.

Damit lassen sich verschiedene Aspekte der Qualitätssicherung verbessern, darunter Testbarkeit, Fehlersuche und Wartbarkeit. Funktionen ohne interne if-Abfragen sind meist einfacher nachvollziehbar und können besser automatisiert getestet werden. Ebenso wird die Wartung durch klare Abgrenzung von Kontrollfluss und Fachlogik vereinfacht, weil Änderungen an den Entscheidungsregeln nur eine zentrale Funktion betreffen und sich nicht durch viele verstreute Stellen im Code ziehen. Diese Denkweise verlangt jedoch Disziplin und ein Bewusstsein für Software-Designprinzipien von den Entwicklern. Es ist nicht immer intuitiv, If-Bedingungen aus Einzeloperationen herauszuziehen, zumal sich dadurch anfangs der Kontrollfluss komplexer oder gebündelter anfühlen kann.

Doch langfristig zahlt sich diese Methode aus – vor allem dann, wenn Projekte wachsen, mehrere Entwickler involviert sind oder strenge Qualitäts- und Performanceziele verfolgt werden. Sie bietet eine klare Antwort auf häufig auftretende Probleme mit komplexen Kontrollstrukturen und ineffizienten Datenverarbeitungen. Zusammenfassend lässt sich festhalten: Das Prinzip, If-Bedingungen möglichst früh und zentral in den Aufrufkontext zu heben, hilft dabei, die Komplexität der Steuerungslogik zu reduzieren und sie an einer Stelle zu konzentrieren. Gleichzeitig trägt das Herunterziehen von For-Schleifen dazu bei, Daten operationen effizient zu bündeln. Die Kombination aus beidem schafft Code, der sowohl elegant als auch leistungsfähig ist.

Wer diese Technik beherrscht, wertet seine Software nachhaltig auf, macht sie robuster und oft auch performanter. Gerade in Zeiten von wachsender Datenmenge, immer komplexeren Anwendungen und dem Streben nach Höchstleistung ist dieses Prinzip eine Effektivitätsgarantie in der Softwareentwicklung.