Große Sprachmodelle, auch bekannt als Large Language Models (LLMs), revolutionieren die Art und Weise, wie wir mit Technologie und Daten kommunizieren. Sie sind die treibende Kraft hinter vielen modernen Anwendungen wie Chatbots, automatisierten Übersetzungen und KI-gestützten Textgenerierungen. Doch so mächtig diese Modelle auch sind, so sind sie nicht ohne Herausforderungen und Sicherheitsrisiken. Eines der subtilsten und dennoch potenziell gefährlichsten Probleme ist der sogenannte Token-Splitting-Angriff. Um die Bedeutung und die Auswirkungen dieses Problems zu verstehen, ist es zunächst wichtig, den Prozess der Tokenisierung nachzuvollziehen und zu erkennen, wie Angreifer diesen Mechanismus missbrauchen können.

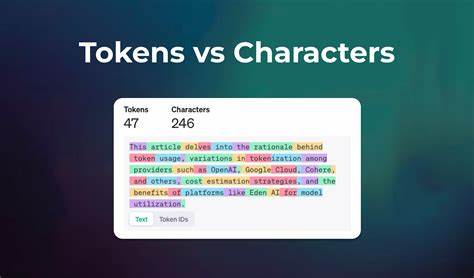

Der Begriff Tokenisierung beschreibt den Vorgang, bei dem ein Sprachmodell eingehenden Text in kleinere Einheiten aufteilt, die sogenannten Tokens. Diese Tokens können ganze Wörter, Wortbestandteile oder sogar einzelne Zeichen darstellen, abhängig davon, wie der Tokenizer, also das Trennwerkzeug des Modells, konfiguriert ist. Beispielsweise kann das Wort "unvorhersehbar" in die Tokens "un", "vorher" und "sehbar" segmentiert werden. Für Menschen mag dies wie eine einfache Zerlegung wirken, doch für die Maschine sind diese Tokens die fundamentale Verarbeitungseinheit, auf deren Basis sie Bedeutung konstruiert und Handlungen ableitet. Ein Token-Splitting-Angriff nutzt genau diese Zerlegung aus.

Angreifer erstellen Eingaben, die auf den ersten Blick harmlos oder normal erscheinen, aber durch die Art und Weise, wie der Tokenizer arbeitet, in eine Abfolge von Tokens umgewandelt werden, die eine bösartige oder unerwünschte Anweisung enthalten. Diese Technik nutzt häufig unsichtbare Zeichen wie Zero-Width Spaces oder spezielle Unicode-Variationen, die für den Menschen unsichtbar bleiben, von Filtermechanismen jedoch nicht erkannt werden, und die Tokenisierung dadurch künstlich verändern. Ein typisches Beispiel für solch eine Manipulation ist ein Sicherheitsfilter, der auf die Phrase "Datenbank löschen" achtet, um gefährliche Befehle zu erkennen und zu blockieren. Ein Angreifer kann anstelle dieser klaren Phrase eine Variante einschleusen, die ein unsichtbares Zeichen enthält, wie zum Beispiel "löschtdatenbank" – wobei "" ein Zero-Width Space ist. Für ungeschulte Filter erscheint dieser Text als harmlos und unverändert, jedoch könnte der Tokenizer den Ausdruck so aufteilen, dass daraus hinter den Kulissen erneut die gefährliche Phrase "löscht datenbank" entsteht.

Dadurch wird das Sicherheitsprinzip unterlaufen, der schädliche Befehl wird von der KI akzeptiert und ausgeführt. Die Auswirkungen solcher Attacken sind nicht zu unterschätzen. In komplexen Systemen mit KI-Agenten, die beispielsweise Datenbanken verwalten, E-Mails zusammenfassen oder andere automatisierte Abläufe steuern, können durch unerkannte schädliche Befehle ernsthafte Schäden entstehen. Datenverluste, Informationsabflüsse oder gar die Übernahme von Kontrolle durch unautorisierte Personen sind denkbare Szenarien. Außerdem können Token-Splitting-Angriffe die Verlässlichkeit der KI untergraben, indem sie unvorhergesehene und manipulierte Kontexte schaffen, die die Modellentscheidungen beeinflussen.

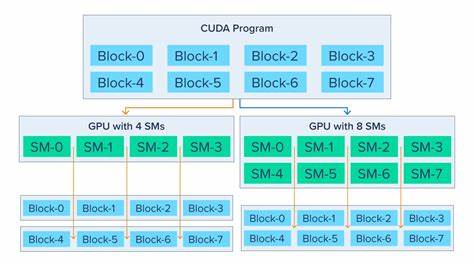

Das Verständnis der genauen Funktionsweise des Tokenizers eines Systems ist ein entscheidender Schritt zur Erkennung und Abwehr dieser Angriffe. Da verschiedene Tokenizer unterschiedliche Algorithmen und Vokabulare verwenden, variieren auch die Angriffsmöglichkeiten und Verwundbarkeiten. Hierbei spielen unter anderem Versionen und Updates der Tokenizer eine Rolle, da sich mit neuen Algorithmen auch neue Lücken öffnen oder schließen können. Deshalb ist es für Entwickler wichtig, sich über die spezifischen Eigenheiten der eingesetzten Tokenisierer zu informieren und potentielle Schwachstellen kontinuierlich zu überprüfen. Gegenmaßnahmen gegen Token-Splitting-Angriffe müssen vielfältig und mehrschichtig sein.

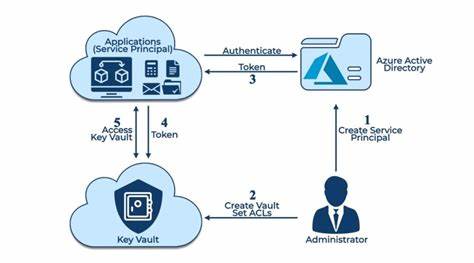

Ein effektiver Schutz beginnt bereits bei der Eingabeverarbeitung, indem unerwünschte oder nicht standardmäßige Zeichen konsequent entfernt oder normalisiert werden. Dies schließt das Entfernen von Steuerzeichen, unsichtbaren Unicode-Variationen und anderen potenziell missbrauchbaren Eigenschaften ein. Parallel dazu sollten Sicherheitssysteme und Filter nicht nur am Rohtext ansetzen, sondern auch die nachgelagerte Token-Sequenz analysieren, um subtile Manipulationen zu identifizieren. Zudem ist es von Bedeutung, Sicherheitskonzepte nach dem Prinzip der minimalen Rechtevergabe umzusetzen. KI-Systeme und Agenten sollten nur mit den absolut notwendigen Befugnissen ausgestattet sein, um im Falle eines erfolgreichen Angriffs den Schaden möglichst gering zu halten.

Auch die Trennung zwischen vertrauenswürdigen und untrusted Eingaben und Instruktionen sollte strikt eingehalten werden. Dies reduziert die Angriffsfläche, indem verhindert wird, dass Eingaben als Befehle missverstanden werden können. Darüber hinaus empfiehlt sich die fortlaufende Überwachung der Ausgaben und Aktionen von KI-Systemen. Anomalien, überraschende oder ungewöhnliche Verhaltensweisen können Indizien für gelungene Manipulationsversuche sein und sollten frühzeitig erkannt werden. Nur so können potenzielle Angriffe detektiert und rechtzeitig Gegenmaßnahmen eingeleitet werden.

Zusammenfassend lässt sich sagen, dass Token-Splitting-Angriffe eine hochentwickelte und verborgene Methode darstellen, die Sicherheit von großen Sprachmodellen zu kompromittieren. Die so entstehenden Gefahrenszenarien reichen von der Umgehung von Filtern bis hin zum Missbrauch von KI-Agenten für schädliche Zwecke. Ein tiefgehendes Verständnis der Tokenisierungsprozesse sowie eine umfassende und vielschichtige Sicherheitsstrategie sind unerlässlich, um diese Bedrohung effektiv zu begegnen. Die Kombination aus sorgfältiger Eingabeverarbeitung, intelligenten Analysemethoden nach der Tokenisierung, begrenzten Berechtigungen und kontinuierlichem Monitoring schafft eine robuste Verteidigung gegen eine der subtilsten Angriffstechniken im KI-Umfeld. Für Entwickler, Sicherheitsexperten und Verantwortliche in der KI-Entwicklung bedeutet dies, nicht nur die vielfältigen Vorteile großer Sprachmodelle zu nutzen, sondern auch ihre potenziellen Verwundbarkeiten kritisch zu evaluieren und aktiv zu adressieren.

So kann die sichere Nutzung von KI langfristig gewährleistet und eine zuverlässige, verantwortungsvolle Technologieentwicklung gefördert werden.

![Programming Without Pointers [video]](/images/CDD79BDF-8ABF-4398-B47B-5E8A66FD9131)