Die rasante Entwicklung von Sprachmodellen im Bereich der Künstlichen Intelligenz hat die Art und Weise, wie Maschinen Sprache verarbeiten und verstehen, grundlegend verändert. Neben dem schieren Umfang und der Rechenleistung von Modellen rückt zunehmend die Frage in den Mittelpunkt, wie kleinere, effizientere Modelle dennoch komplexe Aufgaben meistern können. Ein besonders interessanter Ansatz konzentriert sich dabei auf die Rolle von Stil und Struktur, also die sogenannten stilistischen Muster, die von großen Modellen erlernt und an kompaktere Varianten weitergegeben werden. Diese Erkenntnisse stammen aus jüngsten Forschungen, die sich mit dem Phänomen der „stilistischen Replikation“ in verdichteten Sprachmodellen beschäftigen. Dabei offenbart sich ein überraschendes Bild: Die Leistung dieser Modelle hängt oftmals mehr von der Nachahmung bestimmter Denkstile als vom tatsächlichen tiefgehenden Wissen ab.

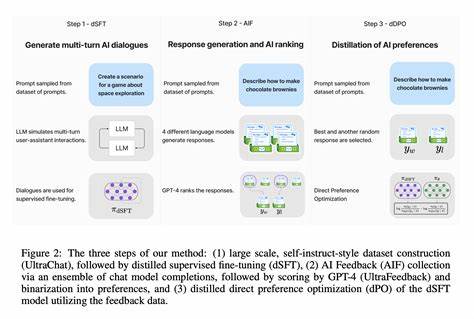

Traditionell galt der Fortschritt in der KI-Entwicklung vor allem darin, größere Modelle mit immer mehr Parametern zu bauen, die über umfangreiche Datenmengen trainiert werden. Dabei ist es üblich, dass solche Modelle durch mehrstufige Denkprozesse versuchen, komplexe Probleme Schritt für Schritt zu lösen. Diese sogenannten reasoning traces sind detaillierte Erklärungen oder Nachweise, die den Lösungsweg transparent machen. Für kleinere Modelle wird dieses Wissen oft durch Distillation gewonnen, ein Prozess, bei dem ein großes Modell sein Wissen in einer komprimierten, leichter handhabbaren Form weitergibt. Interessanterweise zeigen aktuelle Studien, dass diese kompakten Modelle vor allem die stilistischen Merkmale der Denkspuren übernehmen, also den Schreibstil, die Struktur und die spezifische Art der Formulierungen, anstatt das zugrundeliegende rationale Verständnis vollständig zu erfassen.

Diese Beobachtung wirft ein neues Licht auf das Training von Sprachmodellen. Es stellt sich heraus, dass zum Beispiel die Anordnung von Argumenten, spezifische Satzstrukturen oder wiederkehrende Phrasen eine größere Rolle spielen, als bisher angenommen. Modelle, die auf synthetisch erstellten reasoning traces trainiert wurden, die genau diese stilistischen Muster nachahmen – auch wenn sie inhaltlich falsch waren – erreichten dennoch beeindruckende Leistungen. Dies legt nahe, dass die kognitive Tiefe, die wir Menschen bei der Problemlösung einsetzen, zumindest in diesen Sprachmodellen nicht notwendigerweise die zentrale Stellschraube für ihre Funktion ist. Vielmehr sind es die oberflächlichen, stilistischen Merkmale, die den Modellen als Hinweise dienen, wie sie reagieren sollen.

Die Implikationen dieser Erkenntnis sind sowohl faszinierend als auch herausfordernd. Einerseits eröffnen sie neue Perspektiven zur Effizienzsteigerung von KI-Systemen. Wenn eine präzise stilistische Nachahmung ausreicht, um die Performance kleiner Modelle maßgeblich zu verbessern, können Entwickler bei der Ressourcenzuweisung strategisch vorgehen und den Fokus verstärkt auf das Erlernen und Replizieren bestimmter Muster legen. Dies spart Rechenzeit und Speicherplatz und macht den Einsatz von KI in ressourcenbegrenzten Umgebungen realistischer. Besonders im Bereich mobiler Anwendungen oder Embedded Systems könnte dies einen bedeutenden Fortschritt darstellen.

Auf der anderen Seite stellt sich jedoch die Frage nach der Zuverlässigkeit und dem tieferen Verständnis dieser Modelle. Wenn die Antwortqualität maßgeblich vom Stil abhängt und weniger von tatsächlichem Wissen oder logischem Verstehen, dann könnte dies in kritischen Anwendungen, wie der Medizin oder der Rechtsprechung, problematisch sein. Falsche Antworten, die aber im richtigen Stil verpackt sind, können von Nutzern als glaubwürdiger wahrgenommen werden. Dies erfordert eine sorgfältige Evaluation und möglicherweise neue, stilunabhängige Bewertungsmethoden. Die Forscher hinter diesen Studien haben eigens zwei neue Datensätze eingeführt: einen Datensatz aus emergenten reasoning traces und einen synthetischen Datensatz, der gezielt zur Nachahmung der identifizierten stilistischen Merkmale erstellt wurde.

Durch den Vergleich der Modellleistungen auf diesen beiden Datensätzen konnte deutlich gemacht werden, wie stark die Übernahme von Stilmustern Einfluss nimmt. Besonders bemerkenswert ist, dass selbst dann, wenn die synthetischen Spuren zu falschen Schlussfolgerungen führten, die Modelle trainiert auf diese Daten oft bessere Antworten liefern konnten als Modelle, die keinen Zugang zu diesen stilistischen Hinweisen hatten. Das Phänomen der Stil über Substanz spiegelt sich auch in anderen Bereichen menschlicher Kommunikation wider. In der Literatur oder politischen Rede wird oft der Stil genutzt, um Überzeugungskraft zu erzeugen, unabhängig vom tatsächlichen Inhalt. Sprachmodelle imitieren in gewissem Sinne diesen Mechanismus, was ihre Wirkung im alltäglichen Gebrauch verständlicher macht.

Gleichzeitig unterstreicht es, dass die Interaktion mit KI-Modellen ein Bewusstsein für diese „Oberflächen-Ebene“ erfordert. Langfristig könnte dieser Forschungszweig neue Wege zur Modellkompression und -optimierung eröffnen. Statt tiefes Verständnis in großen Modellen aufwendig zu reproduzieren, können kleinere Modelle durch die gezielte Replikation stilistischer Elemente effektiv trainiert werden. Dabei bleibt die Frage offen, inwiefern diese Modelle wirklich „denken“ oder einfach nur gut imitieren. Für die KI-Forschung ist dies eine wichtige Distinktion, die zukünftige Entwicklungen kritisch begleiten muss.

Darüber hinaus bietet die Untersuchung stilistischer Nachahmung Chancen, die Transparenz und Interpretierbarkeit von KI-Systemen zu verbessern. Wenn bestimmte Muster als Kernbestandteile des Denkprozesses verstanden werden, kann man diese gezielt analysieren, kontrollieren und vielleicht sogar manipulieren. Dies fördert eine verantwortungsvollere Nutzung von KI-Technologien und die Entwicklung von Mechanismen, die sicherstellen, dass KI-Antworten nicht nur oberflächlich überzeugend, sondern inhaltlich korrekt sind. Zusammenfassend lässt sich sagen, dass die Entdeckung der Bedeutung stilistischer Replikation in verdichteten Sprachmodellen ein bedeutender Meilenstein in der KI-Forschung darstellt. Dieser Befund verändert traditionelle Vorstellungen vom maschinellen Denken und hebt den Stellenwert von Form, Struktur und oberflächlicher Gestaltung hervor.

Für Anwender, Entwickler und Forscher gleichermaßen ergeben sich daraus neue Herausforderungen und Chancen, wie KI in Zukunft effizienter, zuverlässiger und transparenter gestaltet werden kann. Die Integration dieser Erkenntnisse wird maßgeblich dazu beitragen, dass Sprachmodelle nicht nur leistungsstärker, sondern auch besser verständlich und nutzbar werden – ein entscheidender Schritt auf dem Weg zu intelligenten Systemen, die echten Mehrwert bieten.