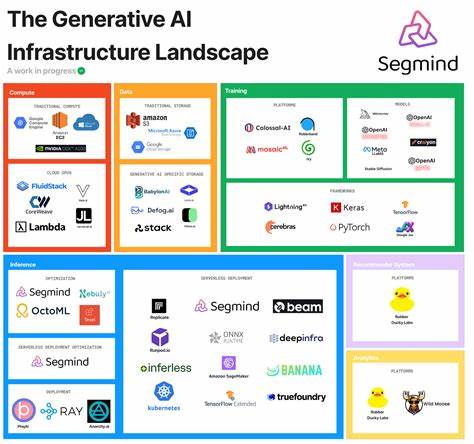

Die Infrastruktur moderner Künstlicher Intelligenz (KI) hat sich in den letzten Jahren rasant entwickelt und bildet das Rückgrat für bahnbrechende Anwendungen in verschiedensten Bereichen. Die Leistungslandschaft der KI-Hardware ist entscheidend für die Effizienz und die Skalierbarkeit von KI-Systemen. Deshalb ist es wichtig, die typischen Leistungskennzahlen wie Größe, Bandbreite und Latenz der unterschiedlichen Komponenten zu verstehen. Diese Parameter bestimmen maßgeblich, wie schnell und effektiv KI-Modelle trainiert und ausgeführt werden können. Die Komplexität und Vielfalt der Hardware-Komponenten in der modernen KI-Infrastruktur erfordern eine differenzierte Betrachtung der einzelnen Elemente und deren Zusammenspiel.

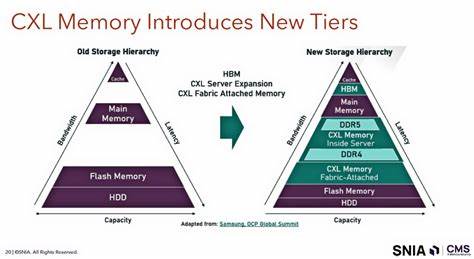

Dabei stehen CPU- und GPU-Caches sowie Hauptspeicher, moderne Schnittstellen und Speichersysteme im Fokus. Die Größe eines Speicher- oder Datenübertragungselements ist ein wichtiger Maßstab dafür, wie viel Information es aufnehmen oder verarbeiten kann. Während zum Beispiel der CPU L1 Cache pro Kern mit 64 Kilobyte eher klein dimensioniert ist, steigt die Speichergröße bei höheren Cache-Leveln auf mehrere Megabyte oder sogar Gigabyte an, wie beim CPU DDR5 Hauptspeicher mit 128 Gigabyte. Interessanterweise besitzen manche Komponenten, insbesondere Schnittstellen wie PCIe oder Netzwerkverbindungen, gar keine eigene Speichergröße, da ihr primärer Aufgabenbereich das Übertragen von Daten ist. Die unterschiedlichen Größen sind ein Ausdruck der hierarchischen Speicherstruktur und spiegeln gleichzeitig die Zielsetzung wider, zwischen Latenzzeit und Durchsatz abzuwägen.

Neben der Größe ist die Bandbreite eine der wichtigsten Messgrößen für die Leistungsfähigkeit von KI-Hardware. Sie gibt Auskunft darüber, wie viel Daten pro Sekunde übertragen werden können und ist ein wesentlicher Indikator für die Effizienz eines Systems. In modernen KIs sind extrem hohe Bandbreiten erforderlich, um Deep-Learning-Modelle mit ihren umfangreichen Datenvolumen und Berechnungen zu verarbeiten. Die GPU L1 bzw. Shared Memory Ebene stellt mit Bandbreiten von bis zu 12 Terabyte pro Sekunde beeindruckende Übertragungsraten bereit und zeigt, wie speziell GPU-Architekturen auf hohe parallele Verarbeitung ausgelegt sind.

Aber auch CPU-L1- und L2-Caches erreichen Bandbreiten im Bereich von mehreren Terabyte pro Sekunde. Schnittstellen wie PCIe entwickeln sich kontinuierlich weiter – PCIe 6.0 x16 bietet beispielsweise bereits Bandbreiten von bis zu 128 Gigabyte pro Sekunde, was den DT-Anforderungen moderner KI-Anwendungen entgegenkommt. Ein weiterer kritischer Faktor ist die Latenz, also die Zeitverzögerung bis zur Verfügbarkeit der angeforderten Daten. In einer KI-Anwendung kann selbst eine geringe Latenz große Auswirkungen auf die Gesamtperformance haben.

Caches direkt auf dem Prozessor, wie der L1 Cache, besitzen mit etwa 1 Nanosekunde die niedrigste Latenz, was schnelle Zugriffszeiten auf häufig verwendete Daten ermöglicht. Dagegen liegen die Latenzzeiten von Speicherkomponenten wie DDR5 RAM oder HBM3 GPU-Speicher im Bereich von mehreren zehn Nanosekunden, gefolgt von externen Schnittstellen wie PCIe mit mehreren hundert Nanosekunden. Hochmoderne Netzwerkschnittstellen wie InfiniBand oder RoCE v2 verfügen über Latenzen im Mikrosekundenbereich, was für verteilte KI-Workloads besonders wichtig ist, bei denen eine schnelle Kommunikation zwischen Recheneinheiten notwendig ist. Die Entscheidung, welche Komponenten in einer KI-Infrastruktur verwendet werden, hängt stark von den Anforderungen des jeweiligen Einsatzszenarios ab. Training von großen neuronalen Netzen erfordert eine enorm hohe Speicherbandbreite und ausreichende Kapazitäten, damit die Modelle schnell trainiert und die Berechnungen parallelisiert werden können.

Inference-Anwendungen benötigen oft schnellen Datenzugriff mit minimaler Latenz, um Echtzeit-Antworten zu gewährleisten. Die Herausforderung besteht darin, eine ausgewogene Balance zwischen Speichergröße, Bandbreite und Latenz zu finden, um systemweite Engpässe zu vermeiden und die gesamte Leistung zu optimieren. Moderne KI-Hardware profitiert zudem von spezialisierten Zwischenschichten in der Speicherhierarchie. Die CPU-Cache-Levels (L1, L2, L3) sind klassischerweise so konzipiert, dass sie den Prozessor nahezu unmittelbar mit Daten versorgen, während der Hauptspeicher und High-Bandwidth-Speicher wie HBM3 die größte Datenmenge lagerfähig machen. Besonders auf GPU-Seite ist die Kombination aus Shared Memory und L2 Cache entscheidend, da sie eine schnelle, hybride Speicherlösung bietet, die parallelisiert arbeitet und so die Rechenleistung weiter steigert.

Schnittstellen wie PCIe oder NVLink erweitern die Kommunikation zwischen Prozessoren beziehungsweise GPUs und zwischen unterschiedlichen Hardwarekomponenten. NVLink 5.0 ist beispielsweise auf hohe Bandbreite von bis zu 1,8 Terabyte pro Sekunde optimiert und bietet zugleich vergleichsweise niedrige Latenzen. Dies ist insbesondere in Multi-GPU-Setups und verteilten Systemen essenziell, in denen große Datenmengen schnell ausgetauscht werden müssen. PCIe entwickelt sich mit Version 6.

0 zügig weiter und kann mit voller Datenbreite Datenraten verdoppeln, was gerade bei datenintensiven KI-Prozessen Vorteile bringt. Speichermedien und externe Speicherlösungen besitzen in der KI-Infrastruktur eine andere Rolle, da sie vor allem für große Datenmengen über längere Zeiträume zuständig sind. NVMe-SSDs der fünften Generation bieten zwar eine enorme Kapazität von mehreren Terabyte, sind jedoch mit Latenzen im Bereich von mehreren Mikroskunden deutlich langsamer als Cache- oder Arbeitsspeicher. NVMe-oF (over Fabrics) ergänzt dies durch Netzwerkprotokolle, die mittels RDMA-Technologie (Remote Direct Memory Access) eine schnellere und effizientere Datenübertragung ermöglichen, was vor allem bei verteilten Speicherarchitekturen relevant ist. Neben den technischen Eigenschaften ist auch die physikalische Kombination der Bausteine in einer KI-Infrastruktur von Bedeutung.

Die Architektur muss so gestaltet sein, dass die Datenflüsse optimal erfolgen und Engpässe minimiert werden. Eine enge Verzahnung von schnellen Caches, großem Hauptspeicher und schnellen Netzwerkschnittstellen schafft hier ideale Bedingungen. Dabei spielen auch Software-Stacks und Treiber eine Schlüsselrolle, um die Hardware-Potentiale voll auszuschöpfen. Die Zukunft der KI-Infrastruktur wird durch kontinuierliche Innovationen bei Komponenten, Schnittstellen und Speichertechnologien geprägt sein. Entwicklungen wie die Einführung noch schnellerer PCIe-Standards, neue Generationen von HBM-Speicher mit höherer Kapazität oder noch niedrigere Latenzen bei Netzwerkverbindungen werden den Leistungsdruck weiter erhöhen.

Zudem wird die Integration spezialisierter KI-Beschleuniger und Domain-spezifischer Hardware die Landschaft weiter diversifizieren. Die Herausforderung wird darin bestehen, die Komplexität der Systeme bei steigender Leistungsfähigkeit handhabbar zu halten und gleichzeitig Kosten, Energieverbrauch und Skalierbarkeit zu optimieren. Zusammenfassend lässt sich sagen, dass die Leistungslandschaft der modernen KI-Infrastruktur durch drei zentrale Parameter bestimmt wird: Größe, Bandbreite und Latenz. Diese sind eng miteinander verzahnt und beeinflussen sich gegenseitig. Die Kenntnis dieser Leistungsmerkmale hilft dabei, die Architektur von KI-Systemen optimal zu planen und somit die Effizienz, Geschwindigkeit und Skalierbarkeit moderner KI-Anwendungen zu steigern.

Wer die Details der Performance von CPU- und GPU-Caches, Hauptspeicher, High-Speed-Schnittstellen und Speichermedien versteht, kann die komplexen Anforderungen der künstlichen Intelligenz besser meistern und innovative Lösungen in der Praxis umsetzen.