In der Welt der Künstlichen Intelligenz und insbesondere im Umgang mit Sprachmodellen wie ChatGPT oder ähnlichen Plattformen kursiert zunehmend ein Trend: Die Suche nach den perfekten, sogenannten „magischen“ Prompts. Diese Prompts, also die Eingabetexte oder Fragen, mit denen man die KI füttert, sollen angeblich dazu führen, dass die KI zu jeder erdenklichen Aufgabe die bestmögliche Antwort liefert – vom Wachstumsexperten über den ultimativen Programmierassistenten bis hin zum Marketingguru. Doch was steckt wirklich hinter dieser Versprechung, und warum könnte dieser Fokus auf die perfekten Prompts eher hinderlich als hilfreich sein? Der Kern dieses Problems liegt darin, dass vollkommen unterschiedliche Situationen individuelle Anforderungen an die Kommunikation mit KI stellen und ein einzelner „Zaubersatz“ schlichtweg nicht die Komplexität jeder einzelnen Anfrage erfassen kann. Ein weit verbreitetes Missverständnis besteht darin, dass das Beherrschen von sogenannten „Prompt-Engineering“ der Schlüssel zum Erfolg im Umgang mit KI-Tools ist. Obwohl es durchaus stimmt, dass kleine Änderungen an einem Prompt die Qualität der Antworten beeinflussen können, ist das nicht die entscheidende Fähigkeit, die man erlernen sollte.

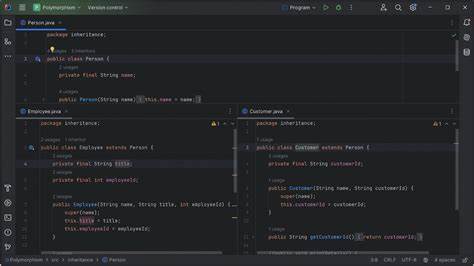

Vielmehr kommt es darauf an, ein tiefes Verständnis dafür zu entwickeln, was Sprachmodelle leisten können und wo ihre Grenzen liegen. Dieses Verständnis umfasst mehrere Ebenen: Es bedeutet zu wissen, wann es sinnvoll ist, ein bestehendes Gespräch mit der KI fortzusetzen, wann besser ein neuer Dialog gestartet wird, welche Typen von Modellen für welche Aufgaben am besten geeignet sind und wann Outputs mit Vorsicht zu genießen sind. Das Entwickeln eines gesunden Bewusstseins für die Zuverlässigkeit und die typischen Fehlerquellen der Modelle ist essenziell, um KI als Werkzeug effektiv nutzen zu können. Ein Blick in die Praxis – zum Beispiel eines Softwareentwicklers, der mit modernen Sprachmodellen arbeitet – zeigt, wie diese Prinzipien konkret umgesetzt werden. Bei der alltäglichen Programmierarbeit dient die KI häufig als intelligenter Autovervollständiger, der über reine Syntax hinaus Vorschläge für den nächsten Code-Snippet liefert.

Wenn Entwickler mit einer neuen Programmiersprache oder einem Framework arbeiten, hilft die KI dabei, die grundlegenden Idiome und Muster zu verstehen, ohne dass dafür lange Recherche notwendig ist. In Problemlösungsphasen, also wenn ein unerwarteter Fehler auftritt oder ein Bug sich hartnäckig zeigt, kann eine KI mit ihrer Fähigkeit zum logischen Schließen brauchbare Hinweise liefern – aber anstatt sich auf eine lange Diskussion einzulassen, empfiehlt es sich, den Kontext übersichtlich zu übergeben und die Antwort kurz zu prüfen. Noch bevor ein Code-Änderungsvorschlag eingereicht wird, lässt sich der Diff durch ein Modell analysieren, um Auffälligkeiten zu entdecken. Gerade in Lernphasen, wenn neue Technologien erkundet werden, bietet sich die Technik an, Hypothesen in Form von einfachen Fragen zu validieren. Ein wichtiges Detail ist, dass zwar auch einmaliger Code für Scripte oder Abfragen von der KI generiert werden kann, diese Ergebnisse aber niemals blind übernommen werden sollten – in Produktionsumgebungen ist Kontrolle und Eigenleistung gefragt.

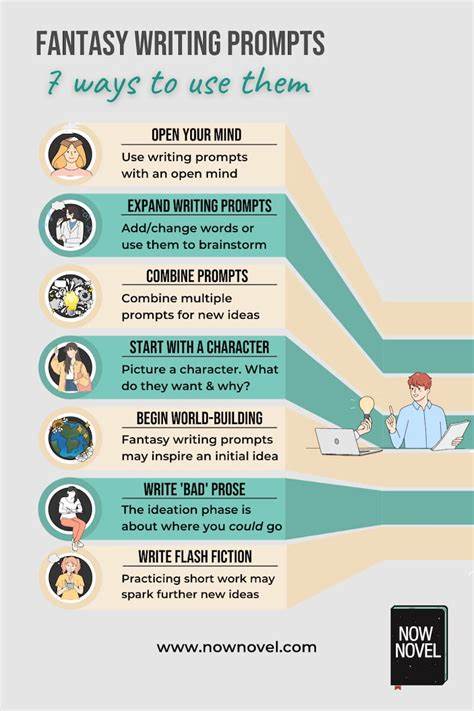

Dabei fällt auf, dass keiner dieser Anwendungsfälle auf eine Vorlage für „magische Prompts“ angewiesen ist. Die Eingaben an die KI sind meist schlicht und ad-hoc formuliert, zum Beispiel: „Kannst du mir bei diesem Bug helfen? Hier sind die Infos, die ich habe.“ Diese Einbettung von Kontext wird als weitaus wichtiger angesehen als das Ausfeilen des perfekten Satzes, der angeblich die beste Antwort erzwingen würde. Zwar ist eine optimierte Formulierung nicht falsch und kann durchaus die Qualität der Ergebnisse heben, doch ihr Impact ist im Vergleich zum richtigen Kontext meist gering. Ein Best-of-Katalog oder eine Bibliothek von Standard-Prompts machen nach dieser Sichtweise wenig Sinn, da die Realität der Aufgaben so vielfältig ist, dass eine universelle Vorlage kaum passgenau sein kann.

Natürlich hat die ganze Debatte um „magische Prompts“ auch eine positive Seite: Sie macht neugierig auf die vielfältigen Fähigkeiten heutiger Sprachmodelle und zeigt auf, wozu diese Werkzeuge grundsätzlich in der Lage sind. Diese Aufmerksamkeit kann Nutzer dazu animieren, KI für ganz neue Bereiche auszuprobieren, an die sie vorher vielleicht gar nicht gedacht hätten – sei es für das Verfassen von Marketingstrategien, das Erstellen von individuellen Skripten oder sogar für die Bewertung medizinischer Symptome. Die „magischen Prompts“ wirken hier wie ein öffentlicher Weckruf, der die Potenziale der Modelle vor Augen führt. Ein spannender Aspekt in der Arbeit mit KI ist die stetige Entdeckung bisher unbekannter Fähigkeiten. Sprachmodelle entwickeln sich nicht nur durch neue Versionen weiter, sondern offenbaren regelmäßig auch überraschende Stärken, die zunächst niemand erwartet hat.

Ein Beispiel dafür ist ein Modell, das plötzlich die Fähigkeit zeigt, Bilder besser zu geolokalisieren als menschliche Experten – eine Errungenschaft, die erst nach genauerer Untersuchung zutage trat. Diese unerwarteten Anwendungen unterstreichen, dass die Arbeit mit KI immer auch ein Experimentierprozess ist, bei dem Nutzer aktiv neue Zugänge und Einsatzfelder erschließen müssen, statt sich hinter starren Vorlagen zu verstecken. Das Fazit lautet daher: Wenn Sie mit einer KI arbeiten möchten, sollten Sie Ihre Zeit besser darin investieren, ein Gefühl für deren Stärken und Schwächen zu entwickeln, als nach einer universellen Anleitung zu suchen. Versuchen Sie, verschiedenartige Problemstellungen anzugehen, setzen Sie die Modelle gezielt mit den richtigen Hintergrundinformationen und dem nötigen Kontext ein und prüfen Sie die Antworten kritisch. Nur so können Sie dauerhaft von den Vorteilen der heutigen KI-Technologien profitieren und echte produktive Mehrwerte schaffen.

Schließlich ist es wichtig, sich davon zu verabschieden, dass AI die menschliche Kreativität und Einordnung vollständig ersetzen kann. Sprachmodelle sind beeindruckende Werkzeuge, aber der Schlüssel zum Erfolg liegt immer in der intelligenten Zusammenarbeit zwischen Mensch und Maschine. In der Praxis wird dieser Erfolg oft durch einfache, klare Kommunikation mit der KI erreicht, durch Geduld beim Schärfen des gemeinsamen „Dialogs“ und durch die Bereitschaft, Ergebnisse kritisch zu reflektieren und anzupassen. Zusammengefasst lässt sich sagen, dass das Festhalten an der Idee der magischen Prompts zukünftige Nutzer eher in die Irre führen kann. Stattdessen lohnt es sich, die eigene Aufmerksamkeit stärker auf das Verständnis der Technologie zu lenken, den Umgang mit den Modellen als flexible, kontextabhängige Werkzeugen zu begreifen und die Arbeit mit KI als dynamischen Lernprozess zu begreifen.

Nur so kann das volle Potenzial dieser faszinierenden Technologie wirklich erschlossen werden.