In den letzten Jahren haben große Sprachmodelle (Large Language Models, kurz LLMs) wie GPT-4, Claude oder spezielle chemieorientierte KI-Systeme enorme Aufmerksamkeit erhalten. Diese Modelle, trainiert auf Milliarden von Textdaten, sind in der Lage, in natürlicher Sprache zu antworten, komplexe Sachverhalte zu erklären und sogar Aufgaben zu lösen, für die sie nicht explizit programmiert wurden. Insbesondere in den Naturwissenschaften, darunter auch der Chemie, eröffnen sie neue Möglichkeiten, die traditionellen Herangehensweisen grundlegend zu verändern. Doch wie steht es um ihre tatsächlichen Kenntnisse und logisch-analytischen Fähigkeiten im Vergleich zu menschlichen Experten? Können diese KI-Systeme die Intuition, Erfahrung und deduktiven Fähigkeiten von Chemikern ersetzen oder zumindest ergänzen? Und welche Grenzen zeigen sich im Umgang mit komplexen chemischen Fragestellungen? Dieser Text beleuchtet umfassend den aktuellen Stand der Forschung anhand einer eigens entwickelten Benchmark namens ChemBench, die einen systematischen Vergleich zwischen führenden LLMs und Chemikern ermöglicht. Die Herausforderung, chemisches Wissen zu messen Chemie ist ein vielschichtiges Fachgebiet, das nicht nur Faktenwissen über Elemente, Verbindungen und Reaktionen umfasst.

Es beinhaltet auch das Verstehen von Zusammenhängen, die Fähigkeit zum logischen Schließen, intuitive Einschätzungen sowie Rechnungen und strukturbezogene Analysen. Wissenschaftliche Publikationen und Lehrbücher vermitteln einen Großteil dieses Wissens in Textform, was LLMs grundsätzlich hervorragend verarbeiten können. Allerdings waren bisher etablierte Tests und Benchmarks entweder zu eng gefasst oder orientierten sich nicht ausreichend an realistischen, komplexen Fragestellungen aus der chemischen Praxis. Genau hier setzt ChemBench an – ein umfassendes, strukturiertes und sorgfältig geprüftes Set von über 2700 Frage-Antwort-Paaren, die Themen vom Grundlagenwissen bis hin zu anspruchsvollen Interpretationstests abdecken. Die Fragen stammen aus vielfältigen Quellen, darunter Universitätsprüfungen, Lehrmaterialien und algorithmisch erstellte Probleme.

Die Fragen werden hinsichtlich der erforderlichen Fähigkeiten – Wissen, Logik, Berechnung und Intuition – sowie des Schwierigkeitsgrades klassifiziert. Anders als reine Multiple-Choice-Aufgaben enthält ChemBench auch offene Fragestellungen, um die tatsächlichen Antwortfähigkeiten der Modelle und Menschen authentischer abzubilden. Überlegenheit moderner Sprachmodelle bei vielen Aufgaben Die Anwendung von ChemBench auf aktuelle führende große Sprachmodelle hat überraschende Ergebnisse geliefert. Modelle wie o1-preview erzielten im Durchschnitt deutlich bessere Ergebnisse als die besten teilnehmenden Chemiker. Selbst weit verbreitete, offen zugängliche KI-Systeme erreichten Leistungen, die nahe an proprietäre kommerzielle Spitzenmodelle heranreichen.

Diese Leistung spricht für das beeindruckende Potenzial moderner KI bei der Analyse, dem Abruf und der Verarbeitung von chemischem Wissen. Doch die Ergebnisse sind differenziert zu betrachten. Trotz der hohen Gesamtperformance zeigen die Modelle erhebliche Schwächen bei Aufgaben, die logisches und mehrstufiges Schließen erfordern, insbesondere wenn sie mit nicht trivialen molekularen Strukturen oder komplexen NMR-Spektren konfrontiert werden. Die Fähigkeit, Symmetrien oder unterschiedliche chemische Umgebungen zu erkennen, ist begrenzt – wahrscheinlich weil Modelle Moleküle häufig nur als Textstring (z.B.

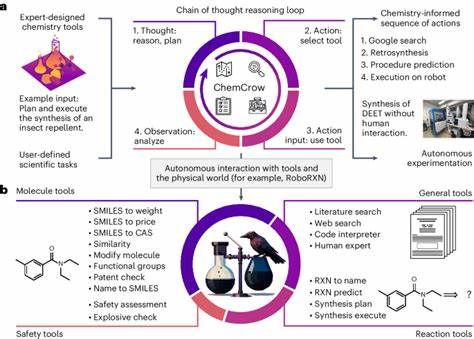

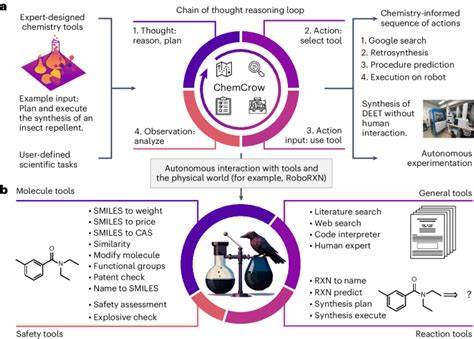

als SMILES) ohne räumliches Verständnis betrachten. Außerdem sind spezielle Sicherheitsthemen, etwa die korrekte Einordnung von Gefahrensymbolen, für KI-Modelle deutlich herausfordernder als für Menschen, insbesondere wenn letztere Zugriff auf entsprechende Datenbanken haben. Der Einsatz von Werkzeugen und Datenbanken spielt eine wichtige Rolle In einigen Fällen verfügen Modelle über sogenannte „agentische“ Fähigkeiten, welche die Nutzung externer Datenbanken, Suchmaschinen oder Analysewerkzeuge ermöglichen. Solche Tool-gestützten Systeme zeigten verbesserte Ergebnisse, konnten jedoch Wissen, das nicht in allgemein zugänglicher Literatur zu finden ist, nicht vollständig kompensieren. Bei sicherheitsrelevanten Fragen zum Beispiel konnten menschliche Probanden mit Zugriff auf spezialisierte Datenbanken wie PubChem bessere Ergebnisse erzielen, da Modelle oft nur auf den Textkorpus zurückgreifen, mit dem sie trainiert wurden oder über den externe API-Zugriff besteht.

Das impliziert, dass eine Integration von LLMs mit Fachdatenbanken und spezialisierten Informationsquellen für die nächste Entwicklungsstufe unerlässlich sein wird, um präziseres und sichereres chemisches Wissen bereitzustellen. Intuition und Präferenz: Ein besonders schwer messbares Thema Ein weiterer interessanter Aspekt ist die Fähigkeit zur chemischen Intuition. Im Alltag treffen Chemiker oft Entscheidungen, die nicht nur auf harten Fakten, sondern auf Erfahrung, subjektiven Einschätzungen und Präferenzen beruhen – etwa bei der Auswahl potenzieller Wirkstoffkandidaten. Große Sprachmodelle zeigten jedoch bei der Nachahmung dieser Präferenzen Schwächen. In Tests, bei denen sie zwischen zwei Molekülen wählen sollten, lagen die Modelle im Wesentlichen auf dem Niveau von Zufallsauswahl.

Dies zeigt, dass die Nachbildung menschlicher Intuition und des „Gefühls“ für Chemie eine Herausforderung für KI darstellt. Zukünftige Forschungen könnten versuchen, Modelle speziell auf solche Präferenzen zu trainieren oder multimodale Daten (z.B. experimentelle Resultate kombiniert mit Text) einzubeziehen, um diesem Bereich näher zu kommen. Selbsteinschätzung und Kalibrierung der Modelle Ein wichtiger Faktor für den Einsatz von KI in Wissenschaft und Praxis ist, ob Modelle ihre eigene Unsicherheit einschätzen können.

Eine mangelnde Fähigkeit dazu führt dazu, dass überzogene Sicherheit in fehlerhaften Antworten möglich ist, was gerade bei sicherheitskritischen Fragen gefährlich sein kann. Erhebungen zeigen, dass viele LLMs keine gut kalibrierten Konfidenzwerte liefern. Einige geben für falsch beantwortete Fragen sehr hohe Sicherheit an, während richtige Antworten nicht immer mit entsprechend höherer Zuverlässigkeit einhergehen. Für Anwendungen, in denen Menschen auf die KI vertrauen, ist genau diese „Vertrauenswürdigkeit“ entscheidend. Ausblick für Chemie und KI: Chancen und Herausforderungen Das enorme Potenzial der großen Sprachmodelle im Bereich Chemie ist offensichtlich.

Durch ihre Fähigkeit, riesige Textmengen zu verarbeiten, können sie Lehrkräfte, Forscher und Studierende unterstützen, indem sie rasch Wissen abrufen, plausible Hypothesen generieren und repetitive Aufgaben übernehmen. Die Überlegenheit gegenüber Menschen bei standardisierten Fragen könnte dazu führen, dass sich die Chemieausbildung und Prüfungsformate ändern müssen – weg von reiner Erinnerung hin zu stärkerem Fokus auf kritisches Denken und Interpretation. Gleichzeitig sind die Limitationen der aktuellen Systeme nicht zu unterschätzen. Die Schwierigkeit bei komplexen chemischen Fragestellungen, der eingeschränkte Umgang mit molekularen Strukturen sowie die schlechte Kalibrierung des Vertrauens sind für den praktischen Einsatz kritisch. Auch ethische Fragen, wie der Missbrauch von KI zur Synthese toxischer Substanzen, sind zu berücksichtigen.