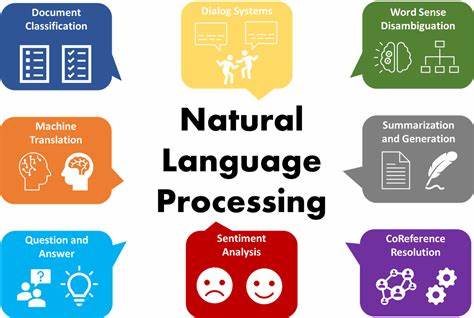

Die natürliche Sprachverarbeitung (Natural Language Processing, kurz NLP) stellt eine der faszinierendsten und zugleich anspruchsvollsten Herausforderungen im Bereich der künstlichen Intelligenz dar. Seit vielen Jahren werden Algorithmen entwickelt, die Maschinen ermöglichen, menschliche Sprache zu verstehen, zu interpretieren und mit ihr zu interagieren. Klassische Ansätze in der NLP basieren überwiegend auf statistischen Methoden und manuell entworfenen Merkmalen, deren Erstellung zeitintensiv und oft problematisch sein kann. Mit dem Aufkommen von Deep Learning hat sich dieser Paradigmenwechsel grundlegend vollzogen – nunmehr können Modelle aus großen Datenmengen selbstständig geeignete Repräsentationen und Merkmale erlernen, ohne dass Experten mühsam Hand anlegen müssen. Ein wichtiger Meilenstein in dieser Entwicklung war die im Jahr 2013 präsentierte Tutorialreihe „Deep Learning for Natural Language Processing (Without Magic)“ von Richard Socher und Christopher Manning.

Diese vermittelt grundlegende Ideen, Methoden und Anwendungen des Deep Learning in der NLP, vermeidet dabei jedoch den Eindruck, es handele sich um Zauberei oder komplexe Black-Box-Verfahren. Stattdessen legt sie Wert auf transparente, nachvollziehbare Ansätze und eine verständliche Erklärung der zugrundeliegenden Prinzipien. Im Kern geht es beim Deep Learning für NLP darum, die Repräsentation sprachlicher Einheiten – seien es Wörter, Sätze oder komplette Dokumente – so zu gestalten, dass sie für Machine-Learning-Modelle optimal nutzbar sind. Traditionelle Verfahren arbeiteten meist mit sogenannten One-Hot-Vektoren oder handkodierten Merkmalen, deren Informationsgehalt begrenzt ist und kaum semantische Beziehungen abbildet. Deep Learning-Modelle hingegen lernen kontinuierliche Vektorraummodelle, die die Bedeutungsähnlichkeit zwischen Wörtern erfassen können.

Dies ermöglicht es, sprachliche Feinheiten wie Synonyme, Wortbedeutungen und sogar syntaktische Strukturen in den Vektoren zu repräsentieren. Die Grundlagen hierzu bilden neuronale Netze, die auf Eingaben aus einfachen numerischen Vektoren trainiert werden. Ein gewichtiger Bestandteil des Tutorials ist die Einführung in Backpropagation, das algorithmische Verfahren zur Aktualisierung der Gewichte innerhalb eines neuronalen Netzes basierend auf dem Fehlersignal. Dieses Verfahren sorgt dafür, dass das gesamte Modell – von den Eingabevektoren bis zu den Ausgabeschichten – gemeinsam optimiert wird. Die Initialisierung mit einfachen Beispielen wie der Sprachmodellierung oder der Teilwortklassenbestimmung (POS Tagging) veranschaulicht, wie tiefere Modelle klassische NLP-Aufgaben verbessern können, ohne auf aufwändige Feature-Engineering-Maßnahmen angewiesen zu sein.

Ein weiterer Meilenstein des Tutorials ist die detaillierte Behandlung rekursiver neuronaler Netze (Recursive Neural Networks, RNN). Diese architektonische Erweiterung erlaubt es, Baumstrukturen als Eingaben zu verarbeiten – eine natürliche Voraussetzung für viele linguistische Aufgaben, die syntaktische oder semantische Baumstrukturen nutzen. Mit rekursiven Netzen lassen sich sowohl die Analyse von Satzbaumstrukturen als auch die Erzeugung von Repräsentationen für komplette Sätze oder Phrasen realisieren. Anwendungen reichen hier von der Sentiment-Analyse über die Paraphrasenerkennung bis hin zu Relationserkennung. Besonders spannend ist, dass das Tutorial den Schulungsprozess für RNNs über sogenannte Backpropagation Through Structure erklärt.

Dieser leicht modifizierte Lernalgorithmus ermöglicht es, die komplexe Struktur des Baums in den Lernprozess einzubeziehen, was zu effektiveren Modellen führt. Auch die Vorstellung von erweiterten Netzwerken wie Recursive Neural Tensor Networks zeigt nicht nur die Mathematik dahinter, sondern auch die praktische Relevanz für Aufgaben wie Stimmungsanalysen. Der Vorteil dieser Methodik ist evident: Es ist möglich, semantische Kompositionen zu modellieren – also wie die Bedeutung von Sätzen aus den Bedeutungen einzelner Wörter zusammengestellt wird. Dies entspricht menschlicher Sprachverarbeitung und war lange Zeit schwer abzubilden. Zudem behandelt das Tutorial weitere wichtige Ansätze im Deep Learning für NLP, etwa Bag-of-Words-Modelle oder Autoencoder, die auf spezifische NLP-Aufgaben zugeschnitten sind.

Dabei wird stets der Bezug zu praktischen Anwendungen gehalten und darauf geachtet, dass die Modelle interpretierbar bleiben. Die verwendeten Beispiele reichen von Named Entity Recognition (NER) über Sprachmodellierung bis hin zu komplexeren Anwendungen. Für Forscher und Entwickler, die in die Welt des Deep Learning für NLP einsteigen wollen, stellt dieses Tutorial eine wertvolle Ressource dar. Es vermittelt nicht nur theoretisches Wissen, sondern legt auch wert auf praktische Umsetzungen. Der bereitgestellte Code und die ausführlichen Übungen sind ideal, um erste eigene Modelle zu trainieren und ein Verständnis für die Herausforderungen und Chancen dieser Technologie zu gewinnen.

Dabei kommt der Ansatz ohne “Magie” insbesondere der Wissenschaft zugute, da er die Black-Box-Natur vieler Deep-Learning-Modelle aufbricht und die Nutzung dieser Methoden für neue Projekte erleichtert. Auf technischer Ebene ermöglicht Deep Learning für NLP mittlerweile beeindruckende Fortschritte. Insbesondere in den letzten Jahren wurde das Potenzial dieser Ansätze bei Aufgaben wie maschineller Übersetzung, Textklassifikation, Informationsabruf und Dialogsystemen mehr als deutlich. Die Fähigkeit, aus großen, unlabeled Datenmengen Bedeutungszusammenhänge zu extrahieren, hat die Automatisierung natürlicher Sprachprozesse revolutioniert. Trotz aller Erfolge bleibt die Erforschung offen: Es gibt weiterhin Herausforderungen bei der Skalierung, der Generalisierung auf neue Domänen und der Erklärung der Modelle.

Gleichzeitig boomen hybride Ansätze, die klassische linguistische Expertise mit Deep-Learning-Techniken kombinieren. Abschließend lässt sich sagen, dass der Einstieg in Deep Learning für NLP durch einen verständlichen Zugang wie jenen des Socher-Manning Tutorials erheblich erleichtert wird. Die klare Struktur, die genau auf die Bedürfnisse und Fragen von NLP-Forschern zugeschnitten ist, bietet ein solides Fundament, auf dem zukünftige Entwicklungen aufbauen können. Die Kombination aus mathematischer Strenge und praktischer Orientierung macht diese Ressourcen auch heute noch zu einem unverzichtbaren Leitfaden, um die komplexen Zusammenhänge zwischen Sprache und Computationsmodellierung zu verstehen und anzuwenden. Die Fähigkeit, natürliche Sprache maschinell zu verarbeiten, gewinnt mit jedem Fortschritt im Deep Learning weiter an Bedeutung und wird in Zukunft viele Anwendungen und Branchen grundlegend verändern.

Die Reise von der reinen digitalen Repräsentation zur echten Sprachverständigung hat mit diesen Methoden einen entscheidenden Schritt nach vorne gemacht.

![Caoimhín Ó'Raghallaigh demonstrates how the Hardanger d'amore works [video]](/images/A066BF10-CD45-47BA-A8E2-44D1C04F97F7)