Die Migration von einer Datenbank zu einer anderen stellt Unternehmen oft vor große Herausforderungen. Insbesondere wenn es sich um komplexe, verteilte Systeme wie CockroachDB handelt, können technische und betriebliche Probleme auftreten, die das Wachstum und die Effizienz eines Unternehmens letztlich bremsen. In den letzten Jahren haben zahlreiche Firmen, darunter auch das Technologieunternehmen Motion, den Wechsel von CockroachDB hin zu PostgreSQL vollzogen. Dieser Wechsel wurde durch verschiedene Faktoren motiviert, die einer genauen Betrachtung bedürfen, um daraus wichtige Lehren für zukünftige Projekte zu ziehen. CockroachDB und PostgreSQL sind beides relationale Datenbanksysteme mit SQL-Unterstützung, unterscheiden sich jedoch grundlegend in ihrer Architektur und ihren Einsatzzwecken.

CockroachDB steht vor allem für horizontale Skalierbarkeit und hohe Verfügbarkeit in verteilten, multi-regionalen Setups. Die Idee dahinter ist, Daten über verschiedene Standorte hinweg zu verteilen, was insbesondere für globale Unternehmen und Datenschutzanforderungen wie die DSGVO von großer Bedeutung ist. Trotz dieser Vorteile zeigten sich in der Praxis bei Motion, einem Entwickler von AI-gestützten Workflow-Lösungen, zunehmend Schwierigkeiten im produktiven Betrieb. Im Fokus der Erfahrungen stand die Kostenexplosion, die mit dem Einsatz von CockroachDB einherging. Innerhalb von zwei Jahren stiegen die Ausgaben für die Datenbank fünffach auf Beträge im sechsstelligen Bereich pro Jahr.

Diese Kostenentwicklung war für das Unternehmen schwer zu rechtfertigen, da zu diesem Zeitpunkt die Anforderungen an Multi-Region-Setups noch nicht umgesetzt wurden und die Datenbank hauptsächlich für einfache transaktionale Abfragen in einer einzigen Region genutzt wurde. Die Frage stellte sich, ob die Vorteile einer verteilten Datenbank in dieser Situation den erheblichen Mehraufwand und die hohen Kosten rechtfertigen. Neben den Kosten war auch die technische Handhabung und der Betrieb der Datenbank ein entscheidender Faktor. Ein gravierendes Problem ergab sich bei der Ausführung von Datenbankmigrationen über das ORM Prisma. Aufgrund von Timeouts während der Migrationen mussten die Entwickler wiederholt manuell in CockroachDB eingreifen und die Migrationen einzeln durchführen.

Dies führte zu längeren Deploy-Zeiten und einem erhöhten Risiko, das gesamte System durch blockierende Operationen zu beeinträchtigen. Diese Herausforderungen blockierten nicht nur den Fortschritt bei Datenbank-Upgrades, sondern erschwerten auch die Einhaltung von Wartungszyklen, da das Unternehmen länger als erwünscht auf einer veralteten Version verweilen musste. Darüber hinaus zeigten sich Probleme bei der ETL-Prozesskette, die für die Integration von Daten in externe Systeme oder Datenbanken zuständig ist. Die beschriebene Airbyte-Connector-Lösung, die offiziell nur in einer Alpha-Phase mit limitiertem Support war, zeigte deutliche Stabilitätsprobleme und führte zur wiederholten Unterbrechung von ETL-Prozessen. Diese Probleme resultierten mehrfach in nächtlichen Alarmierungen für das Team, was die Zuverlässigkeit der gesamten Dateninfrastruktur infrage stellte.

Im Bereich der Query-Performance zeigte sich ein gemischtes Bild. Während bestimmte komplexe Abfragen aufgrund des speziellen Optimizers von CockroachDB schneller waren als in PostgreSQL, machten sich bei vielen realen Abfragen, die durch das ORM Prisma generiert wurden, Nachteile bemerkbar. Besonders problematisch war die oft unnötig komplexe SQL-Generierung durch Prisma, die CockroachDB zu Volltabellenscans zwang und so Abfragezeiten massiv verlängerte. In einem Beispielbericht wurde eine Anfrage mit in etwa zwanzigfach längerer Ausführungszeit unter CockroachDB verglichen mit PostgreSQL dokumentiert. Diese ungleichmäßige Performance führte zu einer schlechteren UX und erschwerte die Entwicklung von UI-Komponenten, da selbst einfache Datenabfragen zu spürbaren Verzögerungen führten.

Auch aus Sicht der Entwickler und Betreiber traten kleineren, aber regelmäßigen Ärgernisse auf. Die Index-Empfehlungen von CockroachDB waren häufig irreführend und verursachten Verwirrungen. Schlussendlich hatte dies zur Folge, dass Entwickler wichtige Indizes entfernten, die dennoch benutzt wurden, was wiederum zu noch schlechteren Abfragezeiten führte. Darüber hinaus gestaltete sich das Abbrechen laufender, teurer Abfragen als schwieriges Unterfangen. Anders als bei PostgreSQL, bei dem ein Knopfdruck in SQL-Clients wie TablePlus genügt, verlangte CockroachDB einen manuellen Eingriff in der Kommandozeile mit zeitintensiver Koordination, was in einem Zwischenfall sogar zum Ausfall einzelner Cluster-Knoten führte.

Der Support von CockroachDB wurde ebenfalls als unbefriedigend erlebt. Das Unternehmen verfügte über einen separaten Support-Portal-Zugang, der keine nahtlose Integration mit dem Hauptzugang bot und lange Reaktionszeiten von bis zu einer Woche aufwies. Gerade bei kritischen Bugs, die den Betrieb sofort beeinträchtigten, konnte diese Verzögerung zu ernstzunehmenden Produktionsausfällen führen. Ein weiteres technisches Hindernis waren anhaltende VPC- und Netzwerk-Verbindungsprobleme. Insbesondere Tailscale-Verbindungen zu den CockroachDB-Cloud-Instances fielen immer wieder aus, ohne dass eine dauerhafte Lösung gefunden wurde.

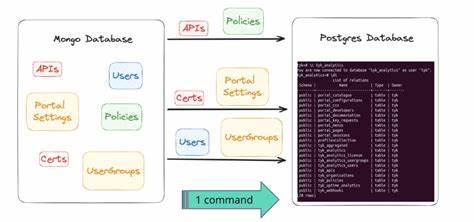

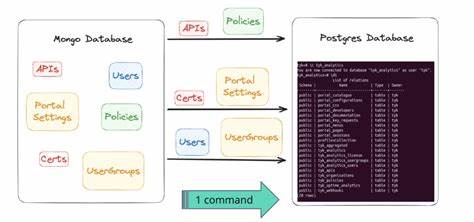

Diese Ausfälle betrafen diverse Umgebungen von Anwendungs-Integrationen bis hin zu lokalen Client-Tools und erschwerten den stabilen Betriebsfluss substantiell. Solche Probleme traten unter PostgreSQL in der Folgezeit nicht mehr auf und bestätigten die Entscheidung zugunsten eines Wechselns. Angesichts all dieser Faktoren wurde die Entscheidung zur Migration auf PostgreSQL getroffen. Die Migration selbst war eine komplexe technische Herausforderung, da CockroachDB und PostgreSQL unterschiedliche Datenformate insbesondere bei JSON- und Array-Typen verwenden. Die Notwendigkeit, sämtliche Daten kompatibel umzuwandeln, führte zur Entwicklung eines eigenen ETL-Prozesses basierend auf neuartigen Tools wie Bun, einem JavaScript-Laufzeit-Umfeld, das das Unternehmen nutzte, um eine effiziente Parallelisierung der Datenübertragung zu erreichen.

Das Migrationsskript arbeitete tabellenweise, indem es zunächst Dumps in Form von CSV-Dateien erzeugte, diese in von Child-Prozessen parallel lesbare Streams verwandelte und schließlich in die neue PostgreSQL-Datenbank einspeiste. Die Umwandlung der JSON- und Array-Daten erforderte eine speziell entwickelte Pipeline, die sicherstellte, dass die Daten in PostgreSQL die gleiche Semantik und Werte enthielten wie zuvor. Aufgrund der hohen Datenmenge von etwa 100 Millionen Zeilen in der größten Tabelle war diese Herangehensweise notwendig, um eine akzeptable Downtime während der Migration zu gewährleisten. Trotz der immensen Datenmenge verlief die Migration in der Produktion mit einem Downtime-Fenster von unter einer Stunde problemlos. Die akkurate Planung, leistungsfähige Hardware und der schrittweise Hochfahren des Systems führten zu einem reibungslosen Übergang ohne Datenverlust.

Nach der Migration zeigten sich deutliche Verbesserungen in der Gesamtsystemleistung mit einer messbaren Reduktion der Antwortzeit um ein Drittel. Darüber hinaus halfen Tools aus dem PostgreSQL-Ökosystem wie PGAnalyze, ineffiziente Abfragen schnell zu identifizieren und zu optimieren, was die Performance zusätzlich steigerte. Nicht zuletzt resultierte der Wechsel auch in signifikanten Kosteneinsparungen. Durch den Wegfall der teuren verteilten Datenbank und die Nutzung von PostgreSQL, das auf einer überprovisionierten aber trotzdem kostengünstigeren Infrastruktur lief, konnte das Unternehmen jährlich über 110.000 US-Dollar einsparen.

Diese Einsparungen kommen neben der verbesserten Entwicklerproduktivität und Systemstabilität in Summe einem erheblichen Wettbewerbsvorteil gleich. Zusammenfassend lässt sich sagen, dass die Migration von CockroachDB zu PostgreSQL für Unternehmen, die aktuell nur einfache transaktionale Workloads in einer Region betreiben, eine sinnvolle und nachhaltige Entscheidung sein kann. Die Vorteile einer spezialisierten verteilten Datenbank wie CockroachDB lassen sich nur dann ausspielen, wenn die Anforderungen an Multi-Region-Verfügbarkeit und umfassende Skalierung wirklich gegeben sind und die Betriebskosten entsprechend valide sind. Die Erfahrungen von Motion zeigen, wie wichtig es ist, technische Wahlentscheidungen laufend an die aktuellen Unternehmensbedürfnisse anzupassen und offene Betriebshürden im Blick zu behalten. Eine pragmatische Migration kann nicht nur kurzfristig Probleme beheben, sondern auch mittel- und langfristig entscheidende Vorteile im Bereich Performance, Stabilität, Kosten und Entwicklererfahrung bringen.

Wer sich mit dem Gedanken beschäftigt, eine große Datenbank-Anwendung umzustellen, sollte sich dieser Faktoren bewusst sein und gründlich evaluieren, welche Datenbanklösung am besten zu den eigenen Anforderungen passt. Dabei zahlt es sich aus, sowohl technische Aspekte, als auch operative Herausforderungen und Support-Fragen intensiv zu betrachten. Moderne Arbeitstools, offene Communities und ein breites Ökosystem an unterstützenden Werkzeugen erleichtern heute zudem den Betrieb von PostgreSQL enorm und tragen zum Erfolg einer Migration bei. Für Unternehmen, die mit den Herausforderungen großer Datenmengen, komplexer Abfragen und hoher Systemverfügbarkeit umgehen müssen, ist PostgreSQL in Kombination mit passenden ORMs und optimiertem Monitoring eine leistungsfähige Wahl. Die Zukunft der Datenbankinfrastruktur wird vor allem durch Flexibilität, Kostentransparenz und Stabilität bestimmt.

Die Migrationserfahrungen zahlreicher Firmen geben wertvolle Hinweise, wie diese Ziele effizient umgesetzt werden können.