Wir befinden uns an der Schwelle zu einer neuen Ära, in der KI-Werkzeuge in nahezu jeder Branche, insbesondere in der Softwareentwicklung, Einzug halten und rasante Veränderungen hervorrufen. Diese Technologien entwickeln sich schneller, als Menschen sich anpassen können, und plötzlich stehen Entwickler und Unternehmen vor der Herausforderung, die Kontrolle über diese digitalen Agenten zu behalten. Der Umgang mit KI-Agenten ist heute keineswegs trivial; er gleicht einer Mission, die auf den ersten Blick unmöglich erscheint. Doch mit der richtigen Herangehensweise und bewährten Techniken lässt sich die Zusammenarbeit mit künstlicher Intelligenz meistern – und zwar so, dass sie produktiv und zielgerichtet verläuft. Dieses komplexe Thema erfordert nicht nur technisches Verständnis, sondern auch eine ehrliche Auseinandersetzung mit den eigenen Fähigkeiten, der eigenen Codebasis und einem systematischen Vorgehen im Entwicklungsprozess.

Nur so können KI-Agenten ihre Stärken ausspielen und gleichzeitig die typischen Fallstricke vermieden werden. Im Zentrum einer erfolgreichen KI-Nutzung stehen sorgfältige Planung und Kontrolle des Handlungsspielraums der Agenten. Fehler, die beim Einsatz dieser Technologien entstehen können, sind vielfältig und bekannt – der Prozess gleicht daher oft einem Lernfeld mit Rückschlägen und notwendigen Anpassungen. Anders als viele vermuten, sind die eingesetzten Werkzeuge keineswegs der entscheidende Hauptfaktor. Viel wichtiger sind die Materialien, aus denen man arbeitet: die Eingaben wie Code, Diagramme, Daten und vor allem die Art und Weise, wie diese kombiniert und präsentiert werden.

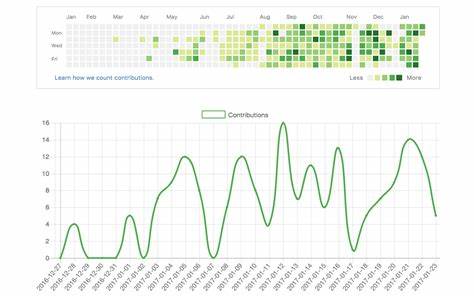

Qualität und Präzision in den Inputs sind das A und O, damit ein KI-Agent solide und hilfreich arbeiten kann. Dabei ist es egal, welches Tool oder welche Plattform zum Einsatz kommt, die Arbeitsweise sollte stets ähnlich sein: konzentriert und durchdacht. Die tägliche Veränderung und Weiterentwicklung von KI-Werkzeugen bedeutet, dass auch Nutzer ständig auf dem neuesten Stand bleiben müssen. Wer seine Tools nicht regelmäßig aktualisiert, verliert schnell den Anschluss. Nutzer profitieren besonders von einem Workflow, der sowohl Erkundung als auch direkte Handlung kombiniert und so die eigene Produktivität nachhaltig steigert.

Praktisch jeder Entwickler kann diese Methoden auf unterschiedliche Hilfsmittel übertragen – ob es sich nun um spezialisierte Agentensysteme wie Cursor, allgemeine Code-Assistenten wie GitHub Copilot oder interaktive Chatbots wie ChatGPT handelt. Doch eins ist klar: Anfänger oder Laien können kaum hochwertige Resultate erzeugen, wenn sie nicht über entsprechende Grundkenntnisse verfügen. Für den optimalen Einsatz von KI sind neben klassischen Programmierfähigkeiten auch tiefgehendes Verständnis von Softwarearchitektur sowie die Fähigkeit gefragt, Anforderungen und Zusammenhänge klar und präzise in verständlicher Sprache zu vermitteln. „Vibe Coding“ ist ein Begriff, der vor allem im Kontext von KI oft fällt – die Vorstellung, man könne einfach irgendwelche Anfragen stellen und sofort brauchbare Ergebnisse erhalten. Obwohl die Technik inzwischen beeindruckende Leistungen erbringt, ist dieser Ansatz meist trügerisch und wird der Realität nicht gerecht.

Ergebnisse, die schnell spontan erzeugt werden, sind oftmals nur Prototypen, die in der Praxis nicht funktionieren. Für schlüssige, auslieferbare Software ist es unabdingbar, einen durchdachten, wiederverwendbaren Plan zu erstellen – auch wenn es zunächst paradox klingt, eine „einmalige“ Aufgabe wiederverwendbar zu planen. Gerade in diesem Schritt zeigt sich, wie oft KI-Agenten selbst nicht ausreichend Sicherheit in ihrem Vorgehen haben und deshalb auf improvisierte Lösungen zurückgreifen, die unerwartete Fehler verursachen können. Ein gut strukturierter Plan, in kleine, überschaubare Abschnitte unterteilt, ist deshalb die Grundlage dafür, dass der KI-Agent fokussiert und zielgerichtet arbeitet. Die Suche nach einem geeigneten Weg, um ein Problem mit dem Agenten zu lösen, benötigt manchmal mehr Zeit als das reine Coding per Hand.

Doch dieser Mehraufwand zahlt sich aus. Er liefert nicht nur eine saubere Dokumentation des Lösungsansatzes, sondern ermöglicht es auch, bei Bedarf den Plan jederzeit zu revidieren, zu erweitern oder zu wiederholen. Damit macht man sich unabhängiger von einzelnen Antworten der KI und profitiert von einer stabilen Struktur, die zu sauberem und wartbarem Code führt. Wer komplexe Aufgaben oder tiefe Eingriffe in die Codebasis plant, kommt nicht um strategische Planung herum. Gleichzeitig sollte man bei der Aufteilung der Aufgaben vorsichtig sein, die Anforderungen modular halten und bei Unsicherheit lieber mehr Erkundungen durchführen, als voreilig in die Implementierung zu springen.

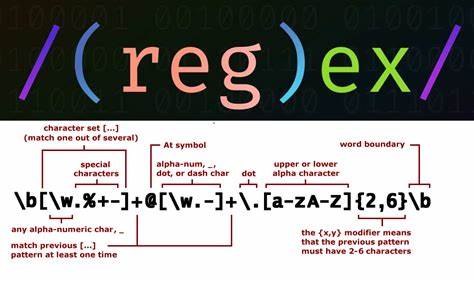

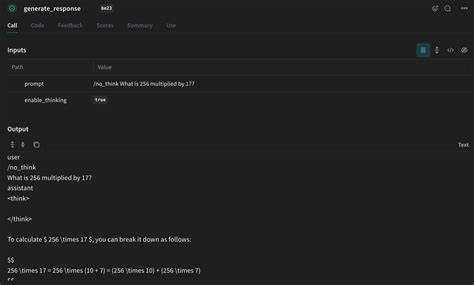

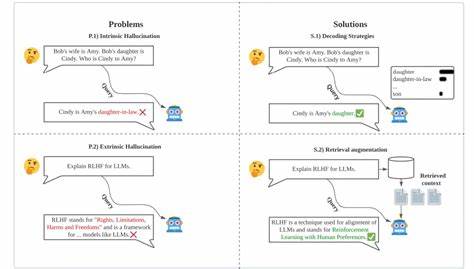

Nur dann gelingt es, die KI-Unterstützung wirklich sinnvoll einzusetzen. Bei der Suche nach Lösungen stoßen viele Entwickler auf das Paradox, dass ganz einfache Anweisungen für KI-Agenten oft unnötig kompliziert sind. Wo Menschen klare Regeln und Erfahrungen haben, fehlt der KI-Modellen ein echtes Regelverständnis. Ihr Kernverfahren ist das Vorhersagen von wahrscheinlichem Text – nicht das Beherrschen von klaren Abläufen oder festen Grundsätzen. Dadurch entstehen gelegentlich Missverständnisse oder unerwartete Ergebnisse, besonders bei scheinbar trivialen Codieraufgaben.

Diese Limitierungen sollten Entwickler kennen und sich bewusst machen, um Fehlentwicklungen zu vermeiden. Manches ist schlichtweg besser, selbst zu erledigen, während kompliziertere Aufgaben von KI-Unterstützung profitieren können. Die Planung ist ein elementarer Arbeitsschritt, den man nicht unterschätzen sollte. Sie gleicht dem Erlernen eines Instruments: Einen Song im Voraus zu planen ist deutlich aufwendiger, als ihn einfach drauflos zu spielen. Doch erst durch eine sauber durchdachte Planung entsteht etwas Wertiges.

Der Entwurf einer detaillierten, maschinen- und menschengerechten Planung – etwa in Form überschreibbarer Dateien mit klarer Struktur und kommentiertem Code – ermöglicht vielfältige Vorteile. Das Dokumentieren und versionieren solcher Pläne im Projekt ermöglicht den Überblick, erleichtert die Zusammenarbeit und schafft eine belastbare Grundlage für den Entwicklenden und den KI-Agenten gleichermaßen. Im Gegensatz zu einfachen Befehlen oder Kurzprompten offenbart sich das Potenzial dieser Herangehensweise insbesondere bei komplexen Softwareprojekten. Wie realistisch die Pläne sind, zeigt sich allerdings oft schnell, da sie nach der ersten Erstellung meist falsch oder unvollständig sind. Diese Diskrepanz ist kein Fehler, sondern Teil des Lernprozesses – sowohl für den Menschen als auch für die KI.

Die ständige Verbesserung, Anpassung, Kürzung oder Erweiterung der Pläne ist wesentlicher Bestandteil einer produktiven Zusammenarbeit mit KI-Agenten. Dabei ist es wichtig, sich selbst nicht zu frustrieren, sondern den Prozess als iterative Entwicklung zu verstehen, die mit Geduld und Präzision zu immer besseren Ergebnissen führt. Tests spielen beim Einsatz von KI eine zentrale Rolle und dürfen keinesfalls vernachlässigt werden. Auch wenn die KI auf den ersten Blick scheinbar optimal funktionierende Lösungen liefert, ist eine manuelle Überprüfung durch den Entwickler unabdingbar. KI-Modelle besitzen keine echte Einsicht in Code oder Anwendung, sondern basieren lediglich auf statistischer Wahrscheinlichkeitsrechnung.

Sie können daher durchaus fehlerhafte oder nur scheinbar funktionierende Lösungen generieren, die in realen Szenarien versagen. Das Testen und Validieren des Codes in der echten Umgebung bleibt somit eine menschliche Kernaufgabe. Dabei hilft es, die Schritte einer KI-generierten Lösung jeweils einzeln umzusetzen, zu prüfen und zu committen, um im Fehlerfall schnell Rollbacks durchführen zu können. Der bewusste und kontrollierte Einsatz von KI schließt auch eine ehrliche kritische Betrachtung des eigenen Codes ein. Es ist eine Herausforderung, unangenehme Schwächen zu erkennen und zuzugeben, doch gerade dadurch verbessert sich das gesamte Projekt.

KI kann dabei ungeschönte Schwachstellen aufdecken und Entwickler zur Refaktorierung motivieren. Auch wenn dies anfangs Zeit und Aufwand kostet, zahlt es sich langfristig durch bessere Wartbarkeit, weniger technische Schulden und bessere Vorgaben für zukünftige Funktionen aus. Ein empathischer Umgang mit sich selbst und der Codebasis schafft die besten Voraussetzungen für ein erfolgreiches Zusammenspiel von Mensch und Maschine. Ein weiterer entscheidender Punkt sind die Regeln, die man der KI gibt, um gewünschte Verhaltensweisen zu steuern. Solche Regeln können fest und immer angewandt werden oder nur situativ, je nach Dateityp, Kontext oder Zweck.

Mit ihnen lassen sich wiederkehrende Fehler minimieren, Verhaltensmuster sicherstellen und zuverlässige Standards etablieren. Moderne Tools erlauben es sogar, KI selbst Regeln erstellen und aktualisieren zu lassen, was den Prozess weiter automatisiert und verbessert. Die Kunst besteht darin, Regeln klar, prägnant und positiv formuliert zu verfassen, um die KI nicht mit widersprüchlichen oder unnötigem Kontext zu überladen. Natürlich kostet der Betrieb von KI-Agenten Geld und Zeit, man investiert also sowohl menschliche als auch finanzielle Ressourcen. Allerdings ist das Verhältnis von Aufwand zu Nutzen besonders bei schwerwiegenden Tätigkeiten wie Refaktorierung und Debugging sehr positiv.

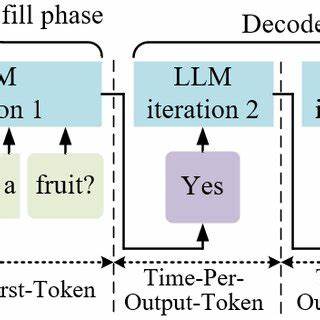

Diese Bereiche profitieren am meisten von der präzisen, systematischen Unterstützung durch KI, da sie tiefes Verständnis und akribisches Vorgehen erfordern. Feature-Entwicklung dagegen birgt das Risiko, dass schnell Ergebnisse produziert werden, die nur scheinbar fertig sind und später Probleme verursachen. Die beste Strategie ist, mit kleinen, gut geplanten Schritten zu arbeiten und für größere Änderungen den Plan ausgiebig zu testen. Die Auswahl des richtigen KI-Modells ist eine weitere Stellschraube. Unterschiedliche Modelle sind für verschiedene Aufgabenbereiche optimiert: Es gibt sogenannte Aktionsmodelle für unmittelbare Ausführung, Denkmodelle für Planung und Debugging und Deep-Thinking-Modelle für komplexe, umfangreiche Analyse.

Üblicherweise sollten Planungs- und Denkphasen von ressourcenintensiveren Modellen unterstützt werden, während die Umsetzung durch günstigere Aktionsmodelle erfolgt. Das bewusste Wechseln zwischen Modellen spart Kosten und verbessert die Ergebnisse. Auch die Begrenzung der Zeichen- und Kontextfenster spielt eine Rolle, damit der Agent relevant bleibt und nicht wertvollen Prompt-Kontext verliert. Kostenkontrolle ist ein entscheidender Faktor für den produktiven Einsatz von KI. Nutzer müssen sorgfältig Budgets setzen, Modelle aktiv ein- und ausschalten und immer wieder den Nutzen im Verhältnis zu den Ausgaben überprüfen.

Dabei ist es wichtig, nicht auf Gratis- oder Billigmodelle zu setzen, wenn diese qualitativ nicht mit den bewährten Premiumangeboten mithalten können. Außerdem sollte man experimentierfreudig bleiben, da sich sowohl Preise als auch Modelle stetig verändern und besser werden. Die Fähigkeit, flexibel auf neue Angebote und Entwicklungen zu reagieren, zahlt sich langfristig aus. Ein Konzept, das in der Diskussion um die Vernetzung verschiedener KI-Agenten aufgekommen ist, nennt sich Model Context Protocol (MCP). Es handelt sich dabei um ein standardisiertes Format, über das unterschiedliche Modelle und Tools miteinander kommunizieren können.

Obwohl MCP spannende Möglichkeiten bietet, ist es letztlich kein magisches Allheilmittel. Es bildet im Kern ab, was Entwickler sowieso bereits tun: den Austausch von Prompts und Aufrufen zwischen verschiedenen Systemen. Daher bleibt MCP in der Praxis meistens nur eine weitere Ebene in der Orchestrierung, ohne grundlegende Probleme zu lösen. Übermäßige Formalisierung der Kommunikation kann sogar zu Einbußen bei der Flexibilität und Robustheit führen. Mit anderen Worten: Zukunftsfähigkeit entsteht vor allem durch intelligente Planung und kontextbewusste Nutzung – und nicht nur durch Strukturierung der Schnittstellen.