Die rasante Entwicklung Künstlicher Intelligenz hat in den letzten Jahren immense Fortschritte durch die Kombination unterschiedlicher Modellarten erlebt. Besonders hervorzuheben ist die Verschmelzung von visuellen Wahrnehmungsmodellen mit großen Sprachmodellen, sogenannten Vision-Language Models (VLMs). Diese Modelle verbinden die Fähigkeit, Bilder oder Videos zu interpretieren, mit den komplexen sprachlichen und denkenden Fähigkeiten großer Sprachmodelle (Large Language Models, LLMs). Die aktuelle Herausforderung besteht jedoch darin, diese beiden unterschiedlichen Fähigkeiten – visuelle Wahrnehmung und abstraktes Denken – so zu verbinden, dass sie sich gegenseitig optimal ergänzen. Ein vielversprechender Ansatz, der genau diese Brücke schlagen will, ist das Model Merging, also das Zusammenführen verschiedener Modelle auf Ebene ihrer Parameter.

Model Merging ermöglicht es, verschiedene KI-Modelle, die ursprünglich separat trainiert wurden, miteinander zu verschmelzen, ohne dass eine zusätzliche aufwendige Trainingsphase notwendig ist. Während frühere Forschungen sich oftmals darauf konzentrierten, Modelle gleicher Art miteinander zu kombinieren, bietet das innovative Verfahren, Modelle verschiedener Modalitäten zu vereinen, wie es bei VLMs und LLMs geschieht, eine völlig neue Perspektive. Durch das Verschmelzen eines visuellen Modells mit einem leistungsstarken Sprachmodell können die herausragenden Fähigkeiten der beiden getrennten Welten allmählich zusammengeführt werden, ohne dabei die Vorteile einzelner Modelle zu verlieren. Die Wirkung von Model Merging geht jedoch weit über das bloße Kombinieren von Funktionen hinaus. Durch detaillierte Experimente hat sich gezeigt, dass die Wahrnehmungsfähigkeiten eines Modells vor allem in den frühen Schichten eines neuronalen Netzwerks kodiert sind, während das reasoning – also das logische Denken und die Schlussfolgerung – hauptsächlich in den mittleren bis späten Schichten stattfindet.

Interessanterweise beeinflusst das Zusammenführen der Modelle diese Schichtstruktur: Nach dem Merging tragen alle Schichten verstärkt zu den reasoning-Fähigkeiten bei, während die Verteilung der Wahrnehmungsfähigkeiten weitgehend stabil bleibt. Dieses Phänomen bietet wertvolle Einblicke darüber, wie neuronale Netzwerke komplexe Fähigkeiten organisieren und welche Rolle einzelne Schichten spielen. Für die Praxis bedeutet die Möglichkeit, LLMs und VLMs ohne erneutes Training zusammenzuführen, einen enormen Fortschritt. Das reduziert nicht nur die Ressourcen, die typischerweise für längere Trainingsphasen erforderlich sind, sondern ermöglicht auch eine flexible und schnelle Integration verbesserter Denkfähigkeiten in bereits funktionierende visuelle Modelle. Insbesondere im Bereich der multimodalen KI, in dem die Verarbeitung von Text, Bild und anderen Datenquellen gleichzeitig erforderlich ist, stellt Model Merging eine vielversprechende Technologie dar, um die Grenzen herkömmlicher Systeme zu überwinden.

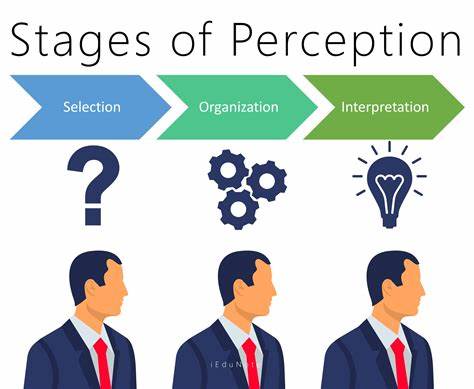

Die Integration von Wahrnehmung und Reasoning ist essenziell, um KI-Systeme zu entwickeln, die nicht nur Informationen sammeln, sondern diese auch sinnvoll interpretieren und schlussfolgern können. Visuelle Inputs liefern Kontext und Details, während Sprachmodelle die Fähigkeit zur abstrakten Analyse und Verallgemeinerung besitzen. Die Verschmelzung dieser beiden Kompetenzen erlaubt es Maschinen, komplexe Aufgaben zu bewältigen – von der Beschreibung und Interpretation von Bildern bis hin zur Lösung multimodaler Probleme, bei denen visuelle Daten mit Sprache verknüpft werden müssen. Darüber hinaus bietet das Verständnis der inneren Mechanismen nach dem Zusammenführen der Modelle eine wichtige Grundlage für die Weiterentwicklung von KI-Architekturen. Durch das Sichtbarmachen, welche Schichten welche Funktionen übernehmen und wie sich diese nach dem Merging verändern, können Forscher gezielter und effizienter neue Modelle gestalten.

Dies ist insbesondere für die Erklärbarkeit von KI von Bedeutung, ein Feld, das immer mehr an Relevanz gewinnt, da wir KI-Systeme nicht nur mächtig, sondern auch transparent und vertrauenswürdig machen wollen. Die Forschungsarbeit, die sich intensiv mit Model Merging befasst, wurde vor Kurzem auf einer renommierten Fachkonferenz präsentiert und hat bereits viel Aufmerksamkeit innerhalb der Fachwelt erhalten. Die Veröffentlichung und zugängliche Bereitstellung des Codes ermöglicht es weiteren Forschenden und Entwicklern, den Ansatz zu adaptieren und weiterzuentwickeln. Dieses offene Modell der Zusammenarbeit steht exemplarisch für die dynamische Innovationskraft der KI-Community. Neben den theoretischen und technischen Fortschritten zeigt Model Merging auch praktische Perspektiven für den Einsatz in verschiedensten Bereichen.

Im Gesundheitswesen könnten multimodale Modelle präziser Diagnosen liefern, indem sie bildgebende Verfahren mit klinischen Textinformationen verknüpfen. Im Bereich autonomer Systeme und Robotik ermöglicht die Kombination von Wahrnehmung und Reasoning intelligente Entscheidungen basierend auf visuellen Daten. Auch in der Mensch-Computer-Interaktion eröffnen sich neue Möglichkeiten, da KI-Systeme komplexe kontextuelle Informationen besser verstehen und darauf reagieren können. Zusammenfassend stellt Model Merging eine innovative Methode dar, um die Fähigkeiten moderner KI-Modelle zu kombinieren und das Zusammenspiel von Wahrnehmung und Denken besser zu verstehen. Dieser Ansatz erweitert nicht nur das Potenzial multimodaler Systeme, sondern schafft auch neue Einsichten in die interne Architektur neuronaler Netzwerke.

Die damit verbundenen Vorteile in Trainingsökonomie, Flexibilität und interpretativer Klarheit fördern die Entwicklung intelligenter Systeme, die effizienter, robuster und zutreffender agieren können. Die Zukunft der Künstlichen Intelligenz könnte durch diese Art der Modellintegration geprägt werden, bei der verschiedene spezialisierte Fähigkeiten auf elegante Weise miteinander vereint werden. Model Merging bietet eine faszinierende Brücke zwischen Wahrnehmung und Reasoning – zwei der zentralsten Aspekte menschlicher Intelligenz – und bringt uns damit einen Schritt näher an die Entwicklung von Maschinen, die nicht nur sehen, sondern auch verstehen und folgern können.