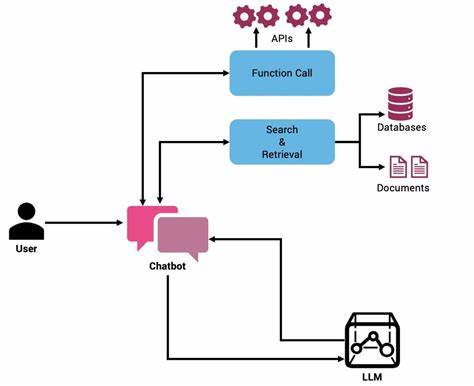

Die fortschreitende Entwicklung großer Sprachmodelle (Large Language Models, kurz LLMs) hat die Art und Weise, wie wir mit Künstlicher Intelligenz interagieren, maßgeblich verändert. Neben der bloßen Textgenerierung eröffnen LLMs mittlerweile die Möglichkeit, durch sogenanntes Funktionales Aufrufen (Function Calling) direkt mit externen Systemen und Anwendungen zu kommunizieren. Diese Fähigkeit wandelt die KI von einem passiven Texterzeuger zu einem aktiven Agenten, der komplexe Aufgaben verstehen, interpretieren und ausführen kann. Funktionales Aufrufen ermöglicht es LLMs, aus der natürlichen Sprache des Nutzers heraus spezifische Funktionsaufrufe zu generieren, um etwa Daten abzurufen, Informationen zu verarbeiten oder Aktionen in realen Systemen auszulösen. Im Unterschied zur direkten Ausführung führen LLMs selbst diese Funktionen nicht aus.

Stattdessen erstellen sie strukturierte Datensätze, die den Funktionsnamen sowie alle notwendigen Argumente enthalten, um den Aufruf zu vollziehen. Diese Datenstrukturen, meist in Form von JSON, werden an eine externe Steuerungskomponente weitergeleitet, welche den tatsächlichen Code ausführt. Damit wird einerseits die Sicherheit erhöht, da die LLMs keinen direkten Zugriff auf kritische Systeme erhalten. Andererseits bleibt die Flexibilität erhalten, da die Modelle aufgrund ihrer Sprachkompetenz die passende Funktion für eine Benutzeranfrage auswählen können. Ein typisches Beispiel für den Einsatz von Funktionalem Aufrufen stellt ein Shopping-Assistent dar.

Wird dieser Agent mit einer Anfrage wie „Ich suche ein blaues T-Shirt“ konfrontiert, analysiert das LLM die Intention und bestimmt, dass eine Suchfunktion mit den Stichwörtern „blaues T-Shirt“ aufgerufen werden muss. Bei einer spezifischeren Anfrage, etwa „Zeig mir Details zum blauen Laufschirt“, wird eine Funktion zur Abfrage von Produktdetails mit der entsprechenden Produkt-ID generiert. Sollte die Absicht unklar sein, sorgt eine Klarifizierungsfunktion für Rückfragen, um Missverständnisse zu vermeiden und ein zielgerichtetes Arbeiten zu gewährleisten. Der technische Kern hinter diesem Ablauf liegt in einer intelligent gestalteten Schnittstelle, die dem LLM alle möglichen Funktionen mitsamt ihrer Parameter und Beschreibung zur Verfügung stellt. Diese Funktionen werden durch sogenannte Funktionsschemata definiert, in denen festgelegt ist, welche Eingaben notwendig sind, wie sie strukturiert sein müssen und welche Bedeutung sie haben.

So erhält das Modell klare Vorgaben, wann welche Funktion eingesetzt wird. Die Herausforderung liegt darin, diese Vorgaben präzise zu formulieren, damit das LLM ohne Fehlinterpretationen arbeitet. Zur Entwicklung eines robusten Agenten wird häufig ein Systemprompt verwendet. In diesem definiert man die Rolle des Modells, seine Aufgaben und die verfügbaren Werkzeuge. Dabei kann die Aufforderung auch enthalten, in Zweifelsfällen Rückfragen zu stellen, statt voreilige Entscheidungen zu treffen.

Der Agent profitiert so von einer kontextbewussten Interaktion, die auf der Historie der Konversation basiert und frühere Antworten berücksichtigt, um eine konsistente Nutzererfahrung zu gewährleisten. Beim Bau eines solchen Systems besteht die Gefahr von Sicherheitslücken, insbesondere durch sogenannte Prompt-Injection-Angriffe. Dabei versuchen Angreifer, die Instruktionen im Systemprompt zu umgehen oder zu manipulieren, um schadhafte Aktionen zu provozieren. Von zentraler Bedeutung ist es daher, die Aktionsmöglichkeiten des Agenten strikt zu begrenzen und die Benutzereingaben auf schädliche Muster zu überprüfen. Neben klassischen Methoden wie Blacklists und regulären Ausdrücken können auch zusätzliche Modelle genutzt werden, um potenzielle Missbrauchsversuche zu erkennen.

So wird ein mehrlagiger Schutz erreicht, der die Integrität der Anwendung wahrt. Die eigentlichen Aktionen, welche als Folge der Funktionsermittlung ausgeführt werden, sind in sogenannten Aktionsklassen implementiert. Diese Klassen übernehmen das Mapping zwischen der Spracheingabe und den konkreten Systemaufrufen. In einem Shopping-Agenten beispielsweise kümmern sich Klassen um Produktsuche, Detailabfrage und Klärung von Eingaben. Jede Klasse enthält eine Ausführungsmethode, die die passende API des Unternehmens oder Dienstleisters anspricht und das Ergebnis in menschenlesbarer Form zurückgibt.

Ein weiterer Fortschritt wird durch die Nutzung von Frameworks erreicht, die Boilerplate-Code reduzieren. So können beispielsweise Pydantic-Modelle genutzt werden, um Aktionstypen präzise zu definieren und automatisch in das offene OpenAI-Schema zu übersetzen. Das vereinfacht nicht nur die Entwicklung, sondern erhöht auch die Wartbarkeit und Lesbarkeit des Codes. Interessant ist zudem die Frage, ob dieser Ansatz traditionelle Rules Engines ersetzen kann. Während klassische Regelwerke oft starr, schwer zu warten und anfällig für unerwartete Wechselwirkungen sind, bieten LLM-basierte Systeme eine flexible, kontextabhängige Entscheidungsfindung.

Sie können natürlichsprachliche Anweisungen interpretieren und komplexe Intentionen erfassen, die in starren Regelsystemen schwer abzubilden sind. Dennoch sind sie nicht vollkommen deterministisch, weshalb in vielen Fällen eine hybride Herangehensweise sinnvoll ist: Automatisierte Entscheidungsfindung kombiniert mit manuellen Kontrollpunkten, um Sicherheit und Transparenz zu gewährleisten. Der Begriff „Tool Calling“ erweitert schließlich das Verständnis von Funktionalem Aufrufen. Er umfasst nicht nur speziell programmierte Funktionen, sondern die gesamte Bandbreite an Mechanismen, mit denen ein LLM externe Werkzeuge nutzen kann – darunter etwa Code-Interpreter, Datenbankabfragen oder Analysewerkzeuge. Diese Gesamtheit ermöglicht es Agenten, komplexe Aufgaben flexibel und effektiv zu lösen.

Eine kommende Entwicklung in diesem Kontext ist das Model Context Protocol (MCP). Dieses Protokoll verfolgt das Ziel, eine standardisierte Schnittstelle zwischen LLM-Anwendungen und externen Funktionalitäten bereitzustellen. Im MCP-Setup werden ein Server mit verfügbaren Tools, ein Client zur Kommunikation sowie ein Host, der LLM-basierte Agenten ausführt, klar getrennt. Diese Modularität ermöglicht es, zur Laufzeit neue Werkzeuge zu entdecken und einzubinden, ohne die Kernanwendung anpassen zu müssen. Beispielhaft lässt sich dies auf unseren Shopping-Agenten übertragen: Statt fest programmierter Funktionen kann der Agent dynamisch abfragen, welche Tools zur Verfügung stehen, und sie flexibel in seine Dialogstrategie integrieren.

Das erweitert Skalierbarkeit und Anpassungsfähigkeit erheblich. Trotz der Vielversprechung von MCP ist der Einsatz mit erhöhter Komplexität verbunden, weshalb es nicht in jedem Szenario sinnvoll ist. Für einfache Anwendungsfälle oder Anwendungen mit überschaubaren Werkzeugumfängen bietet die direkte Funktionale Aufrufstrategie ausreichend Sicherheit und Performance. Bei komplexen, sich ständig ändernden Umgebungen, etwa für Entwicklungsassistenten oder mehrdimensionale Agentensysteme, kann MCP jedoch ein entscheidender Fortschritt sein. Das Zusammenspiel von LLMs, Funktionalem Aufrufen und Protokollen wie MCP eröffnet neue Horizonte für die Entwicklung intelligenter Agenten.

Sie ermöglichen es, die flexible Sprachkompetenz von Modellen mit der Verlässlichkeit und Sicherheit traditioneller Softwarebausteine zu kombinieren. Dabei sind jedoch durchdachte Sicherheitskonzepte wie Eingabesanitierung und begrenzte Funktionsräume unerlässlich, um Angriffen vorzubeugen und die Nutzerdaten zu schützen. Insgesamt steht fest, dass Funktionales Aufrufen eine Schlüsselrolle in der Zukunft der KI-Agenten spielen wird. Es erlaubt neben besseren Nutzererlebnissen auch effizientere, sicherere und leichter wartbare Systeme. Entwickler sollten mit einfachen, risikoarmen Funktionen beginnen und ihre Anwendung schrittweise ausbauen, während sie zugleich die Sicherheitsmaßnahmen weiterentwickeln.

Wer sich tiefgehend mit der Integration von LLMs in produktive Systeme beschäftigt, sollte sich intensiv mit Konzepten wie Funktionalem Aufrufen, Aktionen, Systemprompts sowie Protokollen wie MCP auseinandersetzen. Diese bilden die Grundlage für moderne, adaptive Agenten, welche die Interaktion zwischen Mensch und Maschine auf ein neues Niveau heben können. So eröffnen sie neue Möglichkeiten in zahlreichen Bereichen, von E-Commerce und Kundenservice über Softwareentwicklung bis hin zu datengetriebenen Entscheidungsprozessen.