In den letzten Jahren haben große Sprachmodelle, bekannt als Large Language Models (LLMs), in vielen Fachgebieten bemerkenswerte Fortschritte erzielt. Besonders im Bereich der Chemie, einem wissenschaftlichen Feld, das auf komplexem Wissen und tiefgreifender Denkfähigkeit basiert, stellt sich die Frage, wie diese technologischen Systeme mit der Expertise von menschlichen Chemikern konkurrieren können. Die rasante Entwicklung der KI-Systeme weckt sowohl Faszination als auch Skepsis hinsichtlich ihrer tatsächlichen Fähigkeiten im wissenschaftlichen Kontext. Eine wegweisende Studie, veröffentlicht im Jahr 2025, führt die Diskussion über die Chemiekenntnisse und das schlussfolgernde Denken von LLMs im Vergleich zu menschlichen Experten auf eine neue Ebene. Große Sprachmodelle sind darauf trainiert, Sprache zu verstehen und zu generieren, indem sie auf riesigen Textkorpora basieren.

Der vielversprechende Gedanke dahinter ist, dass sie durch die Verarbeitung umfangreicher Textinformationen auch das Fachwissen einer Vielzahl von Bereichen, darunter Chemie, erwerben können. Doch bislang mangelte es an systematischen Bewertungsmethoden, die die chemischen Fähigkeiten dieser Modelle umfassend und fair mit der Leistung von Chemikern vergleichen. Dieses Defizit hat das Team um Adrian Mirza und Kollegen mit der Entwicklung von ChemBench adressiert, einem automatisierten und umfassenden Evaluationsrahmen für chemisches Wissen und Schlussfolgerungen von LLMs. ChemBench ist ein umfangreiches Benchmarking-Tool, das über 2.700 Fragen umfasst, die aus unterschiedlichen Quellen stammen – von manuell erstellten Prüfungsfragen bis hin zu automatisch generierten Aufgaben.

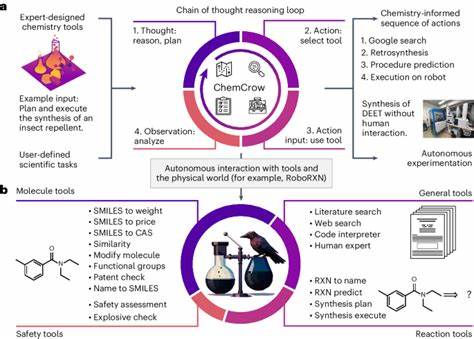

Diese Fragen decken ein breites Spektrum chemischer Themenfelder ab, darunter Allgemeine Chemie, Organische Chemie, Anorganische, Analytische sowie Technische Chemie. Der besondere Wert des Benchmarks liegt darin, dass er nicht nur auf Multiple-Choice-Fragen setzt, sondern auch offene Fragen und Aufgaben, die verschiedene Fähigkeiten wie Faktenwissen, Rechenfertigkeiten, logisches Denken und chemische Intuition erfordern, umfasst. Damit schafft ChemBench eine realitätsnahe Abbildung der Anforderungen, die an Chemiker in Studium und Forschung gestellt werden. Die Evaluierung erfolgte mittels moderner LLMs, darunter sowohl proprietäre als auch Open-Source-Modelle, die teils mit externen Werkzeugen wie Web-Suchen oder speziellen Chemieanwendungen kombiniert wurden. Ergänzend diente eine Vergleichsstudie mit Chemieexperten verschiedener Fachrichtungen als menschliche Benchmark.

Besonders überraschend war das Ergebnis, dass die besten Modelle im Durchschnitt die Leistung der besten Chemiker in der Studie teilweise deutlich übertrafen. Diese Erkenntnis wirft erhebliche Fragen nach der Rolle und dem Potenzial von KI-Systemen in der chemischen Forschung und Ausbildung auf. Trotz beeindruckender Gesamtleistungen offenbart die Untersuchung auch erhebliche Schwächen der Modelle. Grundlegende Aufgaben, die eigentlich als Standardwissen gelten, führen immer wieder zu Fehlern oder unsicheren Antworten. Beispielsweise zeigten die KI-Systeme Schwierigkeiten bei Fragestellungen zur Toxizität von Chemikalien oder bei der Analyse von Spektraldaten, wo Verständnis der molekularen Struktur und analytische Fähigkeiten entscheidend sind.

Auffällig war, dass Modelle häufig übermäßig selbstbewusste Antworten gaben, obwohl diese falsch waren. Diese mangelnde Fähigkeit zur Selbsteinschätzung stellt ein bedeutendes Risiko für den praktischen Einsatz dar, insbesondere wenn Laien auf diese Systeme vertrauen. Ein bemerkenswerter Aspekt liegt in der eingeschränkten Fähigkeit der LLMs, strukturbezogenes chemisches Denken zu leisten. Zwar können sie komplizierte Fragestellungen bearbeiten, jedoch zeigte sich in der Analyse, dass die Leistung der Modelle nicht signifikant mit der Komplexität der Molekülstrukturen korrelierte. Dies deutet darauf hin, dass die Modelle eher auf Ähnlichkeiten mit Trainingsdaten zurückgreifen statt tatsächlich ein eigenständiges Verständnis molekularer Eigenschaften und Strukturen zu entwickeln.

Für kritische Anwendungen wie die Vorhersage von NMR-Spektren oder die Identifikation von Isomeren stellt dies eine große Einschränkung dar. Weiterhin legen die Ergebnisse nahe, dass die Modelle dennoch von einer Erweiterung und Vertiefung ihrer Trainingsdatensätze profitieren könnten. Während viele aktuelle LLMs überwiegend auf wissenschaftlichen Publikationen und allgemeinen Texten basieren, fehlt ihnen der direkte Zugang zu spezialisierten chemischen Datenbanken wie PubChem oder GESTIS. Der Einbezug solcher spezialisierten Datenquellen könnte die Faktengenauigkeit und Zuverlässigkeit deutlich erhöhen und fehlendes Detailwissen ergänzen. Die Studie hebt ebenfalls hervor, dass die Performance der Modelle mit deren Größe zusammenhängt.

Größere Modelle erzielen im Mittel bessere Resultate, was Parallelen zu anderen Domänen wie Medizininformatik oder allgemeiner Spracherkennung widerspiegelt. Dies spricht für mögliche Fortschritte durch weitere Skalierung von Chemie-LLMs, auch wenn dies mit erhöhten Kosten und Ressourcenverbrauch verbunden ist. Auch wenn die Modelle in der Beantwortung wissensbasierter und rechenintensiver Aufgaben brillieren, sind sie aktuell noch nicht in der Lage, chemische Präferenzen oder subjektive Bewertungen von Chemikern zu replizieren. Die Einordnung, welches Molekül in einem Entwicklungsprozess besser geeignet ist, bleibt eine Domäne, in der menschliche Intuition und Erfahrung entscheidend sind. Die KI zeigte sich hier weitgehend zufällig in ihrer Bewertung, was den Nutzen für die frühzeitige Entscheidungsfindung bei neuen Molekülentwürfen einschränkt.

Darüber hinaus ist die Art und Weise, wie ChemBench den Umgang der Modelle mit Unsicherheit untersucht hat, aufschlussreich. Indem die Modelle gebeten wurden, ihre eigene Sicherheit bei den Antworten einzuschätzen, zeigte sich, dass viele nicht zuverlässig zwischen korrekten und falschen Antworten unterscheiden können. Fehlkalibrierte Vertrauenseinschätzungen können ernsthafte Folgen haben, wenn Nutzer die Antworten als gegeben hinnehmen ohne kritische Prüfung. Dies stellt einen zentralen Punkt für die Weiterentwicklung von LLMs als vertrauenswürdige Unterstützer in der Chemie dar. Die Implikationen dieser Ergebnisse sind weitreichend.

In der Ausbildung könnte sich der Fokus weg von reinem Auswendiglernen chemischer Fakten hin zum kritischen Denken und zur Problemlösung verlagern, da LLMs bereits einen Großteil des Faktenwissens reproduzieren können. Für die Forschung eröffnen sich neue Möglichkeiten, etwa durch die Unterstützung von Chemikern bei der Analyse großer Datenmengen, der Formulierung von Hypothesen oder der automatisierten Planung von Synthesen. Gleichzeitig fordert der Einsatz von KI ein verantwortungsbewusstes Handling der Technologien, um Risiken wie Fehlinformationen oder dual-use Anwendungen (zum Beispiel im Bereich chemischer Waffen) zu minimieren. Zukünftige Entwicklungen werden sich vermutlich auf die Kombination aus LLMs und spezialisierten Modulen konzentrieren, die beispielsweise molekulare Strukturen präzise analysieren oder sicherheitsrelevantes Wissen gesondert verifizieren. Die Schaffung besser kalibrierter Unsicherheitsabschätzungen und die Integration von Expertenwissen in Echtzeit sind weitere Ziele, um den Mehrwert der KI-Systeme zu erhöhen und deren Limitierungen auszugleichen.

Abschließend zeigt die Einführung von ChemBench als umfassendem Bewährungsfeld für chemische Sprachmodelle eine neue Ära in der Verbindung von KI und Chemie an. Während große Sprachmodelle in vielen Bereichen menschliche Experten herausfordern oder sogar übertreffen, bleiben wichtige Grenzen bestehen, die nur durch gezielte Weiterentwicklung und engvermaschte Mensch-Maschine-Kollaboration überwunden werden können. Die Balance zwischen automatisierter Wissensverarbeitung und kritisch reflektierter Expertise wird maßgeblich die Zukunft der chemischen Wissenschaften im Zeitalter der künstlichen Intelligenz prägen.