Die Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat die Künstliche Intelligenz und die Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) revolutioniert. An einem zentralen Punkt dieser Modelle steht der Mechanismus der Selbstaufmerksamkeit, oft implementiert durch Attention Heads innerhalb von Transformern. Obwohl diese Bausteine maßgeblich zum Erfolg von LLMs beitragen, werden sie oft missverstanden – und zwar als hochkomplexe Einheiten. Tatsächlich sind einzelne Attention Heads relativ simpel und führen einfache Aufgaben aus. Doch die Kombination zahlreicher dieser Heads über mehrere Schichten macht den Unterschied und erschafft die beeindruckende Leistungsfähigkeit moderner Sprachmodelle.

Wenn man verstehen will, warum diese Mechanismen so gut funktionieren, ist es wichtig, den Grundgedanken hinter Aufmerksamkeit zu durchdringen und dabei die Rolle der einzelnen Heads richtig einzuordnen. Der Begriff Attention Head lässt zunächst vermuten, dass jede einzelne Einheit schon für komplexe Kontextanalysen oder Bedeutungserkennung verantwortlich ist. Das stimmt jedoch nicht. Jeder einzelne Attention Head ist eher „dumm“ oder simpel in seinem Verhalten. Er sucht nach bestimmten Mustern oder Aspekten in den Sequenzen, die als Eingaben verarbeitet werden.

Das Ziel ist nicht, eine komplexe semantische Repräsentation in einem einzigen Schritt zu erzeugen, sondern eher, einfache Beziehungen oder Ähnlichkeiten zwischen Begriffen herzustellen. Die Intelligenz entsteht erst durch die Kombination vieler dieser Heads und ihrer geschichteten Anordnung in tiefen Netzwerken. Die Grundidee der Aufmerksamkeit basiert auf der Projektion von Eingabe-Token in verschiedene Räume: Query, Key und Value. Diese Projektionen wandeln Eingabedaten in Vektoren um, die unterschiedliche Eigenschaften haben. Queries repräsentieren, wonach ein bestimmter Token „sucht“.

Keys beschreiben, was ein Token „ist“, und Values beinhalten die Informationen, die letztlich kombiniert werden. Die Dot-Produkte zwischen Queries und Keys bestimmen, wie stark ein Token auf einen anderen „achtet“. Diese einfachen Rechenoperationen entsprechen einer Art „Mustervergleich“ in einem gelernten, möglicherweise abstrakten Raum. Ein attention head könnte beispielsweise darauf trainiert sein, Artikel („the“, „a“, „an“) mit den dazugehörigen Substantiven abzugleichen. Wenn man an den Satz „the fat cat sat on the mat“ denkt, würde ein solcher Head die Instanz von „cat“ mit dem direkt davor stehenden „the“ verbinden.

Die Stärke der Verbindung ergibt sich dann aus der Ähnlichkeit der Projektionen in Query- und Key-Raum, die durch den Dot-Produkt-Mechanismus festgestellt wird. Dabei müssen sowohl die Bedeutung als auch die Position der Tokens berücksichtigt werden, denn die Reihenfolge spielt für den korrekten Kontext eine Rolle. Was an diesem Mechanismus besonders elegant ist, dass die Query- und Key-Räume oft recht „arm“ oder reduziert ausgelegt sein können. Sie müssen nicht die volle Komplexität und Vielfalt der ursprünglichen Eingabe widerspiegeln, sondern nur genügend Details enthalten, um die relevanten Muster zu erkennen. Die Werte, die danach kombiniert werden, sind dagegen reichhaltiger und enthalten mehr Informationen.

So kann ein relativ einfach gestrickter Attention Head effektiv entscheiden, welche anderen Tokens beim Verstehen eines bestimmten Wortes oder Basiselements wichtig sind. Diese Einfachheit erklärt auch, warum einzelne Attention Heads häufig inkonsistente oder sogar scheinbar „dumme“ Muster zeigen. Zum Beispiel kann ein Head, der auf Artikel-Substantiv-Beziehungen trainiert wurde, im Falle von zwei Artikeln vor einem Substantiv Schwierigkeiten haben, den exakt richtigen Artikel zu abonnieren – es gibt keine allgemeine Logik, die automatisiert garantieren könnte, den am nächsten stehenden Artikel zu beachten. Solche Details erfordern die Überlagerung vieler solcher Heads und die zusätzliche Verarbeitung in den darauf aufbauenden Schichten, um das Gesamtbild zu formen. Mehrere Attention Heads können gleichzeitig verschiedene Aspekte von Daten erfassen.

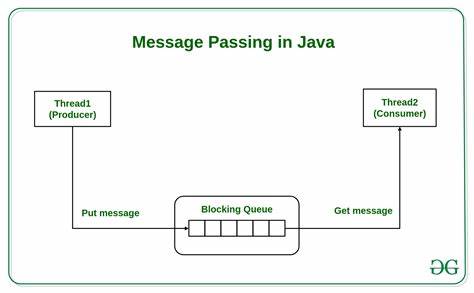

Während ein Head vielleicht Fokus auf Syntax oder Grammatik legt, analysiert ein anderer Kopf semantische Zusammenhänge oder Positionsinformationen. Diese parallele Struktur erhöht nicht nur die Bandbreite der erfassten Informationen, sondern ermöglicht auch, komplexe Muster durch Kombination simpler Einblicke zu modellieren. Die Idee der Schichtung vervollständigt das Bild. Transformer-Modelle bestehen aus vielen hintereinandergeschalteten Schichten von Multi-Head Attention und nachfolgenden Verarbeitungseinheiten. Die Ausgabe einer Schicht – also die neu erzeugten Kontextvektoren – werden als Eingabe der nächsten Schicht benutzt.

Ähnlich wie bei neuronalen Netzwerken zur Bilderkennung, wo jede zusätzliche Schicht abstraktere Merkmale erkennt, reichern Schichten in Sprachmodellen die Repräsentationen von Tokens mit zunehmend komplexeren Informationen an. Dadurch ist es möglich, dass ein einzelner Head in einer frühen Schicht beispielsweise nur פשוט sehr grundlegende syntaktische Beziehungen erfasst. Eine spätere Schicht dagegen kann basierend auf diesen Grundlagen semantische Nuancen oder gar kontextübergreifende Bedeutungen generieren. Durch die Tiefe des Netzwerks entsteht eine Hierarchie an Erkenntnissen – die Basisarbeit von simplen Attention Heads bildet damit den Grundstein für eine differenzierte Sprachverarbeitung. Ein weiterer großer Vorteil des Self-Attention-Mechanismus im Vergleich zu klassischen recurrent neural networks (RNNs) mit Encoder-Decoder-Struktur liegt im Umgang mit der Eingabelänge.

Klassische RNN-Modelle litten unter einem Flaschenhals, weil sie für jede Eingabesequenz einen fixen Vektor als versteckten Zustand erzeugten. Längere Texte konnten so nur schwieriger oder gar nicht ausreichend abgebildet werden, da alle relevanten Informationen komprimiert werden mussten. Transformers eliminieren dieses Problem, indem sie für jeden Token eine eigene Kontext-Repräsentation durch Aufmerksamkeit berechnen. So variiert die Gesamtgröße des „versteckten Zustands“ proportional zur Länge des Inputs. Das bedeutet, dass selbst sehr lange Texte präzise und differenziert modelliert werden können, ohne Gefahr eines Informationsverlustes durch feste Vektorlängen.

Die Lernfähigkeiten dieser Heads und Schichten resultieren aus der Kombination der Architekturbasis mit Trainingsverfahren wie Gradientenabstieg über riesige Textkorpora. In der Praxis lernen die Attention Heads, auf komplizierteste und oft schwer nachvollziehbare Weise Kontexte zu erfassen, die unseren menschlichen Sprachregeln nicht unbedingt entsprechen. Von außen erscheinen ihre Verhaltensweisen häufig „alien“ oder unintuitiv, doch die Effektivität ist unbestritten. Modellieren lassen sich diese Prozesse jedoch besser, wenn man die einzelnen Aufmerksamkeitseinheiten als einfache Mustererkennungen begreift. Heute ist bekannt, dass viele erfolgreiche LLMs wie GPT-3 oder GPT-4 über Dutzende bis Hunderte von Transformerschichten verfügen – mit jeweils vielen Attention Heads.

Die vernetzte Arbeit all dieser Komponenten ermöglicht es den Modellen, komplexe Aufgaben der Sprachverarbeitung mit beeindruckender Genauigkeit zu meistern, von Übersetzungen über Textgenerierung bis hin zu Frage-Antwort-Systemen. Zusammenfassend lässt sich festhalten, dass die beachtlichen sprachlichen Leistungen moderner LLMs nicht auf einzelne, komplexe Attention Heads zurückzuführen sind, sondern auf das Zusammenspiel vieler simpler Heads, die über Schichten hinweg kombiniert werden. Dieses Prinzip der Einfachheit, gepaart mit Tiefe und Parallelität, macht die Transformer-Architektur zu einem der bedeutendsten Durchbrüche im Bereich der Künstlichen Intelligenz und bietet auch weiterhin viel Inspiration für die Weiterentwicklung künstlicher neuronaler Netzwerke. Die Erkenntnis, dass einzelne Attention Heads „dumm“ sind, ist kein Nachteil – im Gegenteil. Sie markiert einen Schlüssel, um die Arbeitsweise von LLMs besser zu verstehen und ein tieferes Verständnis für die Architektur zu entwickeln.

Für Entwickler, Forschende und Interessierte eröffnet dieses Wissen neue Perspektiven, um Modelle zu optimieren, zu erklären und gezielter anzuwenden. So wird der Prozess des „Verstehens“ von Sprachmodellen selbst zum Teil der zukünftigen Innovationen in der KI-Forschung.