Der Bereich der Drohnentechnologie hat in den letzten Jahren enorme Fortschritte gemacht, doch erst 2023 wurde ein echter Durchbruch im Bereich des autonomen FPV-Drohnenrennens erzielt. FPV – die Abkürzung für First-Person View – beschreibt ein Rennen, in dem Pilotinnen und Piloten ihre Drohne durch eine Videobrille aus der Sicht des fliegenden Geräts steuern. Dabei sind außergewöhnliche Flugmanöver, hohe Geschwindigkeit und extreme Präzision gefragt. Genau an dieser Stelle setzt die Innovation anhand von Deep Reinforcement Learning (Deep RL) an, welche die autonome Steuerung perfektioniert und den menschlichen Champions ebenbürtig ist – und teilweise sogar überlegen. Im Frühjahr 2023 stellten Forschende um Elia Kaufmann und weitere Mitglieder der Universität Zürich in Zusammenarbeit mit Intel und führenden KI-Forschungsinstitutionen das System „Swift“ vor.

Dabei handelt es sich um eine autonome Drohne, die allein mithilfe von Onboard-Sensoren und einem neuronalen Netzwerk Rennkurse absolviert und in realen Wettkämpfen gegen menschliche Weltmeister antrat. Die spannende Tatsache daran: Swift konnte zahlreiche Rennen gewinnen und sogar die bislang schnellste jemals erzielte Rennzeit aufstellen. Dies symbolisiert nicht nur einen technologischen Meilenstein, sondern auch eine neue Ära der mobilen Robotik und künstlichen Intelligenz. FPV-Drohnenrennen sind extrem anspruchsvoll. Die Fluggeräte – meist Quadcopter – erreichen Geschwindigkeiten von über 100 Kilometern pro Stunde.

Die Piloten navigieren durch komplexe Strecken mit mehreren Toren in drei Dimensionen und setzen dabei die Drohne oft an deren physikalische Grenzen ein. Für einen autonomen Agenten bedeuten diese Herausforderungen nicht nur schnell agieren zu müssen, sondern auch präzise Navigation und Lagebestimmung allein durch Sensor- und Kameradaten, ohne externe Infrastruktur wie Motion-Capture-Systeme zu nutzen. Swift bewältigt diese Einschränkungen mit einer Kombination aus lernbasierten Modellen und klassischen Algorithmen. Die Technologie hinter Swift beruht auf zwei zentralen Komponenten. Zunächst gibt es ein Wahrnehmungssystem, welches visuelle und inertiale Signale der Drohne in eine kompakte und für die Kontrolle relevante Repräsentation übersetzt.

Dabei nutzt das System eine visuell-inertiale Odometrie (VIO), unterstützt von einem neuronalen Netzwerk zur Erkennung der Rennstreckentore. Die so gewonnenen Informationen werden durch einen Kalman-Filter zu einer robusten Positions- und Geschwindigkeitsabschätzung zusammengeführt. Darauf aufbauend steuert ein feedforward neuronales Netz die Massen-normalisierte Schubkraft und Rotor-Drehzahlen. Das Kontrollnetzwerk wurde mittels model-free on-policy Deep RL in einer realistischen Simulation trainiert. Besonders hervorzuheben ist die raffinierte Strategie für den Übergang von Simulation zu Realität.

Während Trainingsmodelle oft unter Wirklichkeitsabweichungen leiden, konnten die Entwickler eine kleine Datenmenge von realen Flügen nutzen, um Störgrößen in Wahrnehmung und Dynamik empirisch zu erfassen. Gaussian Processes modellieren zufällige Abweichungen in der Positionsschätzung, während k-Nearest-Neighbor Regression deterministische Residuen der Dynamik beschreibt. Die simulierte Umgebung wurde dadurch an die reale Welt verblüffend genau angepasst. Anschließend erfolgte eine Feinabstimmung der Steuerungsrichtlinien, um eine optimale Performance unter realen Bedingungen zu gewährleisten. Im praxisnahen Test trat Swift gegen drei hochkarätige menschliche Piloten an: Alex Vanover, den Weltmeister der Drohnenrennliga 2019, Thomas Bitmatta, zweifacher International Open World Cup Champion, und Marvin Schaepper, Schweizer Meister mit drei Titeln.

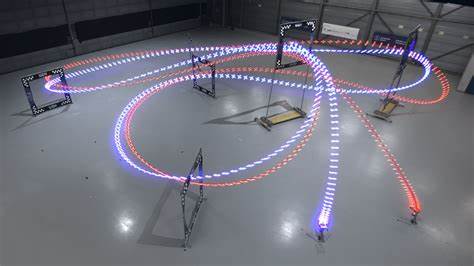

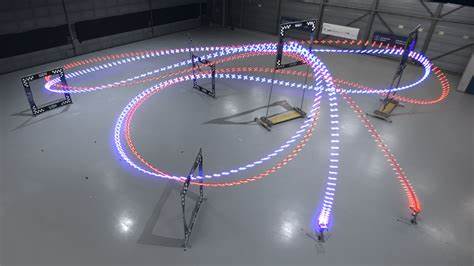

Die Rennstrecke war sorgfältig von FPV-Spezialisten entworfen, mit sieben markanten Toren auf einer mehrdimensionalen 30×30×8 Meter großen Arena. Die Drohnen waren identisch in Gewicht, Form und Antrieb, wodurch ein absolut faires Wettkampfsetting entstand. Nach einer Praxiswoche auf dem Kurs traten Piloten und Swift in mehreren direkten Duellen gegeneinander an. Das Ergebnis unterstrich Swifts Überlegenheit: Die autonome Drohne gewann die Mehrheit der Wettkämpfe gegen jeden der menschlichen Konkurrenten und stellte mit rund einer halben Sekunde Vorsprung die bisher schnellste offizielle Rennzeit auf. Besonders auffällig war Swifts Fähigkeit, in komplexen Manövern wie dem sogenannten Split-S – einem anspruchsvollen Halbloop durch zwei Tore – präzise und engere Kurvenflüge zu absolvieren als die Menschen, und dabei dennoch eine hohe Geschwindigkeit zu halten.

Dabei profitiert Swift von sehr kurzer Reaktionszeit (circa 40 Millisekunden) und dem Einsatz von Intertialsensorik, die menschlichen Piloten aufgrund ihrer körperlichen Distanz zum Fluggerät nicht zur Verfügung steht. Trotz aller Vorteile weist Swift auch Schwächen auf. Die visuelle Erkennung basiert auf Trainingsdaten mit vergleichsweise konstanten Lichtverhältnissen. Änderungen in Ambiente oder teils chaotische Umgebungen können die Gate-Erkennung erschweren und Fehler im Zustandsverständnis verursachen. Menschliche Piloten zeigen sich robuster gegenüber solchen Störungen und können sogar unfallbedingt fortfahren, was Swift derzeit noch nicht ermöglicht.

Dennoch deuten die Ergebnisse auf einen rasanten Fortschritt hin, der mit weiterem Training und diversifizierten Daten diesen Bereich bald überwinden wird. Die Forschung hinter Swift zeigt, wie erfolgreich die Verbindung von Deep RL mit Daten-getriebenen Korrekturmodellen in der physischen Welt funktionieren kann. Während frühere KI-Erfolge vor allem in Simulationen oder statischen Brettspielen erzielt wurden, demonstriert Swift eindrucksvoll, wie reale Herausforderungen mit hochdynamischen, komplexen physikalischen Systemen gemeistert werden. Dies birgt riesiges Potenzial für Anwendungen außerhalb des Drohnensports, darunter autonome Transportsysteme, unbemannte Fahrzeuge und Roboter in Industrie oder Katastropheneinsätzen. Ein weiterer bemerkenswerter Aspekt sind die Trainingsmethoden.

Das Team setzte auf Proximal Policy Optimization, eine moderne Methode der Verstärkungslernalgorithmen, um die Steuerungspolitik im Simulationsmodell zu verbessern. Der Trainingsprozess dauerte lediglich 50 Minuten auf moderner Hardware und basiert auf Belohnungen, die nicht nur Fortschritt und Toranflug honorierten, sondern auch eine Wahrnehmungsstrategie, die das Sichtfeld stets auf das nächste Gate ausrichtet. Dies sichert eine hohe Genauigkeit und stabile Ausgangsdaten für die Drehbewegungen. Die verwendete Hardwarespezifikation entspricht professionellem Standard im Drohnenrennsport, was die Validität der Vergleiche stärkt. Beide Fluggeräte wurden auf der gleichen Plattform aufgebaut, mit leistungsstarkem NVIDIA Jetson TX2 für die Datenverarbeitung sowie Betaflight-PID-Regler für die Motorsteuerung.

Dies schließt Manipulationen durch externe Infrastruktur aus und stellt sicher, dass Swift sich allein auf onboard-Sensorik und seinen Algorithmus stützt – ähnlich wie menschliche Piloten. Das humanisierte Feedback der Kontrahenten zeigt beeindruckende Impressionen. Alex Vanover betont die Schwierigkeit des Split-S-Manövers und die hohe physische Präsenz von Swift im Rennen. Thomas Bitmatta beschreibt den Wandel, den autonome Systeme in seinem Sport wecken, wobei er zugleich menschliches Konkurrenzdenken und Respekt gegenüber der Maschinenleistung verspürt. Marvin Schaepper thematisiert die Ausdauer des Systems, das niemals ermüdet, und das besondere Gefühl, gegen eine Maschine zu fliegen.

Dieses Zusammenspiel von menschlichem Erleben und technologischem Fortschritt zeichnet die moderne Drohnenrenaissance aus. In der wissenschaftlichen und technologischen Community wird die Arbeit als wegweisend anerkannt, insbesondere wegen ihres integrativen Konzepts zwischen Wahrnehmungsgenauigkeit, realitätsnaher Simulation und Deep RL. Die sorgfältige Modellentwicklung, Datenerhebung und iterative Verfeinerung haben es ermöglicht, eine derart anspruchsvolle Aufgabe auf einem Niveau zu lösen, das bisher als unerreichbar galt. Die Zukunft des autonomen Drohnenrennens zeigt sich damit hell erleuchtet. Mit robusteren Wahrnehmungssystemen und stärkerer Generalisierung können autonome Agenten kommende Wettbewerbe dominieren und möglicherweise als Trainingspartner für menschliche Piloten zum Einsatz kommen.

Auch beim Einsatz in weiteren Bereichen, etwa in Lieferdrohnen, Such- und Rettungseinsätzen oder Inspektion von Infrastruktur, versprechen lernbasierte Methoden einen deutlichen Innovationssprung. Insgesamt symbolisiert der Erfolg der Swift-Drohne mit Deep Reinforcement Learning den Substanzbeweis, dass künstliche Intelligenz und robotische Mobilität nicht nur im Labor, sondern im dynamischen realen Wettbewerb konkurrenzfähige und mit Menschen mithaltende Leistungen bringen kann. Der Fortschritt öffnet die Tür zu zahlreichen Anwendungen, in denen Echtzeitentscheidung, Robustheit und Präzision gleichermaßen gefragt sind – eine neue Ära der intelligenten mobilen Systeme beginnt.