Im Mai 2025 gelang es einem Team von Sicherheitsexperten und Programmierern, den Kernel-CTF-Wettbewerb von Google mit einer innovativen Optimierung zu schlagen. Der Schlüssel zum Erfolg lag in der Nutzung der AVX512 IFMA (Integer Fused Multiply–Add) Erweiterungen, welche die zuvor langwierige Proof-of-Work-Berechnung drastisch beschleunigten. Das ehrgeizige Ziel war es, den Proof of Work (PoW) so schnell wie möglich zu lösen, um bei der Submission eines komplexen Exploits an erster Stelle zu stehen und damit den exklusiven Preis von 51.000 US-Dollar zu erhalten. Dieses Ziel erforderte nicht nur das Finden und Ausnutzen einer schwerwiegenden Sicherheitslücke in Linux, sondern auch eine tiefgehende Optimierung des kryptographischen VDF (Verifiable Delay Function), der obligatorisch für den Serverzugang war.

Der PoW wurde dadurch begründet, dass Google den Teilnehmern nur eine begrenzte Anzahl von Einsendungen erlaubte, um die Auszahlung der Prämien zu kontrollieren. Beim Start eines neuen Zeitfensters mussten sich alle Teams umgehend mit dem Challenge-Server verbinden und die Proof-of-Work-Berechnung lösen. Diese Berechnung nahm bei traditionellen Implementierungen mehrere Sekunden in Anspruch, was den Geschwindigkeitserfolg oftmals zu einem Lotteriespiel machte. Die genaue Einhaltung der Zeit war entscheidend, denn nur das Team, das den Flag zuerst korrekt übermittelte, erhielt den Preis – alle nachfolgenden Einsendungen wurden als Duplikate ignoriert. Die Herausforderung bestand zudem darin, dass der PoW auf einer sloth VDF beruht, die absichtlich eine seriell berechenbare Funktion darstellt.

Das bedeutet, dass man diese nur Schritt für Schritt ausführen kann, ohne sie sinnvoll parallelisieren zu können. Die Rechenzeit lässt sich folglich nicht durch Mehrkernprozessoren oder GPUs beliebig reduzieren, was herkömmliche Optimierungsmethoden einschränkte. Die mathematische Kernoperation war das quadrieren einer 1280-Bit großen Zahl modulo einer Mersenne-Primzahl von der Form 2 hoch 1279 minus 1. Das Rechnen mit so großen Zahlen ist aufgrund der nötigen Multiplikationen besonders aufwändig. Der Anfangspunkt der Optimierung war eine Verbesserung der modularen Reduktion.

Da die Modulo-Operation mit einer Mersennezahl erfolgte, konnte man sie durch bitweise Operationen ersetzen, die schneller ausgeführt werden als allgemeine Divisionen. Die Entwickler wählten zudem eine C++-Implementierung, um die den Python-Referenzcode aus GMP-Wrappern (GNU Multiprecision Library) abzulösen und Foreign Function Interface (FFI)-Overhead zu vermeiden. Erste Tests zeigten, dass man so die Laufzeit von mehreren Sekunden auf unter 2 Sekunden auf modernen CPUs senken konnte, was bereits eine signifikante Verbesserung gegenüber der ursprünglichen Implementierung darstellte. Doch der größte Leistungssprung kam mit dem Einsatz von AVX512IFMA. Diese spezielle Intel-Prozessorerweiterung, die erstmals 2016 eingeführt wurde, ermöglicht Multiplikationen und Additionen von 52-Bit Zahlen in einem Vektorregister mit einer hohen Anzahl von parallelen Instruktionen.

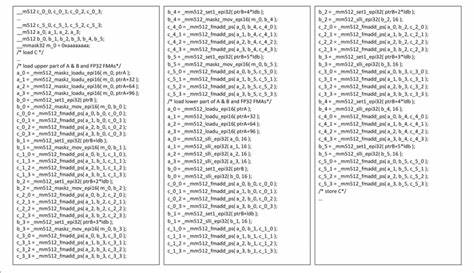

Diese Befehle können mehrere 52-Bit-Teile simultan multiplizieren und aufsummieren, was sich hervorragend für große Ganzzahlarithmetik eignet. Die Herausforderung war jedoch, diesen Serialisierungsengpass beim VDF zu umgehen und den Code so umzuschreiben, dass er diese Vektoroperationen effektiv nutzte. Dabei war es nötig vom üblichen 64-Bit „Limb“-Format auf ein zusammenhängendes Array mit 52-Bit-Limbs umzusteigen, das Fourier-ähnliche Strukturen ermöglicht. Es wurde ein intelligenter Algorithmus entwickelt, der die Multiplikation der großen Zahlen als Summe von zwei Termen implementierte: quadratische Terme und doppelte Summen. Durch geschicktes Verwenden von Sliding Windows konnten die nötigen Zwischensummen optimiert werden, um möglichst wenige unnötige Multiplikationen durchzuführen.

Die Berechnung wurde in 512-Bit Vektorregistern abgelegt und mit Maskierungen versehen, die gezielte Summanden rein- oder rausnahmen, um die Belastung des Prozessors möglichst gleichmäßig zu gestalten. Der Code enthielt zudem ausgeklügelte Inline-Assembler-Komponenten, um den Einsatz von AVX512 Instruktionen maximal zu verbessern und Registerallokationsprobleme zu umgehen. Das Resultat war eine Verkürzung der Proof-of-Work-Berechnung auf zirka 0,2 Sekunden auf einem Ryzen 9 5950X – also fast eine zwanzigfache Beschleunigung gegenüber der Referenzimplementierung. Sogar ein möglicher Teil der FPGA-basierten Optimierungen der Konkurrenz konnte so erreicht oder übertroffen werden, ohne externe Hardware einsetzen zu müssen. Mit der beschleunigten PoW-Berechnung konnten die Exploiter sogar das Booten der virtuellen Maschine (VM) und die Laufzeit des eigentlichen Exploits reduzieren und optimieren.

Die Kommunikation und Einreichung des Flags wurde ebenfalls akribisch vorbereitet, um Latenzen zu verringern. Schlüsselfigur war hier ein insgesamt orchestriertes Team, welches nicht nur die technische Herausforderung meisterte, sondern auch strategisch die besten geografischen Server für eine minimale Netzlaufzeit auswählte. Noch am selben Tag nach der Optimierung gelang es dem Team, die Challenge in rekordverdächtigen 3,6 Sekunden zu lösen – den schnellsten jemals dokumentierten kernelCTF-Slotgewinn. Die Leistung wurde von den Herausgebern des Wettbewerbs bestätigt, was zur Auszahlung der Gesamtpreisgelder von 51.000 US-Dollar führte.

Dabei handelte es sich um Basisprämien, zusätzliche Boni für Exploit-Stabilität und die Entdeckung eines Zero-Day-Fehlers im Linux-Kernel. Die überraschend schnelle Lösung sorgte in Fachkreisen für Aufsehen. Organisatoren gaben später bekannt, dass der Proof of Work in künftigen Editionen nicht mehr eingesetzt wird, um das Feld zugänglicher zu machen und den Vorteil von spezialisierten Optimierungen oder FPGA-Einsatz zu begrenzen. Doch der Beitrag des Teams zeigt exemplarisch, wie tiefe Kenntnisse in Hardwarenähe, komplexe mathematische Algorithmen und Programmiersprachenkenntnisse kombiniert werden müssen, um in solchen Wettbewerben ganz vorne mitzuspielen. Wichtig bei der Analyse ist zu verstehen, wie sich moderne Prozessorfunktionen wie AVX512 im Bereich der Kryptographie und Big Integer Arithmetic auswirken.

Der Multiplikationsdurchsatz wird durch Instruktionen optimiert, die eine ständige parallele Ausführung mehrerer Teiloperationen garantieren und so Bottlenecks durch Latenzen verringern. Die Vorbereitung der Datenstrukturen, um dieses Potenzial auszuschöpfen, ist eine Kunst für sich. Der Erfolg des Teams ist auch eine Eloge an bewährten Open-Source-Bibliotheken wie GMP und einer pragmatischen Kombination aus hochoptimiertem Assembler und C++. Dadurch wurde die Rechenzeit von einem unpraktikablen Python-Skript hin zu einem hochskalierten Optimierungswerkzeug transformiert, welches auf neuesten CPUs brillante Leistung zeigte. Sozehn Jahre Entwicklungstrends einerseits und die wachsende Verfügbarkeit von Hardwareerweiterungen für Spezialzwecke andererseits flossen in diese Lösung ein.

Die Erfahrung zeigt, dass professionelle Competitive Programming-Techniken und Tools aus dem Computer-Algebra-Bereich unmittelbar auch praktische Vorteile in der Cybersecurity bieten können. Der KernelCTF-Erfolg steht außerdem als Beispiel für einen innovativen Ansatz, bei dem mehrere Teammitglieder sich auf jeweils unterschiedliche Komponenten spezialisiert haben: Von der Entdeckung der Sicherheitslücke, über den Exploit, bis hin zum Optimieren der Proof-of-Work-Berechnung. Dieses multidisziplinäre Arbeiten brachte letztendlich den verdienten Gewinn. Abschließend ist zu erwähnen, dass der Verfasser der Optimierung sich auch künftig mit VDFs beschäftigt und nach noch widerstandsfähigeren Funktionen sucht, die nicht so einfach assembler- oder hardwareseitig optimiert werden können. So könnte man in der Zukunft für mehr Fairness und Chancengleichheit in derartigen Herausforderungen sorgen.

Dieser Fall zeigt eindrucksvoll, wie modernste Softwareoptimierung, Hardwarekenntnis und Kryptographie ineinandergreifen, um im Wettbewerb um Sicherheitsexploits und deren Belohnungen neue Maßstäbe zu setzen. Für Entwickler und Sicherheitsspezialisten liefert er wertvolle Einblicke, wie wichtig tiefgehendes Verständnis von Prozessorarchitekturen und low-level Optimierungen für räumlichen und zeitlichen Vorsprung im Cybersicherheitswettbewerb ist.