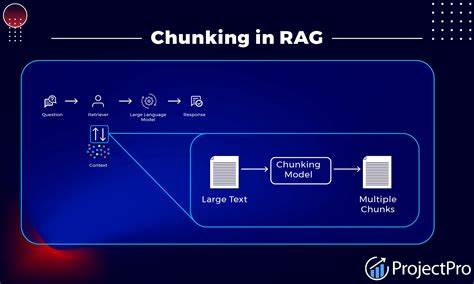

Retrieval-Augmented Generation (RAG) hat sich als eine der revolutionärsten Technologien im Bereich der Künstlichen Intelligenz etabliert, indem es die Vorteile von großen Sprachmodellen und Informationsretrieval-Systemen kombiniert. Ein häufig übersehener, aber zentraler Aspekt im Aufbau und der Optimierung von RAG-Systemen ist die Anwendung der sogenannten Chunking-Strategien. Diese Strategie definiert, wie Informationen aus großen Dokumentenbeständen in handhabbare, relevante Teile aufgeteilt werden, die dann für die Antwortgenerierung genutzt werden können. Doch wie kann man die Effektivität unterschiedlicher Chunking-Methoden messen und die beste Strategie auswählen? Dies ist eine Frage, die besonders Entwickler und Datenwissenschaftler beschäftigt, die RAG-Systeme implementieren oder optimieren wollen.Das Kernproblem bei der Evaluierung von Chunking-Strategien liegt darin, dass es keine universelle Lösung gibt, die für alle Anwendungsfälle gleich gut funktioniert.

Die Datenstrukturen, Anwendungsfälle und Anforderungen variieren stark, sodass eine Strategie in einem Projekt herausragende Ergebnisse liefern kann, während sie in einem anderen versagt. Beispielsweise kann ein System, das viele PowerPoint-Präsentationen und kurze Meeting-Transkripte verarbeitet, andere Anforderungen an die Größe und Art der Chunks stellen als eines, das umfangreiche Case-Study-PDFs analysiert.Ein effizientes Vorgehen zur Bewertung der Chunking-Methoden beginnt mit der Auswahl repräsentativer Datenproben. Gerade in produktiven Anwendungen können Datenvolumen in die Terabyte gehen, was die vollständige Analyse unpraktisch und kostspielig macht. Eine durchdachte Stichprobenstrategie vermeidet es, unnötige Kosten und Zeit in ausgedehnte Tests zu investieren.

Stratified Sampling, also eine repräsentative Auswahl aus jeder Datenkategorie, stellt sicher, dass das Verhalten der Chunking-Strategien im Hinblick auf alle Inhaltsarten kontrolliert geprüft werden kann.Der nächste wichtige Schritt ist die Erstellung eines adäquaten Fragensets, anhand dessen die Qualität der Informationsrückgewinnung und Antwortgenerierung gemessen werden kann. Hierbei empfiehlt es sich, sowohl menschliche Experten als auch leistungsstarke Sprachmodelle zu involvieren. Während menschliche Expert:innen die besten, maßgeschneiderten Fragen generieren können, bieten fortschrittliche Modelle wie gpt-4o-mini oder DeepSeek-R1-Distill-Qwen-32B eine praktische Alternative, vor allem dann, wenn nicht genügend Expertenressourcen zur Verfügung stehen. Die Qualität der Fragen ist entscheidend, da diese direkt die Aussagekraft der Evaluierung beeinflusst.

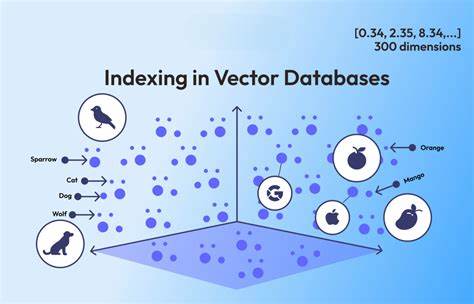

Für die eigentliche Bewertung des Chunking-Verfahrens wird im Anschluss eine Pipeline aufgesetzt, die sowohl die Chunkerstellung als auch die darauf aufbauende Informationsrückgewinnung und Antwortgenerierung umfasst. Ein bewährtes Framework hierfür ist RAGAS, welches verschiedene Metriken wie Relevanz der Antworten, Treue zur Quelle (Faithfulness), Präzision und Rückruf der genutzten Kontexte sowie die Korrektheit der Antworten misst. Die Kombination dieser Werte bietet eine umfassende Sicht auf die Effektivität der jeweiligen Chunking-Strategie.Die praktische Implementierung beginnt mit der automatisierten Aufteilung der Dokumente, gefolgt von deren Einbindung in einen Vektor-Datenbank-Client, zum Beispiel Chroma DB. Das systematische Durchfragen der Testfragen und das Generieren von Antworten durch das Sprachmodell vervollständigen die Evaluationspipeline.

Dabei sind neben der Genauigkeit vor allem auch Laufzeitmetriken entscheidend, da diese im produktiven Einsatz direkten Einfluss auf Nutzererfahrung und Betriebskosten haben.Die Ergebnisse werden anschließend mit Hilfe von Visualisierungen analysiert. Ein erster Überblick über die Gewinnerstrategie lassen sich durch eine Rangliste der Gesamtwerte gewinnen, die auf einer gewichteten Zusammenfassung der Metriken basiert. Dabei zeigen sich oft interessante Trade-offs. Beispielsweise kann eine Strategie bei der Antwortrelevanz überzeugen, gleichzeitig aber lange Antwortzeiten oder große Chunks produzieren, welche die Anwendungsperspektive erschweren.

Die Betrachtung der Chunk-Größen und -Verteilungen gibt wertvolle Hinweise, wie viel Kontext die Modelle jeweils verarbeiten müssen und wie viel potenzieller Informationsrauschen vorhanden ist.Eine weitere wichtige Analyseebene ist die Detailbetrachtung der einzelnen Metriken mittels Radar-Diagrammen. Dabei wird sichtbar, welche Qualitäten in einer Strategie besonders gut oder weniger gut ausgeprägt sind. Diese Erkenntnis ist unerlässlich, um Entscheidungen zu treffen, die auf den konkreten Anwendungsfall abgestimmt sind. In manchen Szenarien steht beispielsweise absolute Treue gegenüber den Originaldaten im Vordergrund, während in anderen die reine Relevanz für die Fragestellung Priorität hat.

Neben Qualität und Nutzwert darf auch die Performance nicht vernachlässigt werden. Die Verteilung der Verarbeitungszeiten zwischen Chunk-Erstellung, inhaltlicher Rückgewinnung und Antwortgenerierung beeinflussen maßgeblich, ob sich eine Strategie in Echtzeit-Anwendungen einsetzen lässt oder besser für Batch-Verarbeitung geeignet ist. Schnelle Algorithmen mit kleineren Chunks ermöglichen niedrigere Latenz, während komplexere semantische Verfahren zwar teils bessere inhaltliche Qualität liefern, jedoch zu höheren Kosten führen.Bei der Auswahl der finalen Chunking-Strategie empfiehlt es sich ebenfalls, mögliche Kombinationen oder hybride Ansätze zu prüfen. Beispielsweise kann eine rekursive Charakteraufteilung kombiniert mit einem semantischen Ansatz verwendet werden, um die Stärken beider Techniken zu vereinen.