Die Entwicklung Künstlicher Intelligenz (KI) schreitet in einem Tempo voran, das viele fasziniert und gleichzeitig vor Herausforderungen stellt. Zentral in dieser Diskussion steht die Frage, wie schnell Algorithmen die Fähigkeiten von KI-Systemen verbessern können. Dabei geht es nicht nur um technische Details, sondern auch um wirtschaftliche, ethische und wissenschaftliche Aspekte, die über die gesamte Branche hinweg Bedeutung haben. Die jüngsten Forschungen, wie die des Teams am University of Chicago XLab unter Leitung von Henry Josephson, liefern eine differenzierte Sichtweise auf die Faktoren, die das Fortschritttempo bestimmen, insbesondere das Zusammenspiel zwischen algorithmischem Fortschritt und der verfügbaren Rechenleistung. Algorithmusfortschritt als Treiber von KI-Fähigkeiten Algorithmen bilden das Herzstück jedes KI-Systems.

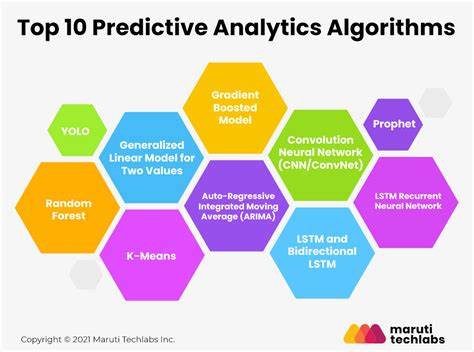

Sie legen fest, wie Modelle lernen, Informationen verarbeiten und Lösungen generieren. Im Laufe der letzten Jahre gab es mehrere signifikante algorithmische Innovationen, die große Sprünge bei der Leistungsfähigkeit ermöglicht haben. Die Transformer-Architektur, die 2017 eingeführt wurde, ist ein Paradebeispiel für solchen Durchbruch und hat die Landschaft der Sprachmodelle revolutioniert. Doch nicht alle algorithmischen Verbesserungen wirken gleich effizient – einige dieser Fortschritte entfalten ihren Nutzen bereits bei kleinen Modellen, andere sind erst bei großem Rechenaufwand sinnvoll einsetzbar. Diese Differenzierung wurde von Josephson und seinem Team genauer untersucht und führte zur Unterscheidung zwischen rechenleistungsunabhängigen („compute-independent“) und rechenleistungsabhängigen („compute-dependent“) Algorithmen.

Rechenleistungsunabhängige Algorithmen: Fortschritt ohne Gigantische Infrastruktur Algorithmen wie Layer Normalization, RoPE (Rotary Positional Embedding) und FlashAttention sind Beispiele für Weiterentwicklungen, die schon bei kleineren Modellen positive Effekte zeigen. Ihre Vorteile können auch Forscher oder Unternehmen mit begrenzten Ressourcen nutzen, was eine Demokratisierung des Fortschritts erlaubt und Innovationen in weniger wohlhabenden Regionen fördert. Das Experimentieren mit einem kleineren GPT-2-Modell (165 Millionen Parameter) zeigte, dass die Kombination solcher Algorithmen den Effekt hat, als hätte man die Rechnerkapazität um den Faktor 3,5 erhöht. Das bedeutet, dass solche Verbesserungen die Effizienz von Trainingsprozessen steigern und so schnellere Entwicklungen ermöglichen, ohne dass eine Ausweitung der Hardware nötig ist. Rechenleistungsabhängige Algorithmen: Die Schwergewichte des Fortschritts Viele der bahnbrechenden Fortschritte und enormen Leistungssteigerungen in der KI basieren jedoch auf Algorithmen, die große Rechenressourcen benötigen, um ihr Potenzial erst vollständig auszuschöpfen.

Die Transformer-Architektur selbst fällt in diese Kategorie und ebnete Wege für Leistungssteigerungen, die um das 10- bis 50-fache effizienter sind – allerdings nur, wenn sie mit massiven Mengen an Daten und Rechenzeit kombiniert wird. Eine wichtige Erkenntnis ist, dass solche Algorithmen sich bei kleineren Modellen oft nicht zeigen oder gar Performance-Einbußen verursachen. Erst durch Skalierung auf extrem große Modelle können ihre Stärken sichtbar werden. Multi-Query Attention ist ein praktisches Beispiel dafür, denn ihre Vorteile treten erst dann hervor, wenn die Modelle so groß werden, dass Speicherplatz und Rechenzeit ernsthaft zum Flaschenhals werden. Diese Dynamik unterstreicht, warum Zugang zu leistungsfähiger Hardware und ausreichend Rechenkapazität ein entscheidender Faktor für die Entdeckung und Validierung großer algorithmischer Fortschritte ist.

Forschungslabore mit beschränkten Ressourcen sind hier oft im Nachteil. Hardware und Algorithmus-Entwicklung: Ein symbiotisches Verhältnis Die Forschungen zeigen, dass Hardware und Algorithmen sich gegenseitig vorantreiben. Fortschritte in der Hardware eröffnen Möglichkeiten für neue algorithmische Paradigmen; umgekehrt erzeugen neuartige Algorithmen erhöhten Bedarf nach immer mehr Rechenleistung. Beispiele wie das chinesische DeepSeek-V3-Modell veranschaulichen diesen Umstand besonders gut. Trotz signifikanter Hardware-Beschränkungen durch Exportkontrollen konnten durch gezielte algorithmische Optimierungen beachtliche Resultate erzielt werden.

Hier wurden zum Beispiel Methoden wie Multi-headed Latent Attention, Mixture-of-Experts-Architekturen und Mixed-Precision Training eingesetzt, um mit einer Hardware-Grenze von weniger als 3 Millionen GPU-Stunden nahe an die Leistungsfähigkeit eines deutlich umfangreicheren LLaMA-Modells heranzukommen, das über 30 Millionen GPU-Stunden beansprucht. Das veranschaulicht, wie algorithmische Innovationen selbst unter Restriktionen relevant bleiben, wobei der Zugang zu großem Compute den größten Vorteil bringt. Die Bedeutung der Entdeckungsrate großer algorithmischer Innovationen Neben der Frage nach der Skalierbarkeit von Algorithmen spielt auch eine Rolle, wie schnell neue Ansätze überhaupt entdeckt werden können. Die Forschung legt nahe, dass die Entdeckung wirklich bahnbrechender, rechenleistungsabhängiger Innovationen rar und mit erheblichem Aufwand verbunden ist. Das bedeutet, dass selbst bei genügend Hardware die Geschwindigkeit, mit der neue Ideen validiert und in praktische Anwendungen übersetzt werden, ein Engpass sein kann.

Zudem ist die Grenzziehung zwischen klein- und großskaligen Experimenten fließend geworden. Labore, die früher als klein galten, arbeiten heute durchaus mit Hunderten von Hochleistungs-GPUs und können so rechenintensive Ansätze zumindest teilweise testen. Das hilft, einige der großen algorithmischen Durchbrüche ohne dauerhafte Extremeinsätze zu identifizieren. Dennoch wird die Forschung dominiert von Einrichtungen, die über entsprechende Ressourcen verfügen, was den Mechanismus einer schnelleren technologischen Entwicklung in bestimmten Zentren fördert. Das führt zu einer Konzentration, die wiederum politische und ethische Fragen über Fairness und Regulierung aufwirft.

Regulatorische und ethische Implikationen Die Erkenntnis, dass große algorithmische Fortschritte häufig rechenleistungsabhängig sind, hat direkte Konsequenzen für die Steuerung und Kontrolle von KI-Entwicklungen. Hardware-Kontrollen, wie sie etwa durch Exportbeschränkungen erzwungen werden, können die Geschwindigkeit großer Sprünge bremsen, aber nicht vollständig verhindern, da Fortschritte bei rechenleistungsunabhängigen Algorithmen weitergehen. Dies macht Regulierungen komplex, da Fortschritte möglicherweise unterhalb der erwarteten Rechenleistungsgrenzen stattfinden können. Noch komplizierter wird es durch sogenannte Testzeit-Optimierungen, bei denen Modelle zum Zeitpunkt der Anwendung noch effizienter gemacht werden können, ohne dass im Vorfeld massiver Rechenaufwand betrieben wurde. Vor diesem Hintergrund ist ein differenziertes Verständnis der Mechanismen hinter algorithmischen Verbesserungen essenziell, um belastbare Vorhersagen zur KI-Entwicklung machen zu können und sinnvolle politische Maßnahmen zu gestalten.

Einschränkungen und zukünftige Forschungsbereiche Die bisherigen Untersuchungen legen nahe, dass ein umfassenderes Bild nur durch weitere Forschung über verschiedene Dimensionen möglich ist. Zum Beispiel wurde der Fokus stark auf das Pretraining großer Modelle gelegt. Methoden wie Fine-Tuning, Reinforcement Learning mit menschlichem Feedback (RLHF) oder Inferenzzeit-Techniken wurden bisher kaum berücksichtigt, obwohl sie wichtige Rollen spielen. Darüber hinaus ist der Einfluss von Datenqualität und -zusammensetzung auf algorithmische Entwicklungen ein Bereich, der noch vertieft erforscht werden sollte. Schließlich variieren die Dynamiken in anderen Anwendungsfeldern wie Computer Vision oder der Bioinformatik womöglich erheblich.

Fazit: Ein komplexes Zusammenspiel von Innovation und Ressourcen Algorithmische Fortschritte sind ein zentraler Motor für die rasante Entwicklung der KI-Fähigkeiten. Während einzelne Verbesserungen bereits bei kleinen Modellen Wirkung zeigen, sind die transformierenden Innovationen meist an großen Rechenaufwand gekoppelt. Der Zugang zu erheblicher Rechenleistung ist somit nicht nur Hürde, sondern auch Hebel. Der Weg zu immer leistungsfähigeren KI-Systemen hängt entscheidend davon ab, wie schnell und effizient Forschergruppen mit ausreichender Hardware neue algorithmische Durchbrüche finden und validieren können. Diese Erkenntnis hat bedeutende Folgen für die Zukunft der KI-Forschung und die Gestaltung von Regulierungen.

Um die Entwicklung realistisch zu prognostizieren und sinnvoll zu steuern, bedarf es deshalb eines tiefgehenden Verständnisses der feinen Balance zwischen Hardwarekapazitäten, algorithmischem Fortschritt und den organisatorischen Rahmenbedingungen, unter denen diese Innovationen entstehen. Die Zukunft der KI steckt in diesem vielschichtigen Geflecht, das Forscher, Entwickler, Politiker und Gesellschaft gleichermaßen fordert.