Im Zeitalter großer Datenmengen und komplexer Systeme gewinnt die Echtzeit-Datenverarbeitung zunehmend an Bedeutung. Unternehmen stehen vor der Herausforderung, Daten sofort und effizient zu verarbeiten, um zeitnahe Erkenntnisse zu gewinnen und ihre Geschäftsprozesse dynamisch anzupassen. Eine zentrale Rolle spielen hierbei Technologien wie Apache Kafka für skalierbares Event-Streaming und ClickHouse als schnelle spaltenbasierte Analysedatenbank. Doch der direkte und fehlerfreie Transport von Events aus Kafka in ClickHouse erfordert spezialisierte Werkzeuge, die nicht nur transformieren, sondern auch Daten bereinigen und veredeln. Genau an dieser Stelle kommt GlassFlow ins Spiel – eine Open-Source-ETL-Lösung, die mit ihren Funktionen zur Echtzeit-Deduplizierung und temporalen Joins eine effiziente und zuverlässige Datenpipeline zwischen Kafka und ClickHouse bietet.

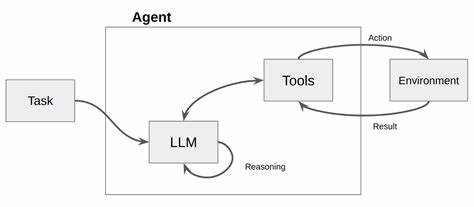

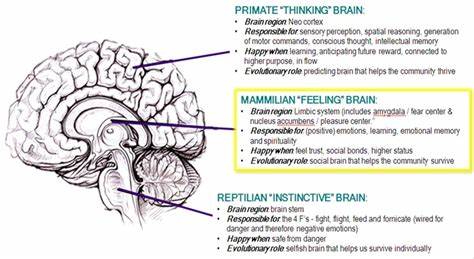

GlassFlow ist darauf ausgelegt, die Komplexität moderner Streaming-Workflows zu bewältigen. Durch eine native Integration beider Technologien erlaubt die Plattform nicht nur eine kontinuierliche Übertragung von Kafka-Nachrichten, sondern sorgt auch dafür, dass redundante oder doppelt erfasste Daten erkannt und entfernt werden. Die deduplizierten Daten ermöglichen präzise Analysen und verhindern Verzerrungen in Berichten oder Algorithmen. Zudem unterstützt GlassFlow temporale Joins – ein mächtiges Feature, das Daten aus verschiedenen Kafka-Quellen mit Bezug auf zeitliche Aspekte zusammenführt. Dies ist besonders wichtig, wenn Daten aus mehreren Streams kombiniert werden sollen, deren Ereignisse aber leicht versetzt eintreffen können.

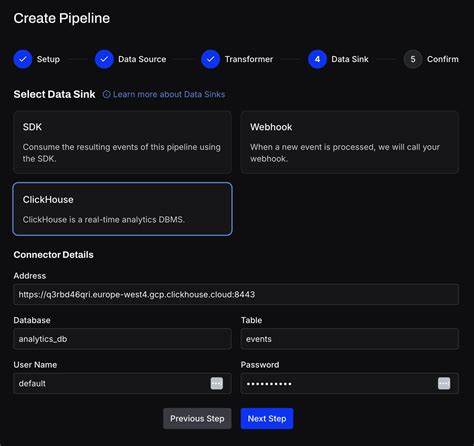

Die Einrichtung von GlassFlow ist bewusst nutzerfreundlich gehalten. Über ein Docker-basiertes Deployment lassen sich die Komponenten leicht lokal starten, was die Entwicklung und das Testing stark vereinfacht. Die Weboberfläche von GlassFlow bietet ein intuitives Interface zur Konfiguration der Datenpipelines, sodass auch Nutzer ohne tiefe Programmierkenntnisse schnell Arbeitsabläufe einrichten und überwachen können. Dies spart wertvolle Zeit und reduziert die Komplexität bei der Verwaltung der Streaming-Prozesse. Auf technischer Ebene ist GlassFlow in einer Kombination aus Go und TypeScript geschrieben, was eine robuste Backend-Architektur mit einer benutzerfreundlichen UI vereint.

Die Performance des Tools wurde zudem in umfangreichen Lasttests geprüft, was für Zuverlässigkeit und Skalierbarkeit in Produktionsumgebungen spricht. Durch die Open-Source-Natur des Projekts können Entwickler die Plattform flexibel an eigene Anforderungen anpassen und erweitern. GlassFlow hat sich als besonders nützlich für Branchen etabliert, die auf Echtzeitdaten angewiesen sind. Beispielsweise ermöglicht es Finanzdienstleistern, Börsendaten mit maximaler Präzision zu verarbeiten, indem Dubletten eliminiert werden und verschiedene Datenströme für tiefere Einblicke verbunden werden. Ebenso profitieren E-Commerce-Unternehmen von GlassFlow, indem Kundendaten aus verschiedenen Quellen zusammengeführt und konsolidiert werden, um personalisierte Empfehlungen zu erzeugen.

Darüber hinaus unterstützt das Tool IoT-Anwendungen mit vielen Sensoren, die ständig Daten senden, und garantiert dabei eine effiziente und korrekte Datenaggregation. Die Dokumentation von GlassFlow ist detailliert und übersichtlich auf der offiziellen Webseite verfügbar. Hier finden Nutzer umfassende Anleitungen zur Installation, Pipeline-Konfiguration und zum Aufbau von Joins und Deduplizierungsregeln. Darüber hinaus wird aktiver Support durch eine lebendige Community auf GitHub und Slack angeboten. Für Unternehmen, die professionelle Hilfe benötigen, existieren ebenfalls Supportmöglichkeiten per E-Mail.

Ein weiterer großer Vorteil von GlassFlow ist die konsequente Ausrichtung auf moderne DevOps-Prinzipien. Durch Containerisierung und klare Konfigurationsoptionen lässt sich das System leicht in bestehende CI/CD-Pipelines integrieren. Dies ermöglicht nicht nur schnelle Updates, sondern auch eine einfache Skalierung bei steigenden Datenvolumen. Das Zusammenspiel zwischen Kafka und ClickHouse ist besonders kraftvoll, weil Kafka als verteiltes, fehlertolerantes Messaging-System ein Höchstmaß an Zuverlässigkeit bei der Datenübertragung bietet. ClickHouse wiederum ist bekannt für seine herausragende Abfrageperformance bei analytischen Workloads, was es ideal für die Verarbeitung großer Mengen an Streaming-Daten macht.

GlassFlow fungiert dabei als Bindeglied und stellt sicher, dass die übertragenen Daten nicht nur ankommen, sondern qualitätsgesichert und in einem Zusammenhang stehen. Mit Funktionen wie deduplizierten Ereignissen innerhalb konfigurierbarer Zeitfenster setzt GlassFlow Maßstäbe in der Behandlung inkonsistenter Daten, wie sie in verteilten Systemen üblich sind. Die Möglichkeit, Joins temporaler Natur umzusetzen, erlaubt darüber hinaus eine weitreichende Flexibilität bei der Analyse von Datenhistorien und mehrdimensionalen Ereignisverknüpfungen. Dies eröffnet neue Wege, Datenflüsse smarter zu orchestrieren und tiefgreifendere Insights in Echtzeit zu erzeugen. Die Offenheit des Projekts unter der Apache-2.