Die rasante Entwicklung von Large Language Models hat das Potenzial, die Softwareentwicklung grundlegend zu verändern. Vor allem bei weniger verbreiteten Programmiersprachen wie OCaml stellt sich die Frage, wie gut diese Modelle auf lokale, selbst gehostete Umgebungen angepasst werden können und wie sie komplexe Programmieraufgaben bewältigen. OCaml, eine funktionale Programmiersprache mit starkem Typensystem, wird insbesondere in akademischen Kontexten wie der Universität Cambridge verwendet, wo Erstsemester in ihrem Grundlagenkurs interaktive Jupyter-Notebooks mit OCaml-Übungen bearbeiten. Diese Übungsaufgaben, auch als „ticks“ bezeichnet, testen grundlegende Konzepte wie Rekursion, Datenstrukturen und Streams und variieren in Schwierigkeitsgrad bis zu freiwilligen „starred“ Zusatzaufgaben. Die Fähigkeit von LLMs, diese Aufgaben erfolgreich zu lösen, ist ein entscheidender Indikator für ihre Praxistauglichkeit in realen Softwareentwicklungsumgebungen, gerade wenn es um spezifische Sprachmerkmale und weniger umfangreiche Trainingsdaten geht.

Ein aktuelles Forschungsteam bestehend aus Sadiq Jaffer, Jon Ludlam und Anil Madhavapeddy hat genau diese Fragestellung untersucht. Im Fokus stand das Modell Qwen3 von Alibaba, das in verschiedenen Größenparametern verfügbar ist und besonders auf lokale Nutzung außerhalb großer Cloud-Infrastrukturen ausgelegt wurde. Die Studienergebnisse überraschen durch die hohe Erfolgsquote dieses Modells bei der Lösung der Cambridge-OCaml-Tick-Probleme. Qwen3 in der 32 Milliarden Parameter Variante, die zudem über eine sogenannte „Denken“-Funktion verfügt, erreichte eine Erfolgsrate von über 95 Prozent bei den Aufgaben, was nahezu an die Leistung von Anthropics Claude 3.7 heranreicht – einem der führenden Cloud-basierten Modelle.

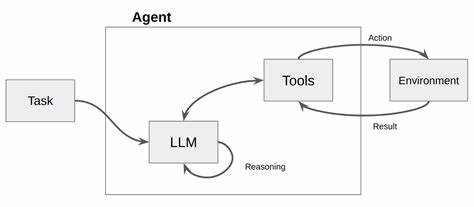

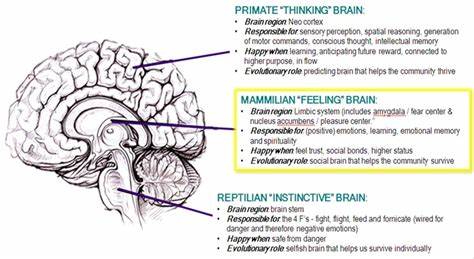

Dabei punktet Qwen3 nicht nur durch seine Effizienz, sondern auch durch Kostenvorteile, da die Preise um ein Vielfaches günstiger sind und das Modell als Apache-2-lizenzierte Software beliebig selbst gehostet werden kann. Die Bedeutung dieser Entwicklung liegt darin, dass LLMs dank dieser Selbsthost-Optionen nicht mehr auf teure API-Zugänge angewiesen sind und Entwickler und Forscher direkt auf die Modelle zugreifen und sie an ihre spezifischen Anforderungen anpassen können. Vor allem bei Sprachen wie OCaml, die nicht zu den „Mainstream“-Sprachen zählen und somit weniger Trainingsdaten in großen Korpora aufweisen, ist ein lokales Modell, das auch mit aktuellen oder noch in Entwicklung befindlichen Sprachfeatures umgehen kann, ein großer Vorteil. Wie funktionieren diese „Denken“-Modi und was bringt ihre Aktivierung? Anders als einfache Antwortgenerierungen ermöglichen diese Modi dem Modell, vor der endgültigen Lösung mehrere Tausend Tokens an „Überlegungen“ zu durchlaufen, wodurch komplexe Probleme besser verstanden und gelöst werden können. Allerdings führt dies auch zu einer Erhöhung der Latenzzeit und höheren Kosten bei Inferenz.

Die zusätzlichen Rechenschritte können in Einzelfällen zu Endlosschleifen führen, wenn das Modell an der Problemstellung hakt. Trotzdem hat sich gezeigt, dass die Denker-Variante von Qwen3 bei allen Modellgrößen die Leistung signifikant verbessert und kleinere Modelle mit „Denken“ sogar mit deutlich größeren konkurrieren können. Im Vergleich zu anderen Open-Weight-Modellen wie Google Gemma3, Meta Llama-3.3, Microsoft Phi-4 oder Deepseek-R1 schneidet Qwen3 systematisch besser ab. Interessanterweise zeigt sich bei Qwen-Modellen ein klarer Zusammenhang zwischen Modellgröße und Erfolgsrate, was vermuten lässt, dass größere Modelle ein besseres Verständnis für die Feinheiten von OCaml entwickeln, vermutlich auch wegen einer größeren Chance, relevante Teile der Trainingsdaten oder Sprachkonzepte aufgenommen zu haben.

Bemerkenswert ist auch der Einsatz sogenannter Mixture-of-Experts-Modelle, wie bei Qwen3 30B-A3B, bei denen nur ein Teil der Parameter pro Token aktiviert wird. Dies bietet einen Performancevorteil durch geringeren Rechenaufwand bei gleichzeitig respektabler Genauigkeit. Trotz ihrer vielen Stärken zeigen alle Modelle derzeit noch Schwächen bei grundlegenden Fehlerquellen. Syntaxfehler wie falsch verwendete Kommentare oder fehlende Schlüsselwörter wie rec bei rekursiven Funktionen gehören ebenso dazu wie typbedingte Verwechslungen zwischen Integer- und Floating-Point-Operatoren. Ein häufiges Versagen resultiert auch aus der Halluzination nicht existierender Funktionen oder der Annahme falscher Verfügbarkeiten von Bibliotheken, etwa Core oder Format.

In vielen Fällen kämpfen die Modelle mit Rekursion und fehlerhaften Abbruchbedingungen, was zu Endlosschleifen in Streams führt. Das nachhaltige Verbessern dieser Fehlerbereiche erfordert zusätzliche Trainingsdaten, idealerweise mit zunehmendem Schwierigkeitsgrad. Zurzeit stehen gerade einmal rund 80.000 OCaml-Quelldateien aus dem opam-Ökosystem als Trainingsdaten zur Verfügung, was angesichts der Komplexität vieler moderner OCaml-Anwendungen vergleichsweise gering ist. Zudem ist unklar, wie schwierig diese Beispiele sind und ob sie die Besonderheiten neuester Sprachfeatures adäquat vertreten.

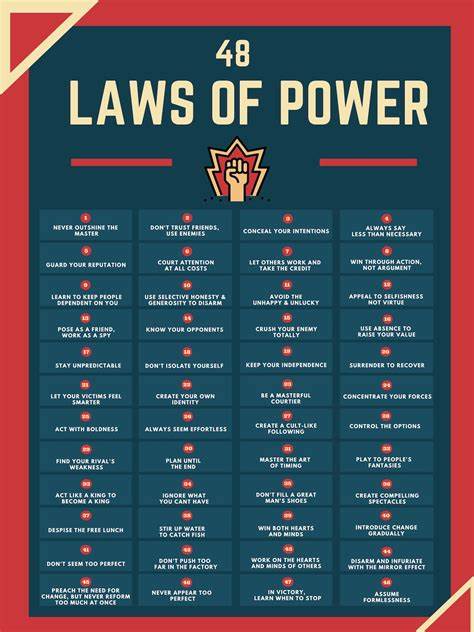

Hier setzen aktuelle Forschungstrends an, die etwa den Transfer von Trainingsdaten aus hochressourcenreichen Sprachen auf Low-Resource-Sprachen untersuchen und so neue Trainings- und Validierungsmöglichkeiten schaffen. Diese Techniken könnten zukünftig nicht nur reguläres Fine-Tuning erlauben, sondern auch fortschrittliche Reinforcement-Learning-Methoden, bei denen die Modelle schrittweise von der Bearbeitung leichter zu schwierigen Aufgaben lernen. Die Ergebnisse dieser Untersuchung bieten nicht nur wichtige Einblicke in den Leistungsstand aktueller LLMs für spezialisierte Programmiersprachen, sondern legen auch nahe, dass der Einsatz lokaler Modelle für Forschung und Praxis immer attraktiver wird. Teams, die eigene Infrastruktur betreiben möchten, um Datenschutzbedenken zu minimieren oder Kosten zu kontrollieren, finden mit Qwen3 eine leistungsstarke Grundlage. Auf der anderen Seite zeigen die Experimente auch, dass man sich nicht auf das Erreichte ausruhen darf, sondern kontinuierlich an Trainingsdaten, Modellarchitektur und Evaluierungen arbeiten muss.

Ein weiterer spannender Aspekt betrifft die Weiterentwicklung von OCaml selbst. Da viele neue Funktionen noch in der Entwicklung sind, könnte ein Prozess, bei dem LLMs gezielt auf diese Features trainiert und angepasst werden, nicht nur bei der Erzeugung von neuem Code helfen, sondern auch bei der Anpassung und Modernisierung alter Codebasen. Ebenso wäre eine Rolle in der Feature-Design-Phase vorstellbar, bei der durch KI-gestützte Simulationen und Validierungen eine schnellere Innovation möglich wird. Neben den rein technischen Aspekten öffnet diese Entwicklung auch neue Möglichkeiten im Bildungsbereich. Lehrkräfte können mit lokal betriebenen Modellen interaktive Lernhilfen bereitstellen, die speziell auf die Lehrinhalte abgestimmt sind, ohne auf Cloud-Dienste angewiesen zu sein.

Lernende profitieren von sofortiger Rückmeldung und Lösungen, die direkt auf ihren Übungsnotationen basieren. Gerade die Fähigkeit, komplexe logische Fehler oder Typ-Inkonsistenzen zu erkennen und zu erläutern, könnte so verbessert werden. Letztlich steht die Zukunft der lokalen LLMs für Programmiersprachen wie OCaml exemplarisch für eine breite Bewegung hin zu dezentralen, kosteneffizienten und leistungsfähigen KI-Lösungen. Während bisherige Erfolge oft monopolähnlichen Cloud-Anbietern zugeschrieben wurden, zeigt der Aufstieg von Modellen wie Qwen3, dass die Ära der lokal nutzbaren Intelligenz begonnen hat. Der Schlüssel zum Erfolg wird dabei weiterhin in der stetigen Verbesserung der Modelle, der Erweiterung passender Datensätze und der engen Verzahnung von Forschung, Praxis und Bildung liegen.

Für Entwickler, Forschungsteams und Bildungseinrichtungen bedeutet dies eine spannende Zukunft mit neuen Chancen und Herausforderungen. Die lokale Ausführung von LLMs ermöglicht eine größere Kontrolle über Datenschutz und Kosten zugleich und stellt sicher, dass auch weniger verbreitete, spezialisierte Programmiersprachen wie OCaml von der KI-Revolution profitieren. Damit kann das Potenzial von KI-basierten Hilfsmitteln optimal ausgenutzt werden – nicht nur in industriellen Großprojekten, sondern gerade in den Grundlagen der akademischen wie praktischen Programmierausbildung.