Die Chemie gehört zu den naturwissenschaftlichen Disziplinen, in denen tiefgehendes Wissen, präzise Analyse und kreatives Denken entscheidend sind. Traditionell beruhen Innovation und Fortschritt in diesem Feld auf dem Expertenwissen hochqualifizierter Chemiker, deren Verständnis von molekularen Zusammenhängen, Reaktionsmechanismen und Safety-Aspekten durch jahrelange Ausbildung und Forschungserfahrung geprägt ist. Doch mit dem Aufkommen großer Sprachmodelle (Large Language Models, LLMs) wie GPT-4 oder Claude wächst in der Wissenschaftscommunity das Interesse, welche Rolle diese KI-Systeme in der Chemie spielen können. Können sie das Wissen von Fachleuten übertreffen? Wie gut ist ihr Verständnis und ihre Fähigkeit, komplexe chemische Probleme zu lösen? Diese Fragen sind nicht nur technologisch relevant, sondern prägen auch die zukünftige Arbeitsteilung zwischen Mensch und Maschine in Forschung und Lehre. Großsprachmodelle basieren auf künstlicher Intelligenz, die auf riesigen Textdaten trainiert wird, um natürliche Sprache zu verstehen und zu erzeugen.

Ursprünglich entwickelt für Anwendungen in der Sprachverarbeitung, sind diese Modelle mittlerweile in der Lage, auch fachlich anspruchsvolle Aufgaben zu übernehmen. Insbesondere in der Chemie erscheint ihr Potenzial beachtlich, da ein Großteil der chemischen Erkenntnisse in wissenschaftlichen Publikationen, Datenbanken oder Lehrbüchern in Textform vorliegt. Die Modelle können diese Texte aufnehmen, daraus Muster erkennen und scheinbar eigenständige Schlussfolgerungen ziehen. In der Praxis bedeutet dies, dass LLMs Fragen beantworten, Reaktionsmechanismen vorschlagen und sogar experimentelle Protokolle planen können, ohne speziell dafür programmiert worden zu sein. Die Studie „A framework for evaluating the chemical knowledge and reasoning abilities of large language models against the expertise of chemists“ verschafft umfassende Einblicke in die tatsächliche Leistungsfähigkeit von LLMs im chemischen Kontext.

Forscher entwickelten mit ChemBench ein eigens dafür konzipiertes Bewertungssystem, in dem mehr als 2.700 Frage-Antwort-Paare aus unterschiedlichen Bereichen der Chemie verwendet wurden. Diese Fragen wurden sorgfältig zusammengestellt und klassifiziert, sodass sowohl Faktenwissen als auch komplexe logische Schlussfolgerungen und Intuition abgefragt wurden. Parallel dazu beantworteten 19 Expertinnen und Experten aus der Chemie denselben Fragenkatalog, teilweise unterstützt durch Webrecherchen und Spezialprogramme. Die Ergebnisse dieser Studie überraschen auf mehreren Ebenen.

In der Gesamtauswertung übertrafen die besten Sprachmodelle im Durchschnitt die Leistung der befragten Chemiker deutlich. Dabei zeigen die LLMs insbesondere eine herausragende Fähigkeit, Wissen schnell abzurufen und bei Standardfragen, die auf Lehrbuchinhalten basieren, zuverlässig zu reagieren. Das führt zu der Erkenntnis, dass KI-Systeme bei repetitiven oder faktenbasierten Aufgaben, die viel Speicher und Textverarbeitung erfordern, übermenschliche Leistung erzielen können. Aufgrund ihres Zugriffs auf ein weit größeres Spektrum an Texten und Informationen sind die Modelle in der Lage, viel schneller als Menschen Fakten abzurufen, zu vergleichen und zu kombinieren. Dennoch offenbaren die Untersuchungen auch signifikante Schwachstellen der aktuellen Sprachmodelle.

Insbesondere bei Fragen, die tiefere chemische Intuition oder umfangreiche Mehrschritt-Rechenprozesse erfordern, zeigen die Modelle Schwächen. So fällt es LLMs schwer, strukturelle Eigenschaften von Molekülen zu verstehen, wenn diese nicht explizit aus Datenbanken stammen, sondern durch geometrische oder räumliche Betrachtungen erschlossen werden müssen – beispielsweise bei der Vorhersage der Anzahl deutlich verschiedener Wasserstoffsignale in NMR-Spektren. Auch bei sicherheitsrelevanten Bewertungen von Chemikalien gibt es Defizite, was angesichts der möglichen Risiken bei Fehlinformationen wesentlich ist. Ein weiterer wichtiger Aspekt ist die Überprüfung der Zuverlässigkeit der Antworten durch die Modelle selbst. Die Fähigkeit, eigene Unsicherheiten zu erkennen und vertrauenswürdige Einschätzungen abzugeben, ist für die Nutzung in kritischen Anwendungen zentral.

In der Studie zeigt sich jedoch, dass viele LLMs nicht verlässlich einschätzen können, wann sie richtig liegen und wann ihre Antworten mit Vorsicht zu genießen sind. Teilweise äußern sie hohe Selbstsicherheit bei inkorrekten Auskünften, was für Nutzer problematisch sein kann und die Anforderungen an die menschliche Aufsicht verstärkt. Der Vergleich mit menschlichen Experten verdeutlicht, dass trotz der beeindruckenden Leistungsfähigkeit von KI der Beitrag erfahrener Chemiker weiterhin unverzichtbar ist. Fachliche Erfahrung bedeutet nicht nur Faktenwissen, sondern auch das Verständnis von Zusammenhängen, die Fähigkeit, neue Hypothesen zu generieren, und vor allem die kritische Bewertung von Ergebnissen – Aspekte, die KI-Modelle derzeit nur unzureichend leisten können. Daher ist die ideale Zukunftsvision nicht ein Wettbewerb Mensch gegen Maschine, sondern eine Synergie, bei der LLMs den Forschenden als Co-Piloten dienen und routinemäßige Arbeitsschritte übernehmen, während diese sich auf kreative und kritische Entscheidungsfindung konzentrieren.

Da die Sprachmodelle mit zunehmender Größe und Datenmenge trainiert werden, ist mit einer weiteren Steigerung der Fähigkeiten zu rechnen. Gleichzeitig betont die Studie die Bedeutung von spezialisierten Datenbanken und die Einbindung externer Werkzeuge, um das Fachwissen der KI zu erweitern und deren Interpretationsspielraum zu verbessern. Beispielsweise könnte eine engere Verzahnung mit Chemie-Datenbanken wie PubChem, Gestis oder anderen Sicherheitssystemen dazu beitragen, Wissenslücken in generischen LLMs zu schließen. Die Entwicklungen werfen auch grundlegende Fragen für die Chemieausbildung auf. Wenn KI-Systeme einfacher und schneller auf reines Faktenwissen zugreifen können als Studierende, so wird es notwendig, den Fokus in Lehre und Prüfungen stärker auf kritisches Denken, Synthese verschiedener Informationsquellen und praktische Fähigkeiten auszurichten.

Gleichzeitig eröffnen sich neue Möglichkeiten, KI als Bildungswerkzeug einzusetzen, das individualisiertes Lernen fördert und umfassende Informationszugänge bietet. Ein zusätzliches Augenmerk liegt auf den ethischen und sicherheitsrelevanten Herausforderungen. Die Möglichkeit, mit LLMs chemisches Wissen zugänglich zu machen, birgt auch Risiken. Die potenzielle duale Nutzung, beispielsweise für die Entwicklung gefährlicher Substanzen, fordert verantwortungsbewusste Governance und strenge Kontrolle. Auch die breite Verfügbarkeit solcher Systeme an Laien oder Studierende ohne fundiertes chemisches Hintergrundwissen kann Fehlinformationen begünstigen, was in Sicherheitsfragen besonders kritisch ist.

Insgesamt zeigt sich, dass große Sprachmodelle bereits heute das Niveau vieler menschlicher Chemiker in Fachfragen erreichen oder sogar übertreffen können. Dies ist ein Meilenstein, der die Chemiebranche vor tiefgreifende Umgestaltungen stellt. Nicht nur in der Forschung, sondern auch in Industrie und Bildung könnten LLMs als effiziente Werkzeuge etablieren, Analysen zu beschleunigen und neue Erkenntnisse zu ermöglichen. Gleichzeitig bleibt die Rolle menschlicher Chemiker von zentraler Bedeutung – sowohl als Experten, die komplexe Zusammenhänge verstehen und interpretieren, als auch als kritische Prüfer der maschinell generierten Informationen. Die vorliegende Studie trägt wesentlich zum Verständnis bei, wo genau KI an ihre Grenzen stößt und welche Entwicklungen notwendig sind, um diese Grenzen zu verschieben.

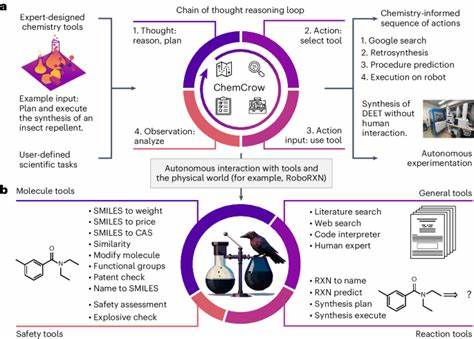

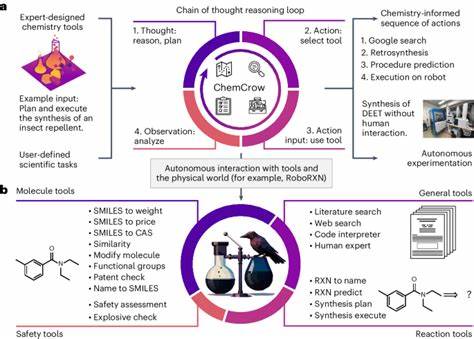

Die kommenden Jahre werden zeigen, inwieweit der Fortschritt in künstlicher Intelligenz die chemische Forschung transformiert. Dass Modelle wie GPT-4 bereits jetzt in der Lage sind, viele Aufgaben besser als der Durchschnittsexperte zu bewältigen, ist ein Grund zur Faszination und zur vorsichtigen Optimismus zugleich. Gleichzeitig werden gezielte Weiterentwicklungen, hochqualitative Datensätze und eine enge Integration menschlicher Expertise unabdingbar sein, um das volle Potenzial KI-gestützter Chemie zu realisieren, ohne die Sicherheit und wissenschaftliche Integrität zu gefährden. Ein weiterer spannender Ansatz ist das Zusammenspiel von Sprachmodellen mit spezialisierten „Agentensystemen“, die über Tools zur Recherche, Simulation oder Berechnung verfügen. Diese Kombination kann helfen, Wissenslücken zu schließen und komplexe Probleme dynamisch zu lösen.

Doch selbst hier bleibt die Herausforderung, wie und wann menschliches Feedback eingebunden wird, um Fehlinterpretationen zu vermeiden und die Vertrauenswürdigkeit der Ergebnisse zu maximieren. Das ChemBench-Framework bietet inzwischen eine wertvolle Grundlage, um zukünftige LLM-Entwicklungen systematisch zu bewerten und zu vergleichen. Ein transparenter, breit akzeptierter Benchmark ist entscheidend, um Fortschritte messbar zu machen und gleichzeitig die Sicherheit und Verlässlichkeit der Systeme zu gewährleisten. Zudem fördert es den Dialog zwischen KI-Entwicklern und Chemieexperten, um die Bedürfnisse der Anwender besser zu verstehen und entsprechende Anpassungen vorzunehmen. Letztlich zeigt die Analyse des Zusammenspiels von künstlicher und menschlicher Intelligenz in der Chemie, dass wir uns in einer Phase befinden, in der bewährte Arbeitsweisen hinterfragt und neu definiert werden.

Die Integration von KI wird den Blick auf Lernen, Forschen und Innovation verändern und Chancen für interdisziplinäre Zusammenarbeit schaffen. Wichtig bleibt es, diesen Wandel kritisch und verantwortungsbewusst zu gestalten, damit die Chemie nicht nur leistungsfähiger, sondern auch sicherer und nachhaltiger wird.