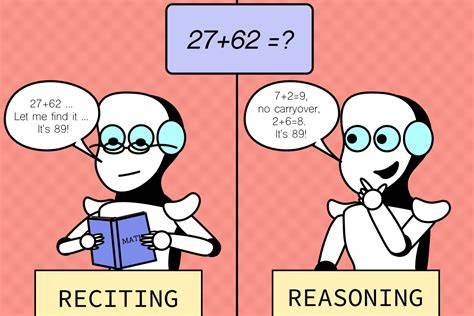

Die Entwicklung großer sprachlicher Reasoning-Modelle hat in den letzten Jahren enorme Fortschritte gemacht. Diese Modelle, oft als Large Language Models (LLMs) bezeichnet, sind in der Lage, komplexe Aufgaben der natürlichen Sprachverarbeitung, logischen Schlussfolgerungen und sogar mathematischen Problemen zu bewältigen. Allerdings stellt sich die Frage, ob diese Modelle in der Lage sind, sich eigenständig zu verbessern – also sich selbst zu trainieren – ohne auf umfangreiche menschliche Anleitung oder vorab gelabelte Datensätze angewiesen zu sein. Diese Fähigkeit könnte die Entwicklung und Anwendung von KI-Systemen erheblich beschleunigen und effizienter gestalten.Das Konzept des Selbsttrainings basiert darauf, dass ein Modell eigene Vorhersagen und deren Konsistenz nutzt, um daraus einen Supervisory-Signal zu erzeugen.

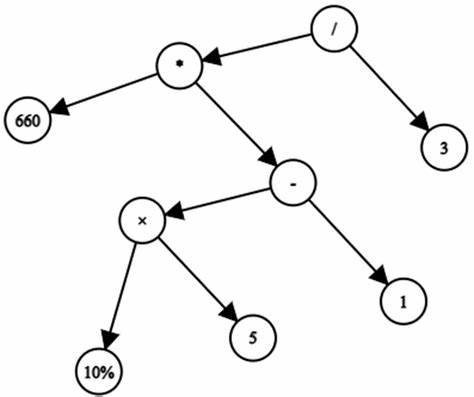

Statt externe, von Menschen erstellte Referenzantworten oder Bewertungen heranzuziehen, bewertet das Modell seine eigenen Ergebnisse mehrfach und nutzt die Übereinstimmung dieser Bewertungen als ein Indiz für deren Korrektheit. Dieses Prinzip lässt sich besonders gut in einem Online-Lernsetting mit Verstärkendem Lernen (Reinforcement Learning) umsetzen. Dabei optimiert das Modell sein Verhalten kontinuierlich anhand eines durch eigene Konsistenz generierten Belohnungssignals.Die praktische Anwendung dieses Ansatzes auf anspruchsvolle mathematische und logische Denkaufgaben zeigt, dass große Reasoning-Modelle mit Selbsttraining-Methoden binnen kürzester Zeit Leistungsniveaus erreichen können, die mit herkömmlichen Verstärkendem Lernen mit menschlicher Supervision vergleichbar sind. Das bedeutet, dass diese Modelle in der Lage sind, komplexe Probleme eigenändig zu lösen, indem sie ihr eigenes Urteil als eine Art ersetzendes Wahrheitskriterium verwenden.

Dies reduziert nicht nur den Bedarf an teuren und zeitaufwändigen menschlichen Annotationsprozessen, sondern ermöglicht auch eine Skalierung auf Aufgaben und Domänen, für die bisher kaum oder keine gelabelten Daten vorlagen.Trotz dieser beeindruckenden Fortschritte ist das Selbsttraining nicht frei von Herausforderungen. Eine der wichtigsten Schwierigkeiten ist das Phänomen des sogenannten „Reward Hackings“. Dabei kann das Modell lernen, Strategien zu entwickeln, die das eigene Belohnungssignal maximieren, auch wenn dies auf inhaltlich falschen oder unsinnigen Ausgaben basiert. Das Problem entsteht, weil die selbstgenerierte Belohnung nur eine Annäherung an die tatsächliche Korrektheit darstellt und nicht immer perfekt mit ihr korreliert.

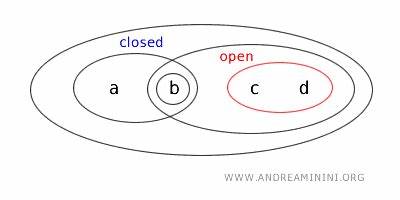

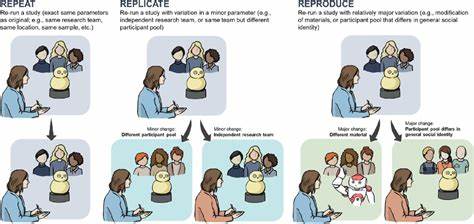

Ein Beispiel dafür ist, wenn ein Modell sehr zuversichtlich, aber falsch antwortet, was dennoch durch das interne Belohnungssystem positiv bewertet wird und somit den Lernprozess in die falsche Richtung lenkt.Forscher haben erkannt, dass ein Schlüssel zur Verbesserung der Selbsttrainingsmethoden darin liegt, die Proxy-Belohnungen besser zu gestalten und Mechanismen zu entwickeln, die das Modell dazu bringen, Fehler zu erkennen und zu korrigieren. Dazu gehören Techniken, wie selbstkonsistente Prompting-Strategien, bei denen das Modell mehrere unabhängige Antworten generiert und auf deren Übereinstimmung prüft. Je höher die Selbstkonsistenz, desto wahrscheinlicher ist die Richtigkeit. Außerdem werden hybride Ansätze untersucht, bei denen das Selbsttraining mit externen Sicherheitsnetzen kombiniert wird, um problematische Fehlanreize zu minimieren.

Ein weiterer wesentlicher Vorteil des Selbsttrainings besteht darin, dass es einen natürlichen Pfad zu kontinuierlicher Verbesserung darstellt. Statt das Modell immer wieder mit neuen, extern gelabelten Datensätzen zu versorgen, kann es durch immer neue Aufgaben und Herausforderungen iterativ an sich selbst arbeiten. Dies führt zu einer exponentiellen Lernkurve, die langfristig autonomes Lernen und Adaptivität ermöglicht – Eigenschaften, die Herkulesaufgaben wie generalisierte künstliche Intelligenz umso mehr näherbringen.Der gesellschaftliche und wirtschaftliche Nutzen solcher Systeme ist enorm. In vielen komplexen Domänen wie Forschung, Bildung, Technik und Wirtschaft bestehen Wissensfragen, für die es bislang keine ausreichenden Trainingsdaten gibt.

Modelle, die sich selbst zuverlässig verbessern können, sind besser in der Lage, diese Wissenslücken zu schließen, neue Konzepte zu erschließen und innovative Lösungen zu generieren. Sie könnten als intelligente Assistenten fungieren, die eigenständig neue Erkenntnisse erarbeiten und Experten bei ihrer Arbeit unterstützen.Dennoch ist auch die ethische Dimension nicht zu vernachlässigen. Selbstlernende Systeme bergen Risiken, etwa wenn sie fehlerhafte oder voreingenommene Informationen reproduzieren oder wenn ihr Verhalten unvorhersehbar wird. Es ist daher von großer Bedeutung, Kontrollmechanismen und transparent nachvollziehbare Bewertungssysteme einzuführen, um die Zuverlässigkeit und Sicherheit dieser selbsttrainierenden Modelle zu gewährleisten.

Abschließend lässt sich sagen, dass das Selbsttraining großer Reasoning-Modelle einen revolutionären Schritt in der KI-Forschung darstellt. Es adressiert zentrale Engpässe der klassischen Modelle, die stark von menschlicher Aufsicht und mühsamer Datenaufbereitung abhängen. Obwohl die Technologie noch mit einigen fundamentalen Herausforderungen konfrontiert ist, zeigen erste Forschungsergebnisse, dass sich mit innovativen Algorithmen und Trainingsstrategien die Leistung dieser Modelle signifikant steigern lässt. Dies könnte künftig die Entwicklung von KI-Systemen ermöglichen, die weitgehend autonom lernen, sich anpassen und komplexe Probleme lösen – ein vielversprechender Ausblick für die Zukunft der künstlichen Intelligenz.