In der Welt moderner Mehrmandantensysteme ist das Konzept des Throttlings oder der Zugangssteuerung zu einem essentiellen Bestandteil des Systembetriebs geworden. Viele denken bei Throttling sofort an den Schutz vor böswilligen Akteuren, die versuchen, Systeme durch übermäßige oder bösartige Nutzung zum Absturz zu bringen. Doch diese Sichtweise ist nur die Spitze des Eisbergs und greift viel zu kurz, wenn man die wahre Komplexität und Bedeutung von Throttling betrachtet. Throttling ist vor allem ein Werkzeug zur fairen Ressourcenverteilung in einer gemeinsamen Umgebung. Wenn Kunden auf eine Plattform zugreifen, teilen sie sich technische Ressourcen, die begrenzt sind.

Die Herausforderung besteht darin, sicherzustellen, dass keiner dieser Kunden durch exzessive Nutzung anderen schadet. Aber was heißt „exzessiv“ genau? Diese Antwort ist kaum eindeutig zu geben, da sie nicht nur technische, sondern auch produktbezogene, geschäftliche und soziale Faktoren berücksichtigt. Die gängige Missverständnis ist, dass Throttling primär dazu dient, bösartige oder fehlerhafte Nutzung zu verhindern. Die Realität ist jedoch differenzierter und wesentlich spannender. Es gibt grundsätzlich zwei Perspektiven, aus denen Throttling betrachtet werden kann: Zum einen als Maßnahme zum Schutz der Kunden vor unerwarteten negativen Folgen ihres eigenen Handelns, zum anderen als Schutzmechanismus für den Systembetreiber, um die Betriebssicherheit zu gewährleisten.

Throttling zum Vorteil der Kunden ist oft ein vorbeugendes Mittel. Ein klassisches Beispiel ist ein Entwickler, dessen fehlerhafter Skriptcode massenhaft API-Anfragen generiert und so für hohe Kosten sorgt. In solchen Fällen dient das Throttling als Sicherheitsnetz, welches den Kunden vor unangenehmen Überraschungen schützt. Darüber hinaus können Limits auch dazu verwendet werden, Kunden zu effizienteren Nutzungsmustern zu lenken. So könnte ein Service durch die Einschränkung bestimmter ressourcenintensiver API-Anfragen die Nutzer dazu bewegen, alternative, optimierte Methoden einzusetzen, welche die Systemlast verringern und gleichzeitig den Kundennutzen steigern.

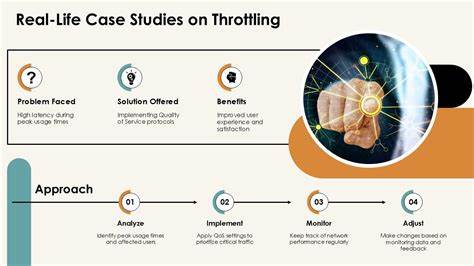

Ganz anders verhält es sich, wenn Throttling eingesetzt wird, um das System selbst vor legitimen, aber zu Spitzenzeiten problematischen Lasten zu schützen. Hierbei sind die Kunden keineswegs „böse“ Nutzer, sondern erleben womöglich aufgrund eigener positiver Geschäftsereignisse eine plötzliche Nachfrageexplosion – vielleicht durch virale Marketingkampagnen oder plötzliche Aufmerksamkeit in den Medien. In dieser Situation greift das Throttling als eine Art Lastabwurf, der zwar das System stabil hält, jedoch direkte Auswirkungen auf einige Kunden hat, die aufgrund einer temporären Erfolgsspitze zurückgestuft werden. Das klassische Bild von gut und böse gerät dadurch ins Wanken, denn hier ist nicht die Absicht der Kunden das Problem, sondern schlichtweg die begrenzte Kapazität des Systems, welches es gilt zu schützen. Ein wichtiger Schritt im Denken über Throttling ist daher die Unterscheidung zwischen Quoten, die im Interesse der Kunden gestaltet werden, und Lastabwurfmechanismen, die systembedingt sind.

Erstere schützen Kunden vor unbeabsichtigtem Missbrauch und helfen ihnen, kontrolliert mit Ressourcen umzugehen. Letztere sind unausweichliche Maßnahmen in Situationen, in denen die Systemressourcen an ihre Grenzen stoßen. Diese Realität verlangt Transparenz und ein systematisches Herangehen, bei dem nicht „Schuldige“ gesucht werden, sondern Lösungen, die den Gesamtnutzen maximieren. Eine gewisse Härte liegt darin, dass Lastabwurf immer auch Kunden schadet und dabei unvermeidlich Kompromisse erfordert. Ziel muss es sein, diesen Schaden so gering wie möglich zu halten und dabei stets das größere Bild zu betrachten – nämlich die langfristige Verfügbarkeit und Leistungsfähigkeit der Plattform für alle Nutzer.

Der Fokus verschiebt sich somit weg von der bloßen Prävention von Missbrauch hin zu der Frage, wie man bei Kapazitätsengpässen möglichst elegant und moderat herunterfährt. Die Dynamik von Throttling zeigt sich besonders deutlich in Verbindung mit automatischer Skalierung. Lastabwurf muss nicht als dauerhafte Sanktion verstanden werden, sondern als überbrückende Maßnahme, um Zeit zu gewinnen, bis zusätzliche Kapazitäten bereitgestellt werden können. Eine Analogie ist ein volles Restaurant während eines plötzlichen Ansturms. Einige Gäste müssen eventuell abgewiesen werden, um denen, die bleiben, weiterhin ein angenehmes Erlebnis zu gewährleisten.

Sobald mehr Personal oder Platz zur Verfügung stehen, kann wieder mehr Gäste akzeptiert werden. In technischen Systemen bedeutet das, dass die Throttling-Mechanismen eng mit skalierenden Infrastrukturen verknüpft sein sollten. Ein Lastabwurf signalisiert dabei dem System, zusätzliche Ressourcen zu starten. Gleichzeitig ist Vorsicht geboten, um eine unkontrollierte Ressourcenausweitung oder ständige Wechsel zwischen Überlastung und Freigabe zu vermeiden. Hier kommen Mechanismen wie Geschwindigkeitsbegrenzungen („Velocity Controls“) zum Einsatz, die die Skalierung glätten und so Stabilität schaffen.

Eine weitere Herausforderung bei der Umsetzung von Throttling klingt simpel, ist in der Praxis jedoch alles andere als trivial: viele Systeme greifen auf statische Limits zurück. Jeder Nutzer bekommt zum Beispiel eine fest definierte Anfragezahl pro Zeiteinheit. So einfach das in der Theorie ist, so problematisch erweist es sich in der Praxis, da die Bedürfnisse und das Verhalten der Kunden stark variieren. Während einige Nutzer mit geringem Verbrauch kaum die Kostenfaktoren beeinflussen, hängen große Kunden und Unternehmen mit hohen Volumina von der Plattform ab und benötigen flexible Lösungen. Statische Limits gehen zudem davon aus, dass Kunden unabhängig voneinander agieren – ein Szenario, das selten der Realität entspricht.

Beispielsweise kann es vorkommen, dass verschiedene Nutzer innerhalb desselben Unternehmens in kurzer Folge Lastspitzen erzeugen oder viele Nutzer denselben fehlerhaften Client einsetzen, der zeitgleich intensiven Traffic erzeugt. Solche korrelierten Lastspitzen können ein System schnell überfordern. Eine zukunftsweisende Alternative ist das kapazitätsbasierte Throttling. Dieses Verfahren lässt neue Anfragen nur so lange zu, wie das System freie Kapazitäten hat. Es funktioniert ähnlich wie eine Verkehrsampel an einer Autobahn-Auffahrt: Wenn die Autobahn frei ist, können Fahrzeuge ohne Einschränkungen einfädeln.

Sobald der Verkehr dichter wird, beginnt die Ampel den Zufluss zu regulieren, um Staus zu vermeiden. Eine weitere, oft diskutierte Herausforderung bei Throttling ist der Umgang mit sogenannten „Top Talkern“ – Kunden, die besonders hohe Ressourcen verbrauchen. In Situationen mit knappen Kapazitäten erscheint es naheliegend, gerade diese Nutzer zu drosseln, da man so am schnellsten Entlastung schafft. Allerdings handelt es sich bei Top Talkern häufig um besonders wichtige Kunden, deren Geschäft stark vom Dienst abhängt. Sie einfach abzuwürgen, kann zu ernsthaften wirtschaftlichen Schäden und Kundenverlust führen.

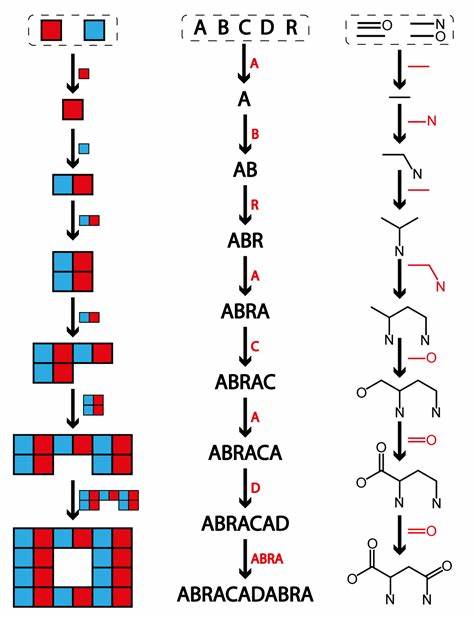

Eine differenzierte Lösung könnte darin bestehen, ausschließlich jene Kunden zu drosseln, deren Verbrauch plötzlich sprunghaft angestiegen ist, also neue Top Talker. Diese Interpretation setzt darauf, dass plötzliche Lastspitzen meist temporär und weniger legitim sind als etablierte hohe Nutzungsmuster, welche das Geschäft eines Kunden widerspiegeln. Technisch lässt sich diese Strategie durch adaptive Limitierung umsetzen. Dabei wird ein zunächst niedriger Grenzwert gesetzt, der bei normalem Betrieb dynamisch nach oben angepasst wird. Steigt die Nachfrage über das Limit hinaus und das System hat noch Kapazität, wächst das Limit mit.

Ist die Plattform jedoch ausgelastet, werden weitere Erhöhungen gestoppt und neue Spitzen werden zurückgefahren, bis die Skalierung den Engpass aufhebt. Interessanterweise ist die wichtigste Erkenntnis, dass Throttling weniger ein Mittel zur Missbrauchsprävention ist, sondern vielmehr ein Werkzeug zur bewussten Ressourcenallokation in einem komplexen, dynamischen Umfeld. Die Engpässe können finanzieller Natur sein – indem Kunden vor unerwartet hohen Rechnungen geschützt werden; technisch bedingt – indem die Systemverfügbarkeit gesichert wird; oder geschäftsstrategisch – etwa durch Produktstufendifferenzierung. Diese Neubewertung erleichtert es, intelligentere Fragen zu stellen, wie zum Beispiel, wie Ressourcen unter begrenzten Bedingungen gerecht verteilt werden können, wie das Gleichgewicht zwischen individuellen Kundenbedürfnissen und Systemsicherheit gefunden wird, oder wie negative Auswirkungen von unvermeidlichen Kompromissen minimiert werden können. Auch die Rolle von Throttling als Frühwarnsignal für notwendige Skalierungsmaßnahmen wird dadurch deutlicher.

Unter all dem ist jedoch nicht zu vergessen, dass Schutz vor böswilligen Angriffen weiterhin eine wichtige Aufgabe von Throttling darstellt. Dennoch ist es zu kurz gegriffen, alle Maßnahmen unter dem Narrativ „Missbrauch verhindern“ einzuordnen. Throttling ist ein vielschichtiges Werkzeug, das technische Zuverlässigkeit, Ressourcenmanagement, Produktdesign und Geschäftspolitik miteinander verknüpft. Die Zukunft von Throttlingssystemen liegt in der bewussten Differenzierung der anliegenden Anforderungen. Klare Trennung zwischen Kundenschutz und Systemsicherung, enge Integration mit automatischen Skalierungsmechanismen, der Übergang von starren Limits zu kapazitätsbasierten Steuerungen und die priorisierte Behandlung etablierter Nutzer sind zentrale Erfolgsfaktoren.

All jene, die sich mit Throttling beschäftigen, sollten sich von einfachen Schwarz-Weiß-Denkmustern verabschieden. Statt nur zu fragen, wie man „schlechte Akteure“ stoppt, geht es vielmehr darum zu verstehen, wer durch die Maßnahmen geschützt wird, welche Kompromisse gemacht werden und wie das gesamte System bestmöglich stabil und effizient bleibt. Diese differenzierte Sichtweise eröffnet neue Möglichkeiten für kreativere und effektivere Lösungen, die langfristig sowohl Kunden als auch Systemen zugutekommen.