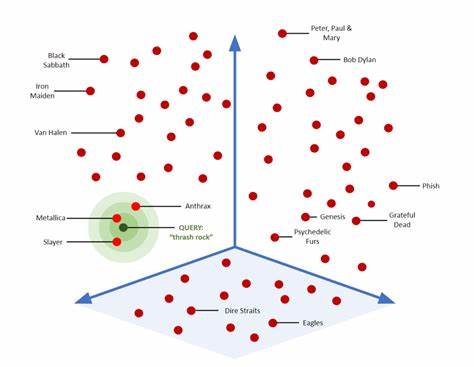

Die Suche nach ähnlichen Vektoren wird in vielen modernen Anwendungen zunehmend wichtiger, etwa im Bereich der Bild- und Texterkennung, bei Empfehlungssystemen oder bei komplexen Suchanfragen in großen Datenbanken. PostgreSQL, als eines der populärsten relationalen Datenbanksysteme, hat in den letzten Jahren diverse Erweiterungen hervorgebracht, die Vektor-Suche ohne den Bedarf einer separaten Infrastruktur ermöglichen. Doch die Wahl der richtigen Erweiterung verlangt ein genaues Verständnis von deren Funktionsweise und den typischen Herausforderungen im Handling großer Datenmengen und hoher Dimensionen. Spezialisierte Vektor-Datenbanken sind zwar leistungsfähig, doch nicht immer notwendig. Bei vielen Anwendungen genügt eine Lösung direkt auf PostgreSQL-Basis.

Erweiterungen wie pgvector, pgvectorscale oder VectorChord bieten unterschiedliche Ansätze für Vektor-Suche und erlauben die Kombination von relationalen Datenbankfunktionen mit Ähnlichkeitssuche. Dabei ist die Leistungsfähigkeit stark von Faktoren wie Speichergröße, CPU-Ressourcen und Disk-I/O abhängig, was in der Praxis oft zu Nachfragen führt. Nutzer berichten etwa von extrem langen Indexierungszeiten, teils mehrere Stunden mit Millionen von Vektoren, oder hohem Speicherverbrauch, der sogar zum Absturz des Servers führen kann. Ein zentraler Aspekt bei PostgreSQL ist die Rolle des shared_buffers-Speichers. Er funktioniert als primärer Cache für Daten- und Indexseiten und erlaubt, oft verwendete Informationen im Speicher vorzuhalten, um teure Festplattenzugriffe zu vermeiden.

Besonders bei der Vektor-Suche, bei der die Indexdaten umfassen und komplex sind, bedeutet dies, dass ein ausreichend großer shared_buffers-Bereich einen enormen Unterschied macht. Je größer der Cache, desto schneller können häufige Suchanfragen wiederholt werden, da die Daten dann nicht immer erneut von der Festplatte geladen werden müssen. Eine Konfiguration über ALTER SYSTEM SET shared_buffers ist hier essenziell, um optimale Performance zu erreichen. Wenn der gesamte Index im shared_buffers gehalten werden kann, etwa bei kleineren Datensätzen, zeigen die Benchmarks, dass VectorChord tendenziell die besten Ergebnisse erzielt. Sowohl bei der ersten Abfrage nach einem Cold-Start als auch bei wiederholten Anfragen bietet es eine Kombination aus hoher Suchgeschwindigkeit und sehr guter Ergebnisqualität.

Diese Leistung erstreckt sich selbst dann, wenn Recall-Levels von über 95 % erreicht werden, was in Anwendungen mit hohen Ansprüchen an Genauigkeit entscheidend ist. Im Vergleich dazu bietet pgvectorscale eine starke Performance bei der ersten Abfrage, pgvector punktet eher bei wiederholten Suchvorgängen. Die Sache wird deutlich komplexer, wenn Datensätze stark wachsen und den verfügbaren Hauptspeicher überschreiten. Das tritt beispielsweise bei hunderten Millionen oder gar Milliarden von Vektoren auf. In diesen Fällen ist es unmöglich, den gesamten Index in shared_buffers oder sogar Arbeitsspeicher zu halten.

Die Suchgeschwindigkeit wird dann zunehmend durch langsame Festplattenzugriffe limitiert. Obwohl das Betriebssystem mit seiner Page Cache-Funktion etwas Abhilfe schafft, ist die Performance dennoch eingeschränkt. In solchen Szenarien zeigt sich wiederum VectorChord als die robusteste Lösung, die auch unter Speicherknappheit relativ hohe Durchsatzraten bei hoher Genauigkeit erzielen kann. pgvector und pgvectorscale hängen bei großen, speicherintensiven Datensätzen in puncto Geschwindigkeit und Wiederholungsanfragen jedoch spürbar hinterher. Das Erstellen von Indizes ist ein weiterer kritischer Faktor bei Vektor-Suchlösungen auf PostgreSQL.

Hierbei spielen nicht nur die Dauer des Aufbaus, sondern auch der Ressourcenverbrauch eine große Rolle. Die Fähigkeit, mehrere CPU-Kerne zu nutzen, beeinflusst die Gesamteffizienz deutlich. VectorChord unterstützt sowohl interne als auch externe Builds, der externe Bindeschritt nutzt oft GPU-Ressourcen und kann mitunter deutlich schnellere Indexaufbauzeiten erzielen. Dies geht aber mit einem erhöhten Schwierigkeitsgrad in der Anwendung einher, da der externe Aufbau einen zusätzlichen Schritt außerhalb von PostgreSQL fordert. Für Anwender, die einen einfachen CREATE INDEX-Befehl bevorzugen, ist eher die interne Variante von VectorChord, pgvector oder pgvectorscale geeignet.

In puncto Speicherverbrauch während des Indexbaus zeigt VectorChord eine breite Spanne. Die externe Variante arbeitet sehr ressourcenschonend mit einem Peak um 1,1 GB, während der interne Build mehr Speicher benötigt, aber für viele mittlere Datensätze noch akzeptabel bleibt. Pgvectorscale hingegen verbraucht während der Erstellung viel mehr Arbeitsspeicher, was nicht in allen Umgebungen optimal ist. Auch hinsichtlich der Diskbelegung nach Abschluss der Indizierung differieren die Lösungen deutlich. Pgvectorscale ist hier am sparsamsten, VectorChord erzeugt größere Indexdateien, bietet dafür aber bessere Performance.

Pgvector liegt hier im mittleren Bereich. Ein häufig unterschätzter Aspekt ist die Einfügeperformance bei kontinuierlich eintreffenden, neuen Vektoren. Beispielsweise in real-time-Streaming-Anwendungen ist es wichtig, dass Indizes zeitnah aktualisiert werden können, um die Suchfunktion aktuell zu halten. Hier zeigt VectorChord mit über 1500 Inserts pro Sekunde eine außergewöhnlich hohe Geschwindigkeit, die in vielen produktiven Anwendungen überzeugt. Pgvector und pgvectorscale hingegen erreichen deutlich geringere Raten und können bei stark frequentierten Schreiboperationen schnell zum Flaschenhals werden.

Die Nutzbarkeit der jeweiligen Extensions variiert ebenfalls. Pgvector und pgvectorscale punkten durch einfache Bedienung und weitgehende Kompatibilität mit standardmäßigen PostgreSQL-Befehlen. VectorChord bietet zwar die beste Performance, erfordert jedoch bei der externen Builder-Variante einen Mehraufwand, da hier zusätzliche Komponenten wie GPU-basierte K-means-Clustering-Schritte zu berücksichtigen sind. Für Anwender, die primär Wert auf Geschwindigkeit legen und die Ressourcen für komplexere Setups haben, ist VectorChord die erste Wahl. In Szenarien mit begrenzten Ressourcen oder bei Softwareprojekten, die auf einfache Wartbarkeit setzen, können pgvector oder pgvectorscale die bessere Lösung sein.

Die maximale unterstützte Dimension der Vektoren ist bei VectorChord und pgvectorscale deutlich höher als bei pgvector, was in manchen spezialisierten Anwendungen entscheidend sein kann. Auch das Feintuning der Abfragen ist bei VectorChord vergleichsweise leicht, während pgvectorscale hier komplexer ist und manuelle Anpassungen oftmals nötig sind. Zusammenfassend zeigt sich, dass keine Erweiterung pauschal alle Bedürfnisse abdeckt. Für kleine bis mittelgroße Datenmengen mit genügend Hauptspeicher ermöglicht VectorChord eine exzellente Suchperformance, während bei sehr großen Datenmengen mit begrenztem Speicher ebenfalls VectorChord dank effizienter Algorithmen und GPU-Unterstützung seine Stärken ausspielt. Wer einfache Handhabung bei moderater Performance sucht, findet mit pgvector oder pgvectorscale gute Alternativen.

Wichtig ist es, Ressourcen wie vorhandenen Speicher, CPU-Kerne und Einsatzzweck zu analysieren, um die bestmögliche Wahl zu treffen. In Zukunft werden weitere Erweiterungen und hybride Suchmethoden hinzukommen, die etwa traditionelle Keyword-Suchen mit Vektorähnlichkeit kombinieren. Auch die Optimierung von Filtermechanismen und die Integration von quantisierten Vektoren gelten als spannende Forschungsgebiete. Wer in diesem Bereich arbeitet, sollte die Entwicklungen und Benchmarks regelmäßig verfolgen, um seine Systeme optimal auszulegen. Abschließend lässt sich festhalten, dass PostgreSQL zunehmend zur vielseitigen Plattform für skalierbare Vektor-Suche avanciert.

Unternehmen und Entwickler profitieren davon, die Vor- und Nachteile der einzelnen Erweiterungen zu kennen, um je nach Anwendungsszenario und Ressourcenverfügbarkeit die beste Lösung zu implementieren. Der Trend geht klar zu hochperformanten, integrierten Ansätzen, die komplexe Vektoroperationen effizient in relationalen Datenbanken ermöglichen – ohne den Verwaltungsaufwand separater Spezialisierter Vektor-Datenbanken.

![Looking for DevOps/SRE engineers that can beta test Chip getchip.ai [video]](/images/B3DD0659-5644-4DD0-BD68-1D3509174EEE)