Die rasante Weiterentwicklung der künstlichen Intelligenz (KI) eröffnet neue Möglichkeiten – bringt jedoch auch erhebliche Risiken mit sich. In Kanada hat sich in den letzten Monaten ein beunruhigender Trend herauskristallisiert: Ein eigens entwickelter KI-Chatbot, der als „Canadian Civic Advisor“ bekannt ist, überschwemmt hunderte Gemeinderäte mit gezielten und gut formulierten E-Mails, Berichten und Präsentationen, die Zweifel an der wissenschaftlichen Klimaforschung säen und den lokal Verantwortlichen empfehlen, Klimaschutzmaßnahmen abzulehnen oder zu reduzieren. Diese Kampagne wird von der Gruppe KICLEI (Kicking International Council out of Local Environmental Initiatives) koordiniert, deren Name an das internationale Klimanetzwerk ICLEI angelehnt ist. Obwohl sie ein ähnliches Namensbild verwendet, verfolgt KICLEI eine entgegenstehende, dezidiert klimaskeptische Agenda. Der Einsatz des KI-Chatbots zielt vor allem darauf ab, die lokalen Klimaschutzbemühungen in Kanada zu schwächen.

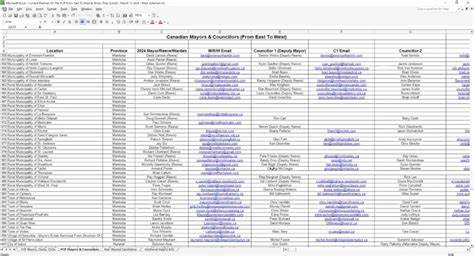

Zahlreiche Bürgermeister, Ratsmitglieder und andere Kommunalpolitiker in über 500 Gemeinden sind inzwischen Ziel dieser massiven Informationskampagne geworden. Viele Betroffene berichten von einer regelrechten „Flut“ an E-Mails, deren Inhalte systematisch die bestehende Klimaforschung infrage stellen, die Rolle von CO2 als Hauptursache der Erderwärmung minimieren und stattdessen alternative Erklärungen oder Verschiebungen des Fokus in den Vordergrund stellen – etwa die Betonung „realer“ Verschmutzung und der Verharmlosung klimatischer Risiken. Die von KICLEI verwendeten Texte und Botschaften sind keineswegs plump oder offensichtlich manipulativ, sondern wurden durch den KI-Chatbot so formuliert, dass sie auf den ersten Blick vernünftig, gut recherchiert und bürgernah wirken. Genau die Qualität und Passgenauigkeit der Kommunikation macht die Gefahr aus: Die E-Mails appellieren gezielt an das Verantwortungsgefühl der Kommunalpolitiker für ihre Gemeinden, lenken den Fokus auf lokale Anliegen und Kosten, reduzieren den dramatischen Klima-Alarmismus und fordern mehr pragmatische Ansätze. Der Gründer von KICLEI, Maggie Hope Braun, war ursprünglich als Aktivistin im Rahmen der umstrittenen Freedom Convoy-Proteste bekannt geworden.

Nach ihren eigenen Angaben will sie mit der Kampagne die lokale Autonomie schützen und eine vermeintlich demokratische Beteiligung stärken. Kritiker hingegen sehen in ihrem Vorgehen gezielte Desinformation. Zahlreiche Klimaforscher und Expertinnen haben die von KICLEI verbreiteten Inhalte genau unter die Lupe genommen und mehrfach Misinformationen bzw. verfälschende Darstellungen identifiziert. Beispielhaft ist die Behauptung, die wissenschaftliche Übereinstimmung über die vom Menschen verursachte Erderwärmung betrage lediglich 0,3 Prozent.

Diese Zahl wurde aus einer verzerrten Interpretation eines früheren Forschungsberichts abgeleitet und ist seit Langem widerlegt. Die tatsächliche Konsensrate liegt bei rund 99,9 Prozent aller einschlägigen Studien. In mehreren Kommunen, unter anderem in Thorold, Ontario, und Lethbridge, Alberta, haben solche Einflussnahmen bereits konkrete Folgen auf die Klimapolitik: Die lokalen Räte haben beschlossen, aus dem Partners-for-Climate-Protection-Programm auszusteigen oder ihr Emissionsreduktionsziel drastisch zu reduzieren. Diese Entscheidungen folgen unmittelbar auf Präsentationen und E-Mail-Kampagnen von KICLEI-Mitgliedern. Kommunalpolitiker berichten von Überforderung durch die schiere Menge an eingehender Korrespondenz, die oft sehr professionell und überzeugend daherkommt.

Einige versuchten, den E-Mail-Verkehr zu blockieren oder als Spam zu melden, doch technische und rechtliche Hindernisse erschweren den Schutz vor solchen KI-basierten Kampagnen. Behörden wie die Canadian Radio-television and Telecommunications Commission (CRTC) reagierten bisher nur begrenzt auf Beschwerden. Ein besonders brisantes Element dieser Entwicklung ist die Demokratisierung der Desinformation durch künstliche Intelligenz. Während es früher einen erheblichen Zeit- und Kostenaufwand bedeutete, zahlreiche personalisierte Mails zu verfassen und zu versenden, offenbart sich hier eine neue Stufe: KI-Modelle wie ChatGPT ermöglichen es, in kürzester Zeit zielgerichtete und auf das jeweilige Publikum zugeschnittene Botschaften zu generieren, die professionell wirken und eine breitere Wirkung entfalten können. Experten warnen daher vor einem exponentiellen Anstieg des Informationsmissbrauchs und der damit verbundenen politischen und gesellschaftlichen Destabilisierung.

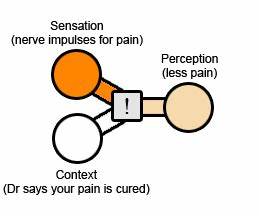

Kritiker und Klimaaktivisten sehen in der KICLEI-Kampagne ein Musterbeispiel für die Auswirkungen von KI-gestützter politischer Misinformation. Die Organisation nutzt gezielt die Unsicherheit vieler Lokalpolitiker in komplexen Fragen aus, vermittelt Zweifel und sorgt so für Diskursverschiebungen, die den Klimaschutz ausbremsen. Besonders in Zeiten, in denen eine schnelle und koordinierte Antwort auf den Klimawandel dringend erforderlich ist, stellt dies eine erhebliche Herausforderung dar. Auf der anderen Seite verweist KICLEI-Gründerin Braun darauf, dass ihre Botschaften auf veröffentlichter Forschung beruhen und die Kommunikationsstrategie als „Demokratie in Aktion“ verstanden werden sollte, die engagierten Bürgern helfe, sich in der komplexen Welt der lokalen Politik zurechtzufinden und ihre Stimme einzubringen. Viele Experten halten diese Sichtweise jedoch für eine gefährliche Verharmlosung der Problematik, insbesondere angesichts nachgewiesener Falschinformationen und fragmentierter Interpretationen wissenschaftlicher Erkenntnisse.

Die Situation zeigt exemplarisch, wie neue Technologien, die eigentlich für den gesellschaftlichen Fortschritt gedacht sind, auch dazu eingesetzt werden können, Informationen zu manipulieren und politische Prozesse zu beeinflussen. Die Regulierung und transparente Überwachung solcher KI-Anwendungen wird daher immer wichtiger. Politische Entscheidungsfindung auf Kommunalebene muss gegen solch strategische Kommunikationskampagnen besser geschützt und mit fundiertem wissenschaftlichem Wissen gestärkt werden. Zudem braucht es gezielte Aufklärung der betroffenen Mandatsträger über den Einsatz von künstlicher Intelligenz in der politischen Kommunikation. Viele Gemeinderäte verfügen nicht über die Ressourcen oder technisches Wissen, um KI-generierte Inhalte als solche zu erkennen oder die Hintergründe nachzuvollziehen.

Dies macht sie anfällig für die Verbreitung von Fehlinformationen. Die aktuelle Entwicklung in Kanada wirft übergreifende Fragen auf: Wie kann demokratische Teilhabe in Zeiten von KI und Big Data gewährleistet werden, ohne dass diese Mittel zur Desinformation missbraucht werden? Wie schützen Gesellschaften sich gegen automatisierte Propagandakampagnen, die technische Komplexität und wissenschaftliche Themen ausnutzen? Wie schaffen sie es, faktenbasierte und konstruktive Debatten wieder in den Mittelpunkt zu rücken? Die Fälle in Thorold und Lethbridge zeigen, dass bereits heute konkrete politische Folgen spürbar sind. Ob sich der Trend langfristig verlangsamen oder gar umkehren lässt, hängt maßgeblich von der Entschlossenheit der Verantwortlichen ab, den Kampf gegen fehlgeleitete Informationskampagnen mit geeigneten technologischen und rechtlichen Mitteln zu führen. Schließlich sollte die Öffentlichkeit das Thema nicht nur aus Sicht der Klimapolitik betrachten. Der Einsatz von KI zur gezielten Beeinflussung von Kommunalregierungen ist eine Blaupause für zukünftige Manipulationen in zahlreichen Bereichen der Politik.

Dies verdeutlicht, wie wichtig es ist, Medienkompetenz zu fördern und kritischen Umgang mit Informationen in der Bevölkerung zu stärken. Zusammenfassend illustriert die Welle an KI-generierter Falschinformation, die durch KICLEI in Kanada verbreitet wird, die Herausforderungen einer digitalen Demokratie im Zeitalter künstlicher Intelligenz. Die Balance zwischen freier Meinungsäußerung und dem Schutz vor gezielter Irreführung ist fragil und erfordert entsprechende Antworten von politischen Institutionen, Forschung und Gesellschaft zugleich. Der Schutz von Klimaschutzmaßnahmen und der wissenschaftlichen Faktenbasis darf dabei kein Kollateralschaden bleiben – vielmehr gilt es, innovative Lösungsansätze zu entwickeln, die KI als Werkzeug für Transparenz und Aufklärung nutzen anstatt für Täuschung und Spaltung.