Multi-Access Edge Computing (MEC) stellt einen wichtigen Schritt in der Evolution der Telekommunikationsarchitektur dar, mit großem Potenzial, die Latenzzeiten von datenintensiven Anwendungen erheblich zu reduzieren. Ursprünglich konzipiert, um Anwendungen wie Gaming und das Metaverse zu unterstützen, sind viele dieser Initiativen jedoch hinter den Erwartungen zurückgeblieben, da zahlreiche Telekommunikationsanbieter die Dienste weniger intensiv nutzen oder sogar eingestellt haben. Interessant ist jedoch, dass dieselbe MEC-Infrastruktur auch für AI-Inferenz am Edge eine vielversprechende Rolle spielen könnte. Doch wie tragfähig ist dieses Konzept in der Praxis? Welche Hindernisse und Vorteile ergeben sich bei der Nutzung von Teleco-MECs für KI-Modelle und deren Echtzeit-Ausführung? Im Folgenden werden die technischen, infrastrukturellen und marktwirtschaftlichen Aspekte hinsichtlich der Umsetzung von AI-Inferenz auf MEC-Umgebungen im Telekommunikationssektor umfassend beleuchtet. Die Ursprünge und Entwicklung von MEC im Telekommunikationsbereich lassen sich auf den Wunsch zurückführen, Anwendungen mit besonders niedriger Latenz näher zum Nutzer zu bringen.

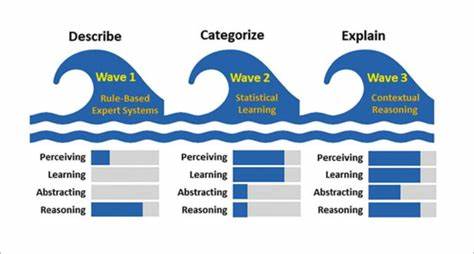

Anstatt Daten zur Cloud zu schicken und auf deren Verarbeitung zu warten, können Datenpakete lokal auf Edge-Servern verarbeitet werden. Damit konnte MEC insbesondere in Bereichen wie Cloud-Gaming, AR/VR oder Video-Streaming die Nutzererfahrung optimieren. Allerdings hat sich im praktischen Einsatz gezeigt, dass viele Dienste nicht die erhoffte Akzeptanz fanden oder sich späte Kosteneffektivität nicht realisieren ließ. Die starke Konkurrenz durch andere Cloud-Computing-Modelle sowie der hohe Investitionsbedarf waren entscheidende Faktoren. In letzter Zeit ist das Interesse an KI-Anwendungen im Edge-Bereich jedoch deutlich gewachsen, was neue Möglichkeiten für MEC eröffnet.

KI-Inferenz, also das Ausführen von bereits trainierten Modellen zur Vorhersage oder Klassifikation, ist besonders latency-sensitiv und benötigt Rechenleistung in unmittelbarer Nähe zum Endgerät, beispielsweise für autonome Fahrzeuge, Smart City-Anwendungen, industrielle Automatisierung oder intelligente Videoüberwachung. Die Verarbeitung erfolgt hierbei unmittelbar in der Nähe der Datenquelle, ohne den langen Weg zu einem zentralen Rechenzentrum nehmen zu müssen. Somit kann nicht nur die Reaktionszeit verbessert werden, sondern auch die Netzwerklast reduziert werden, was gerade für Telekommunikationsanbieter interessant ist. Technisch gesehen erfordert die Integration von AI-Inferenz auf MEC-Systemen spezielle Hardware- und Software-Optimierungen. Die Rechenressourcen an Edge-Standorten sind im Vergleich zu Hyperscale-Clouds oft limitiert, was bedeutet, dass effiziente und ressourcenschonende Modelle gefragt sind.

Neuartige Chips wie Neural Processing Units (NPUs) und spezialisierte AI-Beschleuniger werden vermehrt eingesetzt, um die Performance zu verbessern und gleichzeitig Energieverbrauch zu minimieren. Auch Container-Lösungen und Orchestrierungstechnologien spielen eine zentrale Rolle, um eine flexible und skalierbare Infrastruktur zu gewährleisten. Diese technischen Voraussetzungen beeinflussen stark die Praktikabilität der AI-Inferenz auf MECs. Neben der Hardware stellt auch die Softwareseite Herausforderungen dar. KI-Modelle müssen so konzipiert und optimiert werden, dass sie auf Edge-Hardware effektiv laufen.

Komplexe neuronale Netze können wegen begrenzter Ressourcen kaum direkt ausgeführt werden. Hier kommen Methoden wie Modellkomprimierung, Quantisierung und Edge-spezifische AI-Frameworks ins Spiel. Darüber hinaus sind Security-Aspekte essenziell, denn durch die dezentrale Verteilung der KI-Modelle auf zahlreiche Edge-Knoten entsteht ein erweitertes Angriffsrisiko. Sicherzustellen, dass Datenintegrität und Privatsphäre gewahrt bleiben, ist nicht nur aus Datenschutzgründen, sondern auch für das Vertrauen der Anwender unverzichtbar. Aus ökonomischer Sicht ist die Realisierung von AI-Inferenz auf Teleco-MECs ein Balanceakt zwischen Investition und Nutzen.

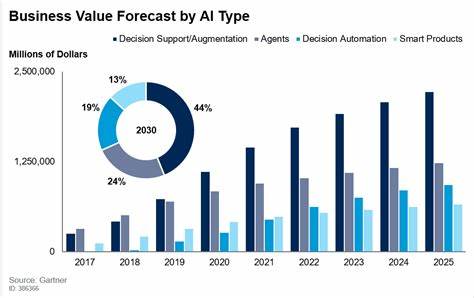

Für Telekommunikationsanbieter kann der Mehrwert in der Erschließung neuer Geschäftsmodelle und Services liegen, die durch geringe Latenzzeiten und lokale Datenverarbeitung ermöglicht werden. Beispielsweise können Unternehmen aus den Bereichen Smart Manufacturing oder Verkehrsüberwachung von Echtzeit-KI-Diensten profitieren. Gleichzeitig müssen Betreiber jedoch die Kosten für die Installation, den Betrieb und die Wartung der Edge-Infrastruktur sorgfältig kalkulieren. Das oftmals heterogene und weitverteilte Netzwerk erhöht die Komplexität der Verwaltung und erfordert erfahrene IT-Teams. Die Marktdynamik ist ein weiterer nicht zu unterschätzender Faktor.

Mit großen Cloud-Anbietern wie AWS, Google Cloud oder Microsoft Azure, die eigene Edge-Computing-Lösungen inklusive integrierter KI-Funktionalitäten bieten, sehen sich Telcos einem starken Wettbewerb ausgesetzt. Die Herausforderung besteht darin, durch enge Verzahnung mit bestehenden Netzen und lokaler Kundennähe Alleinstellungsmerkmale zu schaffen. Kooperationen zwischen Telekommunikationsunternehmen und Hyperscalern könnten eine Lösung sein, um die Vorteile beider Welten zu nutzen. Erfahrungen aus Pilotprojekten und ersten Rollouts zeigen, dass die Umsetzung von AI-Inferenz auf Teleco-MECs technisch möglich ist, aber häufig noch hinter den ursprünglichen Erwartungen zurückbleibt. Gründe hierfür sind nicht zuletzt regulatorische Vorgaben im Bereich Datenschutz, die insbesondere beim Edge-Computing komplex werden, sowie fehlende Standardisierung.

Die Latenzverbesserung und Datenlokalität bringen zwar Vorteile, doch für viele Kunden sind diese noch nicht ausreichend greifbar, um einen Mehrpreis zu rechtfertigen. Nichtsdestotrotz bleibt die Idee hoch attraktiv. Mit der zunehmenden Verbreitung von 5G und zukünftig 6G-Netzwerken steigt die Bedeutung von Edge-Computing dramatisch an. Teleco-MECs könnten damit zum essentiellen Bestandteil einer neuen Ära der vernetzten Intelligenz werden, wenn es gelingt, technische Limitationen zu überwinden und wirtschaftliche Modelle zu finden, die dauerhaft tragfähig sind. Die Anforderungen an geringe Latenz, hohe Sicherheit und dezentrale Intelligenz sprechen für eine zunehmende Verlagerung von AI-Inferenz in die Nähe der Endnutzer.