Die rasante Entwicklung der Künstlichen Intelligenz hat seit einigen Jahren eine spannende Dynamik hervorgebracht, besonders im Wettbewerb zwischen proprietären KI-Modellen großer Unternehmen und immer leistungsfähigeren Open-Source-Alternativen. Während Open-Source-Modelle immer schneller aufholen und ihre Verfügbarkeit die Branche verändert, zeigen jüngste Fortschritte im Bereich der Chain-of-Thought-Modelle und deren intelligente Nutzung von Netzwerkeffekten eine neue Dimension, in der proprietäre Anbieter ihre Stellung behaupten und sogar stärken können. Im Gegensatz zu traditionellen Softwareprojekten, deren Lebenszyklen teils Jahrzehnte umfassen, sind KI-Modelle durch ihre extrem schnelle Veralterung charakterisiert. Ein Modell gilt häufig bereits nach Monaten als veraltet, was kontinuierliche Innovationszyklen und schnelle Nachfolgeversionen erzwingt. Diese Entwicklung unterscheidet die KI-Landschaft grundlegend von der von Open-Source-Software, die über Jahrzehnte kontinuierlich wächst und sich stabilisiert.

In der KI-Welt variieren die Vorteile zwischen Open-Source- und proprietären Lösungen deshalb in einem viel engeren Zeitrahmen, wobei proprietäre Modelle oft einen Lead von rund 18 Monaten gegenüber offenen Pendants aufrechterhalten, bevor letztere aufschließen. Ein herausragendes Beispiel für diese Dynamik ist die Einführung von Chain-of-Thought (CoT) Modellen, welche die Art und Weise, wie KI mit komplexen Aufgaben umgeht, revolutioniert haben. Im Gegensatz zu traditionellen „rohen“ Inferenzstrategien, bei denen das Modell Antworten direkt generiert, nutzt das Chain-of-Thought-Verfahren explizite Zwischenschritte, die zur Lösung des Problems führen. Diese Zwischenantworten können als rationale Argumentationsketten oder „Denkschritte“ verstanden werden. Obwohl CoT-Inferenz mehr Rechenleistung pro Anfrage beansprucht und die Latenz dadurch steigt, erzielt sie zugleich signifikante Verbesserungen bei der Genauigkeit, insbesondere bei komplexen logischen oder mehrschichtigen Aufgaben.

Interessanterweise verändert Chain-of-Thought nicht nur die Fähigkeit der Modelle selbst, sondern auch die Art und Weise, wie Anbieter ihre Infrastruktur strukturieren. Bei offenen Systemen, die oft fragmentiert sind und von vielen unabhängigen Dienstleistern betrieben werden, wird jede Anfrage meist isoliert berechnet. Das bedeutet, dass zugleich ähnliche Denkprozesse immer wieder erneut durchlaufen werden müssen, was die Gesamtressourcen stark beansprucht und Skalierung erschwert. Proprietäre Unternehmen verfolgen hier einen gegenteiligen, konsolidierten Ansatz: Indem sie eine große Nutzerbasis auf einer einheitlichen, zentralisierten Infrastruktur bündeln, eröffnen sich völlig neue Optimierungsmöglichkeiten. Der Schlüssel liegt in der Wiederverwendung der Chain-of-Thought-Zwischenschritte, auch bekannt als CoT-Trace-Reuse.

Da viele Nutzer ähnliche Anfragen mit vergleichbaren logischen Pfaden stellen, kann die dadurch generierte Gedankenkette zwischengespeichert und für zukünftige Anfragen erneut genutzt werden. Diese Herangehensweise reduziert nicht nur den Rechenaufwand und die Inferenzkosten erheblich, sondern verkürzt auch die Antwortlatenz deutlich. Ein einfaches Beispiel verdeutlicht das Prinzip: Wenn ein Modell einmal die Zwischenargumentation „Spinnen haben 8 Beine“ ausgeführt hat, muss es diesen Teil bei einer zweiten Anfrage zu ähnlichen Themen nicht noch einmal neu berechnen. Stattdessen wird das Ergebnis ausgewählter Zwischenschritte einfach abgerufen und in die neue Antwort integriert, was Zeit, Ressourcen und CO2-Emissionen einspart. Darüber hinaus sind proprietäre Anbieter in der Lage, diese Idee noch weiterzudenken und sogenannte spezialisierte Reasoning Tokens zu etablieren.

Hierbei handelt es sich um neu geschaffene, kontextbehaftete Tokens, die komplexe logische Muster in verdichteter Form speichern. Anstatt bei jeder Anfrage erneut eine umfassende Argumentationskette zu generieren, können diese Tokens einfach eingefügt werden, was die Tokenanzahl und folglich die Rechenzeit drastisch reduziert, ohne dabei die Genauigkeit einzubüßen. Diese Innovationen führen nicht nur zu einem Effizienzsprung, sondern auch zu einer schnelleren Weiterentwicklung der Modelle. Die Fähigkeit, wiederverwendbare Bausteine des Denkprozesses als Tokens bereitzustellen, könnte die Verdopplungszeiten der KI-Fähigkeiten erheblich verringern. Laut aktuellen Berichten hat sich die Zeitspanne für die Verdopplung agentischer KI-Fähigkeiten schon von etwa sieben auf vier Monate verkürzt, und die gezielte Nutzung von CoT-Optimierungen könnte diesen Trend weiter beschleunigen.

In einer von ständigem Wettbewerb geprägten Landschaft, in der täglich neue Modelle mit ähnlichen Leistungsmerkmalen veröffentlicht werden, ist die reine technische Überlegenheit nur ein Teil des Puzzles. Die Herausforderung liegt vielmehr darin, wie schnell und effektiv Nutzergruppen bedient und gleichzeitig die Rechenressourcen optimiert werden können. So werden differenzierende Elemente wie effiziente Infrastruktur, Netzwerkeffekte und die Fähigkeit zur schnellen Skalierung zu entscheidenden Wettbewerbsvorteilen. Open-Source-Modelle punkten durch ihre schnelle Verfügbarkeit und die Möglichkeit, innerhalb weniger Tage in unterschiedlichen Services integriert zu werden. Doch wenn dies ohne eine zentralisierte Speicherung von Wissen und Zwischenprozessen geschieht, stößt die offene Skalierung schnell an Grenzen.

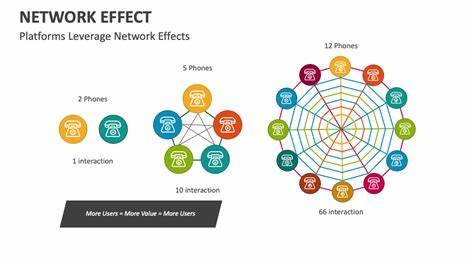

Proprietäre Lösungen, die Nutzer auf einer einheitlichen Infrastruktur bündeln, profitieren dagegen von einem exponentiellen Skaleneffekt der CoT-Nutzung. Jeder neue Nutzer, dessen Anfragen Ähnlichkeiten zu vorherigen Nutzern aufweisen, erhöht den Wert und die Effizienz des Gesamtsystems. Dieser Effekt erinnert an klassische Netzwerkeffekte, bei denen der Wert eines Dienstes mit der Anzahl seiner Nutzer steigt. Im Fall von Chain-of-Thought-basierten KI-Diensten bedeutet dies, dass ein größerer Nutzerstamm nicht nur größere Umsätze und Einnahmen generiert, sondern auch die Effizienz der Modelle und ihre Leistung durch gemeinsames Lernen aus der kumulativen Nutzung verbessert. Die Pflege und kontinuierliche Optimierung dieser Infrastruktur erfordert allerdings eine solide organisatorische und technische Grundlage, die vor allem große Unternehmen mit ihren Ressourcen bereitstellen können.

Die Verwaltung spezieller Tokens, die sichere Speicherung von CoT-Traces und deren intelligente Wiederverwendung sind Prozesse, die ständige Aufmerksamkeit und Weiterentwicklung benötigen. Open-Source-Communities sind zwar innovativ, jedoch fehlt es ihnen meist an der notwendigen Infrastrukturkapazität, um derart zentralisierte und tiefgreifende Optimierungen in großem Maßstab durchzuführen. Zusammenfassend lässt sich sagen, dass die Chiffre zur zukünftigen Marktdominanz im KI-Bereich zunehmend weniger in der reine Rechenleistung oder der offenen Zugänglichkeit von Modellen liegt. Stattdessen gewinnen spezialisierte Optimierungstechniken wie Chain-of-Thought, ihre intelligente Wiederverwendung und die gezielte Förderung von Netzwerkeffekten bei der Nutzerbindung und Ressourceneffizienz an Bedeutung. Die Fähigkeit, komplexe Denkprozesse in wiederverwendbare Bausteine zu zerlegen, diese effizient zu verwalten und den anwachsenden Erfahrungsschatz aller Nutzer zu nutzen, könnte der entscheidende Faktor sein, mit dem proprietäre KI-Anbieter ihren Vorsprung gegenüber Open-Source-Modellen verteidigen und ausbauen.

Die Zukunft der Künstlichen Intelligenz wird daher nicht nur von technischen Innovationen geprägt sein, sondern auch von der Art und Weise, wie Unternehmen ihre Nutzergemeinschaften zusammenführen und infrastrukturelle Vorteile intelligent ausschöpfen. Auf diesem Fundament basieren langfristige Wettbewerbsvorteile in einem Feld, dessen Tempo und Komplexität weiterhin rasant zunehmen. Chain-of-Thought-Netzwerkeffekte stellen dabei einen bisher unterschätzten Hebel dar, mit dem die kommenden Jahre der KI-Entwicklung entscheidend gestaltet werden könnten.