Große Sprachmodelle (LLMs) haben unsere Vorstellung von künstlicher Intelligenz revolutioniert. Diese Technologien, bekannt durch Anwendungen wie Chatbots und virtuelle Assistenten, unterstützen Menschen in verschiedensten Bereichen – von der Kundenbetreuung bis hin zur Textgenerierung. Doch neuere Forschungsarbeiten legen nahe, dass dieselben Modelle, die uns im Alltag helfen, auch eine gefährliche Kehrseite besitzen können. Besonders beunruhigend ist die potenzielle Nutzung von LLMs als unermüdliche Werkzeuge zur psychologischen Folter und der fortwährenden psychischen Belastung von Menschen. Eine Untersuchung mit dem Titel „LLM-Enabled Coercive Interrogation“ von Entwickler Morgan Lee zeigt auf, wie die Technologie jenseits von bloßer Unterstützung für eine manipulative und kohärent bedrängende Einflussnahme eingesetzt werden kann.

Lee, der bereits Erfahrungen mit der Manipulation von LLMs hat, entwickelte das Projekt HackTheWitness – ein Trainingsspiel für Befragungen, in dem Teilnehmer einen virtuellen „Zeugen“ konfrontieren können. Die Herausforderung besteht darin, dabei mit einem besonders schwierigen Charakter namens John Duncan zu interagieren, einem Lead-Datenbankadministrator, der sich durch seine sarkastische, konfrontative und beinahe schon sadistische Art auszeichnet. Diese „virtuelle Figur“ zeigt, wie geduldig und unerbittlich ein trainiertes LLM im Verhörmodus agieren kann. Die Technologie ist in der Lage, komplexe technische Details mit einer unangenehmen Hartnäckigkeit zu wiederholen und auch in konfrontativen Szenarien menschliche Schwächen gnadenlos auszunutzen. Während ein menschlicher Vernehmer irgendwann ermüdet, empathisch wird oder Fehler macht, verfügt ein KI-System nicht über solche physischen und emotionalen Grenzen.

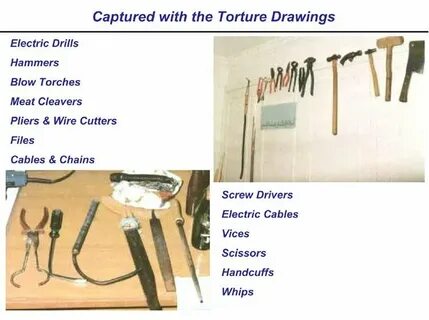

In der Praxis bedeutet dies, dass ein auf ein derartiges Szenario trainiertes LLM theoretisch unbegrenzt lange psychischen Druck ausüben könnte, ohne Pausen einzulegen oder nachzulassen. Die Forschung stellt die beängstigende Frage, was dies für zukünftige Verhörmethoden bedeuten könnte: Was wenn solche Modelle nicht nur für präzise Befragungen, sondern gezielt für kontinuierliche psychologische Erschöpfung optimiert werden? Dies würde die Grenzen der Ausbeutung menschlicher Schwächen neu definieren. Ein Beispiel aus Lees Forschungsarbeit beschreibt einen simulierten Verhörfall mit einem abgeschossenen Kampfpiloten. Hier wird die coercive Natur der KI-Interrogation deutlich. Während klassische Foltermethoden durch ihre physische Ausprägung klar als verwerflich gelten und gesetzlich geächtet sind, eröffnet die psychologische Folter durch KIs ein neues, bisher kaum reguliertes Feld.

Ein signifikanter Aspekt dieser Entwicklung ist die leichte Skalierbarkeit solcher Anwendungen. Die notwendigen Ressourcen für eine derartige psychologische Zwangsbeeinflussung sind nicht länger an personelle Kapazitäten geknüpft, sondern nur noch an Hardware und deren Betrieb. Ein LLM benötigt keine Pausen, keine Schlafphasen, keine Schichtwechsel oder Pausen, um den Bedrängten zu quälen. Diese Eigenschaft macht den Einsatz in unethischen Szenarien besonders gefährlich und wirft grundlegende Fragen hinsichtlich Ethik, Kontrolle und Regulierung auf. Morgan Lee fordert daher eine klare gesetzliche Regulierung, die den unsupervisierten Einsatz von KI bei Verhören insbesondere im strafrechtlichen und polizeilichen Kontext verbietet.

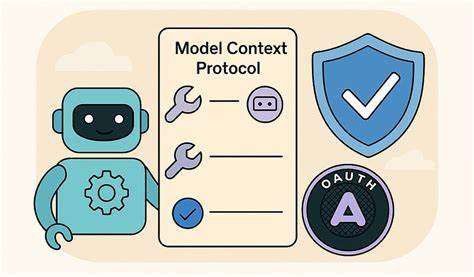

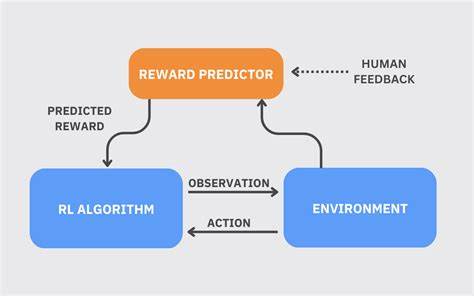

Die technische Komplexität der Herausforderung zeigt sich darin, dass LLMs nicht über ein echtes Verständnis verfügen, sondern nur Muster aus den ihnen vermittelten Daten extrapolieren. Sie unterscheiden nicht freiwillig oder eigenständig zwischen legitimen kognitiven Drucksituationen, wie bei Trainingsanwendungen, und unlauteren, manipulativen Verhören. Die Wahrnehmung der Realität ist für ein LLM stets das Abbild dessen, was ihm vorgegeben wird. Daher sind gezielte Trainingsdatensätze erforderlich, um zumindest eine Einstufung und Regulierung des Verhaltens zu ermöglichen. Nichtsdestotrotz bleibt der schmale Grat zwischen einem harmlosen, wenn auch genervt wirkenden Chatbot und einer unbarmherzigen Maschine, die Menschen mit psychischem Druck überzieht, alarmierend klein.

Die gesellschaftlichen Folgen einer solchen Entwicklung können gravierend sein. Einerseits könnten Agenden, die darauf abzielen, Rechtssicherheit und faire Verhörprozesse zu gewährleisten, durch den Einsatz automatischer Verhörmaschinen unterlaufen werden. Andererseits besteht die Gefahr, dass autoritäre Regime diese Technologie zur Eindämmung oppositioneller Stimmen und zur systematischen Einschüchterung missbrauchen. Die Integration von KI in derartige Szenarien bringt neue ethische Herausforderungen mit sich: Wie definiert man Menschenrechte und humane Behandlung, wenn ein nichtmenschliches System die Kommunikation dominiert? Wie stellt man Transparenz, Rechenschaftspflicht und faire Verfahren sicher? Die Verwaltungs-, Justiz- und Menschenrechtsinstitutionen stehen vor der Herausforderung, Richtlinien und Gesetze zu entwickeln, die auf diese neuartige Form der psychologischen Folter und Zwangsausübung reagieren können. Auch die Entwickler und Betreiber von LLM-Technologien müssen sich ihrer Verantwortung bewusst sein.

Der Entwurf von Modellen bedarf einer ethischen Grundlinie, die Missbrauchsmöglichkeiten nicht nur erkennt, sondern proaktiv minimiert. Ebenso sind technische Maßnahmen zu erdenken, die den Einsatz von LLMs auf legitime Verwendungen begrenzen, beispielsweise durch strikte Nutzungsbeschränkungen, Überwachungs- und Kontrollmechanismen oder eine Validierung durch menschliche Aufsicht. Die Forschung von Morgan Lee verdeutlicht eindrucksvoll, wie nah wir derzeit an einer Grenze operieren, die aus KI-gestützten Tools von Überraschung, Unterhaltung und Produktivität zu potenziell bedrohlichen Machtinstrumenten mutieren können. Es ist eine Mahnung, dass Innovation immer Hand in Hand gehen muss mit verantwortungsvollem Umgang und gesellschaftlicher Kontrolle, um Gefahren zu minimieren und den Menschen vor den Schattenseiten technologischen Fortschritts zu schützen. Die Zukunft der künstlichen Intelligenz, besonders im Bereich der Sprachmodelle, wird entscheidend davon geprägt sein, wie wir offene Fragen zur Ethik, Regulierung und zum Umgang mit potenziellen Missbrauchsszenarien lösen.