In der heutigen digitalen Welt faszinieren Large Language Models (LLMs) wie GPT, BERT oder ähnliche KI-Modelle eine immer größere Öffentlichkeit. Diese Modelle erzeugen beeindruckende, menschenähnliche Antworten auf unterschiedlichste Fragen, unterstützen bei Programmierung, Textverfassung oder schlicht in der Kommunikation. Doch ein immer wieder auftauchendes Rätsel beschäftigt viele Nutzer: Wie wissen LLMs eigentlich, in welchem Kontext eine Frage gestellt wird und warum reagieren sie oft so präzise und situationsbezogen? Beispielsweise schließen Modelle häufig eine Antwort mit einer passenden Grußformel ab, etwa "Happy coding", selbst wenn dies im ursprünglichen Text nicht explizit erwähnt wurde. Diese scheinbar subtilen Kontexteinschätzungen werfen die spannende Frage auf, wie solche Modelle auf diese Weise arbeiten und welche architektonischen sowie datenorientierten Aspekte dahinterstehen. Um zu verstehen, wie LLMs Kontext erkennen, ist es wichtig, die grundlegenden Prinzipien der Transformer-Architektur zu betrachten, auf der die meisten modernen Sprachmodelle basieren.

Transformer-Modelle sind darauf ausgelegt, Wort- oder Token-Beziehungen innerhalb eines Textes zu analysieren – nicht nur benachbarte, sondern auch entferntere Bezüge. Dies geschieht über das sogenannte Selbstaufmerksamkeitsmechanismus (Self-Attention), der es ermöglicht, den Kontext eines einzelnen Tokens in Relation zum gesamten Input zu bewerten. Durch diese Eigenschaft können Modelle Abhängigkeiten im Text erfassen, die für ein tiefes Verständnis notwendig sind. Darüber hinaus spielt das Training eine fundamentale Rolle. LLMs werden mit extrem großen Mengen an Text aus verschiedensten Quellen trainiert.

Diese Daten umfassen Bücher, wissenschaftliche Artikel, Forenbeiträge, Kommentarspalten und Programmierplattformen – kurzum: ein vielfältiges Spektrum menschlicher Kommunikation. So lernt das Modell, typische Muster und Zusammenhänge zu erkennen, die in diesen Texten vorkommen. Wenn beispielsweise in vielen Programmierforen Antworten auf Fragen mit "Happy coding" abschließend formulieret sind, verbindet das Modell diese Grußformel mit einem thematischen Kontext rund um Programmierung. Dadurch erkennt das Modell, wenn eine Benutzeranfrage diesem Kommunikationsstil entspricht und kann entsprechend reagieren. Ein weiterer wichtiger Aspekt ist das Kontextfenster, also der Inputbereich des Modells innerhalb einer Unterhaltung oder eines Textes, den das Modell gleichzeitig verarbeiten kann.

Innerhalb dieses Fensters werden bisherige Nachrichten, Fragen und Antworten berücksichtigt, damit das Modell kohärent und fortlaufend antwortet. In Dialogsystemen beispielsweise ermöglicht dies, dass das Modell sich „erinnert“, was zuvor besprochen wurde, und darauf Bezug nimmt. Wenn ein Nutzer im Gespräch über Programmierung spricht und am Ende des Dialogs ein Dankeschön ausspricht, erkennt das Modell durch den Kontext und die bisherigen Aussagen, dass es angebracht sein kann, mit einer passenden Grußformel wie "Happy coding" zu antworten. Viele Anwender sind erstaunt darüber, wie genau LLMs scheinbar „verstehen“, was gemeint ist. Dieses Verständnis ist im Kern jedoch statistischer Natur.

Das Modell basiert auf Wahrscheinlichkeiten, welche Worte oder Ausdrücke typischerweise in einem gegebenen Kontext folgen. Die enorme Datenmenge, mit der das Modell trainiert wurde, sorgt dafür, dass diese Wahrscheinlichkeiten erstaunlich gut mit menschlichem Sprachgebrauch übereinstimmen. Somit entsteht der Eindruck, dass das Modell wirklich „denkt“ oder weiß, worum es geht – tatsächlich handelt es sich um eine hochentwickelte Mustererkennung. Darüber hinaus tragen Feinabstimmungen (Fine-Tuning) und zusätzliche Trainingstechniken maßgeblich dazu bei, die Kontextwahrnehmung zu verfeinern. Entwickler können ein Modell gezielt auf bestimmte Anwendungsfälle einstellen, zum Beispiel für technischen Support oder kreatives Schreiben.

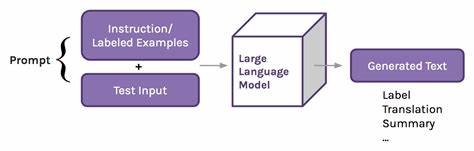

In solchen Fällen wird das Modell auf spezialisierten Datensätzen weitertrainiert, die zu der jeweiligen Domäne passen. Dies erhöht die Genauigkeit und Relevanz der Antworten und verstärkt die Kontextwahrnehmung speziell in diesem Bereich. Es gibt auch innovative Methoden wie den Einsatz von sogenannten Prompt-Engineering-Techniken. Hierbei formulieren Entwickler die Eingaben so, dass das Modell bestimmte Informationen oder Ausrichtungen einbezieht, was wiederum den Kontext beeinflusst. Diese Methoden erweitern die Steuerungsmöglichkeiten und verbessern das Ergebnis in Hinblick auf Relevanz und Kontexttreue.

Auf technischer Ebene ist die Art der Tokenisierung und die Vektorrepräsentation entscheidend. Jedes Wort oder Satzzeichen wird in numerische Vektoren umgewandelt, die Bedeutungsähnlichkeiten abbilden. So kann das Modell semantische Zusammenhänge und kontextuelle Nuancen viel besser erkennen als durch reine Wortproben. Die Kombination aus Transformer-Selbstaufmerksamkeit, Training mit gigantischen Datenmengen, Kontextfenstern und semantischen Vektoren bildet somit das Fundament für die beeindruckende Kontextwahrnehmung moderner LLMs. Dennoch gibt es Limitationen: Da Modelle nur mit Wissensständen aus der Trainingszeit arbeiten und keinen echten Bewusstseinszugang haben, können sie gelegentlich falsche oder unpassende Antworten generieren, wenn der Kontext zu speziell oder mehrdeutig ist.

Außerdem sind sie anfällig für Verzerrungen aus den Trainingsdaten, was manchmal zu fehlerhaften oder stereotypen Aussagen führen kann. Nichtsdestotrotz sind die Fortschritte in diesem Bereich revolutionär und schaffen Anwendungen, die in vielen Branchen für Effizienzsteigerungen sorgen. Vom automatisierten Kundenservice über kreative Textgenerierung bis hin zu fortschrittlichen Assistenzsystemen profitieren Nutzer von der Fähigkeit der LLMs, Kontext zu erfassen und diesen für sinnvolle, kontextbezogene Antworten einzusetzen. Die Frage, wie LLMs Kontext erkennen, zeigt eindrucksvoll, wie weit die künstliche Intelligenz heute gekommen ist. Was auf den ersten Blick nach „Verstehen“ aussieht, ist das Ergebnis komplexer mathematischer Modelle, umfangreichen Trainings und raffinierter Architekturen, die gemeinsam eine neue Qualität der Kommunikation zwischen Mensch und Maschine ermöglichen.

Die Zukunft verspricht noch tiefere Kontexteinsichten, verbesserte Nutzerschnittstellen und zeitnahe Anpassung an dynamische Gesprächsinhalte, was LLMs zu einem unverzichtbaren Werkzeug in der digitalen Welt macht.