In der heutigen digitalen Landschaft, in der Daten das Rückgrat nahezu aller Geschäftsprozesse bilden, steht die Wahl der richtigen Datenbanktechnologie im Fokus vieler Unternehmen. Besonders bei wachstumsstarken Firmen wird die Entscheidung, welche Datenbanklösung zum Einsatz kommt, zu einem zentralen Faktor für Performance, Kosten und Skalierbarkeit. Ein immer häufiger diskutiertes Szenario ist die Migration von modernen verteilten Datenbanksystemen wie CockroachDB hin zu bewährten relationalen Systemen wie PostgreSQL. Doch warum entscheiden sich Unternehmen für diesen Schritt und welche Erfahrungen lassen sich daraus ableiten? CockroachDB wurde lange Zeit wegen seiner beeindruckenden Eigenschaften geschätzt. Die Fähigkeit, horizontal zu skalieren, vor allem in Multi-Region-Setups, verlockte viele Start-ups und skalierende Firmen, die auf hohe Verfügbarkeit angewiesen sind.

CockroachDB bietet eine SQL-kompatible Schnittstelle, was die Integration in bestehende Anwendungen verhältnismäßig unkompliziert erscheinen lässt. Trotzdem stellt sich für viele Unternehmen früher oder später die Frage: Brauchen wir tatsächlich die komplexe Infrastruktur eines verteilten Systems, wenn der Großteil unserer Anwendungen bisher unkomplizierte, transaktionale Abfragen in einer einzigen Region ausführt? Langfristig zeigen sich bei CockroachDB aber vor allem im Hinblick auf wachsende Datenmengen und Anwendungsfälle Grenzen, die nicht ignoriert werden können. Ein besonders gravierendes Problem sind die steigenden Betriebskosten. Bei einem Unternehmen, das seit 2022 CockroachDB nutzt, haben sich die Kosten innerhalb von zwei Jahren verfünffacht und lagen im mittleren sechsstelligen Bereich. Dies wirft die Frage nach der Wirtschaftlichkeit und dem Verhältnis von Nutzen zu Aufwand auf.

Auch technische Herausforderungen erschweren den Betrieb. Das Datenbank-Management-System stößt zunehmend an Performance-Grenzen, etwa wenn es um Migrationen geht. Das Einspielen von Schema-Änderungen über ORM-Tools wie Prisma führte regelmäßig zu Timeouts, die den Betrieb beeinträchtigten und bedeutende Verzögerungen im Deploy-Prozess verursachten. Entwickler waren gezwungen, Migrationen manuell durchzuführen, was nicht nur zeitaufwändig, sondern auch fehleranfällig ist. Solche Einschränkungen behindern nicht nur den technischen Fortschritt, sondern blockieren auch nötige Upgrades der Datenbankversion selbst, was wiederum zu einem verringerten Support und langfristiger Verwundbarkeit führt.

Zusätzlich zu Migrationsproblemen beeinträchtigten auch andere Prozesse die Nutzung. ETL-Jobs zum Beispiel sind essenziell für die Datenintegration und -analyse, doch die Anbindung über Tools wie Airbyte war lange Zeit instabil und von Speicherausfällen geprägt. Dies erschwerte automatisierte Datenprozesse erheblich, sodass Betriebsunterbrechungen und Performance-Einbußen keine Seltenheit waren. In der Konsequenz entstand ein steigender Bedarf nach einer stabileren, effizienteren Lösung. In puncto Abfragegeschwindigkeit ergaben sich verschiedene Erkenntnisse.

Trotz des Rufs von CockroachDB für seine ausgeklügelten Optimierungsalgorithmen wich der Vorteil in einigen Fällen der Realität, dass PostgreSQL bei komplexen und realitätsnahen Abfragen deutlich schneller reagiert. Besonders bei komplexen ORM-generierten SQL-Abfragen zeigte PostgreSQL eine bessere Performance, da die CockroachDB-Abfrageoptimierung unter der Komplexität litt und häufig zu vollständigen Tabellen-Scans führte. Solche Szenarien führten zu massiven Latenzzeiten, die das Nutzererlebnis maßgeblich beeinträchtigten. Neben technischen Schwierigkeiten gab es auch Herausforderungen in der Nutzeroberfläche und dem Support. Die CockroachDB-Oberfläche vermittelte anhand von nicht trivialen Indizes teilweise falsche Empfehlungen, was bei Entwicklern Verwirrung stiftete und zu falschen Entscheidungen bezüglich der Datenbankoptimierung führte.

Die Komplexität, laufende, ressourcenintensive Abfragen abzubrechen, stellte im verteilten System eine vergleichsweise große Hürde dar. Im Gegensatz zu PostgreSQL, wo einfache Abbruchmechanismen über Standard-SQL-Clients möglich sind, mussten Cockroach-Benutzer aufwendige Schritte über die Konsole gehen. Die Folge waren potenzielle Systeminstabilitäten, wenn Abbrüche nicht schnell genug ausgeführt wurden. Auch das Support-Erlebnis fiel gegenüber PostgreSQL eher enttäuschend aus. Die Trennung der Support- und Hauptportale, die fehlende Nutzerfreundlichkeit bei der Ticket-Erstellung und die verzögerten Antwortzeiten führten gerade in kritischen Situationen zu Unmut und beeinträchtigten den reibungslosen Betrieb.

Ein nicht zu unterschätzender Punkt waren die Netzwerkprobleme, etwa bei Verwendung von VPN-Lösungen wie Tailscale. Diese Verbindungsabbrüche kamen unerwartet und beeinträchtigten die Stabilität in allen Umgebungen, von lokalen Clients bis hin zu CI-Jobs. Diese Probleme traten bei PostgreSQL so nicht auf und unterstreichen die praktische Überlegenheit bei der Infrastrukturstabilität. Die eigentliche Migration von CockroachDB zu PostgreSQL war ein technisch anspruchsvoller Prozess. Für ein Unternehmen mit einer Datenbankgröße von ca.

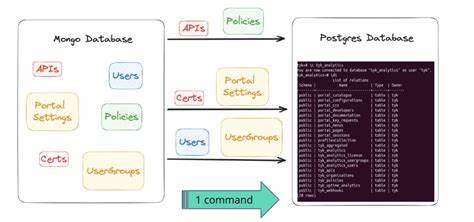

100 Millionen Zeilen stellte die Limitierung der ETL-Tools eine große Herausforderung dar. Um den Wechsel dennoch zu realisieren, wurde eine maßgeschneiderte ETL-Lösung entwickelt, die auf dem aufstrebenden JavaScript-Laufzeit-Framework Bun basierte. Der Ansatz bestand darin, ein Dump-File pro Tabelle zu erzeugen und mithilfe von Streaming-Verbindungen die Daten tabellenweise nach PostgreSQL zu übertragen. Besondere Aufmerksamkeit musste der unterschiedlichen Byte-Kodierung in JSON- und Array-Spalten zwischen den beiden Systemen geschenkt werden. Die Folge war eine eigene CSV-Parsing-Pipeline, die eine reibungslose, inhaltlich identische Übertragung der Daten sicherstellte.

Die Durchführung der Migration verlief erfolgreich und beeindruckend schnell. Unter Zuhilfenahme einer leistungsstarken virtuellen Maschine mit 128 CPU-Kernen wurde die gesamte Übertragung in etwa 15 Minuten abgeschlossen. Die geplante Downtime betrug dabei weniger als eine Stunde, was für ein Unternehmen mit hoher Verfügbarkeit eine beachtliche Leistung darstellt. Im Anschluss konnte dank Maßnahmen wie der Nutzung von Tools wie PGAnalyze die Datenbankleistung weiter optimiert werden. Bereits kurz nach dem Wechsel zeigten sich Verbesserungen durch die Optimierung einzelner Abfragen, wodurch sich die Gesamtperformance um etwa ein Drittel verbesserte.

Die Kosteneinsparungen durch die Migration fallen ebenfalls signifikant aus. Trotz konservativer Überprovisionierung des neuen PostgreSQL-Clusters wurde der Betrieb auf deutlich günstigerem Niveau sichergestellt, mit Einsparungen im sechsstelligen Bereich jährlich. Zudem entfielen Komplexitäten beim Betrieb und Support, was sich wiederum positiv auf die Entwicklungsgeschwindigkeit und Stabilität der Anwendungen auswirkte. Die Erfahrungen mit der Migration von einem verteilten System wie CockroachDB zu einer traditionellen relationalen Datenbank wie PostgreSQL zeigen, dass moderne Geschäftsanforderungen nicht immer mit der neuesten Technologie gleichzusetzen sind. Stattdessen zählen die tatsächliche Nutzung, das Kosten-Nutzen-Verhältnis sowie der gesamte Betriebsaufwand.

PostgreSQL bietet eine flexible und robuste Basis, die dank eines riesigen Ökosystems, vielfältiger Tools und einer lebendigen Community immer weiterentwickelt wird. Unternehmen, die vor ähnlichen Herausforderungen stehen, können von solchen Erfahrungsberichten lernen und erkennen, dass die Wahl der richtigen Datenbank weit mehr ist als eine technologische Entscheidung. Es ist eine strategische Weichenstellung, die maßgeblichen Einfluss auf die Skalierbarkeit, die Kostenkontrolle und die langfristige Wartbarkeit hat. Zusammenfassend lässt sich sagen, dass die Migration zu PostgreSQL für wachsende Unternehmen ein bewährter Weg ist, technische Hürden zu überwinden, Betriebskosten zu senken und die Performance nachhaltig zu steigern. Dabei ist wichtig, eine sorgfältige Planung und Umsetzung vorzunehmen, die auch die Eigenheiten der Daten und die Kompatibilität der Systeme berücksichtigt.

Die Investition in eine solide Datenbankinfrastruktur zahlt sich am Ende vielfach aus und schafft die Basis für zukünftiges Wachstum und Innovationsfähigkeit.