In einer Zeit, in der Datenschutz und Sicherheit von Informationen immer wichtiger werden, gewinnt die Verarbeitung sensibler Daten mit Hilfe von Künstlicher Intelligenz zunehmend an Bedeutung. Große Sprachmodelle (Large Language Models, LLMs) haben sich als leistungsstarke Werkzeuge für die Analyse und Verarbeitung natürlicher Sprache etabliert. Doch gerade der Umgang mit vertraulichen oder nicht öffentlich zugänglichen Dokumenten stellt eine Herausforderung dar, wenn es darum geht, Daten nicht in die Cloud zu übertragen oder auf fremden Servern zu verarbeiten. Genau an diesem Punkt setzt OnPrem.LLM an und bietet eine innovative Lösung für den datenschutzbewussten Einsatz von LLMs vor Ort.

OnPrem.LLM ist ein Python-basiertes Toolkit, das speziell für den Einsatz in Offline- oder stark kontrollierten Umgebungen konzipiert wurde, in denen Datenhoheit und Privatsphäre oberste Priorität haben. Es erlaubt Unternehmen, Forschungseinrichtungen und Behörden, LLMs direkt in ihrer eigenen Infrastruktur zu betreiben, ohne Daten an externe Anbieter weiterleiten zu müssen. Dabei steht die Sicherheit der Daten im Mittelpunkt aller Funktionen und Prozesse. Das Toolkit bietet vorgefertigte Pipelines für verschiedene Anwendungsbereiche wie Dokumentenverarbeitung, Informationsextraktion, Zusammenfassung, Klassifikation sowie die Verarbeitung von Eingabeaufforderungen (Prompts) und Ausgaben mit minimalem Konfigurationsaufwand.

Diese Module unterstützen dabei, komplexe Workflows umzusetzen und individuell auf spezifische Anforderungen zuzuschneiden. Dadurch kann man schnell und effizient intelligente Dokumentenanalyse betreiben – ohne tiefgreifende technische Kenntnisse. Eine besondere Stärke von OnPrem.LLM liegt in seiner Flexibilität hinsichtlich der unterstützten LLM-Backends. Es unterstützt mehrere Modelle und Frameworks, darunter llama.

cpp, Ollama, vLLM und Hugging Face Transformers. Zudem ermöglichen quantisierte Modelle und GPU-Beschleunigung eine effiziente und performante Verarbeitung auch bei begrenzten Hardware-Ressourcen. Das System erleichtert außerdem einen nahtlosen Wechsel zwischen verschiedenen Backends, sodass Nutzer je nach Bedarf die passende Technologie auswählen können. Obwohl OnPrem.LLM für den vollumfänglichen lokalen Einsatz entwickelt wurde, ist es ebenfalls für hybride Einsatzszenarien gerüstet.

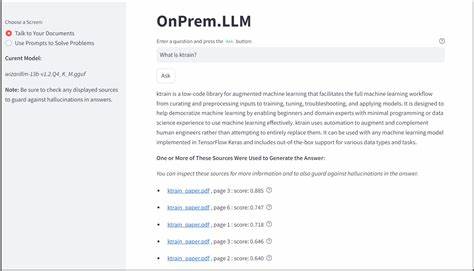

Es erlaubt die Integration mit Cloud-LLM-Anbietern, sofern dies datenschutzrechtlich zulässig und gewünscht ist. Diese Flexibilität ermöglicht eine optimale Balance zwischen Performance und maximaler Datenkontrolle. So können sensible Informationen lokal verarbeitet werden, während weniger kritische Daten in der Cloud analysiert werden – ein wichtiger Vorteil für Unternehmen mit hohen Compliance-Anforderungen. Ein weiterer Aspekt von großer Bedeutung ist die Nutzerfreundlichkeit des Toolkits. Für den Einsatz auch durch nicht-technische Anwender steht eine No-Code-Weboberfläche zur Verfügung, die den Zugang zu den umfangreichen Funktionen deutlich vereinfacht.

Damit können auch Fachabteilungen oder Mitarbeitende ohne Programmierkenntnisse von den Benefits der leistungsfähigen Dokumentenintelligenz profitieren und wertvolle Erkenntnisse aus den eigenen Daten gewinnen. Die Anwendungsgebiete von OnPrem.LLM sind breit gefächert. So können Unternehmen mit sensiblen internen Dokumenten, etwa Personalakten, Verträgen, medizinischen Berichten oder Finanzdokumenten, Inhalte automatisiert extrahieren, klassifizieren und zusammenfassen. Forschungseinrichtungen profitieren von der Möglichkeit, große Mengen wissenschaftlicher Publikationen anonymisiert zu verarbeiten.

Behörden und Institute mit strikten Datenschutzrichtlinien können OnPrem.LLM nutzen, um Dokumente im eigenen Netzwerk sicher zu analysieren, ohne auf externe Cloud-Services angewiesen zu sein. Durch die Kombination von moderner KI-Technologie und einem Fokus auf Datenschutz setzt OnPrem.LLM neue Maßstäbe für den verantwortungsvollen Umgang mit sensiblen Informationen. Während immer mehr Organisationen digitale Transformationsprozesse vorantreiben, entsteht ein hoher Bedarf an Tools, die komplexe Datenanalysen ermöglichen und gleichzeitig die Einhaltung gesetzlicher Datenschutzanforderungen gewährleisten.

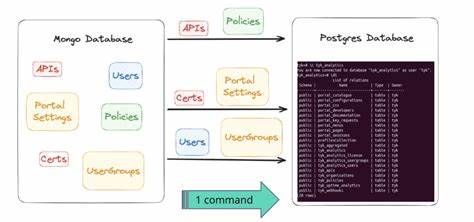

Technisch gesehen stellt das Toolkit durch seine modulare Architektur sicher, dass es sich einfach an unterschiedliche Infrastrukturen anpassen lässt. Anwender können einzelne Komponenten je nach Bedarf ergänzen oder anpassen, etwa für spezielle Dokumenttypen oder zusätzliche Sprachen. Zudem ist die Unterstützung von quantisierten Modellen hervorzuheben, da diese eine ressourcenschonende Ausführung ermöglichen und somit auch auf kleineren Servern oder lokalen Geräten einsetzbar sind. Die Möglichkeit, GPU-Beschleunigung zu nutzen, erhöht die Performance drastisch und erleichtert den Umgang mit großen Datensätzen und komplexen Modellen. Dank der offenen Schnittstellen ist OnPrem.

LLM gut in bestehende IT-Landschaften integrierbar, sodass es sich nahtlos in vorhandene Workflows eingliedern lässt. Das Thema Datenschutz ist in der heutigen Zeit nicht nur eine gesetzliche Verpflichtung, sondern auch ein Wettbewerbsvorteil. Kunden und Partner erwarten, dass ihre Daten sicher und verantwortungsvoll behandelt werden. OnPrem.LLM unterstützt diese Erwartungen, indem es den kompletten Prozess der Dokumentenintelligenz unter die eigene Kontrolle der Organisation stellt und somit das Risiko von Datenlecks und ungewollter Datenweitergabe minimiert.

Darüber hinaus fördert das Toolkit Innovationen in Bereichen wie Natural Language Processing (NLP) und Machine Learning, indem es Forschern und Entwicklern ein leistungsfähiges Werkzeug an die Hand gibt, das sowohl lokal als auch hybrid eingesetzt werden kann. So lassen sich neue Methoden und Anwendungen schnell und sicher prototypen und produktiv einsetzen. Zusammenfassend lässt sich sagen, dass OnPrem.LLM eine bedeutende Entwicklung im Bereich der datenschutzorientierten KI-Anwendungen darstellt. Es verbindet die Leistungsfähigkeit moderner LLMs mit den zwingend erforderlichen Anforderungen an Sicherheit und Datenschutz.

Die breite Unterstützungsbasis verschiedener Backends, die einfache Bedienbarkeit und die Flexibilität bei den Einsatzmodellen eröffnen vielfältige Möglichkeiten für Unternehmen und Institutionen aller Art. In der Zukunft wird die Bedeutung solcher Lösungen weiter zunehmen, da gesetzliche Rahmenbedingungen immer strenger werden und gleichzeitig der Bedarf an intelligenten Auswertungen steigt. Durch OnPrem.LLM wird es möglich, den Spagat zwischen hochmoderner Technologie und maximaler Datenhoheit erfolgreich zu meistern – ein entscheidender Schritt auf dem Weg zu verantwortungsvoller und nachhaltiger Digitalisierung.