Die rasante Entwicklung von Künstlicher Intelligenz und maschinellem Lernen hat in den letzten Jahren viele Branchen nachhaltig verändert. Besonders im Finanztechnologiesektor, kurz Fintech, gewinnen innovative Technologien enorm an Bedeutung. Unter diesen ist die Transformer-Architektur, die ursprünglich für natürliche Sprachverarbeitung konzipiert wurde, zu einem wahren Game-Changer avanciert. Die Fähigkeit von Transformer-Modellen, komplexe Zusammenhänge innerhalb großer Datenmengen zu analysieren, eröffnet im Fintech-Bereich völlig neue Möglichkeiten. Doch wie genau funktionieren Transformer-Modelle, und wie werden sie im Finanzwesen eingesetzt? Zudem stellen sich viele die Frage, wie Hintergrundinformationen und Nutzerkontext in diese hochentwickelten Algorithmen sinnvoll integriert werden können, um präzisere Vorhersagen und passgenaue Dienstleistungen zu ermöglichen.

Im Folgenden werden diese Aspekte eingehend beleuchtet und anhand realer Anwendungsbeispiele veranschaulicht. Transformer-Modelle basieren auf einer Architektur, die es ihnen erlaubt, Zusammenhänge in Sequenzdaten effizient und parallellisiert zu verarbeiten. Ursprünglich von Google für die maschinelle Sprachverarbeitung entwickelt, hat sich diese Technologie tief in viele andere Branchen hineingefressen. Fintech ist hierbei besonders interessant, da hier Daten oft zeitlich sequenziell vorliegen, etwa Transaktionsverläufe oder Nutzerhistorien. Die Transformer-Modelle sind in der Lage, kontextuelle Beziehungen zwischen einzelnen Elementen einer Datenfolge zu identifizieren.

Damit übertreffen sie klassische Modelle bei Aufgaben wie Prognosen, Klassifikationen und Analyse von Zeitreihen oft deutlich. Ein zentraler Vorteil ist die Möglichkeit, Contextual Embeddings zu generieren – das heißt, Datenpunkte werden nicht isoliert betrachtet, sondern im Kontext anderer Daten interpretiert. Gerade im Finanzsektor, wo oft kleine Details entscheidend sein können, ist dieses Merkmal eine große Stärkung. Die Umsetzung von Transformer-Architekturen im Finanzbereich reicht von der Betrugserkennung bei Kreditkartentransaktionen bis hin zur automatisierten Dokumentenanalyse. Unternehmen wie Stripe sind Vorreiter bei der Anwendung von Transformern, da sie in Echtzeit Betrugsmuster erkennen und Zahlungsabwicklungen sicherer machen.

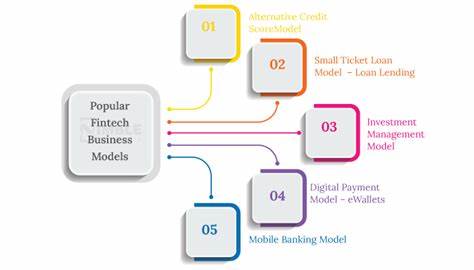

Andere Fintech-Startups setzen diese Technologie ein, um Kreditrisiken effizienter zu bewerten oder personalisierte Finanzprodukte zu gestalten. Dabei ist eine spannende Debatte, wie Hintergrundinformationen, wie Nutzerattribute oder externe Marktdaten, in den Verarbeitungsprozess eingebettet werden können. Schließlich beeinflussen diese Kontextdaten maßgeblich das Verständnis der vorliegenden Informationen. Eine innovative Lösung hierfür ist das Einfügen spezieller Token am Anfang der Transformer-Sequenz – im Fachjargon oft als Token-Preamble bezeichnet. Diese sogenannten Preamble Tokens repräsentieren User-Attribute oder Kontextinformationen, sodass das Modell von Beginn an über wichtige Rahmenbedingungen informiert ist.

Studien und Praxiserfahrungen zeigen, dass diese Vorgehensweise die Leistungsfähigkeit der Modelle bei der personalisierten Datenanalyse und Prognose deutlich verbessert. Ein großer Vorteil von Transformer-Modellen ist die Skalierbarkeit und Anpassungsfähigkeit an verschiedene Datenquellen. Fintech-Anwendungen profitieren davon, indem sie verschiedenste Datenformate miteinander verknüpfen können – sei es strukturierte Finanzdaten, Textinformationen aus Kundenkommunikation oder externe wirtschaftliche Indikatoren. So lässt sich ein umfassendes Bild generieren, das zur Entscheidungsfindung herangezogen wird. Neben der Risikobewertung und Betrugserkennung revolutionieren Transformer auch das Kundenservice-Erlebnis.

Chatbots und virtuelle Assistenten, die auf dieser Technologie basieren, verstehen Nutzeranfragen besser und reagieren auf komplexe Anliegen mit höherer Präzision. Vor allem im Bereich der Kreditvergabe oder der Anlageberatung kann die personalisierte Interaktion mit Kunden dadurch massiv verbessert werden. Die Zukunft von Transformer-Modellen im Fintech-Sektor ist vielversprechend. Die technologiegetriebene Veränderung wird durch weiter steigende Datenverfügbarkeit und immer komplexere Anforderungen an Analyseprozesse weiter vorangetrieben. Gleichzeitig arbeiten Forscher und Entwickler daran, Modelle effizienter zu gestalten, damit sie auch bei enormen Datenmengen in Echtzeit arbeiten können.

Herausforderungen bestehen jedoch weiterhin hinsichtlich Datenschutz und Erklärbarkeit der KI-Entscheidungen. Gerade in Regulierungsbereichen wie dem Finanzwesen sind verständliche Algorithmen und transparente Prozesse unerlässlich. Trotz dieser Hürden sind Transformer-Modelle heute schon integraler Bestandteil vieler moderner Fintech-Lösungen und werden sich in den kommenden Jahren noch stärker durchsetzen. Unternehmen, die frühzeitig auf diese Technologie setzen, profitieren von Wettbewerbsvorteilen durch höhere Genauigkeit, bessere Kundenbindung und innovative Dienstleistungen. Abschließend zeigt sich, dass Transformer-Modelle in Fintech keineswegs ein theoretisches Konzept bleiben, sondern eine lebendige Innovation darstellen, die unsere finanzielle Lebenswelt nachhaltig verändert.

Ihre Fähigkeit, komplexe Zusammenhänge zu erfassen und kontextorientierte Vorhersagen zu treffen, macht sie zu einem unverzichtbaren Werkzeug in der digitalen Transformation der Finanzbranche.