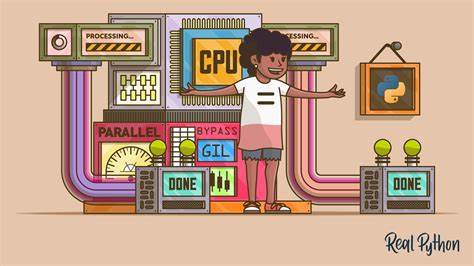

Python zählt zu den beliebtesten Programmiersprachen der Welt und zeichnet sich durch seine einfache Syntax, umfangreiche Bibliotheken und vielseitige Einsatzgebiete aus. Trotz dieser Stärken stößt Python jedoch bei der Ausführung von parallelen CPU-gebundenen Aufgaben auf eine fundamentale Einschränkung – die globale Interpreter-Sperre, besser bekannt als GIL. Die GIL verhindert, dass mehrere Threads innerhalb desselben Prozesses gleichzeitig Python-Bytecode ausführen, was klassische Multithreading parallelisiert werden kann, praktisch unmöglich macht. Für Entwickler, die Performance-Vorteile durch echte Parallelität erzielen möchten, ist das eine Herausforderung. Doch es gibt verschiedene Strategien, um diese Hürde zu überwinden und das volle Potenzial moderner Multi-Core-Prozessoren in Python zu nutzen.

Zunächst ist es wichtig, das Konzept der GIL und ihren Ursprung zu verstehen. Die GIL wurde entwickelt, um die Speicherverwaltung von CPython, der gängigsten Python-Implementierung, zu vereinfachen und die Interpreter-Interne Thread-Sicherheit zu gewährleisten. CPython verwendet eine Referenzzählung zur Speicherverwaltung; ohne die GIL müssten viele tiefgreifende Änderungen vorgenommen werden, um race conditions bei parallelen Zugriffen auf zentrale Datenstrukturen zu verhindern. Die GIL wirkt als eine Art Mutex, der immer nur einem Thread erlaubt, Python-Bytecode auszuführen. Dies bedeutet, dass selbst wenn eine Anwendung mehrere Threads hat, immer nur einer Python-Code auf einem CPU-Kern gleichzeitig ausführen kann.

Dies verhindert echte parallele Ausführung innerhalb eines interpretierten Python-Prozesses. Diese Eigenschaft macht Multithreading in Python besonders bei CPU-gebundenen Berechnungen ineffizient, denn trotz mehrerer Threads nutzt die Anwendung meist nur einen Prozessor vollständig aus. Interessanterweise ist die Situation bei I/O-bound Tasks eine ganz andere. Dort gibt es häufig Wartezeiten, zum Beispiel auf Datenbankantworten oder Netzwerkkommunikation. Während diese Wartezeiten auftreten, gibt die GIL andere Threads frei, sodass mehrere I/O-gebundene Threads scheinbar parallel ausgeführt werden, was in der Praxis zu einer Reduzierung von Latenzzeiten führt.

Wer jedoch CPU-gebundene parallele Verarbeitung in Python realisieren möchte, kann auf verschiedene bewährte Methoden zurückgreifen. Die klassische und am weitesten verbreitete Lösung besteht darin, auf Prozesse statt auf Threads zu setzen. Das multiprocessing-Modul erlaubt es, mehrere unabhängige Python-Interpreter-Prozesse zu starten, die separate Speicherbereiche haben und daher ihre eigene GIL besitzen. Diese Prozesse können auf unterschiedlichen CPU-Kernen parallel ausgeführt werden. Das Zweigeteilte ist jedoch, dass die Kommunikation zwischen Prozessen teurer ist und Daten serialisiert und übertragen werden müssen.

Für kleinere Datenmengen ist dies unproblematisch, bei größeren Datenmengen entsteht jedoch ein erheblicher Overhead, der den Nutzen der Parallelisierung schmälert. Zur Anwendungserleichterung hat Python concurrent.futures eingeführt, welches eine abstrahierte Schnittstelle für das Verwalten von Thread- und Prozesspools bietet. Es vereinfacht die Verteilung von Aufgaben auf Worker, wobei für CPU-intensive Aufgaben besonders der ProcessPoolExecutor geeignet ist. Gleichzeitig bleibt die Serialisierung der Daten zwischen Prozessen eine zu beachtende Limitation.

Abgesehen von Prozess-basierten Ansätzen gibt es auch Lösungen, die die GIL umgehen, indem sie auf alternative Interpreter oder native Erweiterungen setzen. Einige Python-Interpreter wie Jython oder IronPython verfügen ursprünglich nicht über eine GIL, da sie die Multithreading-Modelle ihrer jeweiligen Laufzeitumgebungen – der JVM beziehungsweise CLR – verwenden. Diese Projekte sind heutzutage allerdings veraltet oder werden nicht mehr aktiv gepflegt. Innovativere Ansätze finden sich in Projekten wie nogil, einem Fork von CPython, der versucht, eine GIL-freie Version zu realisieren, oder in der laufenden Diskussion rund um PEP 703, die Python ohne GIL für Multithreading öffnen möchte. Diese Ideen stecken aber noch in den Kinderschuhen und sind weder stabil noch vollständig kompatibel.

Eine sehr gebräuchliche und leistungsfähige Methode sind native Erweiterungen, die zeitweise die GIL freigeben, um reine C-Funktionen auf mehreren Threads parallel auszuführen. Der Einsatz von Cython bietet dabei eine elegante Brücke. Cython erlaubt es Python-Code mit Typhinweisen und zusätzlichen Anweisungen zu versehen, um C-Extensions zu kompilieren, die während kritischer Berechnungen die GIL freigeben. So lassen sich CPU-intensive Rechenoperationen auf mehrere Threads unserer Umgebung verteilen, während der Python-Interpreter keine komplette Neuimplementierung benötigt. Auch das Schreiben eigener C-Erweiterungsmodule mittels des Python/C-APIs erlaubt die Verknüpfung nativer, parallelisierbarer Funktionen mit Python.

Entscheidend ist dabei die korrekte Verwendung der Py_BEGIN_ALLOW_THREADS und Py_END_ALLOW_THREADS Makros, die den GIL während der Ausführung von reinem C-Code freigeben. Dadurch können mehrere Threads echten parallelen Code ausführen, ohne sich die GIL zu blockieren. Ein pragmatischer Weg, um native Bibliotheken in Python zu nutzen, ist das ctypes-Modul. Hiermit kann man dynamisch geladene C-Bibliotheken aufrufen, die unabhängig von der GIL ausgeführt werden können. Das eröffnet ohne aufwändiges Binden oder Kompilieren die Möglichkeit, parallele Berechnungen auszulagern.

Allerdings kann das Marshaling von komplexen Datenstrukturen und die damit verbundene Übertragungskosten limitierende Faktoren sein. Für numerische und wissenschaftliche Rechnungen haben sich spezialisierte Bibliotheken wie NumPy als besonders effektiv erwiesen, da sie intern auf Hochleistungsbibliotheken wie BLAS und LAPACK zurückgreifen, die massiv parallel arbeiten. Diese Strategie verlagert rechenintensive Arbeit in GIL-freien nativen Code, was bei Datengrößen ab bestimmten Schwellen große Geschwindigkeitsvorteile bietet. In der Praxis ist die Wahl zwischen Prozessen, nativen Erweiterungen, alternativen Interpreter und spezialisierten Bibliotheken immer eine Frage des Anwendungsfalls. Für kleine Tasks mit hohem Kommunikationsbedarf kann Multithreading mit Modulen wie concurrent.

futures sinnvoll sein. Für Hochleistungs-CPU-Berechnungen empfiehlt sich der Multiprozess-Ansatz oder die Auslagerung kritischer Algorithmen in C/C++ mit GIL-Freigabe. Als praktisches Beispiel kann man die parallele Verarbeitung von Gigapixel-Bildern in einem Desktop-Programm betrachten. Hier wurden die rechenintensiven Farbkorrekturen in C implementiert, wobei jeder Farbkandel in einem Thread behandelt wird. Mittels ctypes wurde der Speicher von NumPy-Arrays direkt an C übergeben, sodass ein Shared-Memory-Parallelsystem entstand, das die GIL umgeht und eine hervorragende Performance ermöglicht.

Die CPU-Kerne laufen auf Volllast und die Reaktionsfähigkeit der GUI wird garantiert. Die Parallelausführung in Python erfordert somit ein tief greifendes Verständnis der Grenzen der GIL, von Speicherverwaltung, Datenaustausch zwischen Python und nativen Codes, sowie fundierte Kenntnisse in C-Erweiterungen oder fortschrittlichen Tools wie Cython. Trotz der Herausforderung bieten alle vorgestellten Techniken enorme Chancen, die Effizienz von Python-Anwendungen maßgeblich zu steigern und moderne CPU-Architekturen optimal auszunutzen. Parallelentwicklung und Leistungsoptimierung sind heutzutage unerlässliche Fähigkeiten in der Softwareentwicklung. Für Python-Programmierer ist es entscheidend, die Wirkungsweise der GIL zu kennen, um bewusst und gezielt geeignete Techniken einzusetzen.