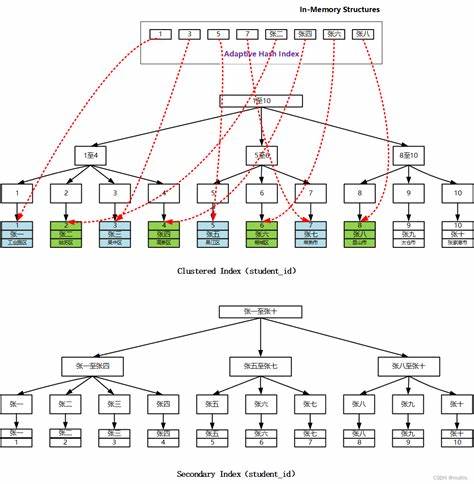

In der Welt der Informatik sind Hash-Tabellen eine der grundlegenden Datenstrukturen für schnellen Zugriff und effiziente Speicherung von Daten. Sie sind aus nahezu jeder Programmiersprache und Anwendung nicht mehr wegzudenken – vom Caching in Webanwendungen über Datenbanken bis hin zu Compiler-Implementierungen. Die Funktionsweise von Hash-Tabellen basiert auf der Verwendung einer Hash-Funktion, welche die Schlüssel auf einen Index im Speicher abbildet, um so einen schnellen Zugriff auf die gespeicherten Werte zu ermöglichen. Dennoch stoßen klassische Hash-Tabellen mit festgelegten, statischen Hash-Funktionen häufig an ihre Grenzen, wenn es darum geht, unterschiedliche Schlüsselverteilungen und Anwendungsszenarien optimal zu bedienen. Hier setzt Adaptive Hashing an, ein innovativer Ansatz, der dynamisch auf die tatsächlichen Schlüsselverteilungen reagiert und somit sowohl Leistungssteigerungen als auch mehr Robustheit ermöglicht.

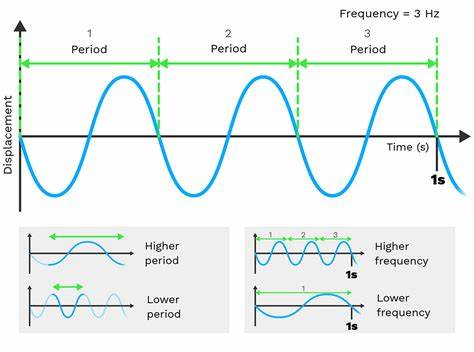

Adaptive Hashing ist ein relativ neues Paradigma, das darauf abzielt, eingebettete und allgemeine Hash-Tabellen deutlich effizienter zu gestalten, indem die Hash-Funktionen während der Laufzeit an die Eigenschaften der eingefügten Schlüssel angepasst werden. Anders als bei traditionellen Hash-Methoden, bei denen der Hash-Algorithmus häufig fixiert ist, erlaubt Adaptive Hashing es, verschiedene Hash-Funktionen oder -Strategien dynamisch auszuwählen oder sogar zu kombinieren, um die Zahl der Kollisionen zu minimieren und die Cache-Ausnutzung zu verbessern. Eine zentrale Herausforderung, die Adaptive Hashing adressiert, liegt darin, dass klassische theoretische Betrachtungen von Hash-Tabellen primär die asymptotischen Laufzeiten in Worst-Case-Szenarien fokussieren. Diese Herangehensweise betrachtet die Hash-Funktion meist als zufällig aus einer Familie ausgewählt, was in der Praxis so nicht gegeben ist. Zwar sind diese theoretischen Ergebnisse wertvoll, doch werden entscheidende konstante Faktoren häufig vernachlässigt – jene Faktoren, die tatsächlich signifikanten Einfluss auf die Performance haben und in realen Programmen über Erfolg oder Misserfolg entscheiden.

Des Weiteren ist es in der Praxis üblich, dass der Hash-Algorithmus für die gesamte Lebensdauer einer Hash-Tabelle festgelegt wird. Adaptive Hashing ermöglicht hingegen eine dynamische Anpassung, die kontinuierlich auf unterschiedlichen Last- und Schlüsselbedingungen basiert. Insbesondere wird die Anzahl der Kollisionen überwacht, ebenso wie die Struktur der Kollisionsketten und das Wachstum der Tabelle. Ein sehr spannender Aspekt von Adaptive Hashing ist die Möglichkeit, Hash-Funktionen zu wählen, die auf die tatsächliche Datenverteilung optimiert sind. Während Perfect Hashing theoretisch optimale Zuordnungen ermöglicht, ist diese Methode oft zu aufwendig für dynamische Datenstrukturen, weil sie entweder die Schlüsselmengen fixiert voraussetzt oder erhebliche Berechnungskosten verursacht.

Adaptive Hashing versucht genau diese demokratische Lücke zu schließen, indem es eine Online-Optimierung realisiert – also die Auswahl und Anpassung der Hash-Funktion während der Nutzung der Datenstruktur. Ein Beispiel für Adaptive Hashing findet sich in der Implementierung von Hash-Tabellen des bekannten Lisp-Systems SBCL (Steel Bank Common Lisp). Hier wurde ein mehrstufiges System umgesetzt, das sich an verschiedenen Metriken orientiert: Bei kleinen Tabellen wird zunächst eine konstante Hash-Funktion verwendet, die effektiv eine lineare Suche bedeutet. Dies ist sehr günstig für geringe Schlüsselzahlen, da der Overhead durch komplexe Hash-Funktionen hier noch höher wäre als der Nutzen. Sobald die Anzahl der Einträge jedoch steigt und eine Vergrößerung der Tabelle ansteht, wird auf eine einfache Hash-Funktion umgeschaltet, die auf einer Bitverschiebung basiert.

Diese spezielle Funktion ist besonders effizient bei Sequenzen von Schlüsseln, die arithmetischen Mustern folgen können, was in der Speicherbelegung von ähnlich typisierten Objekten häufig der Fall ist. Sollte die Zahl der Kollisionen dennoch zu stark wachsen, erfolgt eine weitere Stufe, bei der ein bewährter, aber etwas teurerer Hash-Algorithmus verwendet wird. Dieser ist für breitere Anwendungsszenarien optimiert und wurde im SBCL-Umfeld auf hohe Robustheit feinjustiert. In einer letzten Eskalationsstufe kommt ein genereller, zuverlässiger Hash wie MurmurHash zum Einsatz, der sehr geringe Kollisionen garantiert, aber auch etwas höhere Kosten durch komplexere Berechnungen hat. Adaptive Hashing zeigt hier eindrucksvoll, wie verschiedene Algorithmen intelligent kombiniert und adaptiv gewechselt werden können, um jeweils das beste Verhältnis aus Aufwand und Effektivität zu erzielen.

Für Schlüssel, die aus zusammengesetzten Datenstrukturen bestehen, wie bei EQUAL-Hash-Tabellen in Lisp, werden ebenfalls clevere Strategien genutzt. Insbesondere bei komplexen Schlüsseln, die etwa aus Strings oder Listen bestehen, ist die Hash-Berechnung oft der dominierende Leistungsfaktor. Adaptive Hashing reduziert hier den Aufwand, indem nur charakteristische Bestandteile der Schlüssel gehasht werden – beispielsweise nur die ersten und letzten Zeichen bei Strings oder die ersten Elemente in Listen. Falls dennoch viele Kollisionen entstehen, wird die Granularität der Hash-Funktionen angepasst, zum Beispiel durch Erhöhung der Anzahl der zu berücksichtigenden Schlüsselbestandteile. Diese graduelle Vorgehensweise besitzt den Vorteil, dass sie einerseits schnelle Zugriffe für häufige, unkomplizierte Schlüsseltypen ermöglicht, andererseits dennoch robuste Performance gewährleistet, falls die Schlüsselstrukturen unerwartet komplex werden oder sich stark ändern.

Die Vorteile von Adaptive Hashing sind sowohl theoretischer als auch praktischer Natur. Zum einen führt die dynamische Anpassung der Hash-Funktionen zu einer signifikanten Reduktion von Kollisionen, was wiederum die Suchzeiten und den Speicherbedarf minimiert. Zum anderen wird die Speicherzugriffszeit optimal ausgenutzt, indem die Daten besser im Cache gehalten und die Häufigkeit von Cache-Misses reduziert wird. Die Reduktion von Verzögerungen und internen Warteschlangen durch immer gleichbleibende Hash-Funktionen, die für bestimmte Datensätze ineffizient sind, sorgt für mehr Stabilität und verlässliche Leistung in realen Anwendungen. Die Einführung von Adaptive Hashing hat im SBCL-Compiler bereits messbare Verbesserungen gezeigt, die sich in erhöhtem Durchsatz und geringeren Laufzeiten ausdrücken.

Dabei profitiert besonders der häufige Fall von Objekten ähnlicher Typen, bei denen sich arithmetische Muster oder ähnliche binäre Repräsentationen leicht erkennen und nutzen lassen. Diese Cases sind im Anwendungsalltag häufig und somit besonders relevant. Für die Zukunft bergen adaptive Techniken großes Potenzial für weitere Optimierungen in unterschiedlichsten Bereichen, in denen dynamische Datenstrukturen eingesetzt werden. Gerade in Bereichen wie Künstlicher Intelligenz, Echtzeitsystemen und datenintensiven Applikationen kann Adaptive Hashing dazu beitragen, Flaschenhälse bei der Datenzugriffszeit entscheidend zu reduzieren und damit größere Skalierbarkeit und Robustheit zu erreichen. Die Forschung arbeitet außerdem daran, die Kosten für das Umschalten zwischen Hash-Methoden weiter zu senken, um noch feiner auf Veränderungen bei Datenzustand und Last reagieren zu können.

Messergebnisse aus Praxistests belegen, dass adaptive Systeme die meist starren Vorgaben traditioneller Hash-Tabellen deutlich übertreffen können. Während einfache Hash-Funktionen oft instabil bei unerwarteten Verteilungen von Schlüsseln reagieren, gewährleisten adaptive Lösungen eine besser ausbalancierte Leistung auch bei extremen Szenarien. Adaptive Hashing stellt somit eine wichtige Weiterentwicklung im Bereich leistungsoptimierter Datenstrukturen dar. Entwickler, die auf hohe Performance bei dynamischen oder unbekannten Datensätzen angewiesen sind, sollten diese Technik in Betracht ziehen, da sie eine smarte Balance zwischen Rechenaufwand, Speicherverbrauch und Robustheit bietet. Zusammenfassend lässt sich sagen, dass Adaptive Hashing als Innovationsschub die herkömmlichen Methoden im Hinblick auf Flexibilität und Effizienz übertrifft.

Durch die kontinuierliche Anpassung an die vorliegenden Schlüsselverteilungen realisiert es eine nahezu optimale Nutzung der verfügbaren Ressourcen. Moderne Systemprogramme, Compiler und Anwendungen werden so schneller, robuster und skalierbarer – ein wichtiger Schritt, um mit den immer komplexeren Anforderungen heutiger Softwarelandschaften Schritt zu halten.