Im Zeitalter der Digitalisierung nimmt die Menge an verfügbaren Webinhalten stetig zu. Informationen sind zwar zahlreich, aber häufig unstrukturiert und schwer automatisiert weiterzuverarbeiten. Genau hier setzt die Technologie der strukturierten Webdatenextraktion an, die es ermöglicht, relevante Inhalte direkt aus HTML-Dokumenten zu isolieren, zu analysieren und in maschinenlesbare Formate wie JSON zu überführen. Besonders im Kontext von Retrieval-Augmented Generation (RAG) – einem vielversprechenden Ansatz zur Kombination von vortrainierten Sprachmodellen und externem Wissensabruf – gewinnt diese Fähigkeit enorm an Bedeutung. Mit RAG können KI-Systeme wesentlich genauer und fundierter antworten, indem sie nicht nur auf ihr trainiertes Wissen zurückgreifen, sondern durch effektives Abrufen von relevanten Inhalten aus Quellen wie dem Web ergänzt werden.

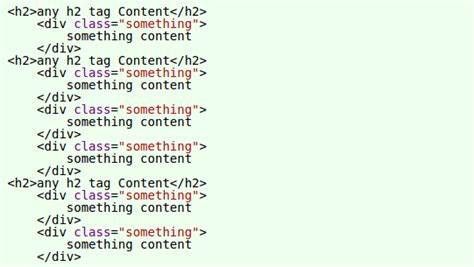

Dabei ist die Qualität und Struktur der zugrunde liegenden Daten entscheidend. Das rohe HTML einer Webseite ist für KI-Modelle und Automatisierungslösungen meist schwer nutzbar, weil es neben sichtbarem Text auch viele irrelevante Elemente wie Skripte, Navigationsleisten oder Werbung enthält. Durch gezieltes Scraping und Parsing lassen sich diese Störeinflüsse eliminieren und die essenziellen Inhalte extrahieren. Moderne Proof-of-Concept (POC)-Lösungen zeigen bereits eindrucksvoll, wie man HTML-Seiten effizient in wohlgeformten JSON-Output überführen kann. Dieser strukturierte Datensatz beschreibt die einzelnen Sektionen der Webseite, wie Texte, Überschriften, Bilder und Links, jeweils klar gekennzeichnet und für die Weiterverarbeitung optimiert.

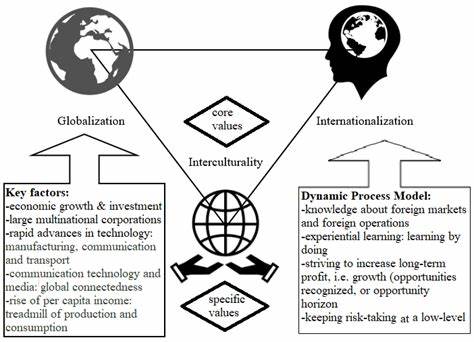

Insbesondere für Entwickler und Forscher, die RAG-Modelle einsetzen, ist eine solche strukturierte Datenbasis der Schlüssel, um zielgerichtete Abfragen zu beantworten oder semantisch relevante Zusammenfassungen zu generieren. Der Nutzen geht jedoch weit über RAG hinaus: Unternehmen können durch automatisiertes Content-Parsing die Wettbewerbsanalyse verbessern, Marktforschung gezielter betreiben und personalisierte Benutzererlebnisse schaffen. Dabei sind Faktoren wie Datengenauigkeit, Geschwindigkeit bei der Verarbeitung großer Mengen an Webseiten und Flexibilität gegenüber verschiedenen Weblayouts wichtig. Die Implementierung effektiver Scraping-Tools verlangt nicht nur technisches Know-how bei der Handhabung von HTTP-Anfragen und HTML-Strukturen, sondern auch das Verständnis von Regular Expressions, DOM-Manipulation und idealerweise Machine Learning für die Inhalteklassifikation. Fortschritte in der KI, wie Transformer-Modelle und NLP-Frameworks, unterstützen dabei, semantisch relevante Inhalte besser zu identifizieren und zu extrahieren.

Gleichzeitig ist die Einhaltung ethischer und rechtlicher Vorgaben, etwa bezüglich Datenschutz und Urheberrecht, bei der Webdatenextraktion unerlässlich. Es sollte stets geprüft werden, ob das Scraping mit den Nutzungsbedingungen der Ziel-Webseite konform ist und welche Daten überhaupt legal verarbeitet werden dürfen. Die Kombination aus strukturiertem Scraping und KI-gestützter Analyse zeichnet sich als zukunftsweisender Trend ab, der viele Branchen transformieren kann. Von digitalen Assistenten, die präzise Antworten liefern, über automatisierte Nachrichtenaggregation bis hin zu intelligenten Suchmaschinen, die relevante Informationen in Sekundenschnelle bereitstellen – die Grundlage ist eine saubere, strukturierte Datenbasis. Zusammenfassend lässt sich festhalten, dass das Extrahieren strukturierter JSON-Daten aus HTML eine Schlüsseltechnologie für moderne KI-Anwendungen wie RAG ist.

Durch gezielte Entwicklung und Nutzung solcher POC-Lösungen können Entwickler den Schritt vom chaotischen Webinhalt zur geordneten Wissensquelle erfolgreich meistern und so kreativ und effizient mit großen Datenmengen umgehen. Die Zukunft gehört intelligenten Systemen, die auf klar gegliederte und hochwertig verarbeitbare Daten zugreifen und dadurch einen echten Mehrwert schaffen.