Die Open Source Welt steht durch die rasante Entwicklung künstlicher Intelligenz (KI) vor neuen Herausforderungen, die sowohl Chancen als auch Risiken mit sich bringen. Ein besonders prägnantes Beispiel dafür ist das Curl-Projekt, das von Daniel Stenberg geleitet wird. Curl, ein weitverbreitetes und essenzielles Kommandozeilen-Tool zum Übertragen von Daten, sieht sich in letzter Zeit einer Flut von KI-generierten Sicherheitsberichten ausgesetzt. Diese Berichte stellen das Projekt und seine Maintainer vor erhebliche Probleme und werfen wichtige Fragen zur Nutzung von KI in der Open Source-Community auf. Daniel Stenberg beschreibt die Lage als eine fast schon absurde Ironie.

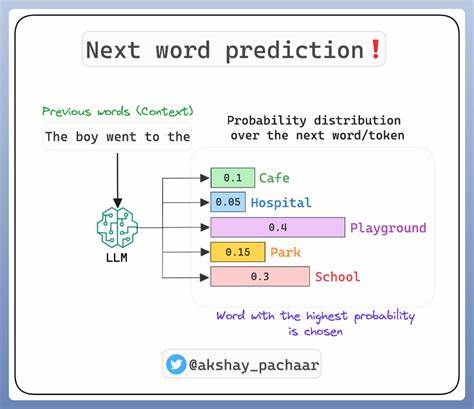

Curl, ein Werkzeug, das viele versierte Entwickler theoretisch in wenigen Tagen programmieren könnten, wird von einer Welle scheinbar gut formulierter, aber letztlich kaum nutzbarer Sicherheitsmeldungen überschwemmt. Diese Berichte werden zunehmend von großen Sprachmodellen generiert – sogenannten Large Language Models (LLMs). Weil es heute leicht ist, automatisch Texte zu erstellen, sinkt die Schwelle, scheinbar valide Sicherheitsberichte einzureichen, auf nahezu null. Diese Flut von Berichten bindet wertvolle Zeit und Ressourcen des Curl-Teams. Sicherheitserfordernisse verlangen eine gründliche Prüfung jeder Meldung – unabhängig davon, ob sie von Menschen oder KI stammt.

Die Folge ist eine erhebliche Belastung für die Maintainer, die ohnehin häufig mit begrenzten Kapazitäten kämpfen. Die zahlreichen KI-generierten Berichte sind nicht selten ungenau, enthalten fehlerhafte technische Details oder sind schlichtweg erfunden. So berichtete Daniel von Beispielen, in denen fehlerhafte Debugging-Informationen für nicht existierende Funktionen oder erfundene Speicheradressen genannt wurden. Das verursacht eine immense Zeitverschwendung und behindert effektive Sicherheitsarbeit. Dabei darf nicht übersehen werden, dass Curl über ein legitimes Bug-Bounty-Programm verfügt, in dem Bestätigungen von Sicherheitslücken finanziell belohnt werden.

In den vergangenen sechs Jahren wurden 78 Sicherheitslücken mit insgesamt 86.000 US-Dollar entlohnt, was zeigt, dass echte Sicherheitsprobleme ernsthaft und professionell behandelt werden. Während ein korrekt eingereichter Bug-Bounty-Bericht schnelle und konzentrierte Arbeit im Team bedeutet, wirkt ein falsch eingereichter KI-Report wie eine Art Denial-of-Service-Attacke auf die Ressourcen von Curl und anderen Open Source Projekten. Aufgrund dieser Entwicklungen sah sich Daniel Stenberg gezwungen, eine neue Richtlinie zum Umgang mit KI-generierten Beiträgen zu entwickeln. Die anfängliche Reaktion war stringent: Nutzer, die KI-Berichte einreichen, ohne dies offen zu legen, werden dauerhaft gesperrt.

Gleichzeitig möchte der Curl-Maintainer keine unreflektierte Feindseligkeit gegenüber KI ausüben. Stattdessen wurde eine differenzierte, dreiteilige Politik erarbeitet, die eine verantwortungsbewusste Nutzung von KI in verschiedenen Bereichen des Projekts regelt. Diese neue Politik fordert zuerst, dass bei Sicherheitsberichten jede Form der KI-Hilfe unbedingt offengelegt wird. Darüber hinaus muss sichergestellt werden, dass der Bericht vollumfänglich korrekt ist. Dieser Ansatz soll Transparenz sichern und gleichzeitig Vertrauen schaffen.

Daniel Stenberg hält es für möglich, dass KI-Tools zukünftig tatsächlich eine wertvolle Unterstützung bei der Sicherheitsforschung bieten könnten, sofern sie korrekt eingesetzt und verstanden werden. Der zweite Teil der Richtlinie bezieht sich auf Pull Requests, also Beiträge zum Quellcode. Hier wird die Qualität des Codes in den Vordergrund gestellt, unabhängig davon, ob der Code mithilfe von KI-Assistenten wie GitHub Copilot entstanden ist oder nicht. Diese pragmatische Haltung erkennt die Realität an, dass Entwickler verstärkt auf KI-Programme zurückgreifen, um ihre Arbeit zu erleichtern. Die entscheidende Messlatte bleibt die Sauberkeit, Sicherheit und Wartbarkeit des eingereichten Codes.

Der dritte Abschnitt behandelt die Verwendung von KI bei Sprachübersetzungen. Daniel Stenberg erkennt an, dass KI-basierte Übersetzungstools eine große Hilfe für Nicht-Muttersprachler sein können, um in der internationalen Open Source Community effektiv zu kommunizieren. Dabei wird aber auch auf die möglichen Schwächen hingewiesen: KI-übersetzte Texte klingen mitunter noch unnatürlich oder roboterhaft. Wichtig ist, dass die Nutzung solcher Hilfsmittel transparent gemacht wird. Insgesamt zeichnet sich bei Curl ein verantwortungsvoller und pragmatischer Umgang mit KI ab.

Im Podcastgespräch zwischen Daniel Stenberg und Josh Bressers wird die Entwicklung der KI mit der frühen Fuzzing-Technologie verglichen. Während Fuzzing anfangs als wenig vielversprechend galt, hat es sich heute zu einem unverzichtbaren Werkzeug in der Sicherheitsforschung entwickelt. Ähnlich könnten KI-Technologien langfristig an Nutzwert gewinnen, doch gleichzeitig ist entscheidend, realistisch und kritisch an ihre Einsatzmöglichkeiten heranzugehen. Die Erfahrungen des Curl-Projekts bieten auch anderen Open Source Gemeinschaften wertvolle Impulse. Es bleibt jedoch jedem Projekt überlassen, wie es mit KI umgeht.

Einige könnten ähnliche Richtlinien wie Curl einführen, andere verzichten bewusst darauf. Wichtig ist, dass die Maintainer selbst die Grenze ziehen, die für sie und ihre Ressourcen sinnvoll ist. Diese Situation unterstreicht eine grundlegende Herausforderung in der Open Source Welt: Maintainer verfügen meist über begrenzte Zeit und Geduld, um ihre Projekte am Leben zu erhalten. Unnötige Aufwände durch unqualifizierte oder irreführende Beiträge können den Fortschritt erheblich bremsen. Transparenz, klare Richtlinien und ein respektvoller Umgang mit neuen Technologien wie KI können helfen, diese Probleme zu mildern.

Die Debatte um Curl vs. KI steht für eine viel größere Diskussion, die in den kommenden Jahren noch deutlich an Fahrt aufnehmen wird. Wie kann Open Source effektiv von KI profitieren, ohne die eigene Integrität und Effizienz zu gefährden? Welche ethischen und praktischen Rahmenbedingungen sind nötig, um den Einsatz von KI verantwortungsvoll zu gestalten? Curl gibt hier ein Beispiel, wie durch Offenheit, klare Regeln und pragmatische Herangehensweisen ein ausgewogenes Verhältnis geschaffen werden kann. Abschließend lässt sich festhalten, dass die KI im Sicherheitskontext von Open Source Projekten zwar eine potenzielle Ressource darstellt, aber derzeit mehr Aufwand als Nutzen verursacht, wenn sie unreflektiert eingesetzt wird. Der Weg zu wirklich nützlichen KI-gestützten Sicherheitsprozessen ist noch lang und erfordert die Weiterentwicklung der Technologie ebenso wie den Aufbau von Vertrauen und Kompetenzen im Umgang mit ihr.

Curl zeigt den Weg auf, wie Projekte ihre Ressourcen schützen können, ohne den technologischen Fortschritt abzulehnen. Während sich die Situation weiterentwickelt, wird es spannend zu beobachten sein, welche Lösungen und Standards sich in der Open Source Community etablieren werden, um die Synergie von Mensch und Maschine im Dienste der Sicherheit und Stabilität bestmöglich zu gestalten.

![Google Data Center Security [video] (2020)](/images/3E92BEAD-1FB7-4659-B0DB-C5FD17877246)