Zufallszahlengenerierung ist fundamental in vielen Bereichen der Informatik, von Computerspielen über statistische Simulationen bis hin zu komplexen wissenschaftlichen Berechnungen. Besonders herausfordernd ist die Erzeugung von Zufallszahlen im Gleitkommaformat, die zwischen 0 und 1 liegen und eine gleichmäßige Verteilung aufweisen sollen. Obwohl heutzutage viele Programmiersprachen und Bibliotheken eine scheinbar einfache Methode zur Generierung solcher Zahlen nutzen, zeigen tiefere Analysen bedeutende Schwächen dieser Verfahren auf. In der Praxis entsteht häufig eine Verzerrung im Verteilungsraum, und bestimmte Wertebereiche bleiben unerreichbar, was zu einer fehlerhaften Simulation oder Analyse führen kann. Die Ursache liegt dabei in der Eigenheit, wie Gleitkommzahlen intern als Tupel aus Sign, Exponent und Mantisse gespeichert und berechnet werden.

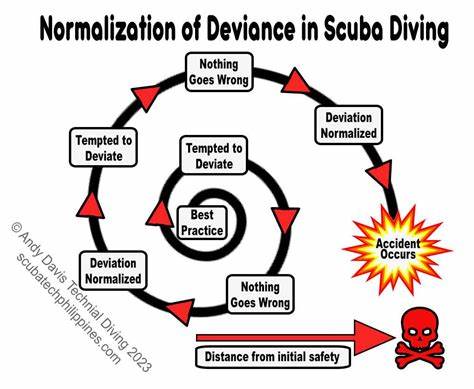

In der gängigen Praxis wird etwa eine große Zufallszahl generiert, in eine Gleitkommazahl umgewandelt und anschließend durch eine Potenz von zwei dividiert, um eine Zahl im Intervall [0,1) zu erzeugen. Dieses Vorgehen scheint zunächst korrekt, da die erzeugte Zahl dem Präzisionsgrad der Gleitkommazahlen entspricht. Bei genauerem Hinsehen fällt jedoch auf, dass nur ein Bruchteil aller möglichen Gleitkommazahlen in diesem Bereich erreichbar ist. Ein Grund dafür ist, dass die Verteilung der Gleitkommazahlen selbst nicht gleichmäßig, sondern exponentiell ist: Je näher die Werte bei Null liegen, desto dichter liegen sie beieinander, während sie bei höheren Zahlen weiter auseinanderliegen. Daraus ergibt sich, dass herkömmliche Verfahren eigentlich eine Art Festkommazahlengenerator simulieren, der zwar intuitiv erscheint, jedoch in Wahrheit eine ungleiche Gewichtung der Bits verursacht und dabei die geringwertigen Bits verzerrt.

Dies hat nicht nur theoretische Relevanz, sondern zeigt sich auch praktisch in uneinheitlichen Zufallszahlen, was die Aussagekraft und Genauigkeit datengetriebener Systeme beeinträchtigt. In jüngster Zeit wurde ein neuer Algorithmus entwickelt, der die Schwächen dieser traditionellen Herangehensweise überwinden kann. Er basiert auf einer zweistufigen Methode: Im ersten Schritt wird eine Grobgenauigkeit errechnet, mit der das Intervall in Abschnitte zerlegt wird, die in einem festgelegten Präzisionsbereich liegen. Im zweiten Schritt wird die niedrigere Signifikanz durch das ergänzende 'Zurückfüllen' der fehlenden Bits realisiert, wodurch die Zufälligkeit der wenig signifikanten Bits gewährleistet wird. Dabei wird ein Verfahren angewandt, das rekursiv in Unterintervalle verzweigt, sollten in der ersten Phase Nullwerte entstehen.

Dieses Verfahren ist hoch effizient und nutzt die Tatsache aus, dass die Wahrscheinlichkeit, in einer bestimmten exponentiellen Range zu landen, sich exakt aus den Eigenschaften des Gleitkommazahlensystems ableiten lässt. Der innovative Algorithmus ist zudem so optimiert, dass die im Standardverfahren häufig auftretenden Schleifen und bedingte Verzweigungen kaum Einfluss auf die Performance haben, da sie statistisch äußerst selten zur Anwendung kommen. Die Implementierung erlaubt je nach Bedarf unterschiedliche Rundungsmodi – das heißt, ob nach oben, unten oder am nächsten Wert gerundet werden soll – und beeinflusst dadurch subtil die Verteilung der erzeugten Zahlenspanne. Die mathematische Grundlage beruht auf der exakten Berechnung der Exponenten- und Mantissabereiche der Gleitkommazahlen und der Definition der Wahrscheinlichkeiten für die einzelnen Zahlen. Dabei wird der Unterschied zwischen idealisierten reellen Zufallszahlen und ihren Gleitkommadarstellungen rigoros beachtet.

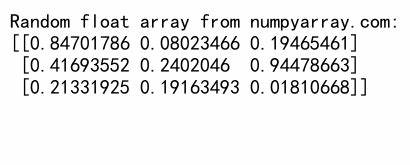

Durch die genaue Modellierung der Wahrscheinlichkeitsverteilungen können Zufallszahlen erzeugt werden, deren Verteilung statisch vollkommen neutral ist – eine Eigenschaft, die sowohl in Simulationen als auch in statistischen Verfahren von großer Bedeutung ist. Die praktische Umsetzung des Algorithmus erfolgt beispielhaft in der Programmiersprache Go, wobei spezielle Bitmanipulationen zum Kombinieren von Mantisse und Exponent sowie zur Berechnung der Bits im Gleitkommazahlenformat verwendet werden. Die Architektur nutzt dabei die Möglichkeit, Gleitkommazahlen als rohe binäre Wörter zu verarbeiten, diese zu verändern und anschließend zurück in die Gleitkommadarstellung umzuwandeln. Auch werden spezielle Randfälle wie Subnormalzahlen oder den Underflow im Exponentenbereich berücksichtigt, um die Korrektheit zu gewährleisten und numerische Stabilität sicherzustellen. Im direkten Vergleich zu klassischen Methoden zeigt dieser Algorithmus klare Vorteile: Während traditionelle Verfahren die niedrigstwertigen Bits der generierten Zufallszahlen systematisch verzerren und in sehr großen Stichproben Abweichungen von der Gleichverteilung sichtbar werden, erzeugt der neue Algorithmus völlig unvoreingenommene Zufallszahlen auch auf den kleinen Signifikanzstufen.

Dies führt zu mehr statistischer Genauigkeit bei der Verarbeitung von Gleitkommazahlen in Anwendungen. Zudem wurde durch Benchmarks belegt, dass die Methode trotz der komplexeren Logik im Durchschnitt keineswegs langsamer arbeitet als einfache Festkommazahlen-Generierung durch Division, vor allem wenn moderne Prozessorfeatures wie Branch Prediction genutzt werden. Ein kleiner Nachteil ist, dass der Algorithmus nicht so leicht vektorisiert werden kann – ein Punkt, der jedoch durch potenzielle künftige Optimierungen behoben werden könnte. Die Bedeutung dieser verbesserten Zufallszahlgenerierung ist vielfältig: Für Wissenschaftler, die Simulationen mit enormer Präzision durchführen, ist jeder noch so kleine Fehler in der Verteilung kritisch. Auch in der Kryptographie können gleiche Wahrscheinlichkeitsverteilungen für bestimmte Gleitkommazahlen eine Rolle spielen.