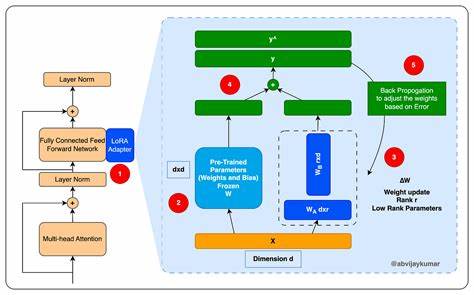

Die rasante Entwicklung im Bereich der künstlichen Intelligenz hat zu leistungsstarken Large Language Models (LLMs) geführt, die komplexe sprachliche Aufgaben mit hoher Präzision bewältigen können. Allerdings ist der Ressourcenbedarf für Training und Einsatz der großen Modelle oftmals prohibitiv. Hier kommen kleinere LLMs ins Spiel, die durch gezielte Feineinstellung trotzdem hohe Expertise erreichen können. Eine besonders vielversprechende Methode hierfür ist die Low-Rank Adaptation, kurz LoRA. Sie ermöglicht es, Modelle effizient und zielgerichtet an neue Anwendungsgebiete anzupassen, ohne den kompletten Modellkern neu trainieren zu müssen.

Dadurch lassen sich auch kleine Sprachmodelle in spezialisierte Expertenagenten verwandeln. LoRA folgt dem Prinzip, nur wenige gewichtete Parameter hinzuzufügen oder zu verändern, um dem Modell neue Fähigkeiten beizubringen. Die Kernarchitektur bleibt dabei unangetastet, was Speicher- und Rechenressourcen schont. Insbesondere bei kleinen LLMs ist dies vorteilhaft, da sie ursprünglich für allgemeine Aufgaben konzipiert sind und mit LoRA ihre Performance bei spezifischen Themenbereichen stark verbessern können. Der Effekt ist vergleichbar mit einer Expertenausbildung: Das Modell gewinnt tiefgehendes Wissen auf einem eng begrenzten Feld, etwa medizinische Beratung, juristische Analysen oder technische Supportanfragen.

Die Anpassung erfolgt durch sogenannte Adapter-Matrizen, die in die bestehenden neuronalen Schichten integriert werden. Diese Matrizen sind meistens viel kleiner als die Hauptgewichte und werden separat trainiert, was die Trainingszeit erheblich verkürzt. Zusätzlich ist die Integration von LoRA einfach, da sie mit bereits vorhandenen Modellarchitekturen kompatibel ist und ohne aufwendiges Fine-Tuning des gesamten Netzwerks auskommt. Für Unternehmen und Entwickler bedeutet das eine erhebliche Kosteneinsparung sowie eine schnellere Markteinführungszeit. Durch LoRA können kleine LLMs auch auf Geräten mit begrenzter Hardware betrieben werden, was die KI-Anwendung signifikant verbreitert.

Die Möglichkeit, spezialisierte Agenten zu schaffen, verbessert zudem die Nutzererfahrung. Statt auf allgemeine, oft zu breit gefasste Antworten zuzugreifen, erhalten Anwender präzise und kontextbezogene Auskünfte. Dies steigert die Akzeptanz von KI-Systemen und eröffnet neue Business-Modelle. Industrielle Bereiche wie Gesundheitswesen, Finanzwesen, Recht und Kundendienst profitieren besonders von dieser Entwicklung. In medizinischen Systemen können etwa kleine, auf klinische Daten angepasste LLM-Agenten Ärzte bei Diagnosen unterstützen oder Patienteninformationen aufbereiten.

Finanzdienstleister nutzen spezialisiert trainierte Modelle, um maßgeschneiderte Beratung anzubieten oder Betrugsmuster effizient zu erkennen. Ein weiterer Vorteil der LoRA-Technik ist ihre Skalierbarkeit und Flexibilität. Da nur zusätzliche Parameter eingefügt werden, können verschiedene Expertisen in ein und demselben Basismodell parallel abgebildet werden. Dadurch wird ein dynamischer Agent erzeugt, der sich je nach Aufgabenstellung anpassen lässt. Ebenso bleibt die Kontrolle über den Aufwand für Training und Deployment überschaubar.

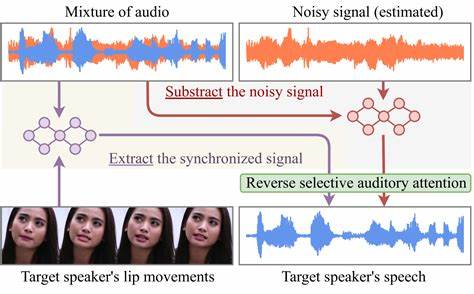

Die Integration von LoRA-inspirierten Modellen in bestehenden Software-Ökosystemen ist unkompliziert, weil die Technologie auf standardisierten Frameworks basiert und mit API-gesteuerten Schnittstellen zusammenarbeitet. Für Entwickler entstehen neue Möglichkeiten, Produkte schneller zu individualisieren und Updates ohne komplexe Modellrekonstruktionen durchzuführen. Ein zukunftsweisendes Forschungsfeld im Kontext von LoRA ist die Kombination mit weiteren KI-Techniken wie Reinforcement Learning oder multimodalen Modellen. Die Verbindung verschiedener Adaptations- und Lernstrategien kann zu noch leistungsfähigeren Expertenagenten führen, die nicht nur Texte verstehen und generieren, sondern auch andere Datenformate wie Bilder oder Tabellen verarbeiten. Damit öffnen sich breite Einsatzbereiche, die von datengetriebener Entscheidungsfindung bis hin zu kreativen Anwendungen reichen.

Trotz aller Vorteile der LoRA-Methode bleiben einige Herausforderungen bestehen. Dazu zählen die Auswahl geeigneter Basis-LLMs, die Definition der optimalen Low-Rank-Struktur und die Sicherstellung, dass die Feinabstimmung keine unerwünschten Verzerrungen oder Sicherheitsrisiken erzeugt. Auch ist die Qualität der Daten für das Feintuning entscheidend, denn je präziser die Trainingsdaten, desto höher ist die Expertise des Agenten. Es empfiehlt sich daher, interdisziplinär mit Fachleuten aus dem jeweiligen Anwendungsbereich zusammenzuarbeiten, um Ergebnisse zu optimieren. Zusammenfassend lässt sich sagen, dass LoRA eine revolutionäre Möglichkeit bietet, kleine Large Language Models effektiv und ressourcenschonend zu feintunen.

Die daraus entstehenden spezialisierten Expertenagenten tragen zur Verbesserung von KI-Anwendungen in vielen Branchen bei und eröffnen attraktive Potenziale für Unternehmen und Nutzer gleichermaßen. Mit der fortschreitenden Entwicklung und Integration dieser Technologie ist zu erwarten, dass KI-Systeme noch zugänglicher, flexibler und leistungsfähiger werden. Die Zukunft gehört somit den intelligenten, anpassungsfähigen Agenten, die als Brücke zwischen genereller KI und spezialisierten Lösungen fungieren.