Künstliche Intelligenz hat in den letzten Jahren enorme Fortschritte gemacht und ChatGPT ist eines der bekanntesten Beispiele für die beeindruckenden Fähigkeiten moderner Sprachmodelle. Während diese Technologie vielfältige Möglichkeiten bietet, sorgen sich viele Menschen um die Umweltfolgen und den Energieverbrauch solcher Systeme. Insbesondere wird häufig die Frage gestellt, wie viel Energie eine einzelne Abfrage bei ChatGPT tatsächlich benötigt und wie dieser Verbrauch im Vergleich zu alltäglichen Anwendungen steht. Die häufig zitierte Zahl, dass eine einzelne ChatGPT-Abfrage rund drei Wattstunden (Wh) Strom benötigt, hat für einiges Aufsehen gesorgt. Das entspricht etwa dem zehnfachen Energieverbrauch einer Google-Suche und wurde oft als Argument gegen die Umwelteffizienz von KI genutzt.

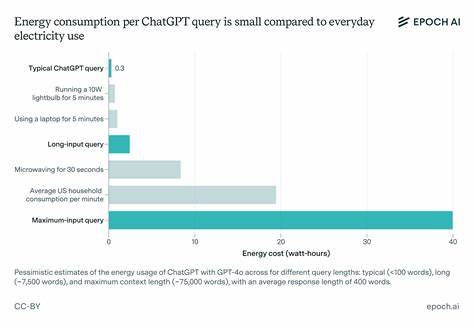

Jedoch zeigt aktuelle Forschung, dass dieser Wert stark überschätzt sein könnte. Neuere Analysen gehen davon aus, dass der typische Energiebedarf für eine ChatGPT-Abfrage mit GPT-4o bei etwa 0,3 Wattstunden liegt – also zehn Mal weniger als zuvor vermutet. Dieser Unterschied lässt sich durch mehrere Faktoren erklären. Zum einen hat sich die Hardware seit 2023 deutlich verbessert, und es werden effizientere Grafikprozessoren wie die Nvidia H100 verwendet, die leistungsstärker und energieeffizienter sind als ihre Vorgänger. Zum anderen wurden frühere Einschätzungen häufig anhand unrealistischer Annahmen zu der Anzahl der verarbeiteten Wörter pro Abfrage getroffen.

Während ältere Rechnungen mit Tausenden von Tokens rechneten, liegt der Durchschnitt moderner Nutzungen bei etwa 500 Tokens pro Antwort, was den Energiebedarf maßgeblich reduziert. Doch was bedeutet eigentlich eine Abfrage im Kontext eines großen Sprachmodells wie GPT-4o? Um einen Text zu generieren, werden Worte in sogenannte Tokens zerlegt; bei OpenAI entspricht ein Token durchschnittlich 0,75 Wörtern. Für die Erzeugung eines Tokens sind Millionen Rechenoperationen erforderlich, genauer gesagt, zwei Floating-Point-Operationen (FLOP) pro aktiviertem Parameter des Modells. Die Modelle von OpenAI sind massiv und haben Schätzungen zufolge bis zu 200 Milliarden Parameter, von denen aber nur ein Teil aktiv genutzt wird. Diese so genannte „mixture-of-experts“-Architektur aktiviert etwa ein Viertel der Parameter pro Token, was den Energieverbrauch optimiert.

Wenn ein durchschnittlicher Chatbot-Dialog also 500 Tokens generiert, summiert sich das auf etwa 1e14 FLOP pro Abfrage. Die Verarbeitung dieser Menge an Rechenoperationen auf aktuellen GPUs mit reduzierter Auslastung (etwa 10% der Nennkapazität) führt schließlich zu einem realistischen Energieverbrauch von circa 0,3 Wattstunden. Im Vergleich zu anderen Stromverbrauchern ist das erfreulich wenig. So verbraucht eine handelsübliche LED-Lampe in wenigen Minuten mehr Energie. Ebenso übersteigt der tägliche Stromverbrauch eines durchschnittlichen US-Haushalts mit über 28.

000 Wattstunden das Energieäquivalent von Hunderten, wenn nicht Tausenden ChatGPT-Abfragen deutlich. Dennoch steigt der Energieverbrauch deutlich an, wenn komplexere Abfragen mit sehr langen Eingabedokumenten bearbeitet werden sollen. Eingaben mit 10.000 Tokens können den Verbrauch auf etwa 2,5 Wattstunden erhöhen, während Extremfälle mit bis zu 100.000 Tokens sogar bis zu 40 Wattstunden erfordern können.

Diese Kosten sind im Kontext langer Dokumente aber eine einmalige Anfangsinvestition: Nach dem Verarbeiten der Eingaben werden Folgeabfragen, die darauf basieren, deutlich weniger Energie benötigen. Ein weiterer Faktor in der Diskussion um KI und Energieverbrauch ist das Training der Modelle. Der Trainingsvorgang eines großen Modells wie GPT-4o zieht über Monate hinweg immense Rechenressourcen und damit Energie in Anspruch. Die geschätzte Stromaufnahme liegt bei 20 bis 25 Megawatt über ungefähr drei Monate, eine Menge, die etwa 20.000 Haushalte zwei Jahre lang versorgen könnte.

Im Vergleich dazu wird die Energie der täglichen Nutzung von ChatGPT zur Abfrageerstellung inzwischen als ähnlich hoch eingeschätzt. Neben dem direkten Betrieb der KI sind auch indirekte Umweltbelastungen zu beachten, etwa die Herstellung der notwendigen Hardware. Diese sogenannten „verkörperten“ Energie- und CO2-Emissionen sind jedoch im Verhältnis zur Nutzung des Systems oft geringer. Hersteller wie TSMC verbrauchen zwar gigantische Mengen an Strom zur Chipproduktion, der tatsächliche Energiebedarf für den Betrieb über die Lebensdauer der Geräte übertrifft in der Regel die des Produktionsprozesses. Es bleibt eine Unsicherheit, wie sich der Energieverbrauch von KI in Zukunft entwickelt.

Fortschritte in der Hardware, effizienteren Algorithmen und Softwareoptimierungen könnten den Verbrauch senken. Zugleich wächst die Popularität und Einsatzbreite dieser Technologien, was den Gesamtverbrauch erhöhen könnte. Modelle mit längeren Antwortketten, die mehr Tokens generieren oder mit längeren Kontexten umgehen, benötigen zwangsläufig mehr Energie. Darüber hinaus sind neben GPT-4o auch andere Modelle, wie GPT-4o-mini, o1 und o3-mini, im Einsatz. Kleinere Varianten wie GPT-4o-mini verbrauchen weniger Energie pro Abfrage, sind aber möglicherweise weniger leistungsfähig.

Modelle, die speziell für komplexere Schlussfolgerungen und längere Antwortketten optimiert sind, wie o1, sind hingegen deutlich energieintensiver. Ihre Nutzung bleibt jedoch aktuell auf Nischenanwendungen beschränkt. Wichtig ist auch der Kontext, in dem ChatGPT verwendet wird. Für normale Nutzer, die gelegentlich Fragen stellen oder Texte verfassen lassen, ist der Energieverbrauch pro Abfrage vergleichsweise gering. Für Unternehmen und Forschungsprojekte mit großem Volumen oder komplexen Aufgaben kann der Aufwand jedoch deutlich höher ausfallen.

Trotzdem bleibt ein einzelner Chatbot-Aufruf meist ein winziger Teil des individuellen Gesamtenergieverbrauchs. Die übergeordnete Diskussion um den Energieverbrauch von KI sollte daher differenziert geführt werden. Es macht einen Unterschied, ob Energieverbräuche pauschal als Bedrohung dargestellt werden, oder ob konkrete Fakten zugrunde gelegt werden. Die Technologie birgt zweifellos Herausforderungen für die Umwelt, aber auch enorme Chancen für Effizienzsteigerungen, Automatisierungen und Problemlösungen, die selbst zur Reduktion von Ressourcenverbrauch beitragen können. Ein immer wichtiger werdender Aspekt ist die Transparenz seitens der Anbieter.

Noch fehlen detaillierte, offizielle Zahlen zu Energieverbrauch und CO2-Fußabdruck von Systemen wie ChatGPT. Eine offene Kommunikation würde es Experten und der Öffentlichkeit erleichtern, fundierte Abwägungen zu treffen. Beobachter erwarten, dass mit zunehmendem gesellschaftlichem Interesse auch die Offenlegung der Daten zunimmt. Die Debatte ist außerdem eng mit globalen Fragen zum Energiemanagement und Umweltschutz verbunden. KI könnte in Zukunft einen signifikanten Anteil am weltweiten Strombedarf ausmachen, wenn das Wachstum ungebremst anhält, weshalb nachhaltige Energiequellen und intelligente Nutzungskonzepte eine zentrale Rolle spielen müssen.

Innovationen im Bereich sparsamer Chips, verbesserter Kühltechnologien und effizienter Rechenzentren sind entscheidend, um die Klimaziele auch im Zeitalter künstlicher Intelligenz zu erreichen. Zusammenfassend lässt sich sagen, dass der aktuelle Energieverbrauch einer ChatGPT-Abfrage deutlich geringer ist, als viele Quellen glauben machen. Moderne Hardware, reduzierte Antwortlängen und verbesserte Nutzungseffizienz sorgen für einen moderaten Energiebedarf von etwa 0,3 Wattstunden je Abfrage. Besonders bei normalen Textanfragen stellt dies eine vergleichsweise geringe Belastung dar. Bei Ausweitungen auf besonders lange Dokumenteneingaben oder komplexe Modelle kann dieser Verbrauch allerdings deutlich steigen.

Die Herausforderung besteht darin, den rasanten Fortschritt in der KI-Nutzung mit den Anforderungen an Umweltschutz und Nachhaltigkeit in Einklang zu bringen. Technologische Entwicklung, politische Regulierung und bewusster Nutzerbedarf müssen zusammenwirken, um das Potenzial von Sprachmodellen wie ChatGPT nachhaltig auszuschöpfen. Nur so kann sichergestellt werden, dass künstliche Intelligenz in der Zukunft einerseits weiterhin innovative Dienste bietet und andererseits ihrer Verantwortung für Umwelt und Klimaschutz gerecht wird.