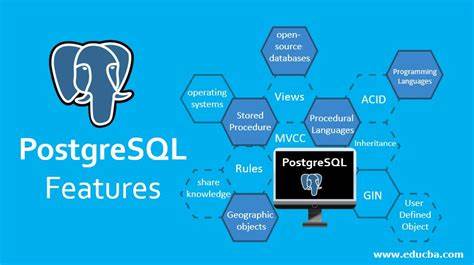

In den letzten Jahren hat die Zahl der Startups, die sich auf Analytics-Lösungen rund um PostgreSQL spezialisieren, stark zugenommen. Diese Entwicklung ist kein Zufall, sondern spiegelt eine tiefgreifende Transformation in der Art und Weise wider, wie Unternehmen Daten speichern, verarbeiten und analysieren. Die Beliebtheit von Postgres als Open-Source-Datenbanksystem, kombiniert mit der immer dringlicher werdenden Notwendigkeit, komplexe Analysen direkt auf operativen Daten durchführen zu können, sorgt für eine Innovationswelle, die Startups beflügelt. Doch warum gerade Postgres, und warum gerade jetzt so viele neue Firmen in diesem Feld entstehen? Um das zu verstehen, lohnt es sich, die zugrundeliegenden Herausforderungen, technologische Entwicklungen und Kundenanforderungen genauer zu betrachten. Postgres erfreut sich seit langem großer Beliebtheit wegen seiner Stabilität, Flexibilität und dem reichen Funktionalitätsumfang.

Ursprünglich als reine relationale Datenbank konzipiert, hat das System in den letzten Jahren zahlreiche Erweiterungen erfahren, die es auch für analytische Anwendungen attraktiv machen. Die Fähigkeit, mit komplexen Abfragen, verschiedenen Datentypen und modularen Erweiterungen umzugehen, hebt Postgres von vielen anderen Datenbanksystemen ab. Dennoch ist Postgres traditionell für Transaktionsverarbeitung (OLTP) optimiert, was bedeutet, dass es Herausforderungen gibt, wenn es um datenintensive Analysen (OLAP) geht. Diese Kluft zwischen operativen Datenbankaufgaben und analytischen Anforderungen bildet den Kern des Problems, das viele Startups adressieren wollen. Ein wesentlicher Treiber für neue Analytics-Lösungen auf Postgres-Basis ist die steigende Menge und Komplexität der Daten.

Unternehmen speichern zunehmend große Mengen unterschiedlicher Datenarten – von Log-Daten über Kundeninformationen bis hin zu Sensordaten – und möchten diese idealerweise in einem System verwalten. Die bisherige Praxis, analytische Abfragen auf denselben Tabellen laufen zu lassen wie operative Workloads, stößt schnell an ihre Grenzen. Indexe, Materialized Views und aufwändige Abfrageoptimierungen können die Performance für Schreibvorgänge stark beeinträchtigen. Die Folge sind langsame Abfragen oder eingeschränkte Möglichkeiten bei parallelen Operationen. Hier setzt die Innovationswelle an: Die Integration von spaltenorientierten Speicherformaten (Column Stores) in Postgres ist eine strategische Antwort auf diese Herausforderungen.

Spaltenbasierte Speicherung bietet signifikante Vorteile bei Analyse-Workloads, da sie die Daten effizienter komprimieren und schneller aggregieren kann. Trotzdem war es lange nicht trivial, diese Speichermodelle nahtlos mit Postgres’ traditionellen Zeilen-basierten Tabellen zu kombinieren. Viele Startups widmen sich deshalb der Entwicklung von Erweiterungen, die die Vorteile des analytischen Spaltenspeichers mit den bewährten Funktionalitäten und der Verlässlichkeit von Postgres verbinden. Ein weiterer wichtiger Faktor ist die Benutzerfreundlichkeit. Produktentwickler und Dateningenieure wünschen sich oft eine einheitliche Schnittstelle für ihre Arbeit, die ohne umständliche ETL-Prozesse (Extract, Transform, Load) auskommt.

Statt Daten aus Postgres heraus zu exportieren und dann in eine spezialisierte Analytics-Datenbank zu laden, soll die Datenaufnahme, -verarbeitung und -analyse direkt innerhalb von Postgres möglich sein. Auf diese Weise lassen sich auch operationale und analytische Daten einfacher verbinden, was neue Einsichten und datengetriebene Geschäftsmodelle ermöglicht. Die Arbeit mit vertrauten Werkzeugen wie psql oder ORM-Systemen (Object-Relational Mappers) erleichtert die Integration zusätzlich. Technische Ansätze variieren dabei stark. Einige Lösungen setzen auf die Einbettung von analytischen Engines wie DuckDB direkt in Postgres, um spaltenorientierte Abfragen auf externen Datenformate wie Parquet oder CSV auszuführen, während andere auf die Verbindung zu externen Analyseplattformen über Foreign Data Wrappers (FDW) setzen, etwa mit ClickHouse.

Beide Strategien haben ihre Vor- und Nachteile, insbesondere im Hinblick auf Performance, Datenkonsistenz und Nutzerfreundlichkeit. Allerdings setzen viele Kunden voraus, dass ihre Daten bereits in spaltenbasierten Formaten vorliegen, was in der Praxis oft nicht der Fall ist. Daher versuchen viele Startups, das Schreiben und Verwalten von spaltenbasierten Datenformaten innerhalb von Postgres möglich zu machen. Die Entwicklung sogenannter Columnstore-Tabellen, die auch Transaktionen, Updates, Löschungen und komplexe Abfragen unterstützen, ist dabei ein technischer Meilenstein. Dies wird durch innovative Projekte und Erweiterungen möglich, die auf offenen Datenformaten wie Iceberg oder Delta Lake basieren und es erlauben, moderne Analytics-Performance ohne Vendor Lock-in zu realisieren.

Hier entstehen Lösungen, die nicht nur schnelle Abfragen ermöglichen, sondern auch einen operativen Datenbankbetrieb neben analytischen Workloads erlauben. Eine der größten Herausforderungen bleibt jedoch die Synchronität zwischen den traditionellen Zeilen-basierten Tabellenspeichern und den spaltenbasierten Tabellen. Anwendungen stellen häufig die Anforderung, dass die Analysen auf stets aktuellen Daten beruhen müssen, was in einem klassischen Data Warehouse-Szenario nicht so leicht realisierbar ist. Die Idee eines ‚operational columnstore‘, der als Single-Source-of-Truth sowohl OLTP- als auch OLAP-Workloads unterstützt, gilt als technologisches Idealziel, ist aber weiterhin schwierig umzusetzen. Unternehmen wie SingleStore haben viele Jahre in diese hybride Technologie investiert, jedoch ist die vollständige Erreichbarkeit von „echtem“ OLTP auf Columnstores noch ein hart umkämpftes Feld.

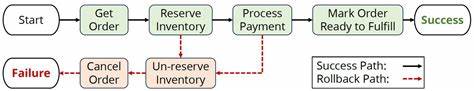

Viele Startups schlagen deshalb hybride Lösungen vor, bei denen Postgres die Rolle des operativen Systems behält und Datenänderungen über Change Data Capture (CDC) in Echtzeit oder nahezu Echtzeit an spezialisierte Analytics-Systeme wie ClickHouse übertragen werden. Diese Systeme sind besonders gut geeignet für Insert-lastige Daten, haben jedoch Schwierigkeiten mit der Verarbeitung von Updates und Deletes. Das führt dazu, dass Nutzer eigene Komplexitätslogiken zur Duplikatsbereinigung implementieren müssen, was den Wartungsaufwand erhöht. Eine nahtlose, leicht zu administrierende Lösung, die all diese Anforderungen erfüllt, ist derzeit noch Mangelware. Vor diesem Hintergrund wird deutlich, warum der Markt für Postgres-Analytics-Lösungen so dynamisch ist.

Der Bedarf an flexiblen, leistungsfähigen und integrierten Systemen wächst exponentiell, das Angebot an Technologien und Konzepten ist breit gefächert und durch zahlreiche Startups geprägt, die versuchen, jeweils innovative Ansätze zu realisieren. Das offene Ökosystem von Postgres erlaubt dabei eine starke Community-Unterstützung und schnelle Entwicklung. Gleichzeitig entstehen neue Anforderungen an Data Engineering und Data Governance, die diese innovativen Startups adressieren müssen. Darüber hinaus erleichtert die weit verbreitete Nutzung von Cloud-Infrastrukturen und Data Lakes die Nutzung offener Speicherformate und fördert die Entwicklung verteilter, skalierbarer Analyselösungen. Die Kombination von Postgres mit modernen Big-Data-Technologien schafft ein vielversprechendes Innovationsumfeld, in dem Startups gefragte Schnittstellen und Werkzeuge entwickeln.

Schließlich spiegelt der Boom an Postgres Analytics Startups auch den Trend hin zu HTAP-Systemen (Hybrid Transactional/Analytical Processing) wider, die die bisherige Trennung von OLTP und OLAP überwinden wollen. Kunden profitieren von reduzierten Datenlatenzen, vereinfachten Architekturen und einer besseren Nutzung ihrer Datenbestände. Die Herausforderung, dieses Ziel zu erreichen, treibt die technologische Evolution an und fördert die Entstehung vieler junger Unternehmen in diesem vielversprechenden Segment. Zusammenfassend lässt sich sagen, dass die Vielzahl der Postgres-Analytics-Startups aus dem Zusammenspiel von technologischer Innovation, gestiegenen Kundenanforderungen und dem Wunsch nach vereinheitlichten Datenplattformen resultiert. Die Kombination aus der Flexibilität von Postgres, der Notwendigkeit schneller und großvolumiger Analysen sowie der Bereitschaft, neue Speicherformate und hybride Architekturen zu erforschen, schafft ein fruchtbares Umfeld für Innovationen.

Während der perfekte, vollständig integrierte Lösungspfad noch nicht gefunden ist, sorgen die vielfältigen Ansätze dafür, dass für nahezu jede Anforderung eine passende Technologie in Reichweite ist. Die Zukunft von Postgres Analytics bleibt spannend – und die Dynamik im Startup-Bereich ein deutliches Zeichen dafür, dass hier bald bedeutende Durchbrüche zu erwarten sind.